Les avantages de l’IA locale : contrôle total et personnalisation avancée

En 2025, l’intelligence artificielle locale transforme les workflows professionnels en offrant une alternative puissante aux solutions cloud. Contrairement aux services IA en ligne bridés, l’IA locale sur votre propre machine garantit une confidentialité totale, une personnalisation illimitée et des performances optimisées selon vos besoins spécifiques. Bien sûr, vous n’aurez pas la puissance de calcul des centres de données, mais vous aurez des possibilités d’adapter, d’intégrer, personnaliser ou encore d’utiliser des modèles spécialisés. Certains petits modèles spécialisés pourraient bien vous surprendre par leur efficacité.

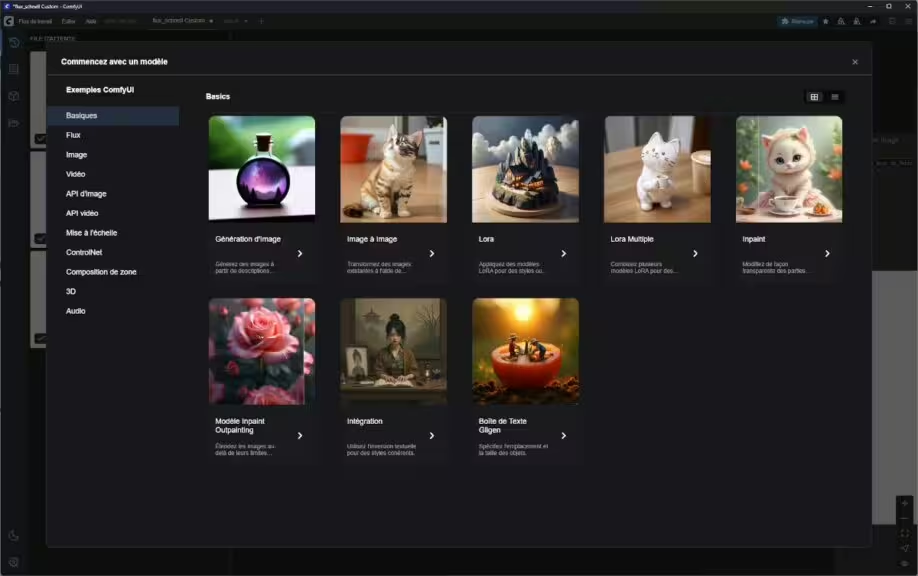

L’un des domaines qui illustre le mieux le gain obtenu par rapport aux solutions Cloud, c’est la génération d’image par IA. Aujourd’hui, il est extrêmement facile d’installer en local une IA de génération d’image, par exemple avec ComfyUI. A condition de passer un peu de temps sur l’outil, le résultat est à mes yeux bien supérieur à des solutions comme Midjourney.

Pourquoi choisir l’IA locale plutôt que les solutions cloud ?

Confidentialité et sécurité des données renforcées

L’intelligence artificielle locale présente un avantage décisif pour les professionnels : vos données restent sur votre machine. Contrairement aux plateformes cloud où chaque prompt, image ou document transite par des serveurs tiers, l’IA locale garantit une confidentialité absolue.

Avantages sécuritaires concrets :

- Aucun risque de fuite de données sensibles

- Conformité RGPD native sans audit externe

- Contrôle total sur le traitement des informations confidentielles

- Pas de collecte de données par les fournisseurs IA

Personnalisation avancée et contrôle granulaire

Là où les solutions IA en ligne imposent leurs limitations, l’IA locale offre une liberté créative totale. Cette personnalisation poussée révolutionne particulièrement la génération d’images avec intelligence artificielle.

- Par exemple, de nombreux utilisateurs de Photoshop utilisent des outils pour leur travail.

- Les infographistes 3D pour générer des textures.

- Les rédacteurs Web pour générer des illustrations.

- Les développeurs pour intégrer des images dans leur développement.

Au delà de la génération d’image, les LLM en local se développent également. Il y a deux grands axes de développement, les LLM intégré dans les logiciels pour des tâches spécifiques et pour les utilisateurs avancés la possibilité de télécharger, executer et personnaliser des LLM Open Source, par exemple à partir d’Hugging Face ou Ollama.

ComfyUI : l’exemple parfait de la supériorité de l’IA locale

Génération d’images sans limites vs solutions cloud bridées

ComfyUI avec Stable Diffusion et de nombreux autres modèles comme Flux, HiDream, illustre parfaitement pourquoi l’IA locale peut surpasser les alternatives cloud. Comparons les possibilités :

Solutions cloud (Midjourney, Imagen, ChatGPT) :

- Styles limités et prédéfinis

- Prompts filtrés et censurés

- Générations quotidiennes limitées

- Aucun contrôle sur les paramètres avancés

- Limites sur les tailles d’images générées

- Variabilité du service, par exemple ChatGPT montre un manque de constance dans les résultats

Lorsque vous avez une idée bien précise, cela nécessite plusieurs prompts et essais. Les quotas sont ainsi vite atteints avec les abonnements d’entrée de gamme. Si l’IA répond mal à votre demande, vous perdez quand même des crédits.

ComfyUI en local :

- Modèles spécialisés illimités (anime, photorealisme, architecture)

- Workflows personnalisables avec nodes multiples

- ControlNet pour contrôle précis de la composition

- Combination de LoRA pour styles uniques

- Aucune limitation de quota ou de censure

- Aucune limite sur les dimensions d’image, vous pouvez générer une image 4K ou plus.

Le résultat n’est pas seulement différent : il est souvent qualitativement supérieur pour des besoins créatifs spécifiques, tout en offrant une reproductibilité des résultats. Même avec une configuration modeste, vous pouvez obtenir de bon résultats au prix d’un temps de calcul un peu plus long. Par exemple avec une RTX 3070 Ti 8 Go VRAM, générer une image en 1280×720 pourra prendre entre 30 et 300 secondes en fonction du modèles, des paramètres et du Workflow. Avec une RTX 5090, les temps de rendu descendent à quelques secondes.

Workflows avancés impossibles dans le cloud

L’intelligence artificielle on-premise (« sur site ») ou en local permet de créer des pipelines de traitement sophistiqués :

- Preprocessing automatique des images sources

- Chaining de modèles pour affiner progressivement

- Batch processing pour traitement en masse

- Integration avec autres outils locaux (Photoshop, Blender)

Par exemple avec ComfyUI, vous pouvez générer une image en 1280×720, puis ajouter un sujet dans l’image, affiner les détails de l’image et enfin réaliser un Upscaling par IA en 4K. Toute ceci avec un même Workflow.

LLM locaux : expertise technique récompensée

Personnalisation poussée des modèles de langage

Les LLM en local (Large Language Models) offrent des possibilités de customisation avancée inaccessibles via les API cloud :

Outils recommandés pour LLM locaux :

- LM Studio : interface simple pour débutants, idéal pour s’initier

- Ollama : solution ligne de commande performante, idéal pour les développeurs

- Text Generation WebUI : contrôle granulaire avancé, c’est un peu le ComfyUI du LLM.

Avantages techniques des LLM locaux

Fine-tuning sur données propriétaires :

- Adaptation aux terminologies spécifiques de votre secteur

- Apprentissage sur vos documents internes sans exposition

- Optimisation des réponses selon vos workflows

Contrôle des paramètres d’inférence :

- Température ajustable pour créativité vs précision

- Top-k et top-p personnalisés selon le contexte

- Longueur de contexte maximisée selon votre hardware

Pour aller plus loin : Fine-Tune pour les débutants : personnalisez votre modèle LLM facilement

Dimensionner sa configuration pour l’IA locale

Configuration minimale pour débuter (16 Go VRAM)

GPU recommandés :

- RTX 4060 Ti 16 Go : bon rapport qualité/prix

- RTX 5060 Ti 16 Go : dernière génération optimisée

Capacités avec 16 Go VRAM :

- Stable Diffusion 1.5 et SDXL en qualité standard

- LLM 7B ou 13B quantifiés (Llama, Mistral, DeepSeek, Gemma, Qwen …)

- Workflows ComfyUI avec petits et moyens modèles. Pour les Workflows avec plusieurs modèles, il faudra soit optimiser, soit être patient.

Configuration intermédiaire (24 Go VRAM)

GPU de choix :

- RTX 4090 24 Go : performance éprouvée

- RTX 5080 24 Go : architecture moderne

Nouvelles possibilités :

- Modèles FLUX et SD3 en haute résolution

- LLM 13B en précision native ou modèles 30B quantifiés

- Workflows ComfyUI complexes avec ControlNet multiples

- Fine-tuning de modèles moyens sans limitation

Configuration professionnelle (32 Go VRAM)

Solution haut de gamme :

- RTX 5090 32 Go : liberté totale pour l’IA locale

Avantages de la configuration 32 Go :

- Aucune limitation sur les modèles actuels

- LLM 70B en quantification Q4 confortablement

- Workflows ComfyUI ultra-complexes sans contrainte mémoire

- Recherche et développement sur nouveaux modèles

- Batch processing intensif pour production

Impact sur la productivité professionnelle

Retour sur investissement calculable :

- Élimination des coûts d’abonnement cloud récurrents

- Productivité accrue grâce à la personnalisation

- Temps de traitement réduit sans latence réseau

- Créativité libérée des contraintes artificielles

Comparaison énergétique : local vs cloud

Consommation réelle de l’IA locale

Contrairement aux idées reçues, l’IA locale présente souvent un bilan énergétique favorable :

Consommation locale :

- Usage ponctuel lors des tâches IA uniquement

- Pas de transmission réseau énergivore

- Optimisation possible selon vos besoins réels

Consommation cloud :

- Datacenters actifs 24h/24 même sans utilisation

- Refroidissement industriel permanent

- Infrastructure réseau pour transmission

Défis et solutions pour l’adoption de l’IA locale

Courbe d’apprentissage technique

L’intelligence artificielle on-premise (sur site ou en local) demande un investissement initial en formation :

Compétences à développer :

- Configuration des environnements (Python, CUDA)

- Gestion des modèles et formats (GGUF, SafeTensors)

- Maintenance des modèles, les modèles Open Source se renouvellent très fréquement

- Optimisation mémoire et performance

- Troubleshooting des erreurs courantes

Solutions pour faciliter l’adoption

Outils user-friendly :

- Interfaces graphiques simplifiées (Text Generation WebUI, LM Studio, ComfyUI Manager)

- Distributions préconfigurées (Automatic1111, InvokeAI)

- Communautés actives pour support technique

Cas d’usage professionnels de l’IA locale

Secteurs prioritaires pour l’adoption

Création de contenu :

- Agences créatives : génération d’assets personnalisés

- Architecture : visualisation concepts et rendus

- Marketing : création visuels branded sans limitation

Développement logiciel :

- Code review automatique sur code propriétaire

- Documentation technique adaptée aux standards internes

- Génération de tests unitaires contextualisés

Conseil et expertise :

- Analyse de documents confidentiels clients

- Rédaction de rapports avec terminologie métier

- Assistant IA spécialisé par domaine d’expertise

Tendances et évolution de l’IA locale

Modèles LLM open-source leaders en 2025

L’écosystème IA open-source connaît une accélération remarquable avec des modèles qui rivalisent désormais avec les solutions propriétaires. Les LLM locaux de 2025 offrent des performances exceptionnelles tout en garantissant une confidentialité totale des données.

Llama 3 (Meta) – Le nouveau standard La dernière génération de Meta disponible en versions 8B et 70B paramètres représente une avancée majeure pour l’IA locale. Avec un contexte étendu jusqu’à 128K tokens dans la version 3.2, Llama 3 excelle particulièrement en génération de code, création de contenu et dialogue avancé. Cette optimisation pour l’inférence locale en fait le choix privilégié des professionnels exigeants.

Modèles spécialisés émergents

- Mistral : reconnu pour son efficacité énergétique exceptionnelle sur hardware grand public

- BLOOM : modèle multilingue supportant 46 langues naturelles et 13 langages de programmation, idéal pour les workflows internationaux

- GPT-NeoX (EleutherAI) : 20B paramètres optimisés pour les tâches mathématiques et l’analyse de connaissances complexes

Modèles communautaires spécialisés L’innovation vient aussi des fine-tuning communautaires : Vicuna, OpenOrca, Platypus2, MythoMax et Zephyr offrent des spécialisations métier impossibles avec les solutions cloud généralistes. Ces modèles, basés sur l’architecture Llama, permettent une personnalisation poussée pour chatbots professionnels, assistance technique ou créativité littéraire.

Écosystème d’outils mature pour l’IA locale

Plateformes user-friendly :

- LM Studio : interface graphique intuitive pour découvrir et déployer des LLM locaux sans expertise technique

- GPT4All : application desktop complète avec bibliothèque de modèles curés et intégration workflow simplifiée

- Jan : plateforme open-source axée confidentialité avec support plugins et customisations avancées

Solutions optimisées performance :

- Ollama : outil en ligne de commande pour déploiement rapide de Llama, Mistral et autres modèles populaires

- llama.cpp : implémentation C/C++ hautement optimisée pour exploitation CPU/GPU maximale

Cette maturité de l’écosystème démocratise l’accès à l’IA locale professionnelle, permettant aux entreprises de toutes tailles de bénéficier d’une intelligence artificielle sur mesure sans dépendance cloud.

Integration avec workflows existants

L’IA locale s’intègre de plus en plus naturellement :

- Plugins natifs dans les logiciels professionnels

- API locales pour développements custom

- Automatisation de tâches répétitives métier

Conclusion : l’IA locale, investissement d’avenir

L’intelligence artificielle locale représente bien plus qu’une alternative aux solutions cloud : c’est un investissement stratégique dans l’autonomie technologique de votre activité professionnelle. La personnalisation avancée, la confidentialité garantie et les performances optimisées offrent un avantage concurrentiel durable.

Avec des configurations hardware accessibles dès 16 Go de VRAM et des outils de plus en plus conviviaux, l’IA on-premise devient la solution de choix pour les professionnels exigeants en créativité, sécurité et performance.

L’investissement initial en matériel et formation se rentabilise rapidement grâce aux économies d’abonnement cloud et aux gains de productivité substantiels. Plus qu’une tendance, l’IA locale définit l’avenir du travail intelligent et de l’efficacité. Concernant les tâches entièrement automatisées, les agents IA autonome, je recommande une approche pragmatique. Comme l’a montré la mauvaise expérience de Klarna avec un chatbot entièrement autonome pour le service client, il ne faut pas tomber non plus dans un enthousiasme excessif. En 2025, l’IA est un formidable outil d’assistance, en revanche l’automatisation complète et autonome semble encore lointaine.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !

Merci pour cet article très intéressant! on se sent moins seul à l’heure de faire son initiation intelligente avec l’IA locale… Une question simple : je suis artiste – photographie, vidéos, tableaux, installations, etc. et j’aimerais savoir ce que vous me conseillez comme installation (quel type de logiciel, AI, etc.) et comme formation (où trouver des formations complètes et bien faites); sachant que je suis au degré zéro des connaissances mais que j’apprends très très vite (dès que j’ai accès à l’info)?

Bonjour et merci pour votre commentaire.

Concernant l’image, ComfyUI est parfait pour commencer si votre matériel le permet (GPU). Pour apprendre, il y a de nombreuses sources sur Internet et YouTube, nous en parlons sur notre page https://cosmo-games.com/comfyui-meilleures-sources-informations/. Tout évolue très vite, il faut donc une bonne dose de curiosité !