Qu’est-ce qu’une base vectorielle ? Comprendre son rôle avec l’IA et les modèles RAG

En 2025, les bases vectorielles se sont imposées comme l’un des piliers de l’intelligence artificielle contemporaine. Longtemps cantonnées à la recherche sémantique et au traitement du langage, elles constituent désormais la colonne vertébrale de l’IA contextuelle, permettant aux modèles d’accéder à la mémoire, au raisonnement et à la compréhension du sens, des capacités qu’aucune base de données classique ne pouvait offrir efficacement.

Leur fonction repose sur le stockage d’embeddings, c’est-à-dire de représentations vectorielles qui traduisent la signification de données non structurées (texte, image, code, audio…). Ces vecteurs permettent aux systèmes d’IA de comparer et de retrouver des informations selon leur sens, et non selon de simples mots-clés. C’est ce principe qui alimente aujourd’hui les moteurs de recherche sémantique, les assistants IA et les agents autonomes capables de comprendre le contexte d’une conversation ou d’une requête.

Dans les architectures modernes, les bases vectorielles jouent un rôle central dans des approches comme le RAG (Retrieval-Augmented Generation), une méthode qui combine la puissance linguistique des Large Language Models (LLM) avec une mémoire externe vectorielle. Le modèle ne se limite plus à son entraînement : il consulte sa base pour rechercher les informations les plus pertinentes avant de générer une réponse contextualisée.

Aujourd’hui, cette technologie structure les écosystèmes d’IA les plus avancés. Des outils tels que Milvus, Qdrant, Pinecone ou encore Chroma propulsent des usages allant du RAG à la mémoire longue durée des agents IA, en passant par la recherche multimodale et la détection d’anomalies dans les données complexes.

En d’autres termes, la base vectorielle n’est plus une simple infrastructure technique : elle est devenue le cœur sémantique des systèmes d’IA modernes. Sans elle, impossible d’offrir des interactions naturelles, une compréhension du contexte ou une mémoire persistante, des capacités désormais indispensables à l’intelligence artificielle dite agentique.

Qu’est-ce qu’une base vectorielle ?

Une base vectorielle est une base de données conçue pour stocker et rechercher des vecteurs numériques, appelés embeddings. Ces embeddings sont des représentations mathématiques qui traduisent la signification d’un contenu non structuré, texte, image, audio, ou code, dans un espace multidimensionnel.

Chaque donnée est transformée en vecteur à l’aide d’un modèle d’embedding, comme nomic-embed, e5-small ou text-embedding-ada-002. Ces modèles capturent le sens des mots et des phrases plutôt que leur simple forme lexicale. Ainsi, deux documents exprimant la même idée avec des termes différents produiront des vecteurs proches dans cet espace sémantique.

Contrairement aux bases de données traditionnelles, qui reposent sur des recherches exactes ou des correspondances de chaînes de caractères, la base vectorielle fonctionne par similarité de sens. Elle peut, par exemple, associer les requêtes “comment fonctionne un GPU” et “explication du processeur graphique”, même si aucun mot n’est identique.

C’est cette propriété qui en fait un outil essentiel pour la recherche sémantique, les agents IA contextuels, ou les systèmes de recommandation intelligents. Les bases vectorielles permettent aux modèles de langage (LLM) de raisonner à partir d’informations non présentes dans leurs poids internes, en consultant des données externes pertinentes via des mécanismes de Retrieval-Augmented Generation (RAG).

En pratique, la base vectorielle agit comme une mémoire sémantique : elle relie la capacité linguistique du modèle à la connaissance issue de documents, d’archives ou de bases métier. Cette approche ouvre la voie à une nouvelle génération d’applications, assistants de recherche, copilotes rédactionnels, moteurs d’analyse documentaire, capables d’exploiter le sens et non la simple syntaxe.

Des initiatives open source comme Chroma, Qdrant ou FAISS facilitent aujourd’hui cette mise en œuvre, permettant aux développeurs et aux chercheurs d’intégrer la recherche vectorielle directement dans leurs pipelines IA. Ces outils forment la base des systèmes RAG modernes utilisés par vLLM, Ollama ou Open WebUI, qui combinent rapidité d’exécution, confidentialité locale et précision contextuelle.

Comment fonctionne une base vectorielle

Le fonctionnement d’une base vectorielle repose sur un enchaînement précis d’étapes qui permettent à une intelligence artificielle d’indexer, de comparer et de retrouver des informations selon leur proximité sémantique.

1. Génération des embeddings

Tout commence par la conversion des données brutes (texte, image, code ou audio) en vecteurs numériques, appelés embeddings. Un modèle d’embedding, tel que text-embedding-ada-002, nomic-embed-text, ou e5-base, traduit le sens du contenu en une série de valeurs flottantes, généralement comprises entre plusieurs centaines et plusieurs milliers de dimensions. Chaque dimension encode un aspect sémantique, le ton, le sujet, la structure ou le contexte, permettant à la machine de comprendre les similarités de sens entre deux éléments.

2. Indexation et organisation vectorielle

Une fois les embeddings créés, ils sont stockés dans une base vectorielle comme FAISS, Chroma, Qdrant ou Milvus. Ces systèmes utilisent des structures d’index optimisées (comme les graphes HNSW ou la quantification de produit) pour accélérer la recherche de similarité dans des ensembles contenant parfois plusieurs millions de vecteurs. L’objectif est simple : retrouver en quelques millisecondes les vecteurs les plus proches de celui d’une requête donnée.

Cette approche est aujourd’hui au cœur des systèmes à grande échelle, notamment ceux utilisés par Pinecone, Zilliz, ou les déploiements industriels de Milvus, capables de gérer des milliards d’embeddings avec une latence minimale.

3. Recherche sémantique

Lorsqu’un utilisateur formule une question, celle-ci est transformée à son tour en embedding. La base vectorielle calcule alors la distance entre ce vecteur et ceux stockés dans l’index, afin d’identifier les passages les plus pertinents sur le plan du sens. Cette étape de semantic retrieval remplace avantageusement les anciennes recherches par mots-clés, souvent limitées et sensibles à la formulation.

4. Fourniture du contexte à l’IA

Les passages sélectionnés sont ensuite transmis au modèle de langage (LLM), exécuté par exemple via vLLM ou Ollama. Le modèle intègre ces extraits dans son prompt avant de générer une réponse contextualisée. C’est le principe même du Retrieval-Augmented Generation (RAG) : relier la puissance linguistique d’un modèle à la pertinence d’une base vectorielle.

5. Résultat : une IA connectée à la connaissance

Grâce à cette synergie, une IA peut répondre avec précision à des questions sur des sujets récents, confidentiels ou spécialisés, sans nécessiter de nouvel entraînement. La base vectorielle agit ainsi comme un système de mémoire externe, une extension de la compréhension du modèle, capable de donner à l’IA une forme de continuité et de contextualisation dans le temps.

Les principales solutions open source

L’écosystème open source a joué un rôle déterminant dans la démocratisation des bases vectorielles. En 2025, plusieurs solutions gratuites, performantes et auto-hébergeables permettent aux chercheurs, développeurs et entreprises de bénéficier d’une recherche sémantique et d’un stockage vectoriel avancé, sans dépendre du cloud.

| Outil | Licence | Spécificités | Points forts |

|---|---|---|---|

| FAISS | MIT (Meta) | Bibliothèque C++/Python | Rapidité extrême, adaptée aux grands volumes |

| Chroma | Apache 2.0 | Base légère en Python | Idéale pour un usage local, simple ou expérimental. compatible avec LangChain, LlamaIndex, Open WebUI |

| Qdrant | Open source (Rust) | API REST et gRPC | Très scalable, supporte les filtres et métadonnées. Idéal pour une intégration poussée avec LangChain, LlamaIndex et Open WebUI. Production Ready |

| Milvus | Apache 2.0 | Architecture distribuée | Haute performance, production-ready |

FAISS

Développée par Meta AI, FAISS (Facebook AI Similarity Search) est une bibliothèque écrite en C++ avec des liaisons Python. Elle reste une référence dans le domaine de la similarité vectorielle à grande échelle. FAISS se distingue par sa rapidité, son efficacité mémoire et sa compatibilité avec les GPU, ce qui en fait un choix privilégié pour les environnements de recherche et les systèmes embarqués nécessitant une très faible latence.

Chroma

Chroma est une base vectorielle en Python, pensée pour la simplicité et l’intégration directe avec les frameworks IA modernes comme LangChain, LlamaIndex ou Open WebUI. Elle est idéale pour les déploiements locaux et les prototypes RAG, grâce à son interface claire et à sa gestion automatique des métadonnées. Chroma est aujourd’hui la solution la plus accessible pour les utilisateurs de vLLM ou Ollama souhaitant expérimenter le chat contextuel avec leurs propres documents.

Qdrant

Basée sur le langage Rust, Qdrant propose une API REST et gRPC complète, une recherche vectorielle ultrarapide et une excellente scalabilité. Elle combine performance et flexibilité, notamment grâce à son support des filtres complexes et de la recherche hybride (texte + vecteurs). Qdrant est de plus en plus utilisée dans des applications industrielles où la précision et la vitesse sont cruciales, comme la cybersécurité ou l’analyse financière.

Milvus

Conçu pour les environnements à grande échelle, Milvus est une base vectorielle distribuée sous licence Apache 2.0. Elle offre un haut degré de tolérance aux pannes, une gestion native du clustering et des optimisations pour les architectures multi-GPU. Milvus est souvent associée à sa déclinaison commerciale Zilliz Cloud, qui fournit une infrastructure managée adaptée aux grands volumes d’embeddings (plusieurs milliards de vecteurs).

Quelle solution choisir ?

Le choix dépend du contexte d’usage :

- FAISS : recherche locale haute performance et prototypage.

- Chroma : intégration rapide dans des pipelines RAG ou Open WebUI.

- Qdrant : déploiements scalables, backends Rust performants.

- Milvus : environnements distribués et volumétrie extrême.

Ces outils open source sont au cœur des infrastructures de retrieval-augmented generation, permettant à des modèles cloud ou locaux (via vLLM, Ollama, ou LM Studio) d’accéder à des connaissances actualisées sans ré-entraînement.

Quand IA et base vectorielle se rencontrent : le rôle du RAG

Une base vectorielle seule ne “comprend” pas le langage ; un LLM seul ne connaît pas vos documents. Ensemble, ils forment le couple essentiel du Retrieval-Augmented Generation (RAG).

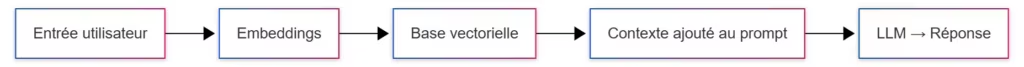

Le RAG associe la puissance linguistique du modèle à la mémoire d’une base vectorielle. Lorsqu’une requête est formulée, le système vectorise la question, recherche les passages les plus pertinents dans la base, puis injecte ces extraits dans le prompt du modèle. Résultat : une IA contextuelle capable de fournir des réponses précises, basées sur des informations à jour et spécifiques à votre environnement.

C’est cette architecture qui alimente des outils comme “Chat with your documents”, ou encore les copilotes documentaires déployés en entreprise. Des frameworks tels que LangChain ou LlamaIndex facilitent aujourd’hui cette intégration.

Vers les agents RAG et l’émergence de l’Agentic RAG

L’évolution naturelle du RAG a conduit à une nouvelle génération de systèmes d’agents intelligents, capables de raisonner, planifier et interagir avec leur environnement de manière plus autonome. Dans cette transformation, la base vectorielle n’est plus un simple composant technique, mais devient une mémoire cognitive au cœur du raisonnement de l’agent.

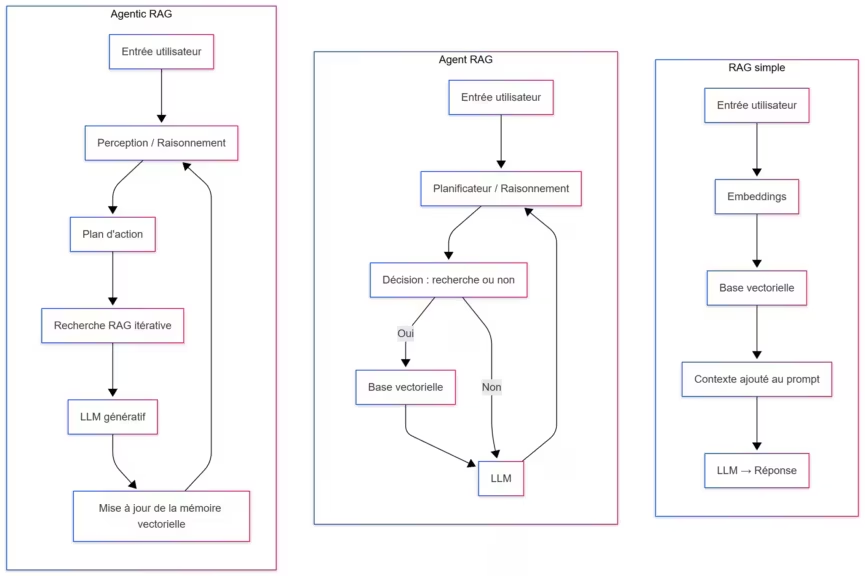

1. Le RAG classique : un système linéaire

Le RAG traditionnel repose sur une architecture séquentielle : une requête est vectorisée, la base recherche les passages les plus pertinents, et le modèle génère une réponse. C’est une approche efficace mais statique, qui ne prend pas d’initiative ni ne planifie d’actions. Elle fonctionne très bien pour des usages précis, comme les FAQ automatisées, les assistants de documentation ou les outils de recherche thématique.

2. L’Agent RAG : la prise de décision

L’Agent RAG franchit une étape supplémentaire en intégrant un moteur de planification. L’agent choisit quand et comment interroger la base vectorielle, décide s’il doit résumer, comparer, ou effectuer une nouvelle recherche. Il devient ainsi capable d’enchaîner plusieurs requêtes RAG dans un même raisonnement. Cette approche, implémentée dans des frameworks comme LangGraph ou OpenDevin, donne naissance à des assistants capables d’analyser des corpus complexes, d’évaluer des sources et de produire des synthèses argumentées.

3. L’Agentic RAG : la mémoire vivante

L’Agentic RAG marque l’arrivée de systèmes réellement autonomes et auto-apprenants. Ici, la base vectorielle n’est plus un simple dépôt de données, mais un espace de mémoire dynamique : l’agent y inscrit ce qu’il apprend, y ajoute les résultats de ses propres analyses et les réutilise pour améliorer ses décisions futures.

Ce cycle, observation, raisonnement, action, mise à jour de la mémoire, forme une boucle cognitive fermée, proche d’un comportement adaptatif. C’est la base de ce que l’on appelle désormais l’IA agentique (Agentic AI), où la connaissance n’est plus statique mais évolutive.

4. Une architecture clé pour les IA de demain

L’Agentic RAG ouvre la voie à des applications bien plus avancées :

- Systèmes de veille autonome capables d’indexer et d’analyser en continu des flux d’informations.

- Copilotes documentaires qui se mettent à jour sans intervention humaine.

- IA industrielles adaptant leur comportement en fonction du contexte opérationnel.

Selon une étude de Hackernoon, les architectures basées sur des bases vectorielles sont devenues la norme pour construire des agents disposant d’une mémoire persistante et contextuelle. Elles permettent aux modèles de conserver la trace de leurs raisonnements, d’apprendre au fil du temps et de relier leurs décisions à une base de connaissance cohérente.

En résumé, l’Agentic RAG transforme la relation entre modèle et données : la base vectorielle n’est plus une simple bibliothèque de vecteurs, mais une mémoire vivante où s’écrit l’expérience même de l’intelligence artificielle.

Open WebUI : rendre les bases vectorielles accessibles à tous

L’essor des bases vectorielles ne concerne plus uniquement les ingénieurs et chercheurs. Grâce à des outils comme Open WebUI, la puissance du RAG local devient accessible à un public beaucoup plus large. Cette interface open source transforme la complexité de l’intégration IA en une expérience fluide et visuelle, sans nécessiter la moindre ligne de code.

Un tableau de bord pour l’IA contextuelle

Open WebUI agit comme un pont entre les modèles d’IA locaux, tels que Ollama, vLLM, ou LM Studio, et les bases vectorielles comme Chroma, Qdrant ou LanceDB. L’utilisateur peut importer ses fichiers (PDF, notes Markdown, documents techniques), lancer l’indexation automatique, puis interroger sa base via une simple interface de chat.

Cette intégration simplifie l’usage de la recherche sémantique et du RAG : l’outil transforme chaque document en embeddings, les stocke dans une base vectorielle, puis les met à disposition du modèle au moment de la génération. En pratique, il devient possible de “converser” avec ses propres archives, sans jamais exposer les données à un service cloud.

Confidentialité et contrôle local

Open WebUI a séduit la communauté open source pour une raison essentielle : tout fonctionne localement. Les documents, les embeddings et les requêtes restent sur la machine de l’utilisateur, garantissant la confidentialité totale des échanges. Cette approche s’inscrit dans une tendance plus large, celle de l’IA locale, où la performance des modèles récents permet d’exécuter des tâches avancées sans dépendre d’une infrastructure distante.

Les frameworks comme LangChain ou LlamaIndex offrent déjà des intégrations natives avec Open WebUI, facilitant la création d’assistants RAG personnalisés capables d’exploiter des corpus internes. L’association avec Chroma (souvent utilisée comme moteur vectoriel par défaut) permet en quelques minutes de déployer un véritable assistant documentaire privé.

Un outil clé pour la vulgarisation du RAG

En rendant la recherche sémantique accessible, Open WebUI joue un rôle similaire à celui d’Ollama pour les modèles de langage : il démocratise l’usage local de l’intelligence artificielle. Pour les rédacteurs, chercheurs ou développeurs, il devient un environnement d’expérimentation concret pour comprendre comment fonctionne une base vectorielle et mesurer l’impact du RAG sur la qualité des réponses générées.

Open WebUI est désormais utilisé comme interface standard dans de nombreux projets open source associant LLM et recherche vectorielle locale, comme le confirment les retours de la communauté sur GitHub,

Faut-il créer sa propre base vectorielle locale ?

L’idée de bâtir une base vectorielle personnelle séduit de plus en plus d’auteurs, chercheurs, journalistes et développeurs. Mais faut-il réellement indexer toutes ses données pour bénéficier des avantages de la recherche sémantique ? La réponse dépend des besoins, des volumes et du niveau de contrôle recherché.

Pourquoi créer sa propre base vectorielle

Mettre en place une base vectorielle locale permet avant tout de capitaliser sur son propre savoir. Chaque article, document technique ou note de recherche peut être transformé en embeddings et stocké sous forme vectorielle. Cette base devient alors une mémoire sémantique personnelle, consultable par un modèle local tel que vLLM ou Ollama.

Les bénéfices sont immédiats :

- Confidentialité totale : les données ne quittent jamais la machine.

- Cohérence éditoriale : l’IA retrouve le style, la terminologie et les formulations propres à son auteur.

- Gain de productivité : les informations déjà rédigées ou analysées peuvent être réutilisées instantanément.

Cette approche permet par exemple à un rédacteur technique d’interroger directement sa base vectorielle pour retrouver une explication, une comparaison de matériel ou une conclusion déjà formulée dans un ancien article.

Les limites à connaître

Indexer toutes les données d’un disque dur n’a pas de sens. Chaque document converti en embedding consomme du stockage, du calcul et de la mémoire vive. De plus, une base surchargée peut rapidement produire des résultats bruyants et moins pertinents.

Une approche plus efficace consiste à structurer le savoir en bases thématiques distinctes :

- Articles et publications pour les contenus éditoriaux.

- Documentation technique pour les données structurées.

- Notes et projets pour les analyses ou travaux de recherche.

Cette segmentation facilite la maintenance et garantit des résultats mieux ciblés.

Outils et intégrations recommandés

Des solutions comme Chroma ou Qdrant simplifient considérablement la création de bases vectorielles locales. Elles peuvent être reliées à Open WebUI, LangChain ou LlamaIndex, formant un pipeline complet :

Documents → Embeddings → Base vectorielle → RAG → Réponse IACe type d’architecture est aujourd’hui considéré comme la colonne vertébrale des IA locales, permettant de combiner indépendance, performance et confidentialité.

Conclusion : la base vectorielle, mémoire et socle de l’IA contextuelle

Les bases vectorielles se sont imposées comme la colonne vertébrale invisible de l’intelligence artificielle moderne. Elles constituent bien plus qu’un simple outil de recherche : elles incarnent la mémoire sémantique qui permet aux modèles de langage et aux agents IA de comprendre, raisonner et interagir avec cohérence dans un environnement changeant.

Leur rôle est aujourd’hui central dans les architectures RAG (Retrieval-Augmented Generation) et Agentic RAG, où elles servent à relier la connaissance humaine à la puissance computationnelle des LLM. Elles offrent à l’IA une mémoire persistante, une compréhension du contexte et la capacité d’évoluer avec de nouvelles informations sans nécessiter de réentraînement complet.

Grâce à l’écosystème open source, Chroma, FAISS, Qdrant, Milvus, ou encore Open WebUI, cette technologie, autrefois réservée aux géants du cloud, est désormais accessible à tous. Elle équipe aussi bien des assistants documentaires locaux que des agents autonomes industriels, et devient le socle de l’IA personnelle et souveraine, capable de fonctionner sans connexion ni dépendance externe.

En définitive, la base vectorielle est à l’intelligence artificielle ce que la mémoire est à l’esprit humain : un espace de continuité, de sens et d’apprentissage. Sans elle, les modèles resteraient statiques et déconnectés de la réalité. Avec elle, ils deviennent contextuels et évolutifs.

Le marché mondial des bases vectorielles connaît une croissance rapide portée par l’explosion des usages en IA générative, en cloud computing et dans les secteurs à forte intensité de données. Selon plusieurs cabinets d’analyse, dont The Business Research Company, Polaris Market Research et SNS Insider, le marché devrait atteindre entre 3,04 et 3,2 milliards de dollars en 2025, contre environ 2,46 milliards en 2024.

Idées à explorer avec les bases vectorielles

Au-delà du RAG et des agents IA, les bases vectorielles ouvrent de nombreuses perspectives concrètes. Voici quelques pistes à explorer pour mieux comprendre leur potentiel :

- Recherche documentaire : créer un assistant capable de retrouver des passages pertinents dans des milliers de fichiers internes.

- Support client : alimenter un chatbot avec la documentation d’entreprise pour des réponses rapides et cohérentes.

- Cohérence éditoriale : aider les rédacteurs à maintenir un ton et un vocabulaire constants à partir de leurs anciens contenus.

- Veille et analyse : suivre automatiquement les tendances sectorielles en indexant des articles, rapports ou publications.

- Ingénierie logicielle : interroger directement une base vectorielle contenant le code source et la documentation API.

Ces usages ne sont qu’un aperçu. Les bases vectorielles offrent un terrain d’expérimentation vaste, où chaque domaine, du journalisme à la recherche scientifique, peut bâtir sa propre mémoire sémantique pour mieux valoriser ses connaissances.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !