Comment ChatGPT gère-t-il la confidentialité des données ?

Avec l’essor de l’intelligence artificielle générative, les questions autour de la confidentialité des données sont devenues cruciales. OpenAI, l’entreprise derrière ChatGPT, collecte et utilise des informations provenant des interactions des utilisateurs.

Mais comment ces informations personnelles sont-elles traitées ? Quels sont les risques et les protections mises en place ? Cet article détaille la politique de protection des données de ChatGPT et les précautions à prendre pour utiliser ce service en toute sécurité.

ChatGPT collecte-t-il les données des utilisateurs ?

Oui, ChatGPT enregistre les conversations des utilisateurs afin d’améliorer ses performances et d’entraîner ses modèles. OpenAI affirme que ces données sont collectées anonymement et ne sont pas revendues à des tiers à des fins commerciales.

Toutefois, les utilisateurs doivent savoir que tout contenu partagé avec l’IA peut potentiellement être exploité pour enrichir les modèles de traitement automatique du langage.

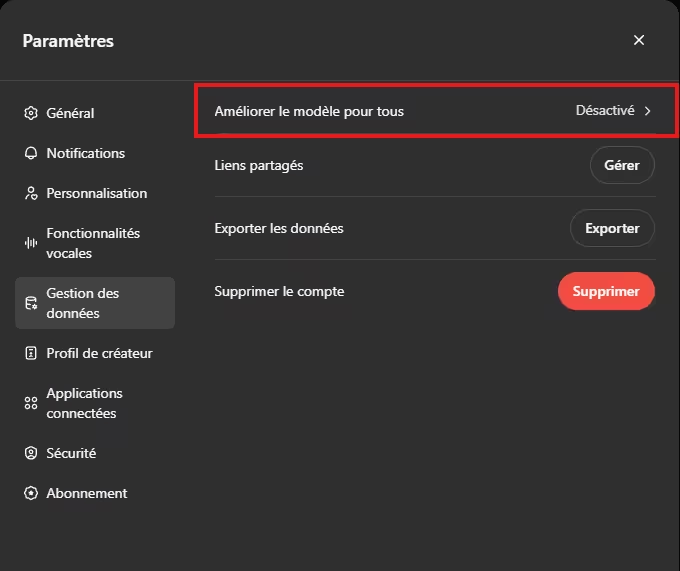

L’option « Améliorer le modèle pour tous » : un levier de confidentialité

OpenAI propose une option intitulée « Améliorer le modèle pour tous » qui permet aux utilisateurs de choisir si leurs conversations peuvent être utilisées pour entraîner et perfectionner ChatGPT. Cette fonctionnalité est activée par défaut, ce qui signifie que les interactions peuvent être analysées par OpenAI.

Cependant, en désactivant cette option, les utilisateurs renforcent leur confidentialité de plusieurs manières :

- Les conversations ne sont plus utilisées pour l’entraînement : réduisant ainsi le risque de voir des informations sensibles réutilisées dans de futures versions du modèle.

- Protection accrue des données personnelles : les informations partagées ne seront pas exploitées pour améliorer les réponses de l’IA.

- Meilleur contrôle sur les données partagées : l’utilisateur garde un pouvoir de décision sur la façon dont ses interactions sont traitées.

Pour désactiver cette option, il suffit de se rendre dans les Paramètres > Contrôles des données et de décocher « Améliorer le modèle pour tous ».

Les risques liés à la confidentialité des données

Malgré les efforts de sécurité des informations, plusieurs problèmes de confidentialité ont déjà été signalés. Par exemple, en mars 2023, une faille de sécurité a permis à certains utilisateurs de voir les titres des conversations d’autres personnes. Cette vulnérabilité a soulevé des interrogations sur la fiabilité des mécanismes de protection des données personnelles mis en place par OpenAI.

Pourquoi certaines entreprises préfèrent une IA locale ?

Certaines entreprises choisissent d’exécuter une intelligence artificielle en local (dans l’infrastructure de l’entreprise) plutôt que d’utiliser un service basé sur le cloud comme ChatGPT. Cette approche permet de se prémunir contre d’éventuelles fuites de données et de mieux contrôler la confidentialité des informations internes.

Voici les principaux avantages :

- Contrôle total des données : Aucune donnée sensible n’est transmise à un serveur externe, limitant ainsi les risques d’exposition.

- Protection contre les cyberattaques : En gardant les modèles IA en local, les entreprises réduisent les points d’entrée pour les hackers et les tentatives de fuite d’informations.

- Conformité aux réglementations : De nombreuses entreprises, notamment dans les secteurs bancaires ou gouvernementaux, sont soumises à des normes strictes sur la protection des données personnelles et doivent éviter le stockage externe de leurs données.

- Performance et réactivité : Exécuter un modèle IA en interne permet d’éviter les latences et de garantir un fonctionnement fluide sans dépendre d’une connexion internet.

Bien que cette solution demande des ressources matérielles conséquentes, elle offre un niveau de sécurité bien plus élevé pour les entreprises manipulant des données sensibles.

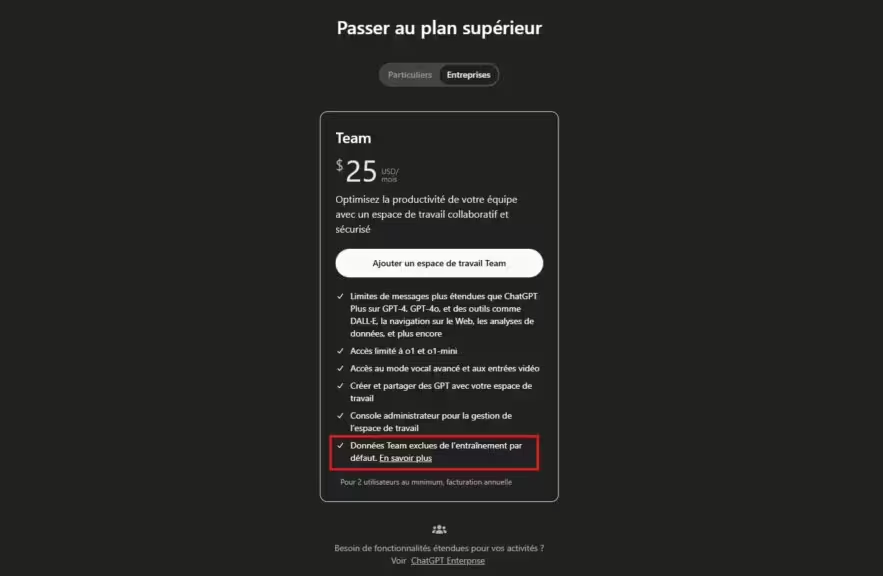

L’abonnement « Team » de ChatGPT visait principalement les entreprises avec la mention « Données Team exclues de l’entrainement par défaut ». Toutefois il ne s’agit que de l’option « Améliorer le modèle pour tous » qui est désactivée par défaut.

Les craintes de entreprises ne se limitent à l’exploitation des données par OpenAI. Un des risques à utiliser une interface Web pour accéder au Cloud, c’est également l’interception des informations entre le client et le Cloud.

D’ailleurs OpenAI a lancé en janvier 2025, ChatGPT Gov pour les gouvernements, afin de répondre à la nécessité de proteger des données hautement sensibles.

Pour aller plus loin : IA local : guide complet pour installer et utiliser un modèle sur votre ordinateur

Quelles protections sont mises en place ?

OpenAI a pris plusieurs mesures pour limiter les risques :

- Anonymisation des données : les informations sensibles sont censées être dépersonnalisées avant d’être utilisées.

- Politique de suppression : il est possible de demander l’effacement de certaines données.

- Conformité au RGPD : en Europe, OpenAI s’efforce de respecter les exigences légales sur la protection de la vie privée.

Comment limiter les risques ?

Pour minimiser les risques de fuite d’informations sensibles, voici quelques conseils :

- Ne partagez jamais de données personnelles avec ChatGPT.

- Désactivez l’option « Améliorer le modèle pour tous » pour empêcher l’utilisation de vos conversations.

- (optionel) Désactivez l’historique des conversations si possible. Vos conversations seront quand même conservées pendant 30 jours pour permettre à OpenAI d’identifier les abus. Je vous conseille donc de laisser cette option activée, elle reste très pratique pour retrouver ces anciennes discutions. En revanche, si la confidentialité des données est un point crucial, c’est une option à mettre en place.

- Consultez régulièrement la politique de confidentialité d’OpenAI pour rester informé des changements.

Conclusion

L’utilisation de ChatGPT soulève des enjeux importants en matière de protection des données. Bien que des mécanismes de sécurité existent, les utilisateurs doivent rester prudents et adopter de bonnes pratiques pour préserver leur vie privée.

L’option « Améliorer le modèle pour tous » joue un rôle clé dans le contrôle des données partagées : la désactiver permet de renforcer la confidentialité et de limiter l’exploitation des conversations par OpenAI. En restant informés et en prenant des précautions, il est possible d’utiliser cette technologie de manière sûre et responsable.

A lire également : L’exécution d’IA en local : une tendance en forte croissance

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !