Claude Haiku 4.5 et la nouvelle vague des IA “efficaces” ?

L’intelligence artificielle n’est plus l’apanage des grands modèles lourds et coûteux. Avec Claude Haiku 4.5, Anthropic ouvre un nouveau chapitre : celui des IA efficaces, capables d’offrir des performances de haut niveau à un coût bien plus abordable.

Dans un monde où les agents IA, l’automatisation et la programmation assistée par LLM se multiplient, cette recherche d’équilibre entre puissance, vitesse et coût devient cruciale. L’enjeu n’est plus seulement la précision, mais l’efficience économique.

Qu’est-ce qu’une IA “efficace” ?

Une IA efficace n’est pas forcément la plus intelligente, mais celle qui en fait le plus avec le moins de ressources. Elle combine vitesse d’exécution, qualité de raisonnement et optimisation du coût par requête.

Performance, coût et latence : un nouvel équilibre

Historiquement, les modèles d’IA ont suivi une trajectoire simple : toujours plus grands, toujours plus chers. Mais cette logique montre ses limites. Chaque appel à un grand modèle comme GPT-5 ou Claude 4.5 peut coûter des centaines de jetons, voire davantage lorsqu’il s’agit d’agents IA autonomes effectuant des tâches en boucle.

Avec l’explosion des usages — assistants personnels, chatbots, génération de code, agents de veille — le volume d’appels API a explosé. Les entreprises qui automatisent massivement via ces modèles voient leur facture cloud grimper en flèche. D’où un recentrage sur la rentabilité des modèles IA : réduire les coûts sans sacrifier la qualité.

Des modèles lourds aux modèles optimisés

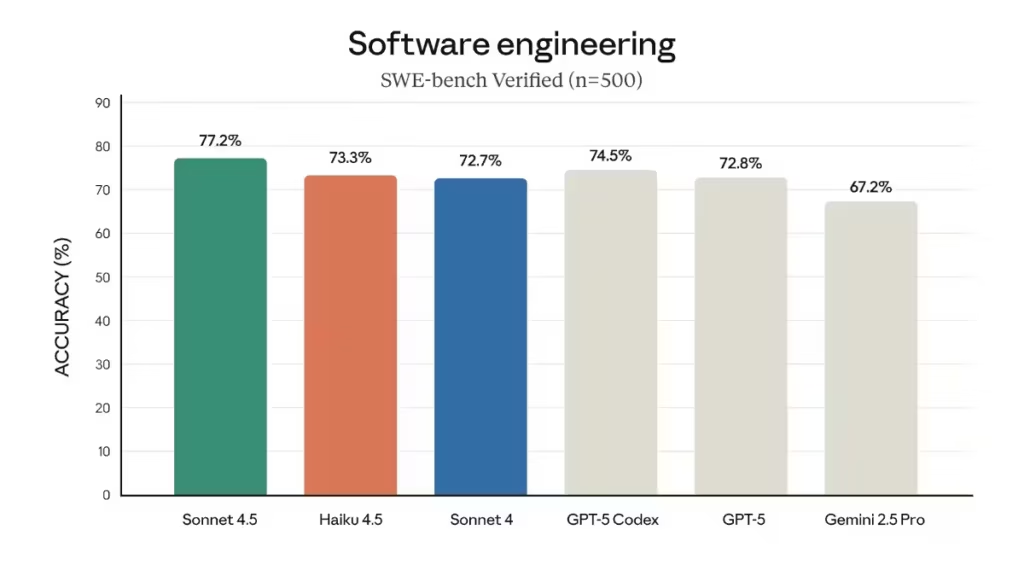

C’est dans ce contexte qu’émerge une nouvelle génération de modèles “small but powerful”, plus compacts mais presque aussi performants que leurs homologues “frontier”. Claude Haiku 4.5 illustre parfaitement cette tendance : une IA qui atteint 90 % des performances de Sonnet 4.5, tout en coûtant trois fois moins cher et en répondant deux fois plus vite (Anthropic, 2025).

Un enjeu pour les entreprises et les développeurs

Pour les entreprises, cette évolution est stratégique. Un modèle “efficace” permet de multiplier les tâches automatisées (résumés, veille, analyse de code, génération de contenu) tout en gardant le contrôle des coûts. C’est aussi un moyen de réduire la dépendance au cloud : beaucoup migrent désormais vers des LLM open source déployés localement, dans une quête d’autonomie et de confidentialité.

Claude Haiku 4.5 : caractéristiques et positionnement

Lancé en octobre 2025, Claude Haiku 4.5 est la version la plus rapide et la plus performante de la gamme “Haiku”. Il se distingue par une intelligence quasi-frontière, une vitesse record et une efficacité énergétique inédite.

Des performances proches des grands modèles

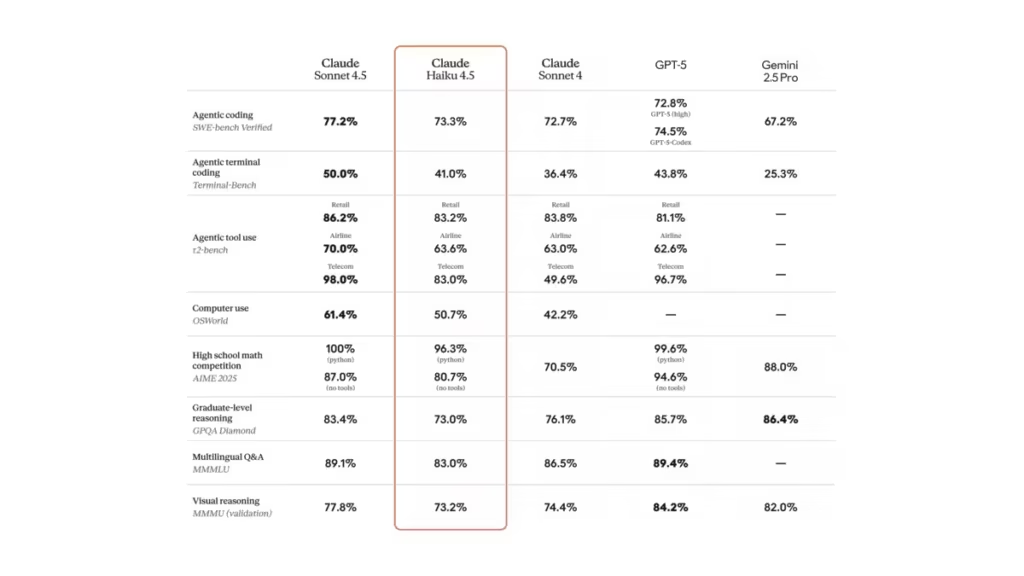

Selon Anthropic, Haiku 4.5 atteint 73,3 % sur le benchmark SWE-bench Verified, un test de référence en programmation. Ce score le place juste derrière Sonnet 4.5, considéré comme le meilleur modèle de codage au monde. Il est aussi quatre à cinq fois plus rapide que Sonnet sur les tâches d’édition et de raisonnement pratique, tout en coûtant un tiers du prix (1 $/5 $ par million de tokens).

Cette combinaison fait de Haiku 4.5 une solution idéale pour les développeurs et les projets à haut volume de requêtes : pair programming, prototypage rapide, analyse de code ou agents collaboratifs.

Une IA pensée pour les usages temps réel

Haiku 4.5 a été conçu pour répondre à des tâches nécessitant faible latence et interactivité continue. Dans Claude for Chrome ou Claude Code, les utilisateurs constatent une fluidité accrue et une réactivité immédiate. Son intégration à GitHub Copilot confirme sa vocation : offrir un modèle IA rapide et économique pour la génération de code au quotidien.

Un design pensé pour les agents multiples

Anthropic pousse aussi un concept inédit : l’orchestration multi-agent. Sonnet 4.5 peut, par exemple, planifier un projet complexe et déléguer l’exécution à plusieurs Haiku 4.5 en parallèle (Anthropic, 2025). Ce schéma est clé dans les architectures modernes : il permet d’accélérer les workflows tout en contenant les coûts. Là où un grand modèle monopolise des ressources pour tout faire, une armée de petits Haiku 4.5 exécute plus vite, à moindre coût.

Pourquoi cette nouvelle vague de modèles “small but powerful”

Le compromis optimal entre coût et latence

L’efficacité ne se mesure plus seulement à la qualité du résultat, mais aussi à la rapidité et au prix. Haiku 4.5 illustre cette philosophie : offrir une intelligence “suffisante” pour la majorité des cas d’usage, tout en restant ultra-compétitif sur le plan économique. Les modèles moyens deviennent désormais le choix par défaut pour l’IA opérationnelle (assistants internes, automatisations, analyse documentaire, code refactoring).

Scalabilité et industrialisation des usages IA

Dans un contexte où les agents IA prolifèrent, chaque tâche supplémentaire génère un coût marginal. Un modèle trois fois moins cher multiplie donc les possibilités de déploiement à grande échelle. Pour les plateformes d’IA, cela ouvre la voie à des applications massives : support client, testing automatisé, création de contenu ou orchestration de sous-agents.

Des architectures plus intelligentes et légères

Cette vague des IA efficaces s’appuie sur des techniques comme la distillation, la quantification et les architectures hybrides (Mixture of Experts). L’objectif : réduire la taille du modèle sans altérer sa capacité de raisonnement. Haiku 4.5 en est l’incarnation la plus visible — un modèle “light” capable de battre certaines IA premium dans des tâches ciblées (Reddit).

Cette recherche d’efficacité ne concerne pas seulement les modèles d’IA, mais aussi les formats de calcul eux-mêmes. NVIDIA, par exemple, a introduit le format NVFP4, une précision 4-bit pensée pour accélérer l’inférence et l’entrainement tout en réduisant la consommation énergétique et la charge mémoire.

Ce type d’innovation illustre bien la même philosophie que Claude Haiku 4.5 : accepter une légère perte de précision pour un gain majeur en vitesse et en coût. Une tendance forte dans l’industrie, où la performance brute cède peu à peu la place à l’efficience calculatoire.

Avantages, limites et risques de Claude Haiku 4.5

Les avantages : rapidité, coût et polyvalence

Les premiers retours d’utilisateurs sur Reddit et GitHub sont quasi unanimes : Claude Haiku 4.5 frappe fort là où ça compte — la vitesse et le coût. Les développeurs notent que les sessions sont « nettement plus fluides », y compris sur des tâches complexes, tout en consommant beaucoup moins de tokens (Reddit).

Ce gain d’efficacité se traduit par :

- une latence réduite, idéale pour les agents temps réel ;

- un coût trois fois inférieur à Sonnet 4 pour des performances comparables ;

- une capacité de déploiement massive sur API ou applications ;

- un excellent rapport qualité/prix pour les environnements à forte volumétrie.

Pour beaucoup d’entreprises, cette combinaison change la donne : il devient enfin possible d’automatiser des centaines de requêtes par minute sans exploser le budget. Dans le développement, le support client ou la veille automatisée, Haiku 4.5 s’impose comme un modèle de production rentable.

Les limites : raisonnement complexe et contexte long

Mais cette efficacité a ses revers. Claude Haiku 4.5 reste un modèle “small” : il excelle sur les tâches unitaires, mais montre des faiblesses sur les raisonnements longs ou les projets nécessitant une mémoire contextuelle profonde. Des utilisateurs rapportent une perte de cohérence dans les conversations prolongées ou les projets multi-fichiers, là où Sonnet 4.5 garde une vision plus globale (Reddit).

De plus, certains testeurs mentionnent des instabilités de contexte dans les architectures multi-agents lorsque plusieurs instances de Haiku 4.5 interagissent en parallèle. Ces cas restent marginaux mais soulignent la difficulté d’orchestrer un grand nombre de modèles rapides sans supervision fine.

Les risques : inflation des coûts cachés et uniformisation

L’ironie, c’est qu’une IA “moins chère” peut paradoxalement coûter plus, si elle incite à multiplier les appels. Dans des environnements automatisés où des agents exécutent des boucles de tâches, même un modèle économique peut rapidement faire grimper la facture. Cette “économie apparente” exige donc une gouvernance stricte : quota de tokens, hiérarchisation des tâches, et équilibre entre modèles légers et puissants.

Autre risque : la standardisation du milieu de gamme. Si tous les acteurs convergent vers les mêmes architectures optimisées, l’innovation pourrait ralentir. On verrait émerger une génération d’IA “rapides mais peu différenciées”, uniformisant la créativité algorithmique.

Perspectives : vers une IA plus sobre et distribuée

La montée en puissance des architectures hybrides

L’avenir s’annonce hybride. Anthropic le montre déjà : Sonnet 4.5 peut planifier, tandis qu’un essaim de Haiku 4.5 exécute les sous-tâches. Cette combinaison entre cerveau stratégique et bras opérationnels pourrait devenir la norme. Les entreprises construiront des systèmes modulaires où chaque IA joue un rôle précis — planification, exécution, vérification — en fonction de son coût et de ses capacités.

Vers une IA plus distribuée et locale

Face à la pression des coûts et aux enjeux de confidentialité, les modèles open source gagnent du terrain. Des LLM comme Qwen 3 Next, DeepSeek V3.2 ou Mistral Large s’installent sur des serveurs internes, offrant un contrôle total et supprimant la dépendance au cloud.

Claude Haiku 4.5, grâce à son efficience et compatibilité API, s’intègre parfaitement dans cette logique d’infrastructure distribuée : une IA performante, rapide et modulaire, déployable partout.

Une nouvelle ère de sobriété computationnelle

Nous entrons dans une ère où la sobriété numérique devient un critère clé d’innovation. Les modèles comme Haiku 4.5 montrent que la performance ne réside plus dans la taille, mais dans l’optimisation de chaque token. Cette philosophie “efficace” pourrait inspirer une nouvelle génération de modèles orientés usage, agissant comme des assistants spécialisés plutôt que des encyclopédies omniscientes.

Conseils pour exploiter ces modèles dans vos projets

Choisir le bon modèle pour le bon usage

- Haiku 4.5 pour les tâches réactives, le prototypage, le pair programming, ou les agents rapides.

- Sonnet 4.5 pour les analyses longues, le raisonnement complexe ou la génération de code multi-fichiers.

- Combinaison des deux pour maximiser vitesse et cohérence.

Penser en termes d’architecture

Un schéma simple : Sonnet 4.5 planifie → Haiku 4.5 exécute → Sonnet vérifie. Cette approche multi-modèle réduit le coût global tout en conservant la qualité du résultat.

Surveiller et maîtriser les coûts

Définissez des limites de tokens par agent, centralisez la facturation, et ajustez la profondeur de raisonnement (thinking tokens) selon le besoin réel. Anthropic propose déjà des contrôles précis via l’API Claude pour ajuster la consommation en temps réel (Claude Docs).

Conclusion

Claude Haiku 4.5 n’est pas simplement un modèle plus rapide et plus abordable. Il symbolise une évolution de fond dans la manière dont l’intelligence artificielle progresse : une IA utile, économe et accessible, où l’objectif n’est plus la démesure mais l’efficience maîtrisée.

Dans un écosystème où chaque requête IA a un coût, où les agents automatisés multiplient les appels API et où la vitesse devient un levier stratégique, Haiku 4.5 ouvre la voie d’un futur plus sobre, modulaire et intelligent.

L’ère des IA “efficaces” ne fait que commencer, et face à la montée des LLM open source et open weight, une question demeure : cette nouvelle efficience suffira-t-elle à freiner leur irrésistible ascension ?

A lire également : IA local : guide complet pour installer et utiliser un modèle sur votre ordinateur

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !