ComfyUI : choisir la taille de modèle adaptée à votre VRAM

Vous souhaitez exploiter toute la puissance de ComfyUI sans faire planter votre PC ? Vous n’arrivez pas à trouver le bon équilibre entre la taille des modèles, la qualité du rendu et votre quantité de VRAM ? Avec les workflows IA de plus en plus complexes, bien choisir la taille de modèle ComfyUI adaptée à votre VRAM est devenu un passage obligé pour créer des images stables, rapides et de haute qualité. Les modèles de Workflow proposés par défaut dans ComfyUI varient énormément, certains sont prévus pour tourner sur de petite configuration avec une faible qualité de rendu, d’autres utilise des modèles beaucoup trop volumineux même sur une RTX 5090.

Dans cet article, nous allons vous guider étape par étape pour comprendre comment la VRAM ComfyUI est utilisée, comment la taille des modèles de diffusion et des modèles CLIP ComfyUI impacte la mémoire graphique, et surtout, comment adapter vos choix selon votre GPU et vos objectifs créatifs. Vous découvrirez des conseils pratiques, des exemples concrets selon la quantité de VRAM : 12 Go, 24 Go, 32 Go ou 48 Go, ainsi que des astuces pour optimiser vos workflows ComfyUI sans sacrifier la qualité de vos générations.

Que vous soyez créateur d’images, développeur ou simple passionné d’IA, ce guide vous permettra de choisir le modèle ComfyUI adapté à votre VRAM, d’éviter les plantages et d’améliorer votre productivité, tout en utilisant au mieux votre matériel pour donner vie à vos projets visuels dans ComfyUI. Ce guide s’adresse également à ceux qui souhaitent utiliser ComfyUI le plus simplement possible avec les Workflow par défaut, sans se plonger dans le paramétrage, la modification ou la création de Workflow. Même si ComfyUI s’avère un peu complexe, il rend la génération d’image en local accessible à tous.

Pourquoi la VRAM est cruciale avec ComfyUI

La VRAM dans ComfyUI est un élément essentiel pour garantir des générations stables et rapides. Choisir la bonne taille de modèle adaptée à votre GPU est un élément crucial. Cette mémoire graphique, également appelée mémoire vidéo, permet à votre carte GPU de charger les modèles de diffusion ComfyUI, les modèles CLIP ComfyUI et interpréteur de texte, et l’ensemble des étapes de génération. Lorsque vous dépassez votre quantité de VRAM, les temps d’execution explosent et parfois cela provoque également des erreurs.

Dans ComfyUI, la consommation de VRAM dépend directement de la taille modèle ComfyUI que vous choisissez. Plus le modèle est lourd, plus la mémoire graphique nécessaire sera importante, ce qui peut rapidement saturer la VRAM, même sur des cartes puissantes comme une RTX 4090 ou RTX 5090. En optimisant votre workflow ComfyUI, vous pouvez réduire l’utilisation mémoire tout en maintenant une excellente qualité de génération, en adaptant vos choix selon votre GPU, la résolution souhaitée et le modèle de diffusion ComfyUI utilisé.

Pour choisir le modèle adapté à votre VRAM, il est donc crucial de comprendre que chaque étape consomme une partie de la mémoire vidéo, qu’il s’agisse du modèle de diffusion, des encodeurs texte ou des processus intermédiaires. Optimiser la consommation mémoire GPU dans ComfyUI vous permettra de générer vos images ou vidéo sans crash tout en utilisant la meilleure taille de modèle possible selon votre VRAM, que ce soit pour des workflows lourds ou des projets plus légers.

Taille de modèle dans ComfyUI : comprendre les différences

Lorsque l’on souhaite choisir la taille de modèle ComfyUI adaptée à sa VRAM, il est important de comprendre pourquoi un fichier modèle affichant 20 Go sur disque peut utiliser 24 à 28 Go de mémoire graphique lors de son exécution dans ComfyUI. La VRAM ComfyUI ne se limite pas au stockage des poids du modèle : elle gère aussi les activations intermédiaires, les buffers temporaires et les calculs pendant le workflow, ce qui augmente la consommation mémoire GPU. Il n’est donc pas possible de charger un modèle de 24 Go en mémoire avec 24 Go de VRAM, sans perte massive de performances. De plus, les pilotes de la carte graphique et d’autres modules occupent une partie de la VRAM (variable de 1 à 2 Go). Globalement avec 24 Go de VRAM, il faut cibler un modèle en mémoire d’environ 20 Go maximum, sans autre modèles complémentaires.

Les modèles dans ComfyUI se déclinent en plusieurs formats, influençant directement leur impact sur la VRAM. Les modèles FP32 (float 32 bits) offrent la précision maximale mais nécessitent une grande quantité de mémoire vidéo, tandis que les modèles FP16 (float 16 bits) réduisent de moitié cette consommation sans perte significative de qualité, de même pour les FP8 de plus en plus utilisés. Pour optimiser votre VRAM, vous pouvez également utiliser des modèles quantifiés Q4 ou Q8, qui permettent de réduire drastiquement la taille en mémoire tout en maintenant une qualité suffisante pour la majorité des usages dans ComfyUI.

Il est également essentiel de distinguer la taille des modèles de diffusion ComfyUI et celle des modèles CLIP ComfyUI ou T5 utilisés pour le traitement des prompts texte. Ces derniers, notamment les modèles T5 XXL ou LLama, peuvent consommer plusieurs gigaoctets de mémoire graphique supplémentaires si vous choisissez de les charger sur le GPU. Pour optimiser votre workflow ComfyUI, vous pouvez envisager de déporter ces modèles texte sur le CPU afin de libérer la VRAM, ce qui vous permettra de choisir un modèle ComfyUI plus lourd adapté à votre VRAM pour le modèle de diffusion sans risquer de saturer votre mémoire graphique. Attention cependant certains modèles supportent mal la fonctionnalité « OffLoading » CPU et provoque des freezes/plantage de l’ordinateur.

Exemple d’un modèle qui dépasse la capacité de la mémoire

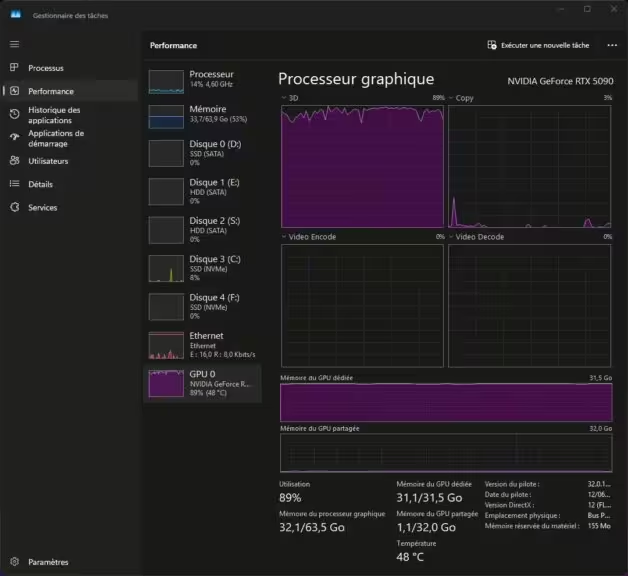

Le gestionnaire des tâches de Windows est suffisant pour savoir quand un modèle ou plus largement un Workflow dépasse la capacité de votre VRAM. La capture ci-dessous illustre le problème avec l’utilisation du modèle hidream_i1_full_fp16.safetensors de 33Go (taille du fichier) et un Workflow avec les modèles T5XXL FP8 et Llama 3.1 8b. J’ai choisi volontairement un modèle très lourd pour l’exemple, mais la logique reste là même tant que le modèle dépasse la capacité de votre VRAM.

A noter, le processus GPU n’est pas à 100%, ce qui indique un ralentissement dû au Swap (VRAM/RAM)

Cela ne créé pas d’erreur, mais le temps de rendu devient trop long. Il s’agit d’un Workflow de base, non optimisé. De nombreuses options sont possibles pour faire tourner ce modèle dans de bonnes conditions.

Pour optimiser ce Workflow et obtenir des temps d’execution convenables, voici les différentes options :

- Changer le fichier modèle hidream_i1_full_fp16.safetensors, utilisez une version FP8 ou GGUF (avec un UNET Loader GGUF). Cela entraine une perte de précision, mais dans de nombreux cas cela reste acceptable. Effectuez des tests pour identifier le bon modèle en fonction de votre configuration.

- Déchargez les modèles CLIP sur le CPU : plus lent mais le modèle de diffusion aura plus de VRAM. Potentiellement le modèle de diffusion sera plus rapide (c’est la tâche la plus lourde) et globalement le rendu également plus court.

- Mettre en place des optimisations de la mémoire dans le Workflow (plus complexe)

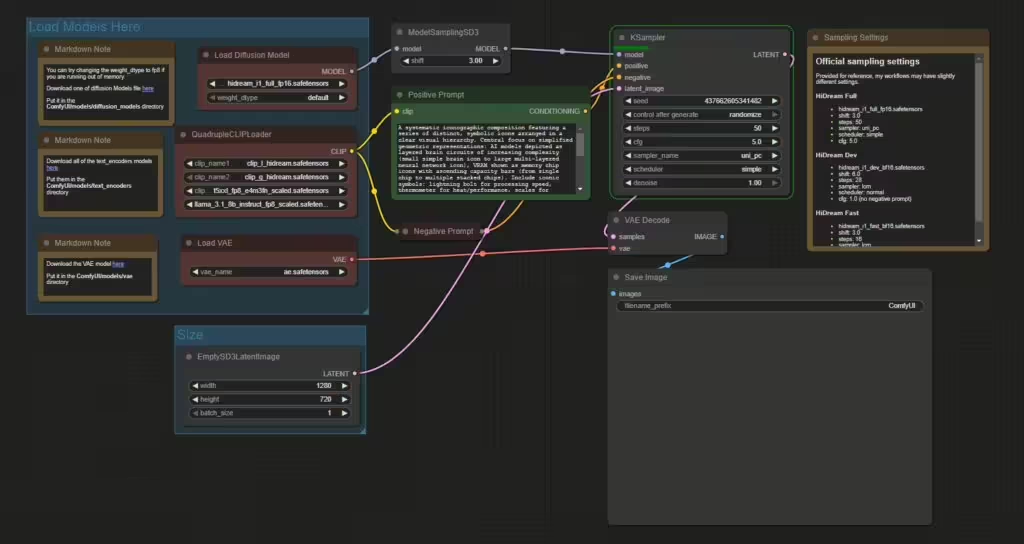

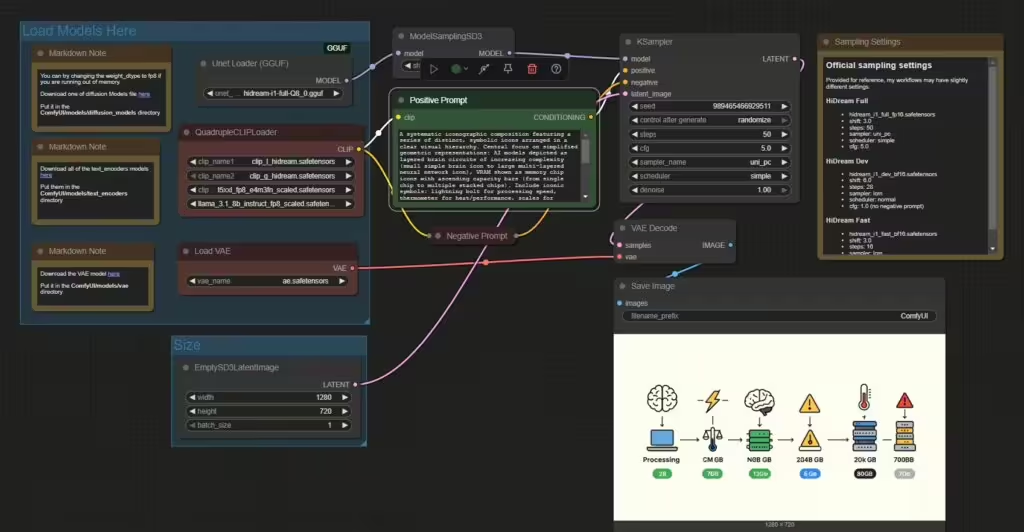

Je modifie le Workflow avec une version GGUF quantifié à 8K (hidream-i1-full-Q8_0.gguf de city96 sur Hugging Face), le fichier fait 18,7 Go. Le temps d’execution passe alors à 120 secondes, l’utilisation de la VRAM est à la limite. En passant les modèles CLIP en GGUF, le temps d’execution tombe à 60 secondes. Il est possible d’utiliser également la version FP8.

Comment choisir la bonne taille de modèle dans ComfyUI selon votre VRAM

Pour choisir la taille de modèle ComfyUI adaptée à votre VRAM, commencez par évaluer la mémoire graphique disponible sur votre GPU (RTX 4070, 4080, 4090, 5090, etc.) et ajustez vos workflows en conséquence pour éviter des temps d’execution excessifs et les erreurs « out of memory » dans ComfyUI. Cette approche vous permettra d’optimiser l’utilisation de votre VRAM ComfyUI tout en maintenant une bonne qualité de génération.

Si votre GPU dispose de 12 Go de VRAM, privilégiez des modèles de diffusion quantifiés en FP8 ou Q6, utilisez un batch size de 1 (privilégiez le bouton Run en indiquant le nombre d’execution), et n’hésitez pas à charger vos modèles CLIP ComfyUI sur le CPU pour libérer la mémoire vidéo.

Avec 24 Go de VRAM, vous pouvez opter pour des modèles FP16 de taille intermédiaire et générer des images en haute résolution tout en maintenant une stabilité dans ComfyUI. Pour les utilisateurs avec 32 Go ou 48 Go de VRAM, il est possible de choisir des modèles ComfyUI plus lourds, en FP16 ou même FP32 selon le projet, tout en travaillant avec des résolutions élevées et des batchs plus importants.

Pour optimiser la consommation mémoire GPU dans ComfyUI :

- Utilisez des modèles quantifiés (Q4, Q8) si disponibles, notamment sur les modèles de diffusion volumineux.

- Déchargez les modèles CLIP sur le CPU pour conserver votre VRAM disponible pour le modèle de diffusion.

- Laissez le batch size à 1 lors de la génération pour limiter les pics de consommation mémoire. Utilisez plutôt le bouton Run en indiquant le nombre d’itération.

- Surveillez l’utilisation de la VRAM avec le gestionnaire des tâches ou nvidia-smi afin d’adapter votre workflow et vos résolutions en fonction de votre projet.

Cette méthode vous permettra de choisir le modèle ComfyUI le mieux adapté à votre VRAM, d’optimiser votre mémoire vidéo, d’éviter les plantages et de maintenir une qualité élevée dans vos créations générées avec ComfyUI.

| Critère | FP16 | FP8 | GGUF Q8 |

|---|---|---|---|

| Type | Float 16 bits (demi-précision) | Float 8 bits | Int 8 bits quantifié (GGUF) |

| Qualité d’image | ✅ Excellente | ✅ Très bonne (légère perte) | ⚠️ Bonne (pertes légères visibles) |

| Consommation VRAM | ⚠️ Élevée | ✅ Moyenne (30-40% de gain vs FP16) | ✅ Très faible (60-70% de gain vs FP16) |

| Performance (vitesse) | Moyenne à rapide | ✅ Rapide sur GPU compatible | Variable (CPU plus lent, GPU variable) |

| Compatibilité | Large (tous GPU, ComfyUI standard) | Limité (GPU récents, support backend requis) | Large (via ComfyUI-GGUF, llama.cpp) |

| Utilisation recommandée | Si VRAM disponible, besoin de qualité max | VRAM limitée mais qualité importante | VRAM très limitée ou usage CPU |

Exemple pratique : ComfyUI avec 12 Go, 24 Go, 32 Go, 48 Go de VRAM

Pour choisir la taille de modèle ComfyUI adaptée à votre VRAM, voici des exemples concrets selon votre carte graphique et sa mémoire vidéo, afin d’éviter les erreurs de mémoire et d’optimiser vos workflows dans ComfyUI :

Avec 12 Go de VRAM (ex : RTX 5070) :

- Utilisez des modèles quantifiés Q4 ou Q8 ou des modèles FP16 légers (3 à 8 Go sur disque).

- Chargez le modèle CLIP ComfyUI sur le CPU pour libérer la VRAM.

- Limitez la résolution (par exemple 768×768) et le batch size à 1.

- Évitez les workflows complexes avec des étapes multiples consommant simultanément de la mémoire graphique.

Avec 24 Go de VRAM (RTX 3090, RTX 4090) :

- Vous pouvez choisir des modèles FP16 de taille moyenne (10 Go à 19 Go sur disque).

- Utiliser un modèle CLIP sur le GPU est possible, mais si le workflow est complexe, le décharger sur le CPU reste recommandé.

- Travailler avec des résolutions de 1024×1024 est envisageable sans saturer la VRAM.

Avec 32 Go de VRAM (RTX 5090) :

- Permet d’utiliser des modèles FP16 lourds ou quantifiés Q8 de grande taille (jusqu’à 14-26 Go sur disque).

- Résolutions élevées comme 1024×1024 ou 1536×864 sans risque de crash.

- Possibilité de maintenir le modèle CLIP ComfyUI sur le GPU tout en utilisant un grand modèle de diffusion dans ComfyUI.

Avec 48 Go de VRAM (RTX 6000 ADA 48 Go, A6000) :

- Vous pouvez choisir des modèles ComfyUI FP16 ou FP32 très lourds (20-30 Go sur disque).

- Résolutions très hautes (jusqu’à 1536×1536, voire 2048×1152 selon le modèle).

- Batch size élevé (2, 4 ou plus) si nécessaire pour la génération en série.

- Workflow complexe avec plusieurs modèles (VAE haute résolution, Loras, UNet lourds) gérés sans problème.

Comme carte professionnelle, il existe également la dernière génération avec la RTX Pro 6000 Blackwell et ses 96 Go de VRAM, mais le prix s’envole au dessus des 10 000 €.

Optimiser ComfyUI sans sacrifier la qualité : bonnes pratiques

Pour choisir la taille de modèle ComfyUI adaptée à votre VRAM sans sacrifier la qualité des rendus, il est essentiel d’adopter des méthodes permettant d’optimiser la consommation de mémoire graphique tout en maintenant de bonnes performances de génération.

Réduire le batch size est l’une des méthodes les plus simples pour diminuer l’utilisation de votre VRAM ComfyUI. Un batch size de 1 permet souvent de libérer plusieurs Go de mémoire, permettant d’utiliser des modèles de diffusion plus lourds ou d’augmenter la résolution sans plantage. Pour effectuer plusieurs itérations successive, préférez le bouton Run en précisant le nombre d’execution.

L’utilisation de modèles quantifiés (Q4, Q8) permet de réduire la taille des modèles en mémoire de 30 à 70 % sans perte de qualité majeures en Q6 ou Q8 dans la majorité des cas. Cela permet de choisir un modèle ComfyUI plus grand même avec une VRAM modeste, tout en conservant une excellente qualité des rendus.

Décharger le modèle CLIP ComfyUI sur le CPU est une stratégie efficace, notamment si vous utilisez un modèle texte volumineux comme T5 XXL ou LLamA. Bien que cela puisse légèrement ralentir l’étape d’encodage texte, cela libère plusieurs Go de VRAM pour le modèle de diffusion, essentiel pour les workflows lourds.

Surveiller la consommation mémoire GPU est indispensable, notamment via l’outil nvidia-smi ou le gestionnaire des tâches de Windows, afin d’ajuster en temps réel la résolution, le batch size ou même la taille du modèle utilisé dans ComfyUI selon les besoins de votre projet.

Enfin, privilégier les modèles essentiels dans vos workflows et éviter d’accumuler inutilement des modèles lourds ou des étapes complexes permet de stabiliser vos générations tout en utilisant efficacement la VRAM ComfyUI. Ces bonnes pratiques vous permettront d’exploiter tout le potentiel de votre GPU, de choisir la taille de modèle ComfyUI adaptée à votre VRAM et d’éviter les erreurs, tout en générant des images de haute qualité avec ComfyUI.

FAQ : taille des modèles et VRAM dans ComfyUI

Pas nécessairement. Bien que les grands modèles de diffusion puissent améliorer la qualité des détails ou des rendus complexes, leur utilisation dépend de la VRAM ComfyUI disponible sur votre GPU. Il est préférable de choisir la taille de modèle ComfyUI adaptée à votre VRAM plutôt que de surcharger votre mémoire graphique.

Si vous rencontrez une erreur u0022out of memoryu0022, réduisez immédiatement la taille du modèle ComfyUI en optant pour une version quantifiée (Q4 ou Q8), baissez la résolution ou le batch size, ou déplacez le modèle CLIP ComfyUI sur le CPU afin de libérer de la VRAM. Surveillez l’utilisation de votre mémoire graphique avec nvidia-smi pour identifier les pics de consommation et ajuster vos paramètres.

Actuellement, dans ComfyUI, les modèles CLIP restent en mémoire GPU ou CPU pendant l’exécution du workflow, mais il est possible de choisir de charger le modèle CLIP ComfyUI sur le CPU avant la génération afin de libérer la VRAM pour le modèle de diffusion. Segmenter votre workflow (par exemple, générer les embeddings texte puis passer à la diffusion) est également une méthode efficace pour optimiser l’utilisation de votre mémoire graphique.

Avec 12 Go de VRAM : 768×768 en batch size 1.

Avec 24 Go de VRAM : 1024×1024 en batch size 1-2 selon le modèle.

Avec 32 Go de VRAM : jusqu’à 1536×864 ou 1024×1536 en batch size 1-2.

Avec 48 Go de VRAM : 1536×1536 ou 2048×1152 en batch size 1-4 selon le modèle.

Adapter la résolution en fonction de votre VRAM ComfyUI vous permettra de stabiliser vos workflows tout en générant des images de qualité, sans compromettre vos projets dans ComfyUI.

Conclusion : bien choisir la taille de votre modèle ComfyUI pour votre VRAM

Pour tirer le meilleur parti de ComfyUI, il est essentiel de choisir la taille de modèle ComfyUI adaptée à votre VRAM, afin d’exploiter pleinement la puissance de votre GPU RTX sans provoquer d’erreurs « out of memory ». En comprenant les différences entre les modèles FP32, FP16 et quantifiés, ainsi que l’impact de la résolution, du batch size et du modèle CLIP sur la consommation mémoire GPU dans ComfyUI, vous pouvez créer des workflows stables tout en maintenant une qualité de génération élevée.

N’oubliez pas que la mémoire graphique ou VRAM n’est pas qu’un chiffre dans ComfyUI : elle conditionne votre confort d’utilisation, la vitesse de génération et la possibilité de traiter des résolutions élevées. En appliquant les bonnes pratiques, comme utiliser des modèles quantifiés, décharger les modèles CLIP sur le CPU ou surveiller votre VRAM, vous pouvez optimiser vos projets sans compromettre la qualité de vos images générées.

Enfin, ajuster la taille des modèles ComfyUI selon votre VRAM vous permet de personnaliser vos workflows selon vos besoins créatifs et techniques, en garantissant des sessions de génération rapides et sans plantage, même sur des configurations disposant de 12 Go de VRAM, tout en exploitant les capacités maximales de votre matériel lorsque vous disposez de 24 Go, 32 Go ou 48 Go de mémoire graphique.

Pour plus de guides et conseils sur ComfyUI, n’hésitez pas à consulter la page dédiée.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !