ComfyUI GGUF : comment et pourquoi utiliser ce format en 2026 ?

L’année 2026 marque un tournant où le format GGUF n’est plus une alternative expérimentale, mais une nécessité absolue pour quiconque souhaite exploiter les modèles de pointe, tels que Flux 2 ou Wan 2.2, sur du matériel grand public. Initialement réservé aux modèles de texte, ce format s’est imposé dans la génération d’images et de vidéos grâce à sa capacité à diviser l’usage de la mémoire vidéo (VRAM) tout en maintenant une qualité visuelle professionnelle.

Pourquoi le format GGUF reste le standard de l’optimisation locale

L’adoption massive du GGUF repose sur des bénéfices techniques qui ont redéfini l’usage de l’IA locale, particulièrement pour les configurations disposant de 6 à 16 Go de VRAM :

- Économie de VRAM massive : La quantification (notamment en Q4 ou Q8) permet de réduire l’usage mémoire jusqu’à 80% par rapport au format FP16 traditionnel.

- Démocratisation des modèles massifs : Grâce au GGUF, il est désormais possible de faire tourner des modèles dépassant les 12 milliards de paramètres sur des cartes graphiques grand public.

- Vitesse et efficacité : Comme le rapporte le wiki communautaire, les modèles GGUF se chargent entre 2 et 5 fois plus vite que leurs équivalents en .safetensors.

GGUF vs NVFP4 : quelle optimisation choisir pour votre GPU ?

En 2026, l’écosystème se fragmente selon l’architecture de votre matériel, offrant deux voies distinctes pour l’optimisation :

- Le format GGUF pour la polyvalence : Il reste la solution de référence pour les séries RTX 30 et 40, bénéficiant d’un catalogue massif de modèles pré-quantifiés.

- L’émergence du NVFP4 pour les RTX 50 : D’après les rapports de NVIDIA, ce format est spécifiquement optimisé pour les architectures Blackwell. S’il est encore en phase « early adopter », il permet déjà de libérer jusqu’à 60% de VRAM et d’augmenter le débit de calcul par 3 ou 4 sur les modèles compatibles.

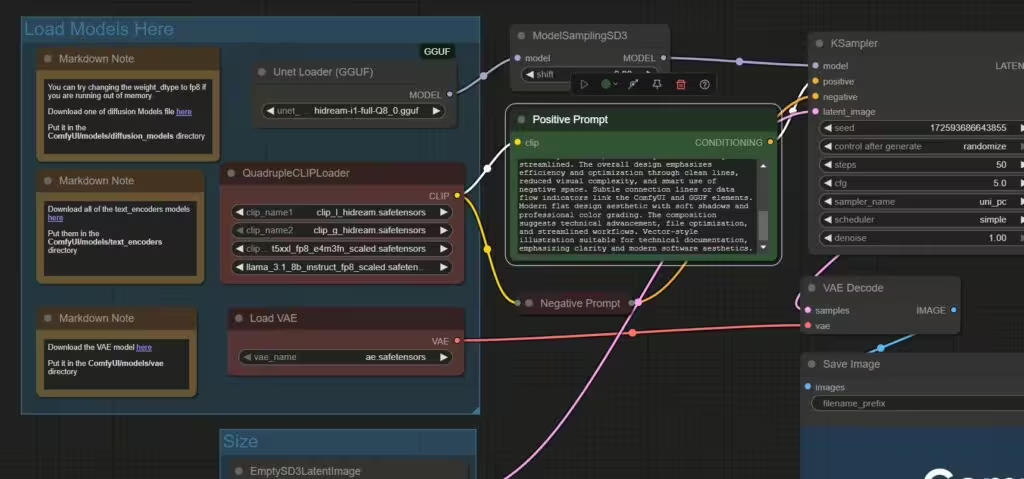

Guide pratique : configurer GGUF avec ComfyUI Desktop

L’installation a été simplifiée par l’évolution des outils officiels et la refonte de l’interface Nodes 2.0 :

- Installation via ComfyUI-Manager V2 : Utilisez la nouvelle interface sécurisée pour installer le nœud ComfyUI-GGUF, ce gestionnaire bloquant désormais par défaut les fonctionnalités système à haut risque.

- Organisation des fichiers : Comme le précise le manuel communautaire, placez vos fichiers .gguf dans models/unet pour les modèles de diffusion ou models/clip pour les encodeurs de texte quantifiés.

- Utilisation des nœuds « Loader » : Remplacez vos chargeurs classiques par les nœuds Unet Loader (GGUF) et DualCLIPLoader (GGUF) pour activer la gestion de la quantification dans votre workflow.

Cas d’usage : optimiser Flux 2 et la vidéo haute fidélité

L’intérêt du GGUF se manifeste pleinement avec les modèles les plus récents et gourmands :

- Flux 2 Dev GGUF : Ce format permet de charger la version Open Weights de Flux 2 sur des GPU de milieu de gamme grâce à une compression optimisée.

- La révolution vidéo avec Wan 2.2 et HunyuanVideo-1.5 : D’après les analyses techniques, l’usage du GGUF combiné au Temporal Rolling VAE permet de générer des clips haute fidélité avec une cohérence temporelle élevée sans erreur de mémoire saturée.

- Le support croissant du NVFP4 : Selon Microsoft et NVIDIA, des modèles comme LTX-2, Qwen-Image et FLUX.1/2 disposent déjà de checkpoints NVFP4 sur Hugging Face, ouvrant la voie à une génération 4K sur PC domestique.

Qualité et précision : l’apport de la quantification dynamique

La crainte d’une perte de qualité liée à la compression est désormais levée, comme le rapporte le suivi technique de la communauté. La méthode de quantification dynamique d’Unsloth minimise les pertes de précision, rendant les résultats en Q8 quasi identiques à la version FP16 de référence. En 2026, le consensus est clair, le Q4 offre une performance extrême pour le prototypage, tandis que le Q8 assure une fidélité visuelle optimale pour la production finale.

L’optimisation, nouveau cœur de la création locale ?

Cette tendance vers des modèles plus légers et plus efficaces interroge sur l’avenir du matériel et plus globalement sur l’usage en local des IA génératives, assisterons-nous bientôt à l’exécution de modèles de pointe sur nos ordinateurs personnels ou stations de travail de manière totalement transparente ?

Pour les débutants, experts, développeurs ou même studios de création, je vous conseille la lecture de l’article « ComfyUI : les meilleures sources d’informations et ressources de l’écosystème« , car l’écosystème évolue vite et les méthodes de création aussi.

Enfin si vous rencontrez fréquemment des freezes avec ComfyUI (plantage complet de l’ordinateur), il est fort probable que cela soit dû à une mémoire saturée ou une instabilité matériel (overclocking, défaut de configuration bios …).

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !