Comprendre l’écosystème LangChain : quelles solutions pour vos projets IA ?

Depuis l’émergence des Large Language Models (LLM), les frameworks destinés à construire des applications basées sur l’intelligence artificielle se sont multipliés à un rythme effréné. Dans cet environnement en perpétuelle évolution, LangChain s’est rapidement imposé comme l’un des piliers de la nouvelle génération d’outils IA. Pourtant, pour de nombreux développeurs et architectes, l’écosystème LangChain reste complexe à appréhender. Entre LangChain, LangGraph, Deep Agents et LangSmith, il n’est pas toujours évident de savoir quelle solution adopter ni dans quel contexte.

LangChain a été pensé pour unifier les briques essentielles du développement IA : la conception, l’orchestration et le déploiement de systèmes basés sur des modèles de langage. L’objectif est clair : permettre aux équipes techniques de passer du prototype à la production en conservant la cohérence de leur pile technologique. Comme le souligne LangChain, chaque composant, framework, orchestration d’agents, outils d’observabilité ou infrastructure, s’intègre dans une approche modulaire conçue pour s’adapter à la plupart des architectures IA modernes.

En octobre 2025, l’écosystème LangChain atteint une maturité notable : les versions stables LangChain 1.0 (publiée le 17 octobre) et LangGraph 1.0 (30 octobre) ont marqué une étape importante dans la stabilisation du projet (GitHub LangChain). La société derrière le framework affiche aussi une solide traction commerciale : plus de 1 300 entreprises vérifiées utilisent aujourd’hui LangChain ou LangGraph en production, parmi lesquelles Uber, LinkedIn et Replit (blog LangChain). Cette adoption confirme que LangChain n’est pas un simple outil de recherche expérimentale, mais bien une solution viable pour des applications IA concrètes et critiques.

Cependant, cette popularité n’efface pas les limites structurelles du framework : latence, complexité de débogage, et gestion parfois opaque des flux d’exécution, comme le signalent plusieurs retours d’expérience partagés sur Reddit ou LinkedIn. Ces critiques soulignent un point essentiel : LangChain ne doit pas être utilisé comme une boîte noire mais comme une boîte à outils. Sa richesse fonctionnelle requiert une compréhension fine de son architecture interne et des mécanismes de chaque sous-projet.

Cet article vise donc à démystifier l’écosystème LangChain. Il présente ses principales solutions, LangChain, LangGraph, Deep Agents, LangSmith, LangServe ou LCEL, tout en évaluant leur viabilité technique et leur pérennité. Vous y trouverez un panorama clair pour identifier quelles briques adopter selon votre projet IA : du simple chatbot RAG jusqu’aux systèmes d’agents autonomes orchestrés.

L’objectif n’est pas seulement de dresser un inventaire, mais d’apporter un regard critique sur ce que LangChain fait bien, ce qui reste perfectible, et comment éviter les refontes coûteuses à mesure que les frameworks évoluent. En d’autres termes, il s’agit de vous donner les clés pour bâtir une architecture IA durable sans subir les effets de mode technologiques et sans dépendre d’un fournisseur de LLM.

Vue d’ensemble de l’écosystème LangChain

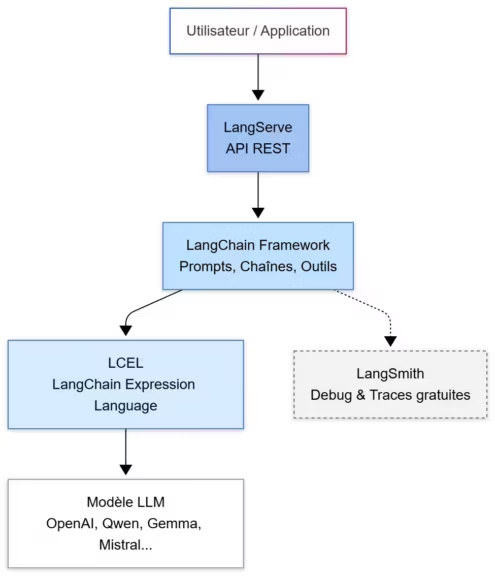

L’écosystème LangChain se distingue par une ambition claire : offrir une infrastructure complète couvrant tout le cycle de vie d’une application IA, du prototypage local jusqu’au déploiement en production. Là où la plupart des frameworks open source se concentrent sur un seul aspect (par exemple la recherche augmentée pour LlamaIndex), LangChain a choisi une approche intégrée et modulaire.

Une architecture modulaire pensée pour l’évolutivité

L’écosystème repose sur une architecture en couches qui sépare la logique de développement, l’orchestration des agents et l’exploitation en production. Cette organisation permet de construire progressivement une stack IA cohérente sans dépendre d’un seul outil.

- LangChain (framework), cœur open source du système, il fournit les briques de base : prompts, chaînes, modèles, mémoires, outils, et le langage déclaratif LCEL (LangChain Expression Language) pour relier ces composants.

- LangGraph, framework d’orchestration d’agents IA, conçu pour les workflows complexes avec état persistant, cycles et gestion d’erreurs.

- Deep Agents, surcouche spécialisée pour créer des agents autonomes capables de planification, d’apprentissage et de persistance.

- LangSmith, plateforme propriétaire d’observabilité, de test et de déploiement, intégrée au reste de la stack.

- LangServe et Templates, outils open source pour transformer les chaînes LangChain en APIs REST prêtes à être déployées, facilitant le passage du code au produit.

Cette approche modulaire, décrite dans la documentation LangChain, permet d’adapter la stack au niveau de maturité du projet. Un prototype peut démarrer avec LangChain seul, puis évoluer vers LangGraph et LangSmith à mesure que les besoins en orchestration et en observabilité se précisent.

Un écosystème à géométrie variable

LangChain repose sur un modèle open core, c’est-à-dire une base ouverte complétée par des outils et services propriétaires :

- Les frameworks de développement et d’orchestration (LangChain, LangGraph, Deep Agents) sont open source sous licence MIT, donc utilisables sans restriction dans des projets commerciaux.

- Les services d’observabilité et de déploiement (LangSmith Platform, LangSmith Studio) sont propriétaires, avec des plans gratuits limités et des options payantes pour la production (LangChain Pricing).

Cette dualité open source / SaaS répond à deux besoins : garder la liberté d’expérimenter en local, tout en offrant une solution clé en main pour les entreprises. LangChain repose sur un modèle open core, où une base ouverte cohabite avec des outils et services payants. Ce modèle, parfois critiqué, permet toutefois d’assurer le financement et donc la pérennité de l’écosystème, car un projet sans ressources finit inévitablement par disparaître.

La documentation LangGraph précise d’ailleurs que depuis la version 1.0, tous les agents LangChain sont désormais construits sur le runtime de LangGraph, signe d’une convergence vers une architecture unifiée.

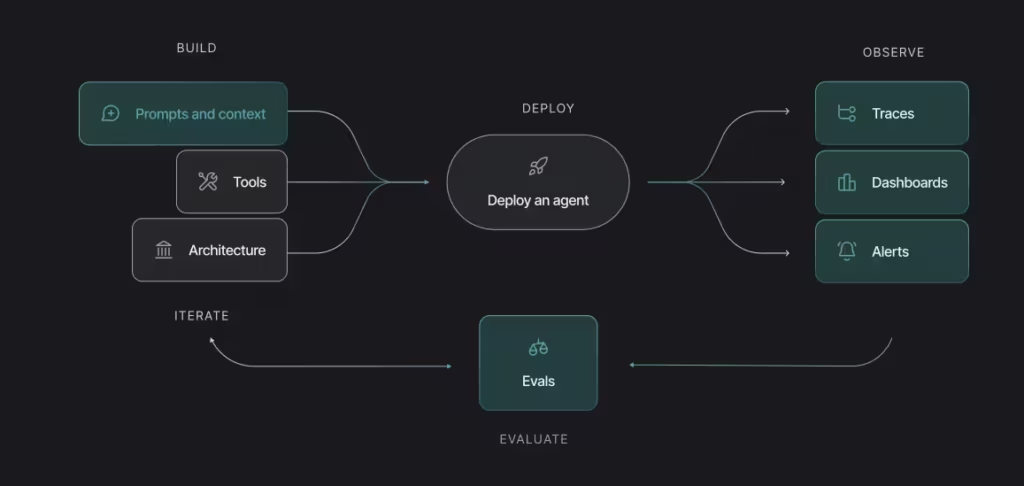

Une vision du cycle complet

L’écosystème LangChain ne se contente pas d’unifier les outils. Il promeut une vision complète du développement agentique, où chaque étape, de la conception au déploiement, peut être reliée par des composants communs et traçables. Cette approche “du code à la production” s’appuie sur l’intégration étroite entre LangChain, LangGraph et LangSmith, et trouve son prolongement dans des offres professionnelles comme LangGraph Platform (aujourd’hui LangSmith Deployment), qui facilitent le passage des projets en production. L’objectif affiché est clair : faire de LangChain la colonne vertébrale des applications IA modulaires et traçables (Sparkco AI).

En résumé, LangChain n’est pas un simple framework, mais un écosystème évolutif. Il s’adapte à la complexité croissante des projets IA, tout en laissant aux équipes le choix entre contrôle total en local et services managés en cloud. Cette flexibilité en fait une base solide, mais également un environnement où le risque de dépendance et la complexité architecturale doivent être anticipés dès la conception.

Les frameworks principaux : LangChain, LangGraph et Deep Agents

L’écosystème LangChain s’articule autour de trois frameworks complémentaires, chacun ayant un rôle spécifique dans la conception, l’orchestration et la mise en œuvre d’applications d’intelligence artificielle. Ensemble, ils forment une base cohérente mais exigeante à maîtriser.

LangChain, le socle open source pour la création d’applications LLM

LangChain constitue le noyau fondateur de tout l’écosystème. Il s’agit d’un framework open source (licence MIT) conçu pour faciliter la création d’applications reposant sur des Large Language Models (LLM). Son objectif est simple : fournir des composants réutilisables et modulaires pour assembler rapidement des workflows IA.

Comme l’indique la documentation officielle, LangChain repose sur quelques concepts clés :

- Prompts et modèles : abstractions unifiées pour communiquer avec les modèles OpenAI, Anthropic, Google ou tout modèle local.

- Chaînes et mémoire : gestion séquentielle de flux conversationnels ou de processus RAG (Retrieval-Augmented Generation).

- Outils et agents : modules capables d’exécuter des actions en fonction des instructions du LLM.

- LCEL (LangChain Expression Language) : syntaxe déclarative simplifiant la composition de chaînes avec l’opérateur « | », permettant le chaînage direct de composants.

LangChain a séduit de nombreux développeurs pour son côté “tout-en-un”, mais cette richesse a aussi un revers. Plusieurs ingénieurs soulignent sur Reddit et Zaytrics la complexité grandissante des abstractions, la latence induite par les couches intermédiaires et la difficulté de débogage des chaînes imbriquées.

Malgré cela, LangChain reste idéal pour :

- Les prototypes rapides ou POC IA.

- Les applications à faible volume ou internes.

- Les projets d’apprentissage, grâce à sa compatibilité étendue avec les modèles et bases vectorielles.

En revanche, pour les environnements à charge élevée ou les architectures critiques, il devient préférable d’évoluer vers LangGraph, plus flexible et robuste.

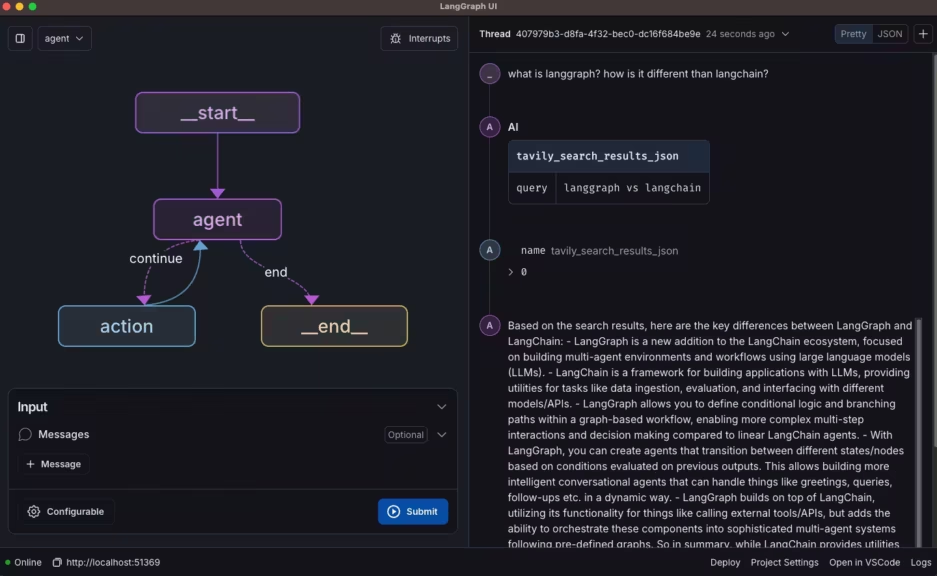

LangGraph, l’orchestration avancée d’agents IA

LangGraph marque une étape importante dans l’évolution de LangChain. Là où LangChain s’appuie sur des chaînes d’actions linéaires, LangGraph adopte une structure en graphe, où chaque nœud correspond à une fonction, un modèle ou un outil, et où les connexions définissent les relations, les conditions ou les boucles d’exécution.

Ce framework open source (licence MIT) permet d’orchestrer plusieurs agents d’IA interconnectés, capables de raisonner ensemble, de coopérer et de conserver un état dans le temps. Comme expliqué dans la présentation de LangGraph, il s’agit d’un framework stateful, c’est-à-dire qu’il garde en mémoire le contexte d’exécution, enregistre des points de contrôle (checkpoints) et offre la possibilité de reprise d’un processus au point d’erreur ou encore de revenir en arrière pour analyser ou corriger une séquence (time-travel debugging).

Fonctions clés :

- Architecture en graphe : modélisation de workflows non linéaires avec boucles et branchements conditionnels.

- Gestion d’état persistante : sauvegarde automatique de l’état des agents pour reprise ou audit.

- Human-in-the-loop : intégration de validations humaines dans le flux.

- Streaming temps réel : visualisation des étapes et résultats intermédiaires.

- Sub-agents : délégation de tâches à des agents spécialisés.

LangGraph a prouvé sa maturité en production. Selon LangChain, des entreprises comme Uber, LinkedIn et Replit l’utilisent déjà pour automatiser des processus complexes, notamment la génération de tests unitaires, l’assistance au recrutement ou la collaboration entre agents de développement.

La différence essentielle avec LangChain réside dans le contrôle explicite. Là où LangChain masque la complexité derrière ses abstractions, LangGraph expose la structure complète du flux, ce qui en fait un choix privilégié pour les architectures IA d’entreprise.

En pratique, LangGraph est à LangChain ce que Kubernetes est à Docker : un orchestrateur conçu pour passer du prototype à la production à grande échelle. Avec son interface visuelle LangGraph Studio, il devient aussi un moyen plus accessible de concevoir et de déboguer des workflows IA complexes, même pour ceux qui ne souhaitent pas tout développer en code pur.

Deep Agents, la couche d’autonomie

Construite sur LangGraph, la bibliothèque Deep Agents pousse plus loin le concept d’autonomie. Présentée sur GitHub et Datacamp, elle fournit une architecture prête à l’emploi pour créer des agents intelligents capables de planifier et d’apprendre sur plusieurs itérations.

Points essentiels :

- Planification hiérarchique : les tâches sont décomposées en sous-étapes, avec suivi d’état (pending, in-progress, completed).

- Mémoire longue durée : stockage persistant des contextes et résultats via un système de fichiers virtuel.

- Sub-agents spécialisés : agents secondaires exécutant des rôles dédiés (recherche, génération, vérification).

- Intégration native avec LangGraph State et Store : conservation du contexte entre sessions.

Deep Agents est particulièrement adapté pour :

- La recherche approfondie automatisée (Open Deep Research Agent).

- La génération de code ou d’analyses itératives.

- Les workflows IA à long cycle de vie, nécessitant mémoire et coordination entre plusieurs agents.

Cette bibliothèque open source reste jeune, mais elle marque une évolution logique : de la simple exécution d’outils (LangChain) vers des systèmes capables de raisonnement multi-étapes et d’autonomie croissante.

Le projet DeepAgents est actuellement en version 0.2, publiée fin octobre 2025, et reste en phase de développement actif sans version stable officiellement annoncée. Selon le GitHub officiel et le blog LangChain, il n’existe encore aucune release stable (1.0) et le dépôt indique “no releases published”. Le projet est sous licence MIT et suscite un intérêt croissant avec plus de 4 700 étoiles GitHub.

- Juillet 2025 : première version expérimentale

- Septembre 2025 : réécriture complète sur LangChain 1.0 avec une nouvelle architecture middleware

- Octobre 2025 (v0.2) : ajout de backends modulaires et meilleure intégration avec LangGraph (LinkedIn LangChain)

Contexte de stabilité

Bien que DeepAgents soit encore en version bêta, il repose sur des fondations solides : LangChain 1.0 et LangGraph 1.0, toutes deux considérées comme stables et prêtes pour la production (LangChain Changelog, blog LangChain). L’outil s’appuie sur le runtime de LangGraph et exploite la nouvelle architecture middleware introduite avec LangChain 1.0, garantissant une base technique fiable.

État actuel

En résumé, DeepAgents est un projet expérimental mais prometteur, idéal pour le prototypage et la recherche sur les agents IA multi-composants. Sa structure s’appuie sur des briques matures, mais il n’est pas encore recommandé pour une utilisation en production.

Les outils complémentaires de l’écosystème LangChain

Au-delà des frameworks de développement et d’orchestration, l’écosystème LangChain comprend un ensemble d’outils conçus pour observer, tester et déployer les applications IA dans des environnements de production. Ces briques ne sont pas toujours indispensables, mais elles deviennent cruciales pour tout projet visant la fiabilité, la traçabilité et la scalabilité.

LangSmith, observabilité et évaluation des applications IA

LangSmith est la plateforme propriétaire de l’écosystème LangChain, dédiée à la traçabilité, au débogage et à l’évaluation des applications LLM. Elle agit comme un véritable cockpit d’observabilité, permettant aux développeurs de suivre chaque étape d’exécution d’un workflow, depuis les prompts jusqu’aux réponses finales.

Comme l’indique la documentation officielle, LangSmith offre plusieurs fonctionnalités majeures :

- Observabilité complète : suivi des entrées, sorties, latences et coûts en tokens.

- Debugging visuel : affichage des prompts et résultats côte à côte pour comparaison et optimisation.

- Évaluation automatique : métriques de qualité, tests A/B et feedback humain intégrés.

- Monitoring en production : détection d’anomalies et alertes en cas de dégradation de performance.

LangSmith fonctionne avec ou sans LangChain, ce qui en fait un outil framework-agnostic, utile aussi pour d’autres pipelines IA. Le plan Developer gratuit offre 5 000 traces par mois avec une rétention de 14 jours, suffisant pour le développement et les prototypes (LangChain Pricing).

Néanmoins, plusieurs ingénieurs ont exprimé des inquiétudes concernant le risque de dépendance. En effet, la centralisation des traces dans le cloud LangSmith peut poser des problèmes de confidentialité et de verrouillage fournisseur, comme l’ont souligné des discussions sur Reddit.

Pour les équipes soucieuses de confidentialité ou d’indépendance, il est possible d’opter pour une version self-hosted de LangSmith (réservée au plan entreprise) ou d’explorer des alternatives open source comme LangFuse, véritable équivalent libre, voire Aegra, plus orienté vers le déploiement et l’orchestration d’agents IA.

LangSmith Deployment et Studio : du code au produit

Pour passer de la conception à la mise en production, LangChain propose deux outils complémentaires : LangSmith Deployment (anciennement LangGraph Platform) et LangSmith Studio.

LangSmith Deployment

Il s’agit d’une infrastructure commerciale conçue pour déployer des agents LangGraph à grande échelle. Elle permet de gérer les flux, la mémoire d’exécution et la communication entre agents sans avoir à maintenir une pile complète en interne. Comme le confirme la documentation, ses principaux atouts sont :

- Déploiement one-click via GitHub.

- APIs de gestion d’état, historique et mémoire conversationnelle.

- Files de tâches scalables et planification par cron.

- Support du streaming temps réel et du human-in-the-loop.

Le plan gratuit Self-hosted Lite offre 100 000 exécutions de nœuds par mois, ce qui suffit pour de nombreux cas d’usage non critiques. Pour des environnements plus exigeants, le plan Plus (39 $/mois) ou Enterprise apporte authentification, monitoring et SLA renforcé. L’intégration technique reste l’investissement le plus important, souvent justifiant le recours à des experts comme l’indique Metacto.

LangSmith Studio

C’est un IDE visuel destiné à la conception et au débogage des graphes d’agents. Il permet de visualiser les connexions entre composants, d’exécuter des tests interactifs et de réévaluer l’état d’un agent à un moment donné (time-travel debugging). LangSmith Studio est particulièrement utile pour les développeurs qui souhaitent comprendre la logique interne de leurs agents sans passer par des logs textuels complexes.

Outils open source complémentaires : LangServe, LCEL et Templates

L’écosystème LangChain comprend également plusieurs outils entièrement gratuits et open source, pensés pour accélérer le développement et faciliter le déploiement des applications IA.

- LangServe : permet de transformer n’importe quelle chaîne LangChain en API REST avec documentation Swagger automatique et endpoints standards (/invoke, /batch, /stream, /stream_log). Basé sur FastAPI et Pydantic, il facilite la mise en ligne rapide d’un service IA (DataCamp).

- LCEL (LangChain Expression Language) : langage déclaratif offrant une alternative plus claire et performante aux chaînes classiques. Il prend en charge le parallélisme, le streaming optimisé et le traçage automatique via LangSmith.

- LangChain Hub et Templates : bibliothèque communautaire de prompts et modèles applicatifs (ReAct, Memory Agent, RAG, etc.), utile pour accélérer le prototypage et standardiser les architectures.

Ces outils forment la boîte à outils libre de LangChain. Ensemble, ils réduisent considérablement la barrière d’entrée tout en maintenant un haut niveau de flexibilité pour les développeurs expérimentés.

Quelle solution choisir selon votre projet IA ?

Choisir la bonne combinaison d’outils dans l’écosystème LangChain dépend avant tout du type de projet, de son niveau de criticité et de la maturité technique de votre équipe. L’erreur la plus fréquente consiste à vouloir tout intégrer dès le départ, alors que LangChain a été conçu pour une adoption progressive.

Petits projets, prototypes et POC

Pour les projets exploratoires, internes ou à faible volume, le framework LangChain seul est souvent suffisant. Il offre une excellente rapidité de mise en œuvre et une grande compatibilité avec les modèles open source (Qwen, GPT-OSS, Gemma, Mistral, Llama 3, etc.).

Configuration recommandée :

- LangChain + LCEL + LangServe

- Utilisation du plan gratuit de LangSmith pour le débogage

- Hébergement local ou via conteneur Docker

Ce type d’architecture est idéal pour :

- Tester des idées d’agents conversationnels.

- Construire un chatbot RAG minimaliste.

- Évaluer les performances de modèles LLM sur des cas métiers simples.

Le principal avantage réside dans la simplicité du déploiement. Un développeur peut passer du code à une API REST fonctionnelle en quelques minutes avec LangServe (Datacamp). Les outils plus avancés comme LangGraph et son interface visuelle LangGraph Studio deviennent pertinents uniquement lorsque le projet évolue vers une architecture multi-agents ou des workflows persistants.

Applications complexes et systèmes multi-agents

Pour les projets plus ambitieux, où la logique devient conditionnelle, récurrente ou distribuée, LangGraph est incontournable. Il apporte la gestion d’état, la persistance et une architecture réellement adaptée aux systèmes multi-agents.

Configuration recommandée :

- LangGraph + Deep Agents + LangSmith

- Stockage vectoriel (Qdrant, Chroma, FAISS) pour la mémoire contextuelle

- Via Docker Compose ou Kubernetes

Ce setup est particulièrement adapté à :

- Des assistants de recherche à long cycle de vie.

- Des copilot d’entreprise intégrant plusieurs sources de données.

- Des pipelines de génération et de vérification de code.

- Plus globalement des pipelines évolués

Des acteurs comme Uber, LinkedIn ou Replit exploitent déjà cette approche pour automatiser des tâches critiques (LangChain Blog). Ces retours d’expérience confirment que LangGraph apporte la robustesse et le contrôle nécessaires à la production, sans sacrifier la flexibilité open source.

Projets critiques et environnements réglementés

Lorsque la fiabilité, la confidentialité ou la conformité sont des exigences majeures, la prudence s’impose. Les services cloud comme LangSmith ou Deployment sont pratiques, mais leur usage peut poser problème dans des contextes réglementés (finance, santé, défense).

Configuration recommandée :

- LangGraph + LangServe + observabilité open source (Aegra, Langfuse)

- Déploiement on-premise ou cloud privé

- Surveillance des performances et logs internes

Cette approche minimise les dépendances propriétaires et réduit le risque de vendor lock-in. L’article de Dashdevs rappelle d’ailleurs que le cloisonnement des dépendances et la modularité du code sont les meilleures garanties pour éviter les refontes futures.

Synthèse : quelle combinaison adopter ?

| Type de projet | Outils recommandés | Objectif principal | Observabilité |

|---|---|---|---|

| Prototype rapide / POC | LangChain + LCEL + LangServe | Tester et itérer | LangSmith gratuit |

| Système multi-agents | LangGraph + Deep Agents | Coordination et persistance | LangSmith self-hosted |

| Application critique | LangGraph + LangServe + monitoring open source | Fiabilité et conformité | Aegra / Langfuse |

| Projet à long terme | LangGraph + LangSmith Deployment | Production et scalabilité | LangSmith Enterprise |

La stratégie gagnante consiste à démarrer petit, valider la logique métier avec LangChain, puis migrer progressivement vers LangGraph à mesure que la complexité augmente. Cette approche incrémentale réduit la dette technique tout en préparant l’avenir.

Viabilité et pérennité de LangChain en 2025

S’engager sur un framework d’intelligence artificielle ne se limite plus à un choix technique, c’est un pari sur sa stabilité et pérennité à long terme. Avec l’investissement en ressources (temps investi, intervention d’experts …), les entreprises cherchent des solutions capables de durer, d’évoluer sans refonte complète et de rester compatibles avec l’écosystème IA et open source. Dans ce contexte, la question est simple : LangChain est-il un choix sûr et pérenne en 2025 ?

Une adoption massive qui inspire confiance

Les chiffres parlent d’eux-mêmes. LangChain bénéficie d’une forte adoption dans l’écosystème IA :

- Plus de 1 300 entreprises vérifiées l’utilisent en production selon Landbase.

- Une valorisation de 1,25 milliard de dollars après une levée de fonds de 125 M$ en octobre 2025 (Fortune).

- Plus de 28 millions de téléchargements mensuels sur GitHub.

- 250 000 utilisateurs actifs sur LangSmith avec plus d’un milliard de traces enregistrées (Contrary Research).

Cette traction confirme que LangChain n’est pas un projet éphémère. Des acteurs majeurs comme Uber, LinkedIn, Elastic, Cloudflare et Replit ont validé son usage en production (LangChain Blog). Ces implémentations concrètes renforcent sa légitimité dans l’écosystème IA.

Un écosystème en phase de stabilisation

Après une période marquée par des mises à jour fréquentes et parfois déstabilisantes, LangChain entre dans une phase de maturité technique.

- Les versions LangChain 1.0 et LangGraph 1.0, sorties en octobre 2025, apportent une compatibilité renforcée et une API stabilisée (GitHub LangChain).

- L’adoption de Pydantic 2 marque la fin des changements structurels majeurs introduits dans la v0.3.

- Les intégrations externes (LLM, bases vectorielles, connecteurs) ont été isolées dans des packages indépendants pour réduire les dépendances et améliorer la maintenance.

Ces évolutions témoignent d’une volonté claire de la part des développeurs de consolider le projet. La documentation officielle de LangGraph précise que l’objectif est désormais de garantir une compatibilité ascendante à long terme, un point souvent réclamé par les entreprises utilisatrices.

Des critiques fondées mais surmontables

Malgré son succès, LangChain n’est pas exempt de critiques. Plusieurs rapports techniques mettent en avant des difficultés réelles en production :

- Overhead de latence dû à l’empilement d’abstractions.

- Silent failures lors d’appels d’outils ou d’agents.

- Debugging complexe à cause du chaînage et des callbacks imbriqués.

- Support async limité pour les charges intensives (Milvus Quick Reference).

De nombreux retours d’expérience indiquent que LangChain séduit beaucoup d’équipes IA, mais que son passage en production reste plus complexe qu’il n’y paraît, comme de nombreux projets IA. Le framework demande une architecture solide, une bonne gestion des états et une intégration rigoureuse avec les systèmes existants. Il est toutefois difficile, voire impossible, d’évaluer précisément le taux de réussite des projets menés avec LangChain, car ces données ne sont ni centralisées ni publiées par les entreprises. Les estimations disponibles reposent surtout sur des témoignages et retours communautaires, qui donnent une vision partielle ou erronée de la réalité du terrain.

Aujourd’hui, les difficultés sont désormais mieux comprises et documentées. Par exemple, les bonnes pratiques recommandées dans le guide Sparkco AI permettent de les limiter :

- Utiliser LangGraph plutôt que les chaînes séquentielles classiques.

- Isoler les dépendances pour éviter les conflits de versions.

- Superviser les workflows via LangSmith ou une solution open source.

- Conteneuriser les agents IA pour garantir la cohérence des déploiements.

Une stratégie d’architecture pour durer

Pour garantir la pérennité d’un projet basé sur LangChain, il faut penser à la résilience structurelle dès la conception.

- Encapsuler les appels LangChain dans une couche d’abstraction pour faciliter une éventuelle migration.

- Préférer les composants open source (LangGraph, Deep Agents, LangServe) plutôt que les services SaaS si la dépendance est un risque.

- Séparer la logique métier du code lié au framework pour préserver la portabilité.

- Surveiller activement la roadmap officielle et les changements de version documentés sur GitHub.

Ces approches permettent de se prémunir contre les refontes lourdes et de conserver une architecture adaptable à long terme, un point souligné dans l’article de CTO Magazine.

Un écosystème durable, mais à utiliser avec discernement

LangChain a atteint une position rare : celle d’un standard de facto dans le développement d’applications LLM. Sa richesse, son écosystème open source et son intégration avec la plupart des acteurs de l’IA en font un choix stratégique solide. Toutefois, son ampleur et sa complexité impliquent une responsabilité d’architecture : plus qu’un simple framework, LangChain est une fondation sur laquelle il faut construire avec méthode.

En résumé, LangChain et LangGraph sont des choix viables et pérennes, à condition d’être employés de manière raisonnée, avec un souci constant de modularité et de transparence.

Conclusion : construire une architecture durable avec LangChain

LangChain n’est plus un simple framework, mais une plateforme complète d’ingénierie IA, couvrant tout le cycle de développement autour des LLM, du prototypage à la mise en production, en passant par l’observabilité et la supervision. Cette richesse technologique impose toutefois une approche lucide : LangChain n’est pas un raccourci, mais un ensemble d’outils puissants qui exigent rigueur, discernement et un réel investissement en temps.

En 2025, le couple LangGraph + DeepAgents représente une avancée majeure dans la conception d’agents autonomes capables de persistance et de coordination. Toutefois, DeepAgents reste en version 0.2 et donc à un stade expérimental, encore réservé au prototypage et à la recherche. Combiné à LangSmith pour la supervision et à LangServe pour le déploiement, cet ensemble esquisse une architecture cohérente, pensée pour relier la flexibilité de l’open source à la fiabilité d’une observabilité centralisée, mais dont certaines briques demandent encore maturité et validation en production.

Cependant, la clé de la pérennité ne réside pas dans la technologie seule, mais dans la manière de l’intégrer. Une architecture bien pensée doit :

- préserver l’indépendance vis-à-vis des services propriétaires,

- séparer clairement logique métier et couches LangChain,

- prévoir une abstraction pour faciliter une migration potentielle vers d’autres frameworks.

En adoptant cette stratégie, LangChain peut devenir une base solide, évolutive et durable. Il permet de bénéficier de l’innovation rapide du monde open source tout en gardant la maîtrise de son infrastructure IA.

Pour les équipes expérimentées, LangChain représente aujourd’hui l’un des écosystèmes les plus complets et matures du marché, à condition de l’utiliser comme un socle flexible plutôt qu’une dépendance rigide. Le message est clair : construisez avec LangChain, mais pensez au-delà de LangChain.

| Critère | LangGraph | CrewAI | Microsoft Agent Framework |

|---|---|---|---|

| Origine / Éditeur | Développé par LangChain | Projet open source indépendant | Microsoft (fusion d’AutoGen et Semantic Kernel) |

| Architecture | Basée sur un graphe d’exécution (chaque nœud = étape, outil ou sous-agent) | Organisation en équipes d’agents spécialisés (“crew”) | Infrastructure modulaire et centralisée, pensée pour la production |

| Philosophie | Orchestration robuste et mémoire persistante | Collaboration multi-agents, approche distribuée | Gouvernance, conformité et observabilité d’entreprise |

| Persistance d’état / Mémoire | Oui, via Redis, PostgreSQL ou Chroma (mémoire externe durable) | Non native, dépend des intégrations externes | Oui, intégrée à Azure (stockage et reprise de contexte) |

| Multi-LLM | Support indirect via LangChain | Oui, un LLM différent par agent possible | Oui, compatible avec plusieurs LLM via connecteurs Azure |

| Interopérabilité | Compatible LangChain, LangSmith, Qdrant, Chroma | Intégration avec +100 outils (Gmail, Notion, Slack, etc.) + MCP | Connecté à l’écosystème Microsoft (Azure, Entra ID, Power Platform) |

| Observabilité / Supervision | Oui, via LangSmith (self-hosted ou cloud) | Basique, orientée logs ou monitoring externe | Intégrée (Azure Monitor, Log Analytics) |

| Cas d’usage typique | Orchestration d’agents complexes, mémoire longue, projets multi-LLM | Collaboration IA entre rôles spécialisés, automatisation de tâches variées | Déploiements en entreprise nécessitant conformité et traçabilité |

| Niveau de maturité | Très stable, éprouvé en production | En développement actif, flexible mais moins standardisé | Récent mais soutenu par Microsoft, adoption rapide |

| Cible principale | Développeurs et architectes IA | Équipes d’automatisation et makers | Entreprises soumises à des normes de sécurité et conformité |

| Licence / Open Source | Open source (LangChain ecosystem) | Open source | Open source (MIT, Microsoft GitHub) |

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !