ChatGPT : dates clés, versions et évolutions de 2022 à 2025

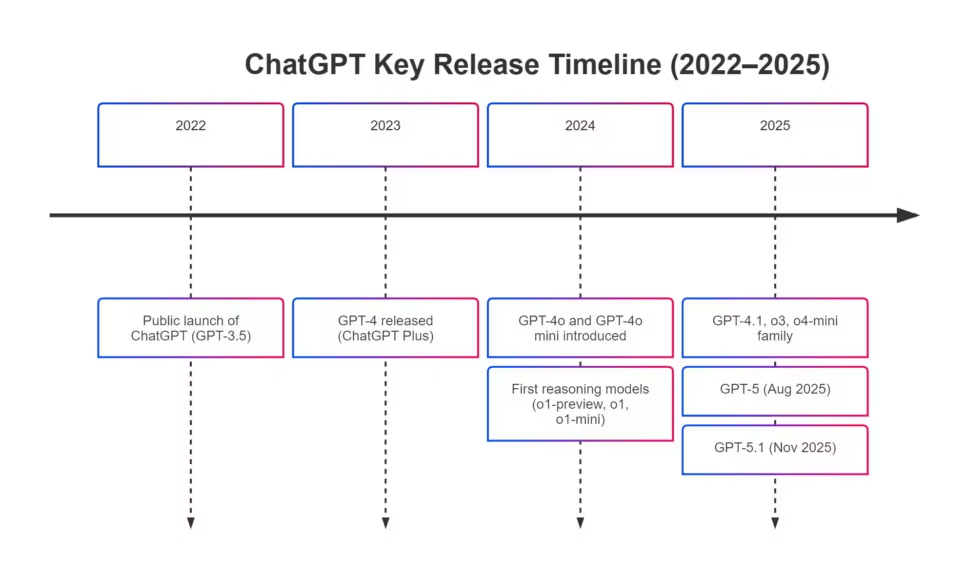

ChatGPT a été lancé le 30 novembre 2022 et s’est imposé en quelques jours comme l’outil d’intelligence artificielle le plus populaire jamais mis à disposition du grand public. Depuis cette date, l’assistant a connu une succession rapide de versions, de GPT-3.5 jusqu’à GPT-5.1 en novembre 2025, avec une montée en puissance des capacités, mais aussi des défis liés à la demande massive et aux contraintes matérielles. Cette analyse retrace l’historique complet de ChatGPT, ses dates clés, les modèles qui l’ont façonné et les tendances qui marquent son évolution jusqu’à aujourd’hui.

Date de sortie de ChatGPT, quand tout a commencé

| Version du modèle | Date de sortie | Statut en 2025 | Rôle dans ChatGPT |

|---|---|---|---|

| GPT-3.5 | Novembre 2022 | Discontinué | Premier modèle utilisé dans ChatGPT lors de son lancement. |

| GPT-4 | Mars 2023 | Discontinué | Introduit avec l’abonnement Plus, amélioration majeure du raisonnement. |

| GPT-4o | Mai 2024 | Support hérité | Multimodalité complète (texte, image, audio, vidéo), modèle plus rapide. |

| GPT-4o mini | Juillet 2024 | Discontinué | Version légère de GPT-4o, remplace GPT-3.5 comme modèle gratuit. |

| o1-preview | Septembre 2024 | Discontinué | Première version préliminaire d’un modèle orienté raisonnement. |

| o1-mini | Septembre 2024 | Discontinué | Variante plus rapide du modèle o1-preview. |

| o1 | Décembre 2024 | Discontinué | Modèle o1 complet, raisonnement amélioré. |

| o1-pro | Décembre 2024 | Discontinué | Version plus compute pour de meilleurs résultats. |

| o3-mini | Janvier 2025 | Discontinué | Successeur d’o1-mini. |

| o3-mini-high | Janvier 2025 | Discontinué | Variante avec plus de capacité de raisonnement. |

| GPT-4.5 | Février 2025 | Discontinué | Dernier grand modèle non chain-of-thought. |

| GPT-4.1 | Avril 2025 | Support hérité | Version améliorée de GPT-4, ajoutée à ChatGPT en mai 2025. |

| GPT-4.1 mini | Avril 2025 | Discontinué | Remplace GPT-4o mini comme modèle léger. |

| o3 | Avril 2025 | Support hérité | Première version stable très performante de la gamme o. |

| o4-mini | Avril 2025 | Support hérité | Version compacte optimisée pour la latence. |

| o4-mini-high | Avril 2025 | Discontinué | Variante avec plus de raisonnement. |

| o3-pro | Juin 2025 | Discontinué | Version hautes performances de o3 pour ChatGPT Pro. |

| GPT-5 | 7 août 2025 | Support hérité | Modèle phare unifié remplaçant toutes les versions précédentes. |

| GPT-5.1 | 12 novembre 2025 | Actif | Amélioration d’instructions, ton plus naturel, personnalités alternatives. |

ChatGPT a été lancé officiellement le 30 novembre 2022, sous la forme d’une research preview gratuite. Cette première version, basée sur GPT-3.5, proposait une interaction conversationnelle fluide, renforcée par l’apprentissage supervisé et le RLHF. L’objectif était d’évaluer le comportement d’un modèle de langage génératif dans un environnement réel, avec des millions d’utilisateurs. Ce pari a transformé ChatGPT en phénomène mondial en quelques jours seulement.

Les modèles GPT avant ChatGPT, un travail de fond dès 2018

Bien avant le lancement de ChatGPT en 2022, OpenAI avait déjà construit plusieurs générations de modèles GPT qui ont servi de fondation à l’assistant que l’on connaît aujourd’hui. Le premier modèle, GPT-1, est apparu en 2018 avec 117 millions de paramètres. Il introduisait le principe de transformer préentraîné, mais restait surtout un prototype destiné à la recherche. GPT-2, publié progressivement en 2019, marquait une étape importante grâce à un modèle bien plus grand et surtout entièrement téléchargeable à partir de novembre 2019, ce qui a permis à la communauté de l’étudier en profondeur.

GPT-3, sorti en juin 2020, a été le premier modèle suffisamment puissant pour inspirer l’idée d’un assistant conversationnel, même s’il n’existait alors que sous forme d’API. C’est sur une version optimisée de cette génération, GPT-3.5, qu’OpenAI construira ensuite ChatGPT en novembre 2022. Ces modèles ne sont donc pas ChatGPT, mais représentent le travail préparatoire essentiel ayant rendu son lancement possible.

Le lancement officiel, 30 novembre 2022

La première version reposait sur GPT-3.5, un modèle optimisé pour le dialogue offrant une compréhension contextuelle solide malgré des limites évidentes. L’interface simple et l’accès gratuit ont permis une adoption immédiate et massive, en faisant entrer l’IA générative dans les usages quotidiens.

Pourquoi ce lancement a marqué une rupture

Jusqu’en 2022, les modèles GPT étaient réservés aux chercheurs et développeurs. ChatGPT a supprimé cette barrière en proposant une IA accessible, capable de rédiger, expliquer et dialoguer sur une grande variété de sujets. Cette démocratisation a marqué un tournant dans la perception de l’IA par le public.

2022, les débuts et l’explosion publique

En décembre 2022, ChatGPT franchit un million d’utilisateurs en cinq jours, un record pour un service numérique. Le modèle GPT-3.5, malgré ses limitations, offrait une qualité conversationnelle suffisante pour impressionner le public. Les premiers usages concernaient la rédaction, l’explication de concepts, la génération de code et l’aide à la compréhension.

De 0 à 1 million d’utilisateurs en 5 jours

Cette croissance spectaculaire a révélé l’intérêt massif pour une IA accessible au grand public. L’outil est rapidement devenu viral, relayé par les réseaux sociaux et la presse.

Les limites et forces de la première version

GPT-3.5 ne disposait pas d’accès au web et ses connaissances s’arrêtaient en 2021. Mais sa capacité à rédiger et à expliquer a suffi à installer ChatGPT comme outil indispensable pour des millions d’utilisateurs.

2023, l’arrivée de GPT-4 et les premières fonctions avancées

L’année 2023 marque un tournant avec le lancement de GPT-4 en mars. Cette version, plus fiable et plus précise, introduit une compréhension améliorée, un raisonnement plus structuré et une gestion contextuelle plus profonde. GPT-4 devient la base de ChatGPT Plus et accélère l’adoption professionnelle.

GPT-4, mars 2023, un tournant majeur

GPT-4 améliore considérablement la qualité des réponses. Il devient capable de traiter des instructions plus complexes, de rédiger des documents longs et d’analyser des données avec une cohérence supérieure.

Nouvelles fonctionnalités, plugins, navigation web, vision

En 2023, ChatGPT évolue d’un chatbot textuel à un assistant polyvalent. Les plugins permettent d’interagir avec des services externes, la navigation web enrichit l’accès à l’information et la vision ouvre la porte à l’analyse d’images.

Impact pour les professionnels

Les entreprises adoptent ChatGPT pour la rédaction, la veille technologique, le support client et l’analyse documentaire. GPT-4 renforce la position de l’IA comme outil de productivité.

2024, multimodalité avancée avec GPT-4o et versions intermédiaires

En 2024, OpenAI introduit GPT-4o, un modèle capable de traiter texte, image, audio et vidéo de manière unifiée. Il remplace progressivement GPT-4 pour de nombreux usages et devient accessible gratuitement dans certaines limites. GPT-4o mini remplace GPT-3.5 et devient la version gratuite par défaut.

GPT-4o marque aussi une rupture technique importante. Contrairement aux générations précédentes, qui combinaient un modèle texte et des modules séparés pour l’image ou l’audio, GPT-4o repose sur une architecture multimodale unifiée. Les entrées textuelles, visuelles, audio et vidéo sont traitées par un même modèle, ce qui réduit la latence, améliore la cohérence entre les modes et permet des interactions en temps quasi réel. Cette fusion interne explique pourquoi GPT-4o est souvent perçu comme plus naturel et plus rapide que GPT-4, malgré une empreinte de calcul plus maîtrisée.

GPT-4o, mai 2024

GPT-4o apporte une multimodalité complète, des performances supérieures et une vitesse accrue. Il démocratise les fonctionnalités auparavant réservées aux versions payantes.

Versions intermédiaires, GPT-4o mini, o1-preview et o1

Entre juillet et décembre 2024, OpenAI expérimente plusieurs modèles intermédiaires.

- GPT-4o mini, version plus légère, remplace GPT-3.5.

- o1-preview et o1-mini introduisent le raisonnement structuré.

- En décembre, le modèle o1 et o1-pro deviennent disponibles, offrant de meilleures performances grâce à des capacités de calcul accrues.

Contrairement aux modèles précédents, la famille o1 ne vise pas à étendre les capacités multimodales, mais à approfondir le raisonnement. Ces modèles introduisent un pipeline de décision reposant sur des étapes explicites, optimisées via l’apprentissage par renforcement. Ils séparent clairement la génération rapide de texte de la résolution logique complexe, ce qui permet au modèle d’adapter sa profondeur de raisonnement selon le problème posé. Cette architecture a servi de base aux versions ultérieures, notamment pour GPT-5 et GPT-5.1.

| Modèle | Année | Multimodalité | Raisonnement | Vitesse / Latence | Coût / Efficacité | Disponibilité | Notes clés |

|---|---|---|---|---|---|---|---|

| GPT-4 | 2023 | Partielle (image via API) | Très solide mais lent | Lente, forte charge GPU | Coût élevé | Plus disponible dans ChatGPT, encore présent dans API historique | Premier grand saut de qualité, forte capacité de raisonnement, lourd et coûteux à exécuter. |

| GPT-4.1 | 2025 | Améliorée mais pas unifiée | Raisonnement plus stable que GPT-4 | Plus rapide, mieux optimisé | Beaucoup plus efficace que GPT-4 | Disponible API puis ChatGPT | Version plus compacte et efficace, pensée pour réduire le coût d’inférence dans un contexte de pénurie GPU. |

| GPT-4o | 2024 | Complète (texte, image, audio, vidéo) via un modèle unifié | Très bon, raisonnement moins profond que o1/o3 | Très faible latence, quasi temps réel | Très rentable, optimisée pour usage massif | Disponible pour tous les utilisateurs (quotas selon l’abonnement) | Premier modèle multimodal totalement fusionné, interactions naturelles, excellente expérience utilisateur. |

2025, l’année des modèles o3, GPT-4.5, GPT-4.1 et GPT-5

En 2025, ChatGPT évolue rapidement. Les modèles o3 et o3-mini succèdent aux modèles o1 et améliorent encore le raisonnement. GPT-4.5 apparaît en février 2025 comme l’un des derniers modèles traditionnels avant la transition vers les modèles dotés de chaînes de raisonnement.

GPT-4.1 et GPT-4.1 mini, avril 2025

GPT-4.1 améliore la cohérence, la vitesse et la fiabilité. Il est ajouté à ChatGPT en mai 2025. GPT-4.1 mini remplace GPT-4o mini comme version gratuite allégée.

GPT-5, août 2025

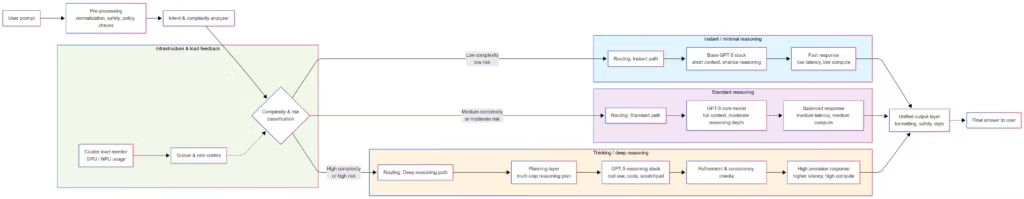

GPT-5 représente une nouvelle étape. Il remplace toutes les versions précédentes et devient le modèle principal pour les utilisateurs gratuits et payants. GPT-5 Auto sélectionne automatiquement le niveau de raisonnement nécessaire. Des variantes comme GPT-5 Instant, Thinking et Pro modulent le temps de réflexion selon les besoins.

GPT-5 apporte une autre innovation majeure : le routage adaptatif. Au lieu de mobiliser systématiquement un modèle large pour chaque requête, GPT-5 évalue la complexité du prompt, puis dirige la demande vers un pipeline léger ou vers un pipeline de raisonnement plus profond. Cette approche réduit fortement le coût d’inférence tout en préservant la qualité sur les tâches difficiles. Dans un contexte marqué par une pénurie mondiale de GPU, ce mécanisme permet d’absorber davantage de requêtes sans dégrader la stabilité du service. Il constitue l’un des changements structurels les plus importants depuis l’arrivée de GPT-4.

A lire également : DFloat11, la compression lossless qui allège les modèles IA malgré la pénurie de GPU, une avancée clé qui vise justement à réduire l’empreinte mémoire et accélérer le traitement des modèles tout en préservant la précision.

GPT-5.1, novembre 2025

GPT-5.1 améliore la capacité de suivi d’instructions, adopte un ton plus naturel et introduit des “personnalités alternatives”. Il devient la version la plus aboutie disponible aujourd’hui.

GPT-5.1 améliore aussi la stabilité du raisonnement et la cohérence entre deux réponses similaires. La gestion de la profondeur de réflexion a été ajustée pour produire des résultats plus homogènes, tout en optimisant la charge serveur grâce à un routage plus fin. Le système introduit également une meilleure personnalisation, avec des profils de réponse ajustables et un comportement plus aligné sur les préférences utilisateur. Ces évolutions rendent le modèle plus prévisible, ce qui est essentiel pour les usages professionnels et l’automatisation via des agents IA.

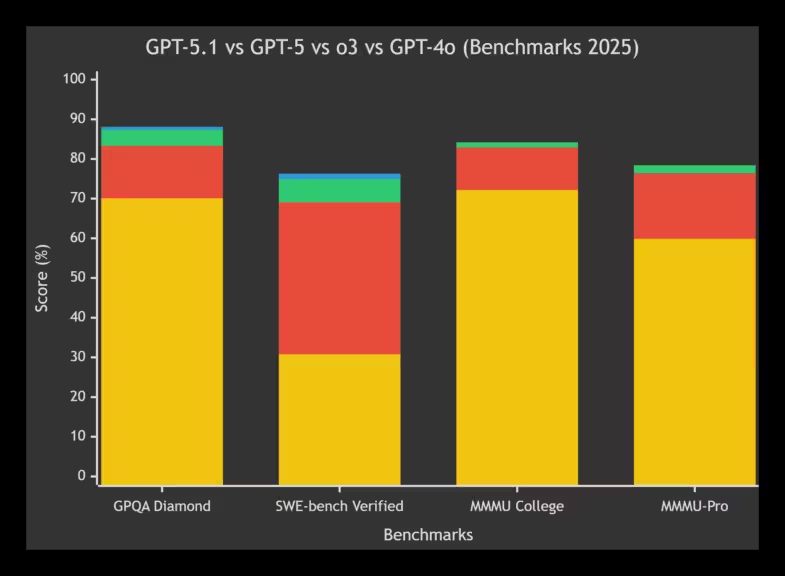

Comparaison des performances

| Benchmark (2025) | Tâche / Domaine | Configuration (mode / outils) | GPT-5.1 | GPT-5 | o3 | GPT-4o |

|---|---|---|---|---|---|---|

| GPQA Diamond | Questions scientifiques de niveau PhD | Reasoning standard | 88.1 % | 87.3 % | 83.3 % | 70.1 % |

| SWE-bench Verified | Résolution automatique d’issues GitHub | Reasoning activé (“thinking”) | 76.3 % | 74.9 % | 69.1 % | 30.8 % |

| HMMT (Math Olympiad) | Problèmes mathématiques avancés | Avec outils Python | n.d. | 96.7 % | 93.3 % | n.d. |

| FrontierMath Tier 1–3 | Mathématiques de recherche | With Python / No tools | n.d. | 32.1 % (Pro) | 15.8 % | n.d. |

| MMMU College | Raisonnement multimodal (texte + image) | Reasoning activé | n.d. | 84.2 % | 82.9 % | 72.2 % |

| MMMU-Pro | Multimodal pro (ingénierie, médecine, science) | Reasoning activé | n.d. | 78.4 % | 76.4 % | 59.9 % |

| Artificial Analysis Index | Score agrégé (raisonnement + long contexte) | Reasoning High / Medium | n.d. | 68 (High) | 67 (Medium) | ~44 |

- GPT-5.1 n’a pas encore un ensemble complet de benchmarks publics, mais les deux plus solides (GPQA Diamond et SWE-bench Verified) montrent une légère amélioration par rapport à GPT-5.

- Les benchmarks dépendants du niveau de raisonnement (Instant / Medium / High effort) doivent être lus avec prudence, car la performance varie fortement selon la charge de calcul engagée.

- GPT-5 introduit un routage adaptatif, ce qui modifie la méthodologie des tests : la même requête peut être traitée par un pipeline plus ou moins profond.

- Les données proviennent de différentes sources reconnues, il s’agit d’un indicateur global

*GPT-4o en jaune, o3 en rouge, GPT-5 en vert, GPT-5.1 en bleu avec des données partielles

Questions clés pour comprendre l’évolution de ChatGPT en 2025

L’évolution de ChatGPT en 2025 soulève plusieurs questions structurantes pour comprendre la direction prise par les modèles. La multimodalité continue d’évoluer, mais c’est le raisonnement explicite, déjà amorcé avec la famille o1, qui devient central. Les modèles doivent gérer des contextes plus longs, adapter dynamiquement leur profondeur de réflexion et maintenir une cohérence élevée malgré une demande croissante. Dans ce cadre, l’efficacité d’inférence devient un enjeu majeur, notamment en raison de la pénurie mondiale de GPU qui impacte directement les performances observées par les utilisateurs. Enfin, l’arrivée future de GPT-6 devrait renforcer deux axes : la mémoire long terme et l’adaptabilité fine aux préférences individuelles.

Le succès de ChatGPT face à la pénurie mondiale de GPU

Le succès massif de ChatGPT s’accompagne de ralentissements ponctuels. Les modèles récents sont plus lourds et le nombre d’utilisateurs continue de croître. Cette situation est aggravée par la pénurie mondiale de GPU professionnels et les limites du packaging CoWoS et de la mémoire HBM. Ces contraintes expliquent pourquoi certains services ralentissent aux heures de pointe.

Pour une analyse détaillée, vous pouvez consulter :

- Pourquoi ChatGPT, Claude et Gemini deviennent plus lents en 2025

- Pénurie de GPU, pourquoi les data centers tournent au ralenti en 2025

Malgré ces limites, OpenAI s’en sort mieux que d’autres grâce à une stratégie multi-cloud qui répartit les workloads entre plusieurs fournisseurs, limitant les temps d’attente et stabilisant les performances.

Les versions 2024–2025 ont été développées dans un contexte où la disponibilité en calcul atteignait ses limites. Chaque nouveau modèle, de GPT-4.1 à GPT-5.1, inclut des optimisations fortes pour réduire le coût d’inférence plutôt que d’augmenter la taille brute des réseaux. Cette évolution est directement liée à la saturation des infrastructures, comme détaillé dans nos analyses sur les ralentissements de l’IA en 2025. L’innovation ne se mesure donc plus uniquement en nombre de paramètres, mais en efficacité, en capacité à router intelligemment les requêtes et à maintenir un service stable malgré des ressources limitées.

À retenir

En trois ans, ChatGPT est passé d’un prototype conversationnel à un assistant avancé largement intégré dans les usages quotidiens. Les prochaines étapes de cette évolution iront vers une présence encore plus fluide dans nos outils, nos logiciels et nos appareils. Les modèles deviennent plus faciles à utiliser, plus personnalisés et mieux adaptés aux préférences individuelles, posant les bases d’une IA de plus en plus omniprésente dans la vie numérique.

Cette trajectoire s’accompagne d’une transformation plus large du secteur. L’intégration de l’IA ne se fera pas uniquement dans le cloud. Les prochaines années verront l’émergence d’un usage plus hybride, combinant exécution locale sur nos postes de travail et traitement à distance. Pour les entreprises, cette hybridation est déjà en marche, portée par un besoin stratégique, celui de ne pas dépendre d’un seul acteur ni d’une seule infrastructure. Cette approche multi-cloud et local permet de sécuriser les performances, la confidentialité et la résilience des services.

L’évolution des modèles, en revanche, ne suit plus le rythme spectaculaire des premières années. ChatGPT n’est pas devenu plus rapide ces derniers mois, comme l’expliquent nos analyses sur les ralentissements liés à la pénurie de GPU et à la saturation des infrastructures. Les modèles sont plus lourds, la demande est plus forte et les ressources matérielles limitées. OpenAI, comme les autres acteurs, adapte la puissance de calcul en fonction du trafic, ce qui peut entraîner des variations de performance.

La sélection automatique du modèle, introduite avec GPT-5 et GPT-5.1, donne parfois l’impression d’une accélération, car le système choisit une version “Instant”, “Thinking” ou une profondeur de raisonnement adaptée au besoin. Cette approche simplifie l’expérience utilisateur et optimise la charge côté serveur, mais elle peut aussi générer des différences de qualité entre deux réponses similaires. C’est aujourd’hui un compromis nécessaire pour maintenir un service stable face à une demande massive.

Dans ce contexte, l’enjeu central n’est plus uniquement d’augmenter la puissance brute des modèles, mais de réduire le coût d’inférence. C’est la logique suivie par OpenAI avec GPT-5.1, mais aussi par Anthropic avec Haiku 4.5. Une baisse durable du coût d’exécution permettrait d’élargir les usages, d’activer de nouveaux scénarios avec des agents IA et d’intégrer l’IA plus profondément dans les logiciels et les appareils du quotidien.

Quant à GPT-6, aucun calendrier n’a encore été officialisé, mais les attentes se concentrent sur une meilleure mémoire long terme et une personnalisation plus fine. Les prochaines années seront donc marquées par une IA plus intégrée, plus adaptable et déployée de manière plus distribuée, entre cloud et local, tout en s’appuyant sur des modèles moins coûteux et plus efficaces.

Sources & Références

OpenAI documente publiquement les versions successives de ChatGPT à travers ses canaux officiels. Les annonces majeures concernant les modèles GPT-4, GPT-4o, GPT-5 et la série « o » sont détaillées dans le blog officiel OpenAI : https://openai.com/blog

Les aspects techniques, comme la gestion multimodale (texte, vision, audio) et les capacités raisonnement des modèles récents, sont explicités dans la documentation de la plateforme OpenAI, qui fournit également les spécifications de chaque version, leurs accès API et leurs limites : https://platform.openai.com/docs

Pour obtenir la liste complète et à jour des modèles disponibles, actifs ou en support hérité (GPT-4o, GPT-4.1, GPT-5, o-series), OpenAI maintient une page dédiée dans son Model Index : https://platform.openai.com/docs/models

Les notes de mise à jour détaillant les évolutions successives, les optimisations de performances, les changements d’API et les dépréciations de modèles sont accessibles dans la section Release Notes : https://platform.openai.com/docs/release-notes

Les informations relatives au raisonnement avancé, au routing de profondeur de réflexion et aux spécificités de la série « o » (o1, o1-preview, o3, o3-mini) sont décrites dans le guide officiel Reasoning Models : https://platform.openai.com/docs/guides/reasoning

La documentation multimodale couvrant la fusion texte-image-audio-vidéo, notamment pour GPT-4o, est disponible dans la section Vision : https://platform.openai.com/docs/guides/vision

Enfin, des analyses indépendantes sur les annonces OpenAI, l’évolution de ChatGPT et l’impact sur le secteur sont régulièrement publiées par des médias technologiques comme The Verge, Ars Technica et Wired, qui couvrent les changements d’architecture, les contraintes de calcul et les enjeux industriels : https://www.theverge.com https://arstechnica.com https://www.wired.com

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !