DeepSeek V3.1 : comment un modèle IA open-source à 685B paramètres défie Claude Opus pour 68 fois moins cher

Et si vous pouviez obtenir les performances d’un modèle d’intelligence artificielle de pointe comme Claude Opus 4, mais pour une fraction du coût ? C’est exactement la promesse que lance DeepSeek V3.1, sorti de nulle part pour secouer le paysage de l’IA open-source.

Avec une architecture titanesque de 685 milliards de paramètres et une efficacience redéfinissant l’économie des grands modèles de langage (LLM), cette IA ne se contente pas de rivaliser avec les leaders du marché. Elle les défie sur leur propre terrain, en particulier dans le domaine du développement logiciel, tout en étant entièrement gratuite via l’interface Web et 68 fois moins chère via l’API.

Comment une telle prouesse est-elle possible ? La réponse se niche dans une combinaison d’innovations techniques : une architecture Mixture-of-Experts (MoE) hyper-optimisée, une utilisation agressive de la quantification FP8 et des techniques d’attention avancées. Cet article plonge sous le capot de ce modèle pour décrypter comment DeepSeek a réussi à construire une intelligence artificielle d’élite pour une facture énergétique et économique radicalement plus basse.

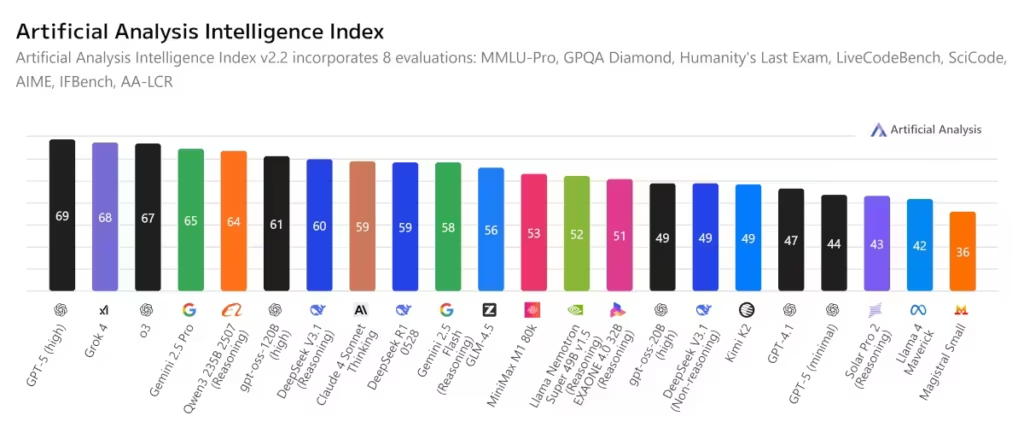

1. Le choc des performances : les benchmarks parlent d’eux-mêmes

Sur le papier, le défi semble insurmontable. DeepSeek V3.1, un modèle open-source, face à Claude Opus 4 d’Anthropic, l’un des modèles propriétaires les plus performants et les plus chers du marché. Pourtant, les résultats sont sans appel.

Sur le benchmark Aider, un test de référence pour évaluer les capacités d’assistance au codage, DeepSeek V3.1 atteint un score impressionnant de 71,6%. Pour mettre ce chiffre en perspective, il surpasse légèrement Claude Opus 4, qui se situait autour de 70,6% lors de la même évaluation. Cette avance, bien que minime, est symboliquement extrêmement forte. Dans la pratique de nombreux développeurs confirment les excellentes capacités du modèles.

Mais la véritable avancée réside dans le coût associé à cette performance.

« Là où l’utilisation de Claude Opus 4 pour une tâche de codage standard peut coûter plusieurs dollars, DeepSeek V3.1 fournit un résultat comparable pour environ 1 dollar, soit une réduction de coût d’un facteur 68. »

Cette différence abyssale n’est pas une simple optimisation marginale. Elle représente un changement de paradigme dans l’économie de l’IA, rendant une puissance de calcul autrefois réservée aux grandes entreprises accessible à tous les développeurs et startups.

Il s’agit d’une agrégation de benchmark et donc juste d’un indicateur

2. Sous le capot : le cocktail gagnant de l’innovation technique

La performance à bas coût de DeepSeek V3.1 n’est pas un coup de chance. Elle est le fruit d’une conception architecturale minutieuse, centrée sur l’efficacité. Voici les trois piliers technologiques qui rendent cette IA si performante.

A. Mixture-of-Experts (MoE) : 685B de paramètres, mais seulement 37B activés

C’est un point centrale de son efficacité. Le modèle contient un nombre astronomique de 685 milliards de paramètres. Vous pourriez imaginer que chaque calcul du modèle mobilise cette puissance colossale, ce qui serait extrêmement lent et cher.

En réalité, le modèle fonctionne sur le principe du MoE (Mixture-of-Experts). Imaginez une immense équipe d’experts, chacun hyper-spécialisé dans un domaine (Python, biologie, raisonnement logique, création littéraire…). Pour chaque question que vous posez, le modèle ne consulte qu’un tout petit comité de 2 à 4 experts (soit environ 37 milliards de paramètres activés).

- Avantage : Vous bénéficiez de l’expertise d’un modèle géant.

- Gain de performance : La vitesse d’inférence et la consommation mémoire sont divisées par un facteur énorme, car seule une fraction des paramètres est utilisée.

L’analyse du fichier model.safetensors.index.json du modèle, disponible sur la plateforme Hugging Face, confirme cette architecture. Les couches MLP (Multi-Layer Perceptron) présentent des dimensions spécifiques (e.g., [18 432, 7 168]) qui ne correspondent pas à une architecture dense classique et sont un indice technique fort de l’utilisation du MoE.

B. La quantification FP8 (F8_E4M3) : Le « MP3 » des poids de l’IA

Le deuxième pilier est la quantification avancée. Traditionnellement, les grands modèles d’IA utilisent des formats de nombres lourds comme le F32, BF16 ou le FP16 pour leurs calculs, garantissant une grande précision mais au prix d’une forte consommation de mémoire et de bande passante.

DeepSeek V3.1 a été entraîné et est exécuté en utilisant massivement le format F8_E4M3, une version du FP8 (Float8). Pour faire simple, cela revient à compresser les poids du modèle, comme on compresse un fichier audio en MP3 pour gagner de la place sur son téléphone, en perdant un peu de qualité mais en conservant l’essentiel.

L’extrait du fichier technique le montre clairement :

- model.layers.0.mlp.down_proj.weight : [7 168, 18 432] – F8_E4M3

- model.layers.0.self_attn.o_proj.weight : [7 168, 16 384] – F8_E4M3

La magie opère grâce aux « weight_scale_inv ». Pour chaque grosse matrice de poids en F8_E4M3, le modèle dispose d’un petit tenseur de calibration en F32 (Full precision) qui permet de déquantifier intelligemment les poids et de préserver une très grande partie de la précision du calcul final. C’est ce qui permet de réduire la taille mémoire du modèle et d’accélérer son exécution avec une perte minime sur la précision.

C. Multi-Head Latent Attention (MLA) & Multi-Token Prediction (MTP)

Enfin, DeepSeek V3.1 embarquerait des techniques avancées pour améliorer son efficacité cognitive :

- MLA (Multi-head Latent Attention) : Il s’agirait d’un mécanisme d’attention permettant au modèle de se concentrer sur des concepts abstraits et des relations latentes, au-delà de la simple corrélation entre les mots. L’architecture d’attention complexe visible dans le fichier technique, avec des projections en deux étapes (q_a_proj/q_b_proj), est parfaitement cohérente avec cette description.

- MTP (Multi-Token Prediction) : Au lieu de prédire le prochain token de manière séquentielle, le modèle apprend à en prédire plusieurs à la fois pendant sa phase d’entraînement. Cette technique, bien qu’invisible dans l’architecture finale, le rend plus efficace et plus rapide.

Les mécanismes exacts du MLA ne sont pas encore documentés publiquement de manière exhaustive.

3. L’impact économique : une économie à tous les niveaux

Le véritable impact de ces innovations techniques se mesure en dollars et en watts.

Coût d’Entraînement : Entraîner un modèle de cette taille avec des méthodes classiques aurait coûté des dizaines, voire des centaines de millions de dollars. Grâce à l’optimisation technique, DeepSeek affirme avoir entraîné V3.1 pour la somme « modique » (à cette échelle) de 5,6 millions de dollars, utilisant approximativement 2,8 millions d’heures de GPU H800.

Coût d’Inférence : C’est là que la magie opère pour l’utilisateur final. La combinaison MoE + FP8 signifie que :

- Le modèle nécessite moins de mémoire VRAM pour fonctionner.

- Il requiert moins de bande passante pour charger ses poids.

- Il effectue moins de calculs par token généré.

Résultat : une réduction drastique du coût par requête pour les hébergeurs, une économie qui est répercutée sur les utilisateurs finaux. Cela ouvre la porte à une utilisation intensive de modèles de pointe pour du développement de logiciels, de la création de contenu ou de l’analyse de données, sans faire exploser le budget.

4. Au-delà du code : un modèle unifié et tourné vers l’avenir

Contrairement à sa version précédente (R1) qui avait des versions spécialisées pour le code, le raisonnement ou le chat, DeepSeek V3.1 est un modèle unifié. La même intelligence artificielle, le même cerveau, est utilisé pour toutes les tâches. Cette approche simplifie grandement son déploiement et son utilisation.

De plus, l’analyse de son vocabulaire étendu a révélé la présence de deux tokens spéciaux (<|search_begin|>, <think>).

- Le premier suggère une capacité native à effectuer des recherches en ligne pour compléter ses réponses.

- Le second est un marqueur classique pour la raisonnement en chaîne (Chain-of-Thought), où le modèle formalise sa réflexion étape par étape avant de donner une réponse finale.

Ces éléments pointent vers un modèle conçu non seulement pour être performant, mais aussi pour interagir de manière plus riche et plus fiable avec son environnement et l’utilisateur.

Conclusion : une révolution silencieuse dans le monde de l’IA

DeepSeek V3.1 n’est pas qu’une simple mise à jour incrémentale. C’est une démonstration de force technique qui prouve plusieurs choses :

- L’open-source peut rivaliser avec le propriétaire. La qualité n’est plus l’apanage des modèles fermés d’OpenAI ou d’Anthropic.

- L’efficacité est la nouvelle course à l’armement. Ce n’est plus une simple course au nombre de paramètres, mais à l’optimisation de chaque opération.

- L’accessibilité économique est cruciale. En divisant les coûts par 68, DeepSeek démocratise l’accès à une intelligence artificielle de pointe et à l’usage intensif.

Alors que le modèle, sous licence MIT permissive, se diffuse déjà sur Hugging Face et via des plateformes tierces, il met une pression immense sur les géants établis. La prochaine étape sera de voir comment la communauté open-source s’en saisira et comment les acteurs traditionnels répondront à ce défi technique et économique.

Une chose est sûre : l’équation de l’IA vient à nouveau d’évoluer. Au delà des benchmarks, il est également nécessaire d’évaluer la constance du modèle. Lors de mes tests via l’interface Web officielle, DeepSeek V3.1 s’est montré très performant sur la qualité rédactionnelle en français, puis lors d’une autre discussion, le texte comportait plusieurs erreurs.

A lire également : DeepSeek v3.1 surpasse GPT-OSS d’OpenAI : l’open source entre dans une nouvelle ère

| Categorie | Benchmark (Metric) | DeepSeek V3.1 Sans raisonnement | DeepSeek V3 0324 | DeepSeek V3.1 Avec raisonnement | DeepSeek R1 0528 |

|---|---|---|---|---|---|

| General | |||||

| MMLU-Redux (EM) | 91.8 | 90.5 | 93.7 | 93.4 | |

| MMLU-Pro (EM) | 83.7 | 81.2 | 84.8 | 85.0 | |

| GPQA-Diamond (Pass@1) | 74.9 | 68.4 | 80.1 | 81.0 | |

| Humanity’s Last Exam (Pass@1) | – | – | 15.9 | 17.7 | |

| Search Agent | |||||

| BrowseComp | – | – | 30.0 | 8.9 | |

| BrowseComp_zh | – | – | 49.2 | 35.7 | |

| Humanity’s Last Exam (Python + Search) | – | – | 29.8 | 24.8 | |

| SimpleQA | – | – | 93.4 | 92.3 | |

| Code | |||||

| LiveCodeBench (2408-2505) (Pass@1) | 56.4 | 43.0 | 74.8 | 73.3 | |

| Codeforces-Div1 (Rating) | – | – | 2091 | 1930 | |

| Aider-Polyglot (Acc.) | 68.4 | 55.1 | 76.3 | 71.6 | |

| Code Agent | |||||

| SWE Verified (Agent mode) | 66.0 | 45.4 | – | 44.6 | |

| SWE-bench Multilingual (Agent mode) | 54.5 | 29.3 | – | 30.5 | |

| Terminal-bench (Terminus 1 framework) | 31.3 | 13.3 | – | 5.7 | |

| Math | |||||

| AIME 2024 (Pass@1) | 66.3 | 59.4 | 93.1 | 91.4 | |

| AIME 2025 (Pass@1) | 49.8 | 51.3 | 88.4 | 87.5 | |

| HMMT 2025 (Pass@1) | 33.5 | 29.2 | 84.2 | 79.4 |

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !