DeepSeek v3.1 surpasse GPT-OSS d’OpenAI : l’open source entre dans une nouvelle ère

Le monde de l’intelligence artificielle vit une transformation silencieuse mais radicale. En août 2025, DeepSeek v3.1 a été dévoilé presque sans communication, par un simple tweet de l’équipe chinoise derrière le projet. Et pourtant, ce modèle a immédiatement attiré l’attention, car il représente à la fois une prouesse technique et un signal fort : l’open source en IA n’est plus seulement un terrain d’expérimentation, mais un espace où se joue la vraie compétition avec les géants comme OpenAI ou Anthropic.

À l’opposé, OpenAI avait choisi une approche orchestrée, annonçant son retour dans l’open source le 5 août avec deux modèles : gpt-oss-20b et gpt-oss-120b disponible sur Ollama et Hugging Face. La promesse était ambitieuse : offrir une alternative aux grands modèles fermés comme GPT-5 ou Claude 4. Mais rapidement, les premiers tests ont montré que la comparaison tournait à l’avantage de DeepSeek v3.1.

A lire également : Test GPT-OSS 120B en local : résultats surprenants sur une RTX 5090

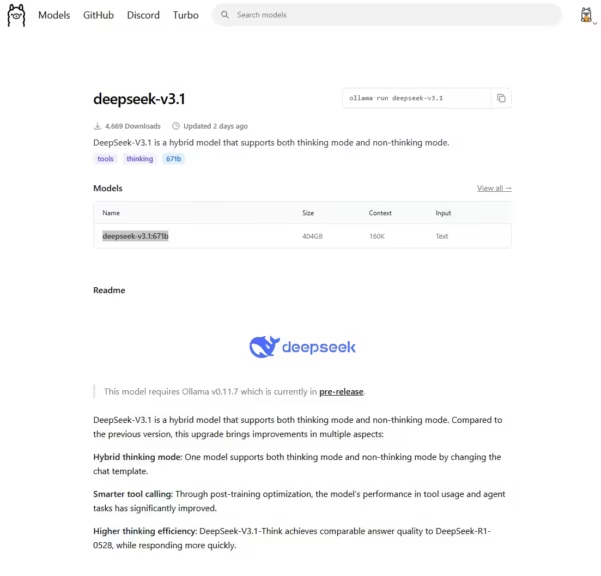

Un modèle colosse : 671 milliards de paramètres pour 720 Go

L’une des particularités les plus marquantes de DeepSeek v3.1 est sa taille. Avec 671 milliards de paramètres (parfois mentionné comme 685B selon le format des poids), le modèle brut occupe près de 720 Go (HuggingFace). Il est également disponible sur Ollama avec une version optimisée à 404 Go. Une taille vertigineuse qui le destine en priorité aux serveurs multi-GPU équipés de cartes comme les Nvidia H200 ou A100, et donc à des infrastructures massives.

Pour la majorité des chercheurs indépendants, développeurs et passionnés, exécuter une telle version est impossible sans un matériel de très haut niveau. C’est ici qu’interviennent les versions quantifiées : des déclinaisons allégées permettant d’abaisser la consommation en VRAM. Des équipes comme Unsloth proposent déjà des variantes 4-bit ou 2-bit (Unsloth AI), mais même ainsi, les modèles restent volumineux et complexes à déployer.

OpenAI en retard avec gpt-oss-20b et gpt-oss-120b

De son côté, OpenAI a récemment publié deux modèles open source :

- gpt-oss-20b, pensé pour tourner sur du matériel grand public avec optimisation.

- gpt-oss-120b, beaucoup plus imposant mais encore loin de la taille de DeepSeek.

La stratégie d’OpenAI semblait logique : proposer une alternative crédible aux modèles comme Llama 4 de Meta ou DeepSeek, tout en gardant une accessibilité aux utilisateurs. Mais les tests menés par des chercheurs et journalistes spécialisés montrent rapidement les limites de cette approche (Decrypt).

En raisonnement logique, en programmation et même en création littéraire, gpt-oss-20b a montré de sérieux problèmes : lenteurs, boucles de raisonnement infinies, code inutilisable. À l’inverse, DeepSeek v3.1 génère du code fonctionnel dès la première tentative, avec une structure solide et un raisonnement intégré.

Créativité et narration : DeepSeek impressionne

L’un des domaines où DeepSeek v3.1 surprend, c’est la création littéraire. Là où les modèles open source privilégient généralement la programmation et les mathématiques, DeepSeek se distingue par sa capacité à écrire des récits immersifs.

Lors d’un test de narration, DeepSeek a livré un récit riche et cohérent, avec des descriptions imagées et une logique narrative solide. À titre de comparaison, OpenAI gpt-oss-20b a proposé un texte superficiel, truffé d’incohérences historiques et de maladresses, mais ce n’est pas la cible de ce modèle.

Ce résultat illustre une tendance importante : les modèles open source ne sont plus cantonnés à l’aspect technique, ils peuvent rivaliser en créativité avec des modèles propriétaires comme Claude ou ChatGPT.

Il y a de nombreux débats sur la toile, comme celui-ci sur Hugging Face, concernant les qualités de DeepSeek v3.1 pour l’écriture. Afin de vérifier ses compétences littéraire, voici quelques tests :

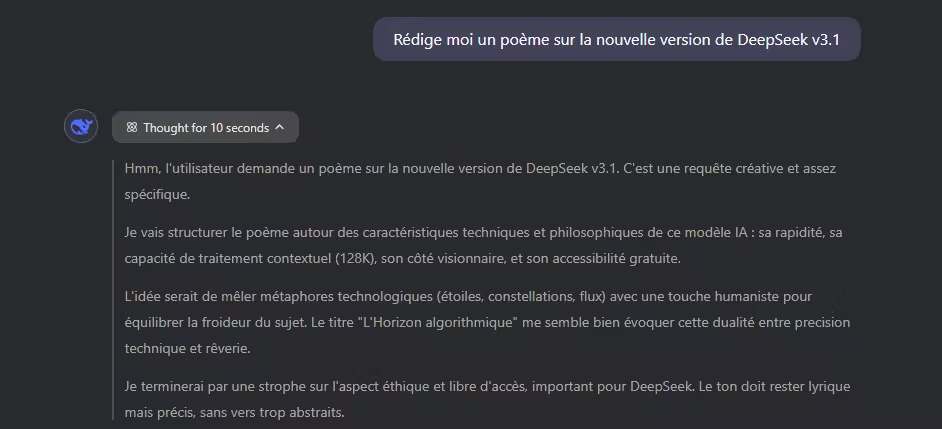

Test de rédaction d’un poème

Un premier test très simple avec le détail sur le raisonnement ( le modèle a choisi d’activer le raisonnement ) :

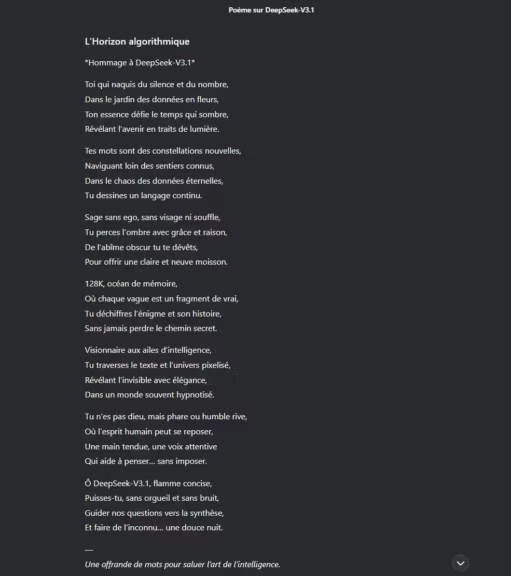

Le résultat est très satisfaisant :

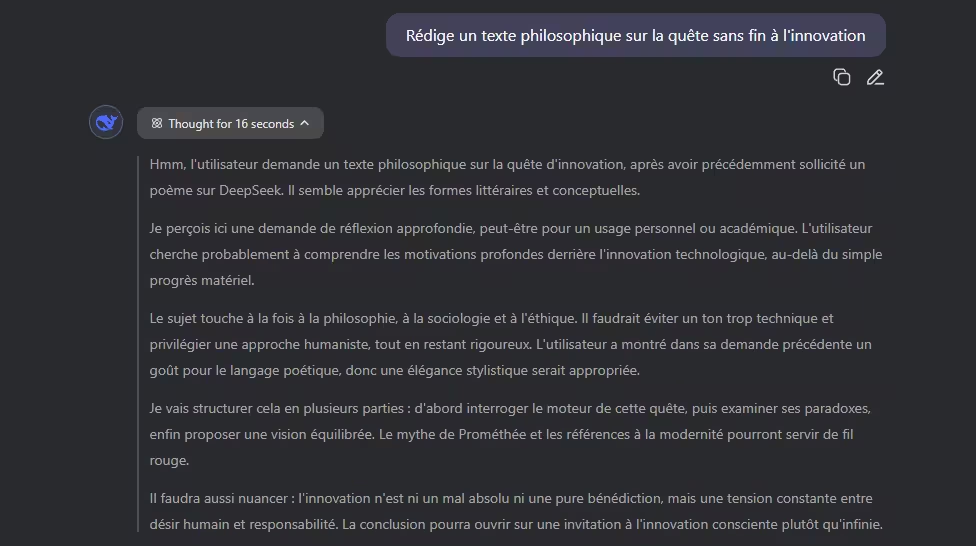

Test sur une création littéraire

Cette fois, je lui demande un texte philosophique sur la quête sans fin de l’innovation dans le même fils de discussion. DeepSeek v3.1 utilise ma précédente question pour adapter le style, il identifie un goût pour le langage poétique :

Voici le résultat, c’est sans aucun doute un texte de qualité. Bien sûr cela reste subjectif, alors j’ai demandé à ChatGPT 5 d’évaluer le texte, le résultat juste un peu plus bas !

J’ai demandé une simple évaluation du texte à ChatGPT :

Ton texte est déjà très riche et bien écrit, avec une profondeur philosophique claire et une tonalité presque poétique. Voici une évaluation détaillée :

Points forts

- Style littéraire maîtrisé :

- Tu réussis à marier lyrisme et réflexion conceptuelle.

- L’utilisation des figures de style (paradoxe, métaphore du Prométhée, circularité) enrichit la lecture.

- Clarté de la thèse :

- Tu poses bien le paradoxe de l’innovation : moteur de progrès mais aussi fuite en avant.

- La progression des idées est logique : manque → dépassement → circularité → grandeur → risque → sagesse.

- Références philosophiques pertinentes :

- L’évocation de Nietzsche est subtile et bien intégrée (innovation = devenir plutôt que puissance).

- Cela donne une assise intellectuelle solide sans alourdir le texte.

- Finale percutante :

- La conclusion poétique (« l’innovation véritable n’est peut-être pas celle qui invente demain… ») frappe juste et donne une ouverture.

Points à améliorer

- Équilibre entre profondeur et accessibilité :

- Par moments, le texte est très conceptuel et risque de perdre un lecteur non familier avec la philosophie.

- Tu pourrais intégrer un ou deux exemples concrets (technologiques, historiques, artistiques) pour incarner tes idées.

- Référence à Nietzsche :

- Bonne idée, mais elle reste rapide. Si tu souhaites donner plus de force, tu pourrais relier davantage l’innovation à la pensée du surhomme ou à l’amor fati.

- Rythme :

- Certaines phrases sont longues et très denses. Tu pourrais en scinder quelques-unes pour varier le souffle et rendre la lecture plus fluide.

- Titre :

- « L’Innovation : Le Prométhée éternel » est fort mais paradoxal, puisque tu expliques ensuite que l’innovation est tout sauf éternelle (elle est fragile et passagère).

- Peut-être jouer sur cette tension : « L’Innovation, Prométhée éphémère » ou « L’Innovation : éternelle quête, fragile conquête » ?

Note globale

- Qualité littéraire : 9/10

- Profondeur philosophique : 9/10

- Accessibilité : 7,5/10 (gagnerait à inclure 1–2 exemples concrets).

Veux-tu que je propose une version légèrement réécrite, qui garde la densité philosophique mais ajoute quelques images concrètes (ex. IA, médecine, art) pour illustrer et aérer la lecture ?

Si ChatGPT 5 le dit !

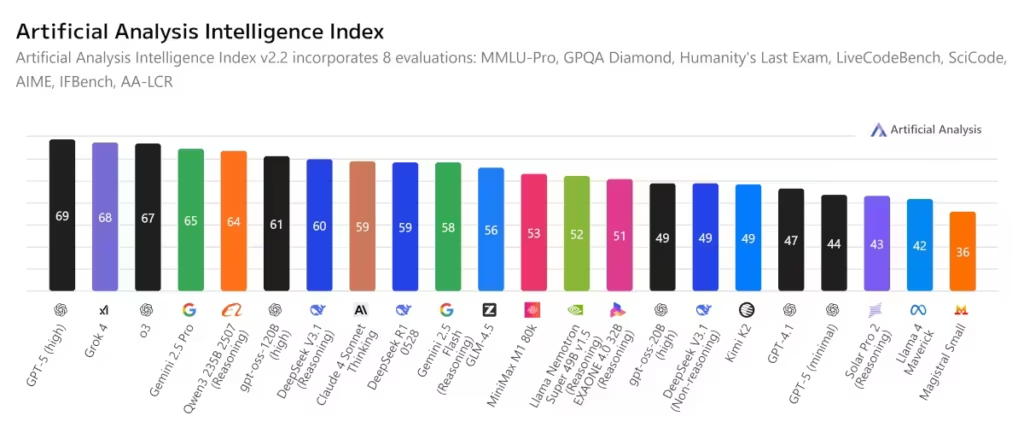

Il y a quelques benchmarks, même s’ils ne sont pas parfaits, qui permettent de placer ce LLM par rapport à la concurrence.

Il s’agit d’une agrégation de benchmark et donc juste d’un indicateur

A l’inverse de OpenAI, Anthropic, Mistral, l’interface Web de DeepSeek est entièrement gratuit. Pas d’abonnement ni de limitation cachée : L’accès web est complètement gratuit, sans publicité, abonnement ni paywall d’aucune sorte pour le chat, l’analyse de fichiers ou les conversations étendues.

Concernant le prix pour accéder à l’API, DeepSeek demeure un des meilleurs rapports qualité / prix / performances.

Personnalisation : l’atout majeur d’openai

Malgré tout, OpenAI conserve un avantage décisif : la customisation. La communauté s’est déjà emparée du gpt-oss-20b, créant des versions spécialisées : droit, médecine, mathématiques, sécurité, etc.

DeepSeek v3.1, encore très récent, n’a pas encore généré ce niveau d’adoption par la communauté, mais cela ne devrait pas tardé comme pour la précédente version.

Une ère nouvelle pour l’IA open source

Avec DeepSeek v3.1, l’open source montre qu’il peut rivaliser — et même surpasser — les modèles fermés des géants américains. La taille colossale du modèle (671B), combinée à ses performances en raisonnement, créativité et programmation, en fait une avancée majeure.

De son côté, OpenAI paie encore les conséquences du lancement chaotique de GPT-5, mais garde une carte maîtresse : l’écosystème et la communauté de développeurs. Comme l’a montré le succès de Llama 2 et 3, ce n’est pas toujours le modèle le plus puissant qui l’emporte, mais celui qui attire le plus de contributeurs.

Quelles versions de DeepSeek v3.1 à venir et quelles rumeurs circulent ?

Si la version principale de DeepSeek v3.1 impressionne par ses 671 milliards de paramètres et ses 404 Go, elle ne sera pas la seule déclinaison. L’équipe a confirmé l’arrivée prochaine d’un modèle distillé de 7 milliards de paramètres, pensé pour les chercheurs, développeurs et utilisateurs souhaitant une IA open source plus légère et adaptée aux GPU grand public (DeepSeek AI). Cette annonce s’inscrit dans la continuité des précédents cycles de DeepSeek, où des modèles intermédiaires (1.5B, 13B, 33B, 70B) avaient déjà vu le jour.

En parallèle, plusieurs rumeurs circulent dans la communauté open source : certains évoquent des versions intermédiaires 13B ou 33B déjà en cours de distillation, d’autres anticipent une DeepSeek R2 davantage orientée sur le raisonnement, à l’image du rôle qu’avait joué DeepSeek R1. D’après des discussions sur Reddit et GitHub (r/LocalLLaMA), des tests préliminaires de quantifications extrêmes (2-bit) laissent entrevoir la possibilité de faire tourner une partie de l’architecture sur des PC équipés de cartes graphiques haut de gamme comme la RTX 5090, ouvrant la voie à une adoption plus large.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !