DFloat11, la compression lossless qui allège les modèles IA malgré la pénurie de GPU

En 2025, la pénurie mondiale de GPU pour les centre de données ralentit les modèles IA les plus utilisés et limite l’accès aux grands LLM. DFloat11, une compression lossless apparue récemment (août 2025), réduit la mémoire des modèles d’environ 30 pour cent sans nuire à la précision. Cette approche pourrait améliorer la fluidité des services IA, soulager les data centers et atténuer les effets de la tension croissante sur les GPU. C’est aussi une solution pour les passionnés et les développeurs qui souhaitent exécuter des LLM ou des IA de génération d’images sur du matériel grand public.

Pourquoi les modèles IA deviennent plus lents en 2025

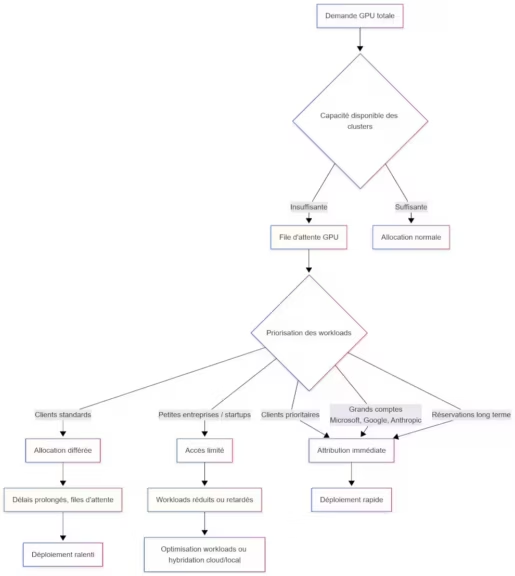

La demande mondiale en calcul explose sous l’effet de modèles toujours plus volumineux, souvent supérieurs à plusieurs dizaines de milliards de paramètres. Les infrastructures ne suivent pas toujours, en particulier dans les clouds, où les GPU les plus puissants sont réservés en priorité aux usages critiques. Pour les utilisateurs et les entreprises, cette pression se traduit par des latences en hausse et des performances variables selon les périodes de la journée.

(Cliquez pour agrandir)

Cette saturation est alimentée par la multiplication de services génératifs et de modèles multimodaux qui consomment massivement de la mémoire GPU. Les centres de données doivent composer avec une offre limitée de GPU, des coûts énergétiques croissants et des charges en hausse constante. Dans ce contexte, les techniques de compression IA sans perte, comme DFloat11, répondent à une demande urgente.

A lire également : Pénurie de GPU : pourquoi les data centers tournent au ralenti en 2025

Une demande GPU qui explose face aux modèles géants

Les modèles récents nécessitent de stocker des milliards de poids en BFloat16, ce qui gonfle considérablement l’empreinte mémoire. À mesure que les capacités contextuelles augmentent, les besoins dépassent les moyens matériels, créant un déséquilibre entre ambitions techniques et disponibilité GPU.

A lire également : Pourquoi ChatGPT, Claude et Gemini deviennent plus lents en 2025

Comment cette tension se traduit pour les utilisateurs

Pour les utilisateurs finaux, ces contraintes apparaissent sous la forme de réponses plus lentes, de files d’attente ou de limitations temporaires. Les modèles IA les plus populaires adoptent parfois des mécanismes de dégradation pour maintenir la stabilité des services, ce qui accentue les effets perceptibles de la pénurie de GPU.

DFloat11, une compression lossless apparue en 2025

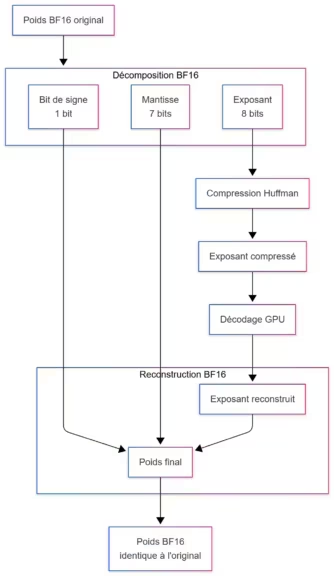

DFloat11 est une technique de compression sans perte conçue pour réduire la taille des modèles IA tout en préservant des résultats identiques. Elle repose sur une observation simple : l’exposant des poids BFloat16 comporte des redondances exploitables. En compressant uniquement cette partie, DFloat11 réduit l’empreinte mémoire de 30 pour cent en moyenne, sans modifier les comportements du modèle.

Contrairement aux méthodes de quantification 8 bits ou 4 bits, qui peuvent dégrader les performances sur les tâches avancées, DFloat11 conserve l’intégrité complète du modèle. Cette précision inchangée en fait une solution idéale pour les usages sensibles au détail, comme le raisonnement, l’analyse documentaire ou la génération d’images de haute qualité. Depuis sa publication, la méthode a été adoptée dans plusieurs modèles populaires, notamment Llama 3.1 8B, Qwen3 ou certaines variantes de FLUX.1.

Un format basé sur BFloat16 et Huffman

Le fonctionnement repose sur un réencodage de l’exposant en utilisant une variante de compression inspirée de Huffman. L’exposant, très compressible, peut alors être stocké en 10 ou 11 bits selon la distribution des valeurs. Le signe et la mantisse restent inchangés, ce qui garantit une reconstitution exacte lors de la décompression et assure un comportement parfaitement identique à la version originale.

Réduction mémoire 30 pour cent sans perte de précision

Dans la pratique, les modèles compressés DFloat11 occupent généralement entre 67 et 70 pour cent de l’espace requis par leurs versions BFloat16. Les résultats produits restent strictement identiques, ce qui permet d’optimiser la mémoire GPU sans compromis. Cette compression lossless améliore également la capacité à gérer des contextes longs ou à exécuter des modèles plus volumineux sur un même matériel.

Quels gains DFloat11 apporte réellement

DFloat11 a été pensé pour optimiser l’inférence en minimisant les transferts et en exploitant pleinement la mémoire GPU. La décompression est effectuée directement sur la carte graphique, ce qui permet de maintenir un débit élevé même lorsque les modèles atteignent plusieurs centaines de milliards de paramètres. Les tests disponibles montrent des performances proches de 200 GB par seconde, nettement supérieures aux approches basées sur le CPU.

Cette efficacité se traduit par une meilleure utilisation de la mémoire GPU, une réduction des opérations de transfert et une capacité accrue à exécuter des modèles complexes ou à gérer des séquences de tokens plus longues. Pour les usages professionnels, cette optimisation ouvre la voie à des pipelines plus stables et à une baisse des coûts d’infrastructure.

Jusqu’à 30 pour cent de mémoire GPU en moins

Avec DFloat11, un modèle nécessitant 16 Go peut passer à environ 11 ou 12 Go. Pour les modèles très volumineux, l’impact est encore plus stratégique. Certaines configurations auparavant impossibles deviennent réalisables, comme le chargement de Llama 3.1 405B sur un ensemble de 8 GPU de 80 Go.

Débit de décompression élevé

Le kernel GPU dédié s’appuie sur des tables de correspondances compactes, entièrement chargées en mémoire locale. Cette approche permet de décoder rapidement les exposants compressés et de reconstituer les poids sans saturer la bande passante mémoire. Le résultat est une décompression rapide et stable, compatible avec des charges intensives.

Contextes plus longs et génération étendue

La mémoire économisée peut être allouée aux buffers utilisés pour la génération, ce qui allonge la capacité contextuelle. Les tests évoquent des gains pouvant multiplier par cinq à quinze la longueur maximale générable sous une contrainte mémoire donnée. Un avantage notable pour les usages nécessitant des analyses de documents volumineux ou des conversations étendues.

Impact sur les modèles graphiques et textuels

DFloat11 a été évalué sur différents types de modèles, dont FLUX.1 pour la génération visuelle et plusieurs variantes textuelles de Llama 3.1. Sur les modèles de diffusion, la réduction mémoire atteint 27 à 28 pour cent avec une légère hausse du temps d’inférence. Sur les modèles textuels, la précision reste identique, confirmant l’intérêt de la compression lossless pour un large spectre d’applications.

DFloat11 face à la pénurie de GPU, pourquoi c’est stratégique

La réduction mémoire proposée par DFloat11 intervient à un moment où les ressources GPU sont particulièrement sollicitées. Les data centers doivent gérer une augmentation massive de la charge, une disponibilité limitée des GPU et une demande grand public exponentielle. Dans ce contexte, économiser 30 pour cent de mémoire par modèle devient un levier essentiel pour maintenir des services rapides et stables.

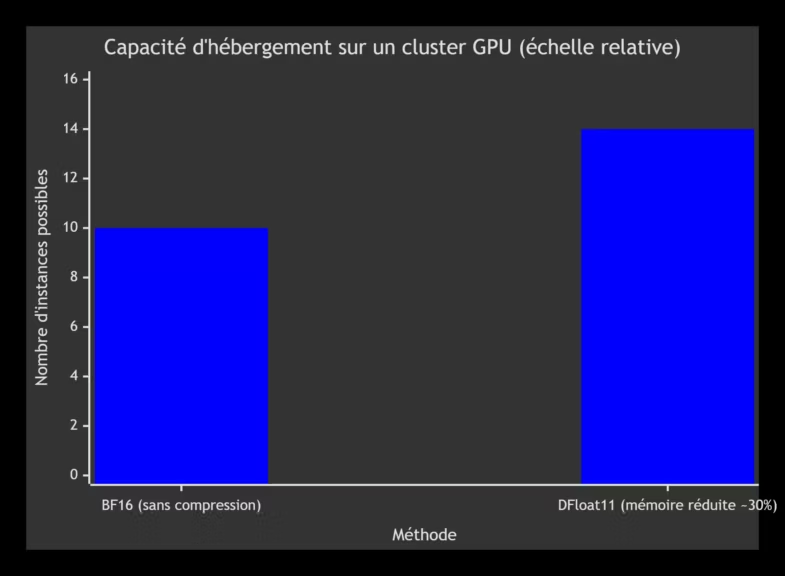

Cette optimisation permet de déployer davantage de modèles sur un nombre fixe de GPU, de fluidifier les pics d’activité et de maîtriser les coûts d’hébergement. Elle améliore aussi la qualité d’usage pour le grand public, qui subit moins les effets de saturation aux heures de forte affluence. Pour les entreprises, DFloat11 ouvre la voie à des applications plus ambitieuses sans nécessiter de matériel supplémentaire.

Limites et contraintes actuelles de DFloat11

DFloat11 introduit des gains importants, mais certaines limites doivent être prises en compte avant une adoption à grande échelle. La première concerne la latence à faible batch, particulièrement perceptible lorsque le modèle est utilisé en mode interactif. Dans ces situations, chaque opération de décompression est difficile à amortir, ce qui peut ralentir la génération token par token.

L’autre contrainte tient à la dépendance à des outils récents. La méthode repose sur des versions récentes de CUDA et sur des intégrations encore en cours d’évolution dans plusieurs frameworks. Certains environnements doivent encore être mis à jour pour prendre en charge la décompression GPU de manière stable.

| Aspect | Avantages de DFloat11 | Limites de DFloat11 |

|---|---|---|

| Réduction mémoire | Environ 30% de mémoire en moins pour les LLM et modèles de diffusion | Gain variable selon la structure des modèles |

| Précision | Compression lossless, résultats identiques bit à bit | Aucun gain supplémentaire au delà de la réduction mémoire |

| Performance GPU | Décompression très rapide, proche de 200 GB/s | Overhead notable en batch 1 ou inférence interactive |

| Compatibilité | Intégration croissante sur HuggingFace, support ComfyUI, format safetensors | Dépendance à CUDA récent, compatibilité incomplète selon les frameworks |

| Déploiement | Permet de charger des modèles plus grands sur le même cluster GPU | Manque de retours en production longue durée |

| Coûts | Réduction potentielle des coûts d’inférence et d’hébergement | Nécessite souvent une mise à jour des environnements existants |

Enfin, si les benchmarks sont nombreux, la plupart concernent des sessions de courte ou moyenne durée. Les tests longue durée en production restent limités, et les retours de terrain seront déterminants pour confirmer la robustesse de la méthode.

Overhead batch 1 et usage interactif

Lors d’une génération interactive, chaque bloc de poids doit être décompressé plus fréquemment. Dans ce contexte, le gain mémoire est bien présent, mais l’avantage en performance peut s’atténuer. Les optimisations en cours visent à réduire ce surcoût et à améliorer les temps de réponse.

Dépendances logicielles et compatibilité partielle

L’utilisation de DFloat11 suppose une pile logicielle à jour incluant CUDA 12 et des bibliothèques compatibles. Certains frameworks ne prennent pas encore intégralement en charge la décompression sur GPU, ce qui peut créer des écarts de performance selon l’environnement utilisé.

Manque de benchmarks longue durée

Les tests publiés se concentrent surtout sur des charges ponctuelles ou sur quelques heures d’inférence. Les analyses continue, sur plusieurs jours ou semaines, permettront de mieux évaluer la stabilité, la fragmentation mémoire et l’impact sur les systèmes de production.

Comment tester ou utiliser DFloat11 aujourd’hui

DFloat11 est déjà accessible pour un large éventail de modèles IA. Sur HuggingFace, plusieurs variantes compressées sont proposées pour Llama 3.1, Qwen3, Phi 4 ou encore des modèles de diffusion comme FLUX.1. Cette disponibilité facilite l’expérimentation sans avoir à recompiler un modèle soi même ou à créer un pipeline spécifique.

Pour trouver les modèles disponibles en DFloat11 sur Hugging Face, vous pouvez utiliser ces deux liens :

- La page officiel de DFloat11 qui liste les modèles uniquement avec les modèles officiels.

- La page de recherche qui contient les modèles également les modèles créés par la communauté.

Le package Python dfloat11 simplifie l’intégration en fournissant un chargement direct des modèles compressés. La décompression GPU est gérée automatiquement, y compris pour les modèles en safetensors. L’installation se limite à quelques commandes et ne nécessite pas de modifications majeures du code existant.

ComfyUI propose aussi un plugin dédié aux modèles visuels, ce qui permet de profiter de la réduction mémoire dans des workflows graphiques. L’ajout d’un mode CPU offload offre une alternative utile pour les environnements disposant de GPU plus modestes ou de configurations hybrides.

Modèles disponibles sur HuggingFace

Plusieurs modèles sont déjà disponibles en version DFloat11. On y trouve notamment Llama 3.1 8B, Qwen3 allant de 4B à 32B, Stable Diffusion 3.5 Large et les variantes FLUX.1 Krea. Cette diversité permet de tester l’efficacité de la compression lossless sur des tâches textuelles, visuelles ou multimodales.

Intégration via le package dfloat11

Le package Python dfloat11 gère la décompression directement sur GPU et s’intègre avec les frameworks standards de chargement de modèles. Il prend en charge le format safetensors, ce qui facilite le déploiement dans des environnements reproductibles et sécurisés. Grâce à ses kernels optimisés, les modèles compressés peuvent être utilisés sans modification du code d’inférence existant.

Support ComfyUI et CPU-offload

ComfyUI ne prend pas officiellement en charge DFloat11 pour le moment, mais plusieurs développeurs ont créé des custom nodes permettant de charger et d’utiliser des modèles compressés en DFloat11 dans les workflows de diffusion. L’installation passe généralement par l’ajout du dépôt ComfyUI-DFloat11 dans le dossier custom_nodes, soit via ComfyUI Manager, soit par un simple clonage du dépôt GitHub officiel. Ces extensions ajoutent un nœud dédié, souvent nommé DFloat11 Model Loader, qui remplace les nœuds standard de chargement de modèles dans les pipelines Flux ou Qwen-Image. Des forks comme ComfyUI-DFloat11-Extended élargissent la compatibilité à davantage de modèles, dont certaines variantes Schnell.

- dépôt ComfyUI-DFloat11

- Des forks comme ComfyUI-DFloat11-Extended offrent une compatibilité élargie pour certains modèles spécifiques, comme Flux Schnell.

Les modèles compatibles, comme CyberRealisticFlux-DF11-ComfyUI, Qwen-Image-DF11, SRPO-DF11 ou encore les versions DFloat11 de Flux, sont disponibles sur Hugging Face. Certains workflows sont même intégrés directement dans les PNG des modèles, ce qui facilite leur utilisation sans configuration supplémentaire.

L’avantage principal demeure la réduction importante de VRAM, avec des gains observés autour de 30 pour cent. Par exemple, Qwen-Image peut passer d’environ 41 Go à 28 Go en version DFloat11, ce qui ouvre la possibilité d’exécuter ces modèles sur des configurations haut de gamme comme une RTX 5090 ou même sur des configurations plus modestes via CPU offload. Ce mode répartit une partie de la décompression ou du chargement entre le processeur et le GPU, ce qui permet de compenser certaines limites matérielles. Bien que très demandée par la communauté depuis mi 2025, l’intégration native DFloat11 dans ComfyUI n’est pas encore disponible et repose entièrement sur ces extensions communautaires.

À retenir

DFloat11 s’impose comme une avancée significative dans la compression lossless des modèles IA. En réduisant de près de 30 pour cent la mémoire nécessaire tout en préservant la précision, cette méthode améliore l’accès aux grands modèles et limite l’impact de la pénurie GPU. Sa décompression rapide, sa compatibilité avec les modèles récents et son intégration dans les frameworks courants en font une solution prometteuse pour les data centers comme pour les professionnels.

Les prochains mois seront déterminants pour évaluer la maturité de la technologie. Si la compatibilité logicielle progresse et que les optimisations de latence se confirment, DFloat11 pourrait devenir un standard dans la gestion mémoire des LLM et préparer l’arrivée de modèles toujours plus vastes.

Vous souhaitez aller plus loin ? Retrouvez l’analyse technique complète et des informations détaillées sur DFloat11 sur notre site Cosmo Edge.

Sources et références

Entreprises

- 2025, Selon GitHub, dépôt officiel du projet DFloat11, https://github.com/LeanModels/DFloat11

- 2025, Comme l’indique GitHub, dépôt du plugin ComfyUI DFloat11, https://github.com/LeanModels/ComfyUI-DFloat11

- 2025, D’après HuggingFace, organisation DFloat11 regroupant les modèles compressés, https://huggingface.co/DFloat11

Institutions

- 2025, Comme le rapporte Rice University à propos des promotions des enseignants impliqués dans DFloat11, https://engineering.rice.edu/news/rice-engineering-and-computing-promotes-11-faculty

Sources officielles

- 2025, Comme le précise arXiv, publication “Lossless LLM Compression for Efficient GPU Inference via Dynamic-Length Float”, https://arxiv.org/abs/2504.11651

- 2025, Version HTML complète sur arXiv, https://arxiv.org/html/2504.11651v2

- 2025, Version OpenReview du papier, https://openreview.net/pdf/6b1607ff4d79f3a474030fbbf74f738e0e5350c9.pdf

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !