L’émergence des fournisseurs d’IA publics : vers une souveraineté numérique ?

L’intelligence artificielle est souvent associée aux géants privés comme OpenAI, Google ou Anthropic. Pourtant, une autre voie se dessine : celle des fournisseurs d’IA publics, pensés comme des services d’utilité publique. À l’image de l’électricité ou de l’eau, l’accès à l’IA pourrait un jour être considéré comme un bien commun, géré par des institutions publiques ou des consortiums non lucratifs.

C’est dans cette perspective que s’inscrit Public AI, un projet open source qui ambitionne de rendre l’inférence accessible à tous, gratuitement ou à faible coût, tout en garantissant transparence et souveraineté (Public AI, About us).

Public AI, une IA comme service public

Le projet Public AI Inference Utility se présente comme un équivalent des services essentiels : un “AI on tap”, où chacun peut accéder à des modèles souverains comme on ouvre un robinet (About the Inference Utility). Cette analogie n’est pas anodine. Elle vise à montrer que l’IA ne devrait pas être réservée à ceux qui disposent de ressources financières considérables, mais disponible de façon stable et équitable.

L’infrastructures actuelle reposent sur deux piliers :

- Un backend vLLM, optimisé pour faire tourner efficacement des modèles massifs.

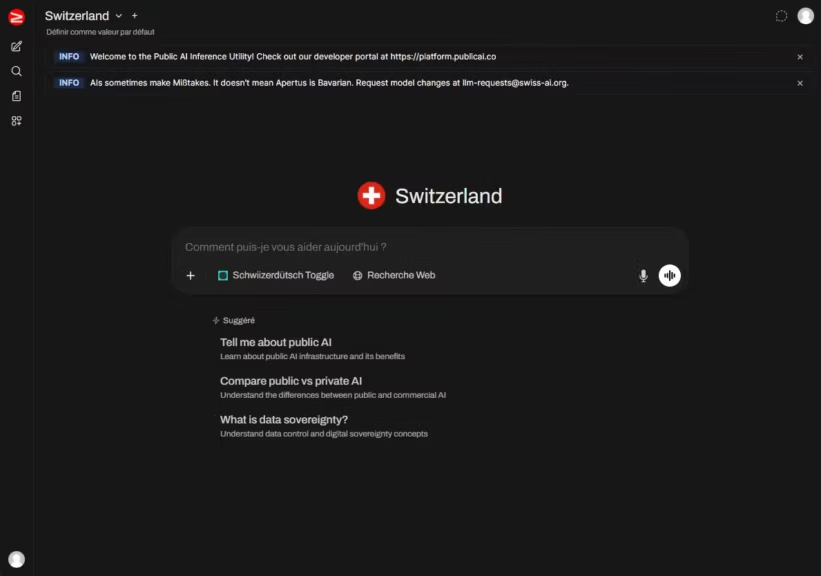

- Une interface open source basée sur Open WebUI, qui permet une utilisation simple via une interface de chat, accessible gratuitement à l’adresse chat.publicai.co.

L’utilisateur peut donc dialoguer avec Apertus-70B (modèle suisse) ou SEA-LION v4 (modèle singapourien) dans une interface claire, sans passer par des lignes de code comme de nombreux projets open source. Cette approche s’apparente à un véritable “service public numérique”, pensé pour privilégier l’accessibilité plutôt que la complexité technique. Toutefois, dans son état actuel, ce service reste loin d’atteindre le niveau de ChatGPT ou Claude, que ce soit en termes de performances, de multimodalité ou de précision.

Une API ouverte, mais sous contrainte

Pour les développeurs et chercheurs, Public AI propose aussi une API documentée (Public AI docs). Elle reprend un standard familier : une API compatible OpenAI, simple à intégrer dans un projet existant. Hugging Face a d’ailleurs choisi d’intégrer directement cette API dans son système d’Inference Providers (Hugging Face blog), ce qui permet d’appeler des modèles Public AI depuis les SDK officiels Hugging Face (Python et JavaScript).

Cependant, cette ouverture soulève des questions. L’API de Public AI est soumise à des limitations strictes pour éviter la saturation :

- 20 requêtes par minute pendant certains événements comme les Swiss AI Weeks (Public AI documentation).

Si ce plafond peut sembler suffisant pour des usages ponctuels, il devient vite un frein pour des projets à grande échelle.

Hugging Face comme relais de diffusion

L’intégration dans Hugging Face constitue un tournant. Jusqu’ici, accéder à un modèle souverain nécessitait souvent des démarches techniques complexes. Désormais, il suffit de sélectionner Public AI comme fournisseur d’inférence dans l’interface Hugging Face Hub ou via les SDK officiels.

Cela apporte trois bénéfices immédiats :

- Accessibilité accrue : la barrière technique est considérablement abaissée.

- Visibilité internationale : les modèles publics sont mis sur le même plan que ceux proposés par des entreprises privées.

- Interopérabilité : l’API compatible OpenAI permet de réutiliser facilement du code existant.

Mais cette diffusion large amplifie aussi les risques : si l’inférence via l’interface Web reste maîtrisable (un utilisateur tape une requête après l’autre), l’inférence via l’API peut générer une charge massive en cas d’appels automatisés.

Hugging Face met en place des quotas et systèmes de priorisation afin de protéger l’infrastructure de Public AI et garantir un service fiable.

- Quotas selon les comptes : les utilisateurs gratuits disposent d’un accès best effort avec des limites implicites sur le nombre de requêtes ou la taille des fichiers. Les comptes Pro, Team et Enterprise bénéficient de quotas plus élevés, d’API plus rapides et d’un accès prioritaire aux ressources (Hugging Face storage limits).

- Priorisation : les abonnés Pro et au-dessus ont un accès prioritaire, moins de risque de throttling et des délais réduits, notamment via des mécanismes comme ZeroGPU pour Spaces (Artificial Intelligence News).

- Protection de l’infrastructure : Public AI s’appuie sur un backend distribué basé sur vLLM avec équilibrage de charge mondial, ce qui assure une répartition équitable des requêtes et réduit les risques de saturation (Hugging Face blog).

En résumé, Hugging Face combine quotas différenciés, priorisation par abonnement et résilience technique pour préserver la stabilité de l’écosystème, y compris pour le service non lucratif Public AI.

Les enjeux de souveraineté numérique

L’existence de fournisseurs d’IA publics va au-delà de la technique. Elle répond à un enjeu géopolitique et culturel : ne pas dépendre exclusivement des géants américains ou chinois pour l’accès aux modèles d’IA.

Public AI est déjà soutenu par des initiatives comme la Swiss AI Initiative, AI Singapore, AI Sweden ou encore le Barcelona Supercomputing Center (Public AI, About us). Ce choix de l’internationalisation montre que la souveraineté numérique ne doit pas se réduire à une logique nationale, mais peut s’organiser en réseau entre pays partageant une même vision.

Une gratuité sous conditions

Aujourd’hui, Public AI offre un accès gratuit à l’inférence. Ce modèle repose sur :

- Des dons de temps GPU par des partenaires publics et privés.

- Des subventions et financements (Mozilla, Future of Life Institute, etc.).

- À terme, la mise en place de modèles économiques hybrides : publicité, contributions citoyennes (type Wikipédia), abonnements Pro (About the Inference Utility).

Si cette gratuité est un argument fort, elle ne peut masquer une fragilité : celle de la viabilité financière et technique à long terme. Sans un soutien institutionnel massif, un service public de l’IA risque d’avoir du mal à résister à la montée en charge.

L’ambition des fournisseurs d’IA publics

Les fournisseurs d’IA publics incarnent une promesse : rendre l’intelligence artificielle accessible comme un bien commun, tout en garantissant transparence et souveraineté. Public AI illustre cette ambition, en combinant une interface simple chat.publicai.co, une API ouverte et une intégration stratégique dans Hugging Face.

Mais l’expérience met aussi en lumière des défis : la scalabilité de l’infrastructure, la pérennité du modèle économique et la capacité à rivaliser avec les infrastructures privées restent des questions ouvertes. Parallèlement, les progrès sont rapides. Qu’il s’agisse du matériel ou des optimisations logicielles, il est désormais possible de faire tourner de petits modèles d’IA directement sur un poste de travail. L’écart entre les LLM open source et les solutions propriétaires continue ainsi de se réduire.

Si l’IA doit devenir un outil universel, il est probable que la voie des services publics d’inférence gagne en importance dans les années à venir. La réussite ou l’échec de Public AI servira alors de référence pour évaluer si l’on peut réellement parler de souveraineté numérique dans l’intelligence artificielle.

Pour aller plus loin : Installer vLLM avec Docker Compose sur Linux (compatible Windows WSL2)

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !