Génération de vidéos IA avec une simple carte graphique 6 Go

La génération de vidéos IA accessible à tous ? C’est désormais une réalité grâce à FramePack, une nouvelle architecture de diffusion vidéo permettant de créer des clips animés en local, même avec une carte graphique dotée de seulement 6 Go de VRAM. Cette avancée ouvre la porte à une création de contenu assistée par intelligence artificielle sans avoir besoin de serveurs distants ni de GPU professionnels coûteux.

FramePack : une avancée majeure pour la vidéo générée par IA

Développé par Lvmin Zhang en collaboration avec Maneesh Agrawala de l’université de Stanford, FramePack repose sur une approche novatrice : il comprime les séquences vidéo selon leur importance pour limiter la mémoire utilisée, tout en conservant une qualité élevée.

Alors que les modèles de diffusion classiques nécessitent souvent plus de 12 Go de mémoire vidéo pour produire des vidéos cohérentes, FramePack permet de générer un clip d’une minute avec seulement 6 Go de VRAM. Cette performance est rendue possible grâce à une gestion intelligente du contexte temporel, un facteur clé dans les modèles de génération vidéo basés sur l’IA.

Une solution conçue pour tourner en local sur des PC gaming

L’architecture FramePack fonctionne en local et prend en charge les cartes NVIDIA RTX 30, 40 et sans oublier les dernières RTX 50. Elle exploite les formats de données FP16 et BF16, optimisant ainsi l’utilisation des ressources matérielles. La compatibilité avec les anciennes architectures Turing ou les GPU AMD et Intel n’est pas encore confirmée.

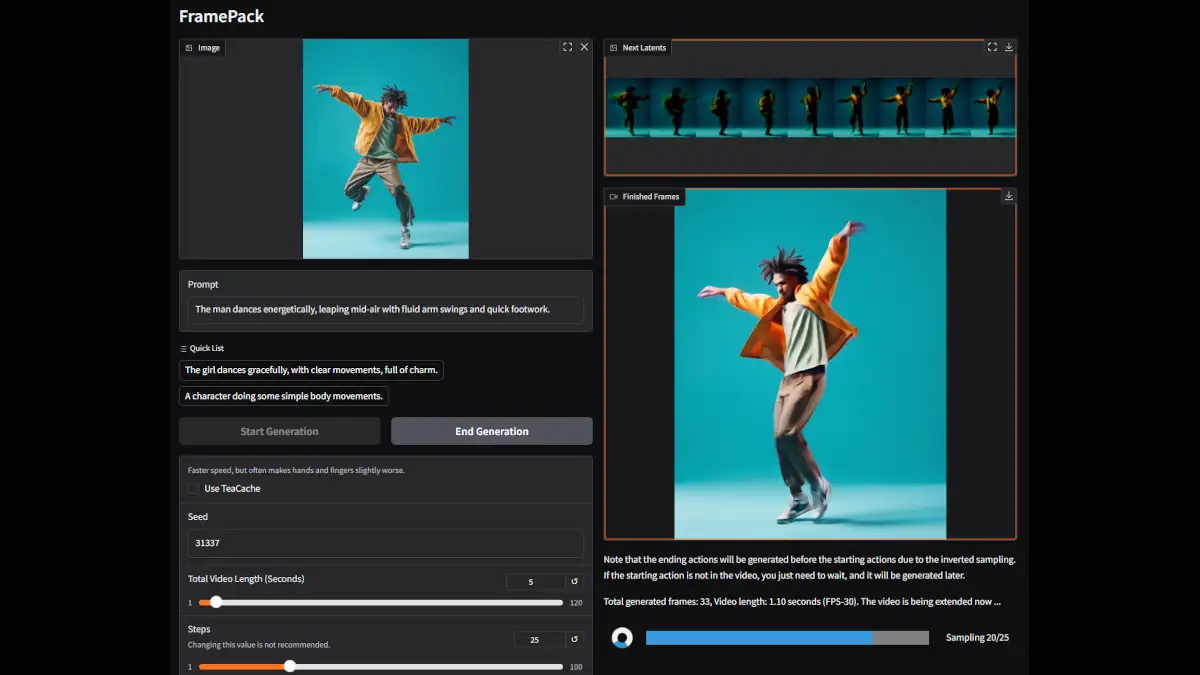

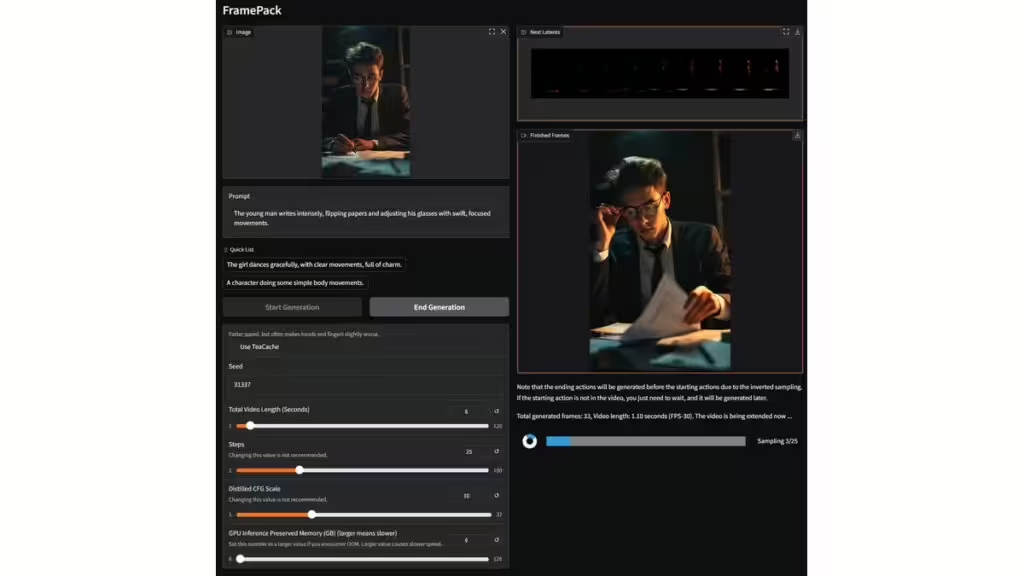

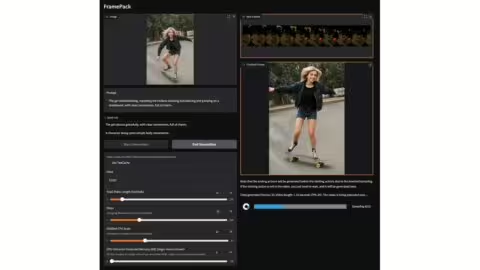

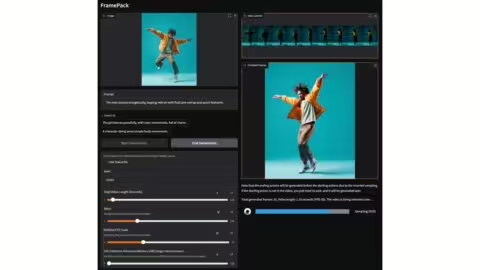

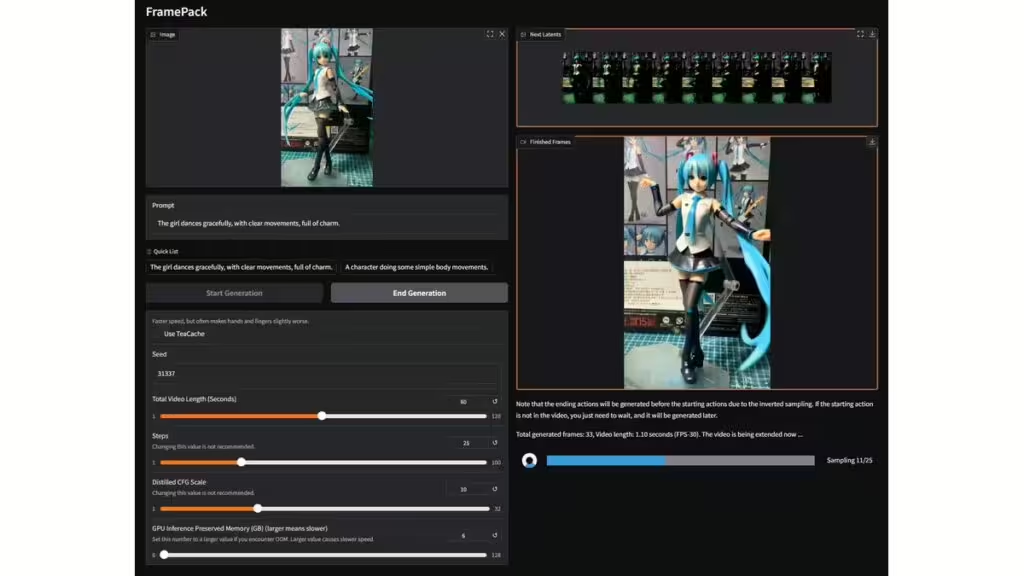

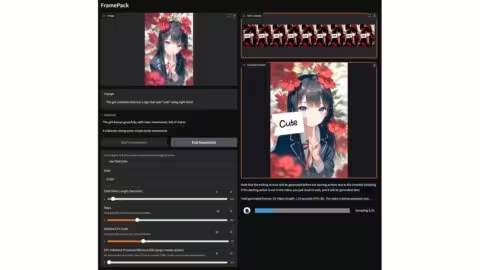

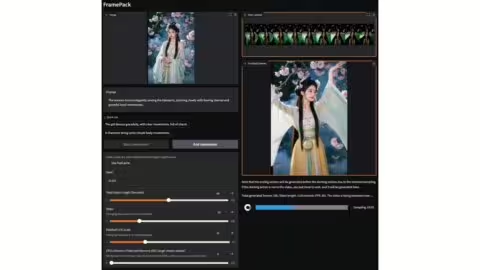

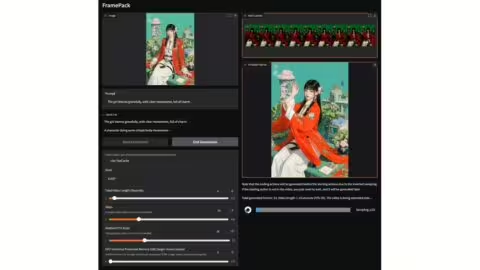

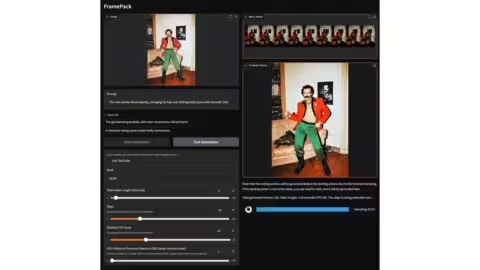

Le logiciel inclut une interface graphique (GUI) fonctionnelle reposant sur un modèle basé sur Hunyuan.

Performances : promesses et limites actuelles

Un GPU haut de gamme comme la RTX 4090 peut atteindre environ 0,6 image par seconde, ce qui reste modeste. La génération reste néanmoins interactive, chaque image étant affichée dès qu’elle est prête.

L’objectif de FramePack est de fournir une alternative locale aux services de génération vidéo cloud, souvent coûteux et centralisés.

Cependant, la fréquence maximale reste limitée à 30 images par seconde, ce qui peut être insuffisant pour certaines productions professionnelles ou vidéos dynamiques. Cette limite pourrait évoluer avec les prochaines, mais il n’y a pas de communication pour confirmer ce point. En attendant, des solutions par interpolation d’images sont toujours possible pour atteindre une fréquence plus élevée.

Afin de vous faire une idée précise de ses capacités de génération de vidéos, sans l’installer, vous trouverez sur la page du projet de nombreux exemples de vidéo générés par l’IA avec ce lien.

Quels usages concrets pour les créateurs de contenu ?

Même si FramePack ne vise pas à remplacer des solutions professionnelles comme Runway ML ou Sora (OpenAI), son faible besoin en ressources rend la génération de vidéos IA accessible aux vidéastes amateurs, aux créateurs de GIFs ou même aux développeurs souhaitant intégrer de courtes séquences dans des jeux ou des applications.

L’usage en local permet aussi de préserver la confidentialité des données, un atout de plus face aux plateformes en ligne qui nécessitent l’envoi de contenus vers des serveurs tiers.

Tutoriel rapide : comment tester FramePack dès aujourd’hui

La méthode la plus fiable pour utiliser FramePack est de suivre les instructions disponibles sur son dépôt GitHub officiel. Voici un résumé simplifié pour débuter.

Prérequis système

- Système d’exploitation : Linux recommandé (Ubuntu 22.04 LTS), Windows (un fichier d’installation est disponible sur la page Github)

- Carte graphique : NVIDIA RTX 30/40/50 avec au moins 6 Go de VRAM

- Pilotes : CUDA 11.8+, cuDNN installé

- Python : 3.10 (environnement virtuel recommandé)

- Dépendances : Torch (>=2.0), torchvision, xformers, gradio, etc.

💡 Des instructions détaillées sont disponibles dans sur la page GitHub. Pour les utilisateurs Windows, une installation via WSL2 (bien configuré) est une piste à explorer. J’essairai de vous faire des retours sur cet usage, après quelques tests.

Comparatif : FramePack face aux solutions concurrentes

| Local / Cloud | Matériel requis | Points forts | Limites | |

|---|---|---|---|---|

| FramePack | Local | RTX 3060+ avec 6 Go VRAM | Léger, open source, temps réel (frame par frame) | Interface brute, performances limitées |

| Runway ML | Cloud | Aucun (navigateur) | Simple, rapide, accès à Gen-2 | Payant, vidéo uploadée sur serveurs |

| Pika Labs | Cloud | Aucun | Bonne qualité, accessible via Discord | Pas open source, limité en personnalisation |

| Sora (OpenAI) | Cloud (non public) | Matériel inconnu | Vidéos ultra réalistes, long métrage possible | Réservé aux partenaires, coût et accès inconnus |

| ModelScope/T2V (Alibaba) | Local + Cloud | GPU >16 Go recommandé | Outils gratuits, modèles accessibles | Complexité d’installation, vidéos très courtes |

FramePack est actuellement la meilleure solution open source et locale pour la génération de vidéos IA avec une carte graphique 6 Go. Elle est idéale pour les passionnés, les développeurs, les curieux et les créateurs souhaitant rester indépendants des plateformes cloud tout en expérimentant la vidéo générée par diffusion. En revanche, pour une qualité professionnelle ou des rendus longs, des solutions cloud restent pour l’instant plus abouties.

Conclusion

Avec FramePack, la génération de vidéos assistée par IA entre dans une nouvelle ère. Il devient possible de créer des animations dynamiques, stylisées ou réalistes sans recourir à des infrastructures cloud coûteuses. Grâce à une simple carte graphique 6 Go, les utilisateurs peuvent expérimenter localement et développer leur propre contenu vidéo IA. Si les performances peuvent encore progresser, cette technologie représente un saut important en matière de démocratisation de l’intelligence artificielle visuelle.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !