Hugging Face Transformers : quelles interfaces graphiques pour simplifier son usage ?

Depuis son lancement, Hugging Face Transformers est devenu une référence incontournable pour exploiter des modèles de traitement du langage naturel (NLP), mais aussi des modèles multimodaux (texte, image, audio). Pourtant, pour un grand nombre d’utilisateurs, l’absence d’interface graphique native rend l’entrée en matière intimidante.

La bibliothèque s’adresse avant tout aux développeurs Python, et son usage standard implique d’écrire du code, de gérer des environnements et d’installer des dépendances. Mais cela ne signifie pas qu’il faut absolument plonger dans les scripts pour bénéficier de la puissance des modèles Hugging Face. Aujourd’hui, plusieurs interfaces simplifiées et outils graphiques offrent une expérience accessible, aussi bien pour les chercheurs confirmés que pour les curieux souhaitant tester rapidement une IA.

Dans cet article, nous allons explorer les principales solutions disponibles en 2025 : API Pipeline, Hugging Face Spaces, OpenWebUI, Gradio et LM Studio. Chacune a ses avantages, ses limites, et ses cas d’usage idéaux.

Hugging Face n’a pas d’interface graphique native

Première précision : contrairement à d’autres solutions comme Ollama, LM Studio ou encore Text Generation WebUI, la bibliothèque Transformers ne propose pas d’interface utilisateur prête à l’emploi.

Cela signifie que si vous installez Transformers via pip install transformers, vous n’obtiendrez aucune fenêtre graphique ou chatbox par défaut. Tout passe par le code Python. Comme le rappelle GeeksForGeeks, l’écosystème Hugging Face est pensé avant tout pour les développeurs, avec un accent sur la flexibilité et la personnalisation.

Pourtant, cela n’empêche pas d’utiliser des interfaces graphiques externes. Hugging Face a construit un écosystème riche autour de sa bibliothèque, et la communauté a développé de nombreux outils pour rendre l’expérience plus accessible.

API Pipeline : l’entrée simplifiée pour les développeurs

La première solution « clé en main » proposée par Hugging Face, c’est l’API Pipeline.

Avec quelques lignes de code seulement, il est possible d’appeler un modèle préentraîné pour des tâches comme :

- génération de texte,

- classification de sentiment,

- traduction,

- résumé de documents,

- question/réponse.

Exemple minimal :

from transformers import pipeline

generator = pipeline("text-generation", model="gpt2")

print(generator("Hello Hugging Face", max_length=30))Pour quelqu’un qui n’a pas envie de configurer un environnement complexe, cette approche est idéale. On reste dans le code, certes, mais la simplicité est telle qu’il n’est pas nécessaire d’avoir des connaissances avancées en programmation.

Comme le souligne Milvus Blog, l’API Pipeline est la meilleure porte d’entrée pour découvrir l’écosystème, sans se perdre dans les détails d’architecture des modèles.

Hugging Face Spaces : une interface graphique sur le Web

Si écrire du code n’est pas une option, il existe une alternative encore plus simple : Hugging Face Spaces.

Spaces est une plateforme collaborative hébergée par Hugging Face. Elle permet à la communauté de publier des applications interactives autour des modèles. Ces interfaces graphiques reposent généralement sur Gradio ou Streamlit, et sont accessibles directement depuis un navigateur.

Par exemple, vous pouvez tester :

- un modèle de génération d’images,

- une IA de transcription audio,

- un chatbot textuel,

- ou même des pipelines complexes combinant plusieurs modèles.

L’avantage ? Zéro installation locale. Il suffit d’ouvrir un navigateur, de choisir un Space, et d’interagir avec le modèle. Comme l’explique Data Scientist Guide, cette approche démocratise l’accès aux modèles en supprimant la barrière technique.

Attention : la limite d’usage gratuit des Spaces hébergés par Hugging Face. Certaines applications peuvent être restreintes en fonction de la charge serveur.

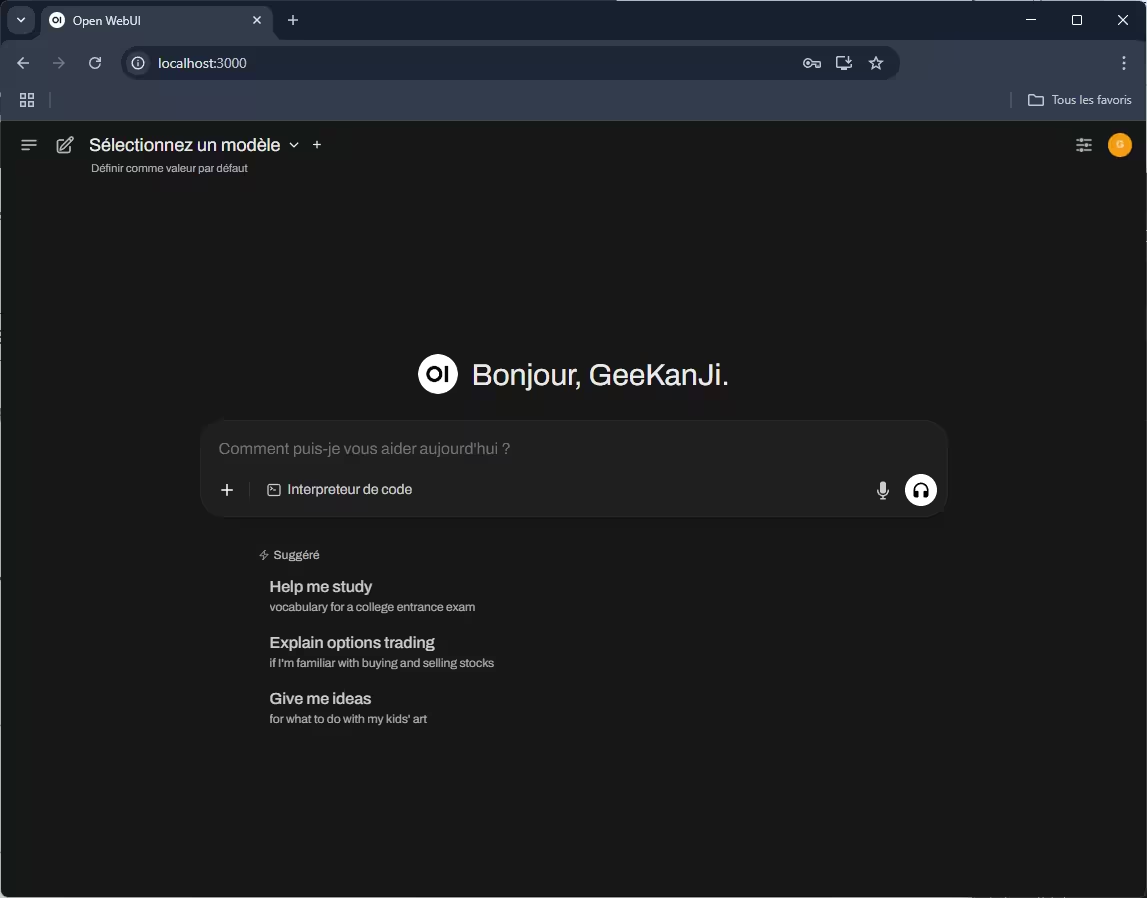

OpenWebUI : une intégration locale possible

Pour ceux qui préfèrent une expérience graphique en local, une solution intéressante est d’associer Hugging Face Transformers à OpenWebUI. Il s’agit d’une interface Web très similaire à celle de ChatGPT, Claude ou autres chat.

Grâce à la commande :

transformers serve --enable-corsIl est possible de déployer un serveur REST local, que OpenWebUI peut interroger. Comme détaillé dans la documentation Hugging Face, cela permet d’exécuter des modèles localement et d’y accéder via une interface graphique moderne.

Ce scénario est particulièrement adapté pour :

- la transcription audio (par ex. avec openai/whisper-large-v3),

- la génération de texte,

- d’autres tâches NLP gérées par Transformers.

L’intégration OpenWebUI + Transformers est moins connue que Spaces ou Gradio, mais elle offre une alternative sérieuse pour ceux qui veulent garder leurs données en local.

Gradio : l’outil graphique par excellence pour Hugging Face

Gradio occupe une place centrale dans l’écosystème Hugging Face.

Cet outil permet de créer en quelques lignes de code une interface Web interactive. Par exemple :

import gradio as gr

from transformers import pipeline

generator = pipeline("text-generation", model="gpt2")

def generate_text(prompt):

return generator(prompt, max_length=50)[0]["generated_text"]

demo = gr.Interface(fn=generate_text, inputs="text", outputs="text")

demo.launch()En lançant ce script, vous obtenez une mini application Web utilisable dans le navigateur, sans avoir à développer une interface complète.

Comme l’explique Deep Learning Nerds, Gradio est devenu un standard de facto pour tester rapidement des modèles. C’est aussi la brique technologique qui alimente une grande partie des Spaces.

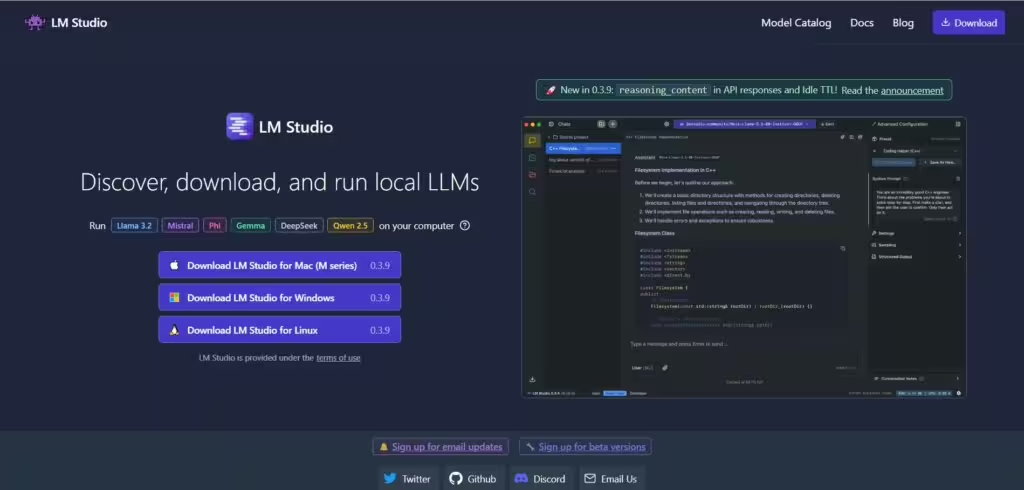

LM Studio : l’alternative desktop

Enfin, pour ceux qui veulent une expérience 100 % graphique et locale sans passer par Python, LM Studio est une option à ne pas négliger, en particulier pour faire ses premiers pas dans l’IA en local.

Disponible sur Windows, macOS et Linux, LM Studio permet de :

- télécharger des modèles Hugging Face depuis le Model Hub,

- les exécuter en local via une interface chat,

- utiliser un serveur API local pour interagir avec d’autres applications.

LM Studio se rapproche de solutions comme Ollama ou Text Generation WebUI, mais avec une compatibilité directe avec Hugging Face. Comme le rappelle CodeWatchers, c’est aujourd’hui l’une des méthodes les plus simples pour exécuter un modèle Hugging Face sans écrire une seule ligne de code.

Attention : LM Studio n’est pas conçu pour les modèles audio/vision, l’outil se concentre sur le texte.

Conclusion : quelle interface choisir ?

Le choix dépend de vos besoins :

- API Pipeline : idéal pour les développeurs débutants.

- Spaces : parfait pour tester des modèles sans installation locale.

- OpenWebUI + Transformers Serve : solution locale pour garder le contrôle sur vos données.

- Gradio : outil flexible pour créer des démos et des prototypes.

- LM Studio : application desktop clé en main, sans Python.

En résumé, même si Transformers ne propose pas d’interface graphique native, l’écosystème regorge d’outils qui simplifient son usage, que ce soit via le Web, une application desktop ou une API locale.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !