LangGraph : l’ossature open source des agents IA modernes

Dans l’écosystème bouillonnant de l’intelligence artificielle, où chaque mois apporte son lot de nouveaux modèles de langage, un nom s’impose peu à peu comme la colonne vertébrale de l’agentique open source : LangGraph. Conçu par l’équipe de LangChain, ce framework est devenu en 2025 une référence pour créer des agents IA autonomes, capables d’orchestrer plusieurs modèles de langage, qu’ils soient commerciaux ou open source, sans dépendre d’un fournisseur unique. Pour une approche plus complète de la conception d’agents autonomes, consultez notre guide Comment construire des agents IA indépendants de tout fournisseur LLM.

L’époque où un agent IA reposait exclusivement sur OpenAI ou Anthropic touche à sa fin. Les entreprises cherchent désormais la souveraineté technologique et la flexibilité multi-LLM. LangGraph répond à cette demande avec une approche modulaire et transparente, centrée sur la construction de graphes d’exécution intelligents.

Comprendre l’approche “graph-based orchestration”

LangGraph ne se contente pas de piloter des modèles de langage. Il structure la logique d’un agent sous forme de graphe d’orchestration, une architecture où chaque nœud représente une action, une décision ou un sous-agent, et où les liens traduisent les flux de données et de contrôle.

Cette approche, décrite dans la documentation officielle LangGraph, offre trois avantages majeurs :

- Lisibilité du flux : le raisonnement de l’agent est visualisable et traçable.

- Parallélisation : plusieurs tâches peuvent être exécutées en même temps.

- Replanification dynamique : l’agent peut ajuster son exécution selon le contexte ou les erreurs détectées.

Contrairement à une architecture séquentielle classique (où les tâches s’enchaînent linéairement), LangGraph permet aux agents de travailler comme des systèmes adaptatifs, capables de réévaluer leurs décisions. C’est ce qui le distingue de frameworks plus simples comme AutoGen ou Semantic Kernel (désormais intégrés dans le Microsoft Agent Framework).

En pratique, un graphe LangGraph peut inclure :

- des nœuds d’action (appel à un modèle, requête API, calcul) ;

- des nœuds de décision (conditions, vérifications, routage de LLM) ;

- des nœuds de mémoire (accès ou mise à jour du contexte).

Cette approche “graph-based” est aujourd’hui adoptée dans les infrastructures IA les plus avancées, car elle offre une meilleure observabilité, un contrôle fin des workflows et une résilience naturelle en cas d’erreur ou d’indisponibilité de modèle.

La persistance d’état : le cœur de la mémoire des agents IA

L’une des forces les plus notables de LangGraph est sa persistance d’état, c’est-à-dire la capacité à reprendre une tâche après interruption sans perdre le contexte. Là où d’autres frameworks redémarrent à zéro, LangGraph sauvegarde les états internes de chaque nœud du graphe.

Cette mémoire durable s’appuie sur des systèmes de stockage externes, que le développeur peut choisir selon ses besoins :

- Redis pour la rapidité d’accès. Idéal pour la persistance in-memory et les graphes d’état volatils. Intégration simple via LangGraph Memory ou Celery-like workers.

- PostgreSQL pour la durabilité transactionnelle. Base relationnelle stable, requêtes SQL, journaux et audit faciles. Adaptée si vous voulez tracer les runs en dehors de LangSmith.

- Qdrant, Milvus, Chroma ou FAISS pour la mémoire vectorielle et la recherche sémantique.

Ainsi, un agent LangGraph peut se souvenir d’un dialogue, conserver une file de tâches partiellement accomplies, ou reprendre un calcul interrompu par une coupure réseau.

Comme le souligne la documentation de LangSmith, la plateforme associée, cette persistance permet de tracer les décisions, de rejouer les flux et de diagnostiquer précisément les erreurs (source LangChain).

En combinant stockage relationnel (états et logs) et base vectorielle (mémoire sémantique), LangGraph atteint un équilibre rare entre fiabilité et intelligence contextuelle.

Comparatif synthétique :

| Objectif principal | Solution à privilégier | Justification |

|---|---|---|

| Orchestration rapide, files d’attente, état éphémère | Redis | Idéal pour la persistance in-memory et les graphes d’état volatils. Intégration simple via LangGraph Memory ou Celery-like workers. |

| Sauvegarde durable des runs, logs, états | PostgreSQL | Base relationnelle stable, requêtes SQL, journaux et audit faciles. Adaptée si tu veux tracer les runs en dehors de LangSmith. |

| Conserver une mémoire sémantique (contextes, embeddings, RAG) | Vector DB (FAISS, Chroma, Qdrant, Milvus, Weaviate) | Recherche par similarité, utile pour agents conversants ou IA contextuelles. Peut se combiner avec PostgreSQL pour le reste. |

Recommandation

- Redis pour commencer : léger, sans configuration lourde.

- PostgreSQL pour tracer ou requêter les runs hors LangSmith.

- Vector DB pour un usage avancé si les graphes utilisent des vecteurs sémentiques (embeddings) ou du RAG (RAG simple, agent RAG ou RAG agentic).

Exemple concret

| Cas d’usage | Stack recommandée |

|---|---|

| Tests de workflows d’agents | LangGraph + Redis |

| Déploiement stable en production | LangGraph + PostgreSQL (+ Redis pour cache) |

| Agents IA avec recherche documentaire | LangGraph + Vector DB (Qdrant ou Chroma) |

Si votre but est de construire un environnement complet de développement agentique (persistence + mémoire contextuelle), la combinaison PostgreSQL + Qdrant est la plus polyvalente. PostgreSQL + Qdrant + Redis est le trio optimal, la couche Redis permet une mise en cache (Cache des requêtes récentes, gestion d’état temporaire d’agents, coordination inter-processus …). Redis peut être ajouté dans un second temps. La base PostgreSQL + Qdrant est un très bon choix pour démarrer avec des fonctionnalités avancés. LangGraph + Redis à privilégier pour débuter simplement.

Un framework vraiment LLM-agnostique

LangGraph incarne pleinement le concept de framework LLM-agnostique. Sa configuration repose sur de simples variables d’environnement, comme :

AGENT_LLM_PROVIDER=openai

AGENT_LLM_MODEL=gpt-5Changer de modèle devient alors une opération triviale.

Cette abstraction permet à l’agent de passer de ChatGPT à Claude, Gemini, Mistral, ou même un modèle local via Ollama ou vLLM, sans toucher au code métier.

Ce principe de routage dynamique multi-LLM est essentiel dans les environnements hybrides où les coûts, la latence et la qualité varient selon la tâche. Par exemple :

- Claude peut gérer la réflexion analytique,

- ChatGPT la génération de texte,

- un modèle open source Mistral la synthèse rapide,

- un modèle local personnalisé l’analyse des données internes / personnels.

Cette flexibilité confère à LangGraph une résilience unique. Même si un fournisseur tombe, l’agent continue de fonctionner avec un modèle alternatif. Microsoft applique déjà une logique similaire dans son Agent Framework, où chaque service dispose de fallback providers automatiques (blog officiel Microsoft).

Mémoire, outils et extensions : l’écosystème LangGraph

LangGraph tire parti de la richesse de l’écosystème LangChain. Les développeurs peuvent y intégrer des tools (actions), des RAG pipelines, ou des connecteurs d’entreprise.

LangGraph n’est pas un moteur de recherche sémantique en soi, mais il peut interopérer avec des solutions externes de génération augmentée (RAG). Parmi celles-ci, Haystack, développé par deepset.ai, se distingue comme un framework concurrent orienté retrieval et question answering open source (documentation Haystack ).

Un agent peut, par exemple :

- interroger Notion, Slack ou HubSpot via des APIs ;

- exploiter un moteur RAG open source comme Haystack pour enrichir ses réponses (documentation Haystack) ;

- stocker ses contextes dans Qdrant ou Weaviate ;

- et exposer son service via LangServe pour un usage web ou production.

Cette modularité repose sur des outils déclaratifs, souvent définis en schéma OpenAPI. Pour garantir la fiabilité, chaque outil doit être idempotent : plusieurs exécutions successives ne doivent pas modifier l’état global (ex. créer plusieurs doublons d’un même objet). Cela évite les erreurs répétitives dans les agents multi-LLM ou lors de relances automatiques.

LangSmith fournit la couche d’observabilité : il trace chaque appel, chaque décision de routage, et mesure la latence et la qualité des résultats.

LangGraph et LangSmith fonctionnent comme deux faces d’un même système : l’un orchestre, l’autre observe.

Observabilité et gouvernance : de la transparence à la traçabilité

Dans un contexte où les entreprises doivent concilier innovation et conformité, LangGraph se distingue aussi par son ouverture à la gouvernance IA. Grâce à LangSmith, chaque décision, chaque interaction avec un LLM, chaque exécution de node est journalisée.

Ce suivi complet permet :

- l’audit de bout en bout d’un flux d’agent ;

- la détection d’anomalies ou de dérives ;

- et la génération de rapports conformes aux exigences RGPD ou SOC2.

Comme le note LangChain dans sa documentation, cette traçabilité s’intègre aisément dans les pipelines CI/CD : les développeurs peuvent rejouer des conversations, comparer les performances de différentes versions et automatiser les tests d’agents.

Cette culture de la transparence rejoint les approches du Microsoft Agent Framework, mais avec la philosophie open source : liberté d’hébergement, adaptation à tout environnement, et absence de dépendance à Azure.

Une intégration fluide dans une pile IA open source

LangGraph s’intègre naturellement dans une pile logicielle IA complète, typique d’une infrastructure open source moderne :

| Composant | Rôle | Outils compatibles |

|---|---|---|

| Orchestration | Flux d’agents IA | LangGraph |

| Mémoire | Contexte et persistance | Qdrant, PostgreSQL, Redis |

| RAG | Recherche sémantique | Haystack, Weaviate |

| Monitoring | Observabilité et QA | LangSmith |

| Déploiement | API et interface | LangServe, FastAPI, Streamlit |

Ce découplage technologique permet une approche BYOC (Bring Your Own Cloud), autrement dit la possibilité de choisir son propre environnement d’exécution. L’ensemble du système peut fonctionner en local, dans un cloud privé ou dans une architecture hybride, tout en conservant le même comportement et les mêmes performances. Cette flexibilité renforce la souveraineté des données, un critère devenu essentiel pour les entreprises soumises à des exigences de conformité ou de sécurité élevées.

Limites et bonnes pratiques

LangGraph est puissant, mais il exige une certaine rigueur architecturale. Voici les recommandations issues des projets open source et de la documentation LangChain :

- Clarté avant complexité : éviter les graphes trop profonds ou imbriqués, difficiles à déboguer.

- Idempotence et timeout : garantir la stabilité des outils et la gestion d’erreurs.

- Observation dès la conception : activer LangSmith dès le début du projet.

- Séparation des environnements : déployer sur des contextes isolés (dev, staging, production).

LangGraph, moteur de l’autonomie IA

LangGraph s’impose comme le socle technique de l’autonomie IA : un framework open source, flexible, interopérable et résilient. Il offre aux développeurs une liberté rare, choisir leurs modèles, leurs outils et leurs infrastructures, tout en garantissant la cohérence et la persistance du raisonnement.

Face aux solutions propriétaires, il représente une alternative solide, alignée sur la philosophie du multi-LLM, de la transparence et de la souveraineté technologique.

Pour les entreprises, c’est aussi un investissement d’avenir : la garantie que leurs agents IA resteront viables, même si le marché des LLM change de visage demain.

Plus qu’un framework, LangGraph s’impose comme l’ossature technique d’une génération d’agents IA conçus pour fonctionner sans dépendance envers un fournisseur unique.

Étude de cas : un agent IA autonome avec LangGraph

Pour mieux comprendre la puissance du framework, prenons l’exemple d’une entreprise qui développe un agent interne capable d’assister les ingénieurs dans la veille technologique et la rédaction de rapports techniques.

Contexte du projet

L’objectif de l’entreprise, un agent :

- fonctionnant en local pour préserver la confidentialité ;

- capable de comprendre et résumer des documents techniques ;

- et de communiquer avec différents modèles selon la tâche.

Architecture choisie

L’équipe a construit une stack open source IA basée sur LangGraph :

- LangGraph pour l’orchestration du flux d’agents ;

- Qdrant pour la mémoire vectorielle ;

- Haystack pour la recherche documentaire sémantique ;

- vLLM pour exécuter un modèle open source localement ;

- LangSmith pour le suivi des interactions et des erreurs.

Le graphe LangGraph comportait trois agents :

- Analyst Agent : analyse et extrait les passages importants (Claude).

- Writer Agent : synthétise les résultats en texte fluide (ChatGPT).

- Reviewer Agent : valide le contenu via un modèle local personnalisé.

Chaque agent communique via des nœuds reliés et stocke son état dans la mémoire persistante. Si un modèle est indisponible, LangGraph route automatiquement la tâche vers un autre fournisseur (failover).

Résultats

- Réduction de 25 % du coût d’exécution grâce à l’usage hybride (cloud + local). L’objectif de l’entreprise est d’augementer ses invectissements dans son infrastructure (serveurs GPU, Cloud privé) afin d’executer des LLM en local, plus performants, et réduire encore ses coûts.

- Zéro perte de contexte sur des exécutions prolongées (plusieurs heures).

- Observabilité complète via LangSmith, avec des logs exploitables pour la QA interne.

Cet exemple montre qu’un agent IA peut être à la fois autonome, auditable et indépendant, sans dépendre d’API externes. LangGraph agit ici comme un chef d’orchestre, garantissant la cohérence du raisonnement, la reprise d’état et la stabilité du flux d’exécution. Il offre aussi une évolutivité naturelle : les organisations peuvent progressivement intégrer de nouveaux modèles ou déployer davantage de LLM en local, sans refondre leur architecture.

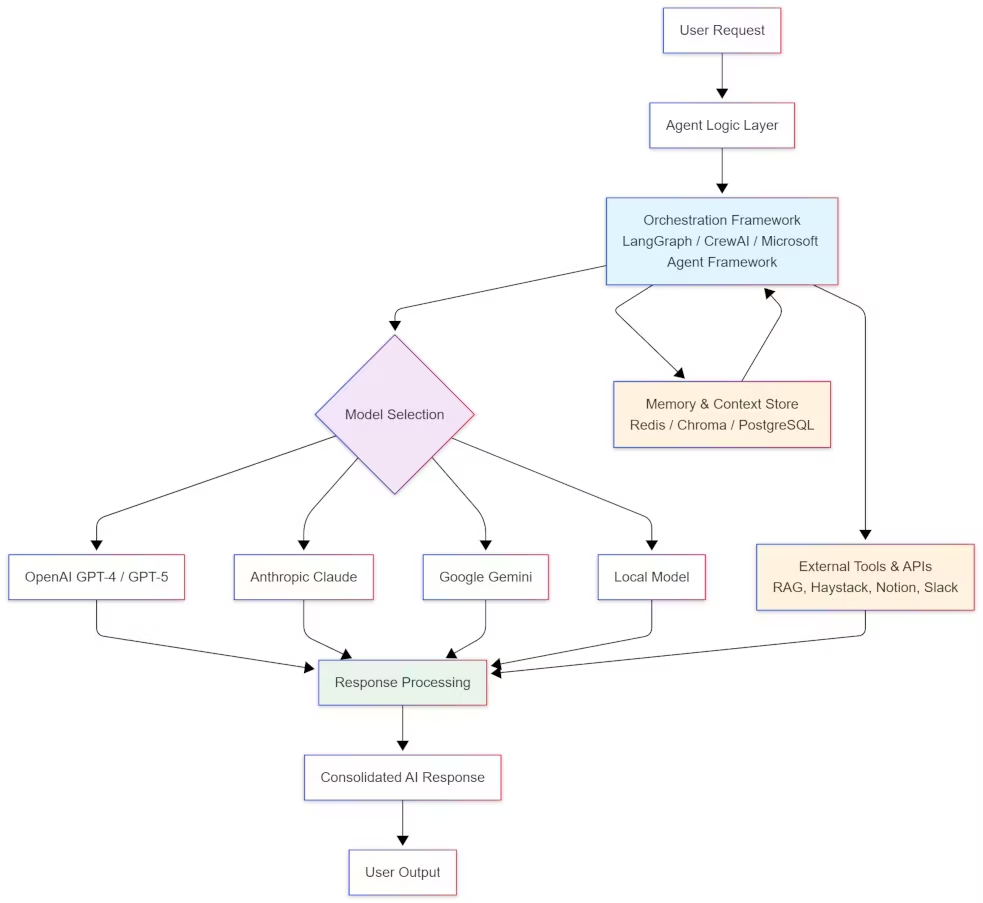

Schéma : architecture simplifiée d’un agent IA avec LangGraph

Ce diagramme illustre la logique de graph orchestration : chaque agent est un nœud collaborant au sein d’un flux supervisé par LangGraph, avec mémoire persistante et observabilité intégrée.

Conclusion

LangGraph n’est pas qu’un outil supplémentaire dans l’écosystème open source de l’IA. C’est une référence pour orchestrer des agents IA utilisant différents modèles de langage, au sein d’architectures capables d’apprendre, de raisonner et de persister dans le temps.

En proposant une structure graphique, modulaire et traçable, LangGraph transforme la logique expérimentale des prototypes IA en systèmes fiables, auditables et extensibles. Associé à des composants comme LangSmith, Chroma ou Weaviate, il forme un véritable socle technique pour concevoir des agents IA LLM-agnostiques, interopérables et souverains.

Mais sa véritable force réside dans son adaptabilité à l’évolution rapide des modèles de langage. Alors que les entreprises commencent à entraîner ou personnaliser leurs propres LLM open weight, LangGraph leur permet de les intégrer naturellement au sein d’une même architecture, au même titre que les modèles commerciaux. Cette compatibilité fait de lui un pont durable entre les LLM du cloud et ceux hébergés en local, un enjeu stratégique pour la souveraineté et la maîtrise des coûts.

Dans un contexte où l’autonomie IA, la résilience technologique et la confidentialité des données deviennent des priorités, LangGraph illustre comment l’open source offre une voie claire pour allier innovation et indépendance. Il n’est plus seulement un framework : c’est la charpente évolutive d’une intelligence artificielle distribuée, adaptée aux transformations à venir du paysage LLM.

Ressources recommandées

- Documentation officielle LangGraph

- LangSmith – traçabilité, mesure et QA des agents IA

- LangServe – déploiement d’agents LangGraph sous forme d’API

- Chroma DB – mémoire vectorielle open source

- Haystack RAG – moteur de recherche sémantique open source

- CrewAI – framework multi-agents collaboratifs

- Microsoft Agent Framework – orchestration d’agents IA orientée gouvernance

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !