Ollama par défaut en Q4 : pourquoi vos modèles IA perdent en précision

Lorsque l’on installe un modèle d’intelligence artificielle via Ollama, il est facile de croire que l’on utilise une version complète, avec toute sa précision et ses capacités. Pourtant, la réalité est différente : par défaut, Ollama distribue la majorité de ses modèles en quantification 4 bits (Q4_K_M), une méthode de compression pensée pour réduire la consommation mémoire et accélérer l’exécution. Cette optimisation, bien que pratique, entraîne une perte de qualité et de précision par rapport aux versions en pleine précision (FP16 ou FP32).

Dans cet article, nous allons explorer pourquoi Ollama a fait ce choix, quelles en sont les limites, et surtout comment les utilisateurs peuvent contourner ce compromis lorsqu’ils recherchent des résultats plus fidèles et que leur matériel le permet.

Qu’est-ce que la quantification dans Ollama ?

La quantification consiste à réduire la précision numérique utilisée pour représenter les paramètres d’un modèle. Au lieu de stocker les poids en 16 ou 32 bits, Ollama utilise généralement des formats 4 bits comme le Q4_K_M, ou parfois le Q4_0 pour des versions plus anciennes (Hugging Face).

- Avantage principal : un modèle compressé en Q4 utilise beaucoup moins de mémoire et peut tourner sur des configurations grand public, y compris avec des GPU limités en VRAM ou même sur CPU.

- Inconvénient : une partie de la finesse et de la précision du modèle est perdue, ce qui peut se traduire par des réponses moins nuancées ou des erreurs plus fréquentes.

Comme l’explique Dataiku, la quantification est toujours un compromis entre vitesse et qualité : plus on réduit la taille des nombres, plus l’exécution est rapide, mais au détriment des performances cognitives du modèle.

Pourquoi Ollama privilégie le Q4 par défaut ?

L’objectif affiché par Ollama est simple : démocratiser l’usage des modèles IA locaux. En proposant des variantes par défaut en Q4_K_M, la plateforme permet à des utilisateurs qui ne disposent pas de cartes graphiques haut de gamme de faire tourner des modèles comme LLaMA 2, Gemma ou DeepSeek directement sur leur machine.

Cette approche répond à une logique d’accessibilité :

- Un modèle 7B en FP16 peut nécessiter plus de 16 Go de VRAM, alors qu’en Q4 il se contente de 4 à 5 Go.

- La vitesse d’inférence est grandement améliorée, rendant l’expérience utilisateur fluide même sur des configurations modestes.

En d’autres termes, Ollama mise sur la compatibilité et la rapidité plutôt que sur la qualité brute. Cela explique pourquoi tant d’utilisateurs découvrent après coup que leurs modèles sont moins précis qu’attendu.

Les limites du Q4 : quand la précision fait défaut

Même si la quantification Q4_K_M est reconnue comme l’un des meilleurs compromis actuels (Towards AI), elle n’est pas exempte de limites :

- Perte de nuances : les réponses peuvent sembler plus générales, avec une profondeur de raisonnement réduite.

- Erreurs subtiles : certaines tâches sensibles (calculs précis, logique complexe) peuvent donner des résultats incorrects.

- Capacités amoindries : sur des modèles très compressés, les capacités de génération de code ou de raisonnement avancé sont parfois dégradées.

Comme l’a souligné un utilisateur sur Stack Overflow, un même modèle peut produire des réponses nettement moins fiables dans Ollama par rapport à sa version Hugging Face non quantifiée.

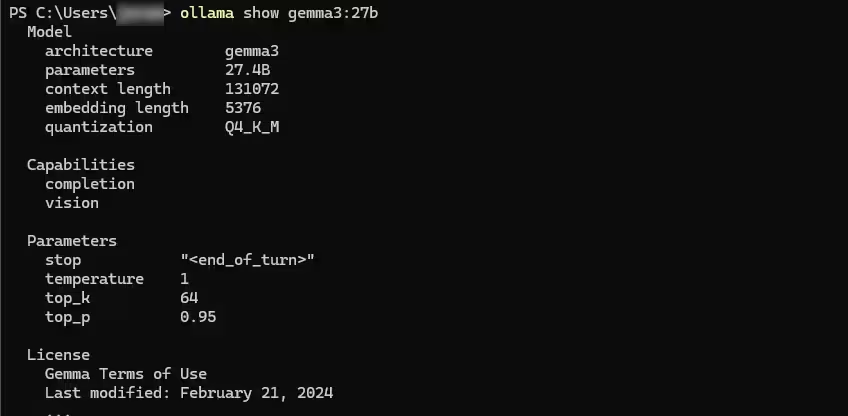

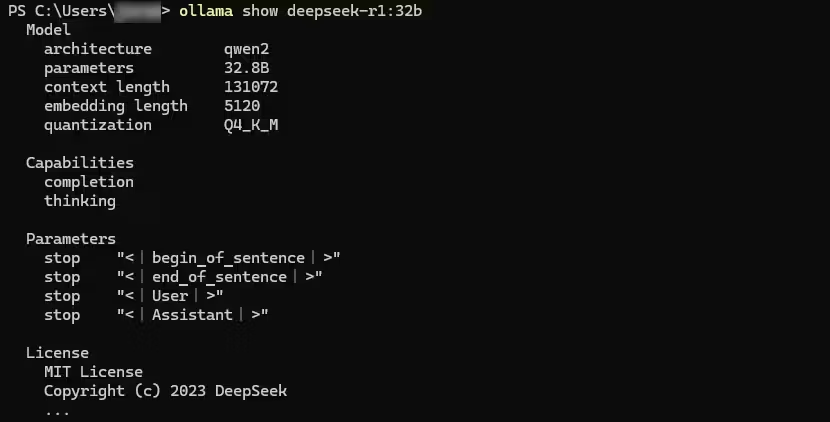

Comment vérifier la quantification de vos modèles ?

Un piège fréquent est de croire que la commande ollama list affiche la quantification. Ce n’est pas le cas. Elle ne montre que le nom du modèle, son ID et sa taille.

Pour voir le niveau de quantification exact, il faut utiliser :

ollama show <nom-du-modèle>Par exemple :

ollama show gemma3:27bLe retour affichera des informations détaillées, dont la ligne :

quantization: Q4_K_M

C’est le moyen le plus sûr de savoir si l’on utilise un modèle en Q4, Q5, Q6 ou Q8.

Existe-t-il des alternatives pour plus de précision ?

Heureusement, Ollama ne se limite pas au Q4. Il est possible de :

- Télécharger des variantes plus précises comme le Q6_K ou le Q8_0, adaptées aux GPU plus puissants.

- Importer ses propres modèles depuis Hugging Face avec la quantification de son choix (Ollama Docs).

- Mixer plusieurs approches : utiliser un modèle Q4 pour les tâches rapides et peu sensibles, et réserver un modèle Q8 pour des usages plus critiques.

Quand le Q4 suffit… et quand il devient un problème

Le choix du Q4 n’est pas mauvais en soi. Tout dépend de l’usage :

- Cas d’usage adaptés au Q4 :

- Chat conversationnel basique

- Résumés rapides

- Questions générales

- Prototypage sur PC portable ou machine modeste

- Cas où le Q4 devient limitant :

- Analyse de code complexe

- Raisonnement mathématique ou logique poussé

- Recherche académique exigeante

- Applications professionnelles sensibles

Dans ces situations, la quantification par défaut devient une contrainte, et il est préférable de choisir une version plus précise, même si cela demande davantage de ressources.

Conclusion : une force qui devient aussi une faiblesse

Le choix d’Ollama d’imposer par défaut la quantification Q4_K_M est cohérent avec sa mission : rendre l’IA locale accessible au plus grand nombre, sans exiger un GPU à plusieurs milliers d’euros. Grâce à cette approche, des modèles puissants comme LLaMA, Gemma ou DeepSeek peuvent tourner sur des PC portables ou des machines de bureau modestes.

Cependant, cette démocratisation a un prix : la perte de précision et de fiabilité. Pour un usage quotidien ou exploratoire, ce compromis est acceptable. Mais dès que l’on aborde des applications sensibles (développement, recherche, analyse de données), la limitation devient évidente.

En d’autres termes, Ollama offre une porte d’entrée idéale à l’IA locale, mais ceux qui souhaitent exploiter toute la richesse des modèles doivent rapidement envisager d’autres quantifications ou d’autres solutions.

A lire aussi : Ollama vs vLLM : quelle solution choisir pour servir vos modèles LLM en local ?

Conseils pratiques : comment choisir la bonne quantification ?

Voici quelques repères simples pour adapter votre usage :

1. Évaluer son matériel

- Moins de 8 Go de VRAM (ou uniquement CPU) → restez en Q4_K_M. C’est la seule option réaliste pour un usage fluide.

- Entre 12 et 24 Go de VRAM → privilégiez le Q6_K, qui offre une meilleure précision tout en restant accessible.

- 32 Go de VRAM et plus (RTX 5090, serveurs dédiés, GPU Pro) → optez pour le Q8_0 ou même des modèles FP16 si disponibles, pour conserver la qualité maximale.

A noter, les modèles BF16 ne sont aujourd’hui pas supporté par Ollama. Malgré la possibilité de les importer, il sont convertis en FP16. Une mise à jour d’Ollama pourrait à terme améliorer ce point.

2. Adapter au cas d’usage

- Chat généraliste, résumés, prototypage → Q4 suffit largement.

- Développement, génération de code, logique mathématique → Q6 recommandé.

- Recherche critique, IA de production, génération scientifique → Q8 ou FP16 pour éviter toute perte de fiabilité.

3. Vérifier la quantification avant usage

Toujours exécuter :

ollama show <model>afin de savoir dans quel format tourne votre modèle. Beaucoup d’utilisateurs découvrent trop tard que leurs résultats sont biaisés par une quantification trop agressive.

4. Importer ses propres variantes

Si Ollama ne propose pas directement la quantification que vous souhaitez, il est possible d’importer un modèle Hugging Face et de le convertir dans le format adapté (Ollama Docs).

Mot de la fin

Ollama n’essaie pas de tromper ses utilisateurs : son choix par défaut reflète une vision pragmatique, où accessibilité et vitesse priment sur la perfection. Mais comprendre les implications de la quantification est crucial pour tout utilisateur avancé.

En connaissant ces limites, chacun peut décider :

- de rester en Q4 pour profiter d’une IA locale rapide et légère,

- ou d’investir dans une quantification plus précise pour exploiter tout le potentiel des modèles modernes.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !