Ollama vs vLLM : quelle solution choisir pour servir vos modèles LLM en local ?

L’essor de l’inférence LLM en local bouleverse la façon dont développeurs, chercheurs et entreprises exploitent l’intelligence artificielle. Deux noms reviennent sans cesse dans les discussions : Ollama et vLLM. Ces deux serveurs LLM locaux incarnent des philosophies radicalement différentes. L’un mise sur la simplicité, l’autre sur la performance et la scalabilité. Mais alors, Ollama vs vLLM, quelle solution choisir pour servir vos modèles de langage en local ? Ces deux solutions sont parfois présentées comme similaires, pourtant elles différents sur de nombreux points. Choisir la bonne solution adaptée à vos usages et essentiel, que ce soit pour obtenir des résultats de qualité ou s’adapter à vos contraintes matérielles.

Pourquoi installer un serveur LLM en local ?

Historiquement, utiliser un modèle de langage de grande taille impliquait de passer par le cloud. Problème : coûts élevés, dépendance à une connexion Internet, risques pour la confidentialité des données. Aujourd’hui, avec des solutions comme Ollama ou vLLM, il est possible d’exécuter un LLM sur PC ou serveur GPU.

Les avantages sont clairs :

- Confidentialité : vos prompts et données restent en interne.

- Réactivité : absence de latence réseau, idéal pour des usages interactifs.

- Maîtrise des coûts : pas d’abonnements ni de facturation à la requête.

- Personnalisation : possibilité d’ajouter du RAG (Retrieval-Augmented Generation), du fine-tuning ou des prompts systèmes adaptés à votre contexte.

- Optimisation matérielle : exploiter pleinement un GPU puissant comme une RTX 4090, une RTX 5090 ou encore une carte professionnelle (Quadro, A100, H100 …).

Présentation générale : Ollama vs vLLM

Ollama : la simplicité avant tout

Ollama s’est imposé comme la solution la plus accessible pour découvrir l’inférence LLM locale.

- Installation rapide sur Windows, macOS et Linux.

- Hub de modèles intégré avec des versions prêtes à l’emploi (LLaMA, Mistral, Qwen, Gemma, DeepSeek…).

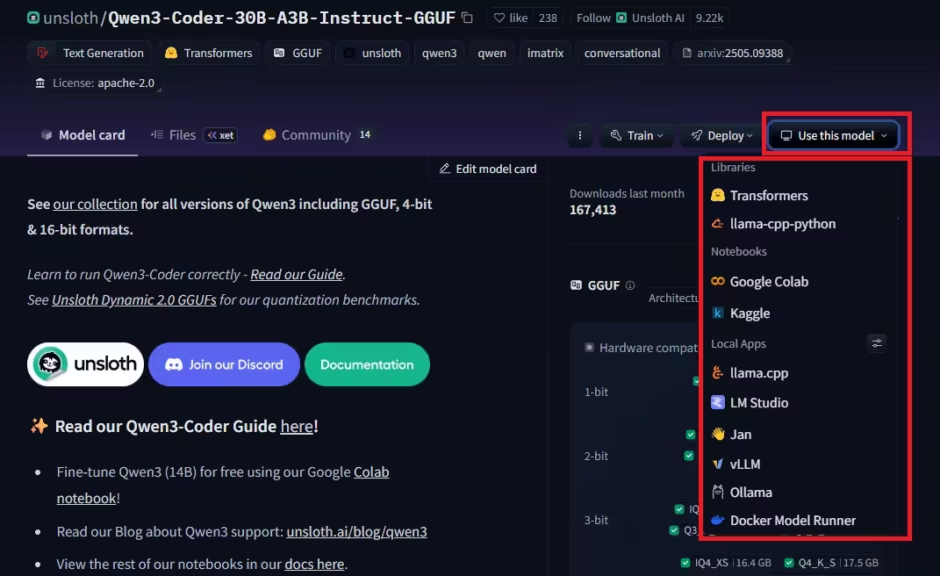

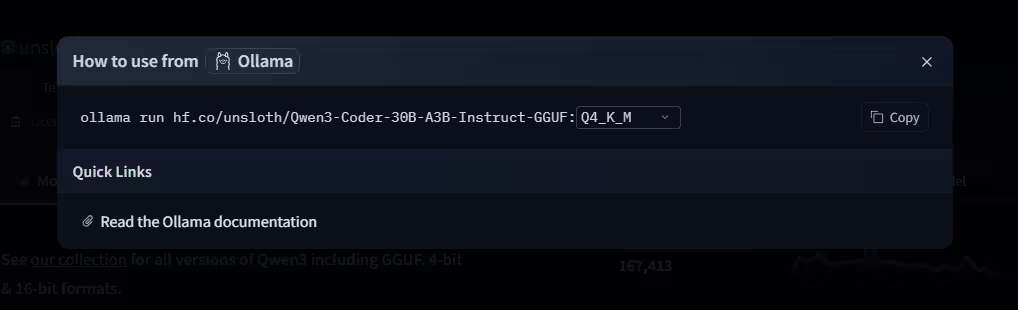

- Compatibilité avec les formats GGUF, la quantification dynamique d’Unsloth est supportée. Par défaut, vous obtiendrez des modèles quantifiés en Q4 issu de la bibliothèque d’Ollama. Toutefois il est possible de récupérer des modèles directement sur Hugging Face, comme les modèles d’Unsloth. L’interface d’Hugging Face affiche les commandes pour utiliser les modèles dans Ollama et autres outils

- Support CPU et GPU (NVIDIA, AMD, Apple Silicon).

- Compatibilité API OpenAI, facilitant l’intégration dans Open WebUI, LangChain ou vos scripts Python.

Mais cette simplicité a un prix :

- Par défaut, Ollama privilégie le format quantifié Q4_K_M. Résultat : plus facile à lancer, mais perte de précision par rapport au FP16/BF16.

- Difficile de saturer une carte haut de gamme comme une RTX 5090 (32 Go VRAM). Même avec de gros modèles, Ollama ne tire pas pleinement parti du GPU. De plus, le serveur plafonne et la latence augmente rapidement, comme le montrent de nombreux retours sur Reddit ou Hacker News.

- Performances limitées dès qu’on dépasse une dizaine de connexions simultanées.

En clair : Ollama est idéal pour tester rapidement un modèle, travailler offline ou explorer l’écosystème LLM sans effort technique. Toutefois cette simplicité à un prix, la perte de précision.

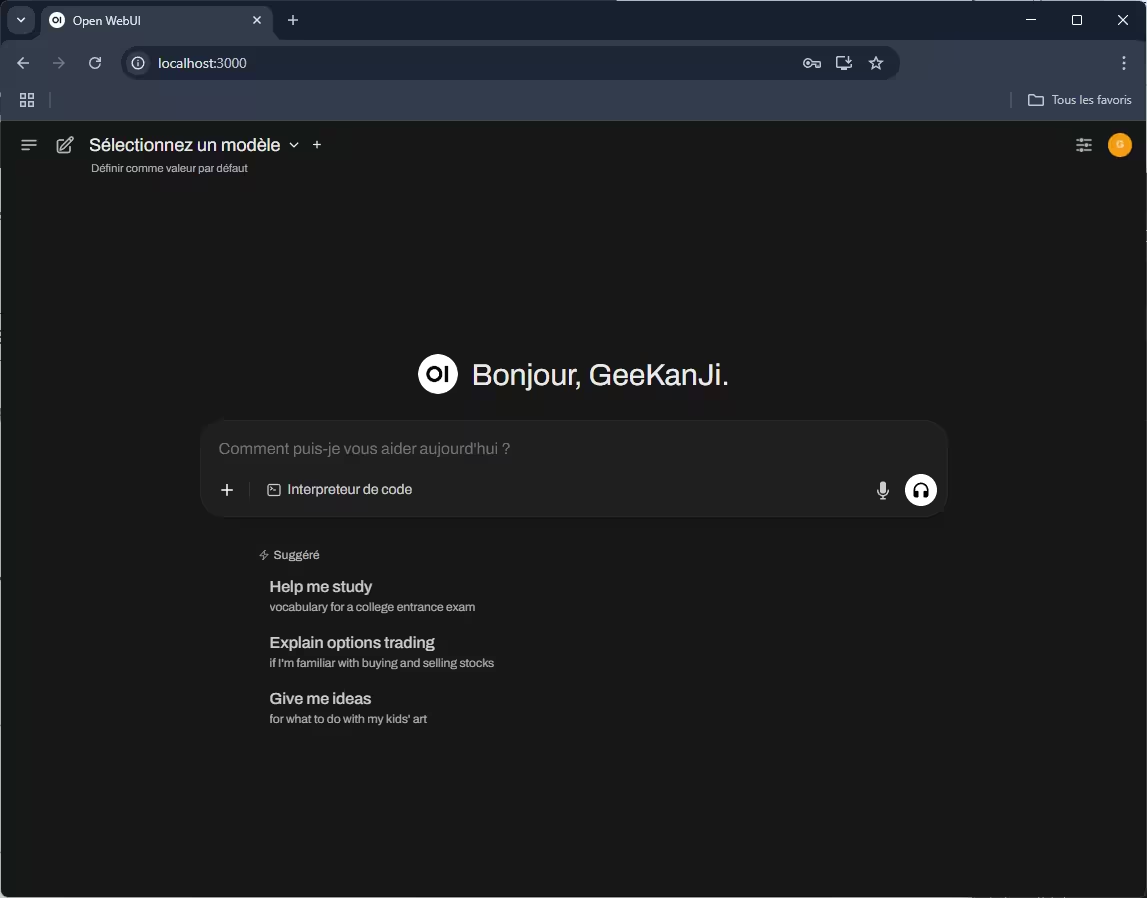

Si la ligne de commande n’est pas idéal, des solutions apportent une interface Web similaire à ChatGPT. Open WebUI est une de ces solutions et s’installe également très facilement.

Installation et prise en main

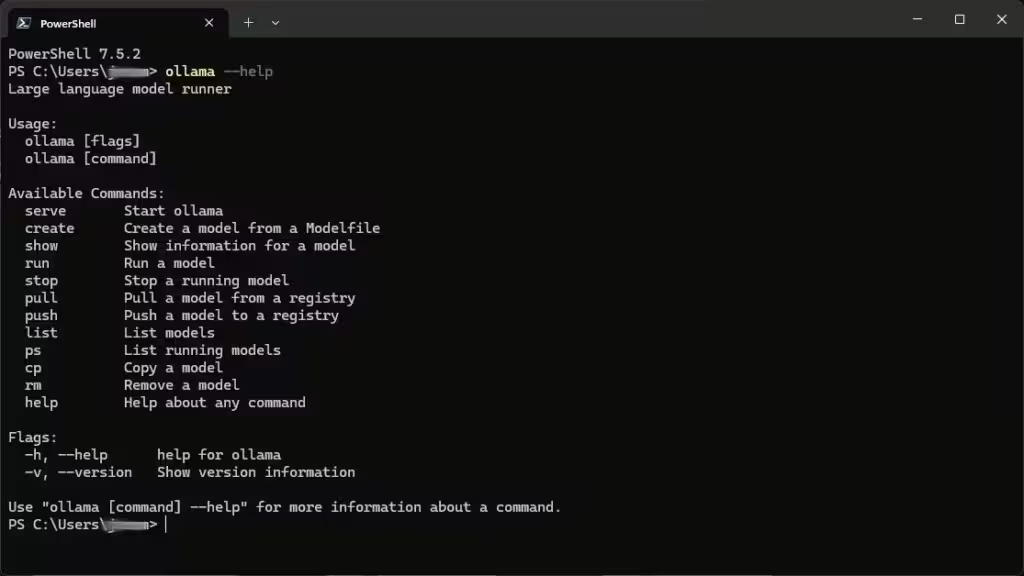

L’installation est accessible à tous : il suffit de télécharger Ollama depuis le site officiel, ou d’utiliser un gestionnaire de paquets, et de lancer une simple commande (ex : ollama run mistral). Tout est pensé pour masquer la complexité : Ollama télécharge, configure et sert le modèle, sans configuration avancée. Son interface en ligne de commande, volontairement minimaliste, permet de :

- Lister les modèles (ollama list)

- Identifier un modèle sur la page « Search » d’Ollama et télécharger. Les commandes sont indiquées sur la page du modèle.

- Lancer ou arrêter une instance

- Vérifier l’état du serveur

- Gérer plusieurs modèles localement

Comment utiliser les modèles d’Hugging Face avec Ollama ?

Comme nous l’avons vu par défaut, les modèles d’Ollama sont quantifiés en Q4, cela participe à l’accessibilité de la plateforme. Toutefois pour ceux qui souhaitent plus de précision et d’optimisation, il est possible de télécharger les modèles d’Hugging Face et de les faire tourner sur Ollama.

Pour simplifier le processus, Hugging Face propose une aide simple et rapide à mettre en place :

Vous n’avez plus qu’à coller la ligne de commande dans votre interface :

Voici une version optimisée SEO, reformulée pour un article :

Ollama et le support BF16 : une limitation importante

De nombreux utilisateurs se demandent si Ollama exécute réellement les modèles en BF16 lorsqu’ils lancent une commande comme :

ollama run hf.co/unsloth/Qwen3-30B-A3B-Instruct-2507-GGUF:BF16En pratique, Ollama télécharge bien le fichier BF16 (au format safetensors ou GGUF) depuis Hugging Face. Mais au moment de l’import, le pipeline interne applique une conversion automatique en FP16. Résultat : même si vous récupérez un modèle marqué BF16, l’inférence se fait toujours en FP16 dans Ollama.

Cela entraîne deux conséquences majeures :

- Pas d’exploitation du vrai support BF16 matériel présent sur les GPU récents (RTX 40xx, H100, etc.)

- Perte de l’intérêt du format BF16 en termes de rapport précision/VRAM, puisque les poids sont stockés et exécutés en FP16

Cette limitation est confirmée dans plusieurs discussions GitHub :

- Import BF16/FP32 converti automatiquement en FP16 (#9944)

- Exécution des modèles BF16 comme FP16 (#4670)

- Bug sur l’import des modèles BF16 GGUF (#9343)

Aujourd’hui, Ollama ne propose aucune option pour garder un modèle en BF16 natif. C’est une limitation à connaître si vous cherchez à profiter pleinement du support BF16 pour optimiser vos performances et la précision IA.

vLLM : la puissance pour les environnements professionnels

vLLM, de son côté, vise un tout autre public : développeurs exigeants, chercheurs et entreprises. C’est une solution penser pour le déploiement en production sur des serveurs, toutefois elle reste parfaitement adapté à une installation en locale.

- Optimisé pour CUDA : kernels GPU spécialisés, gestion mémoire avancée.

- Supporte Hugging Face Transformers (LLaMA, Mistral, Falcon, Qwen, Gemma, DeepSeek…), avec un chargement efficace en FP16 et BF16.

- Meilleure gestion des grands contextes (128k tokens et plus), ce qui ouvre la voie aux cas d’usage avancés.

- Throughput supérieur : capable de gérer des centaines voire des milliers de requêtes concurrentes.

- Multi-GPU et clustering via Ray : parfait pour les environnements à forte charge.

Mais vLLM n’est pas exempt de contraintes :

- Setup plus complexe (installation Linux ou Windows via WSL, Python, CUDA à jour).

- Réservé aux GPU NVIDIA : pas de support officiel pour l’inférence sur CPU, GPU AMD ou Apple Silicon.

- Consommation VRAM élevée par défaut (90 % du GPU alloués).

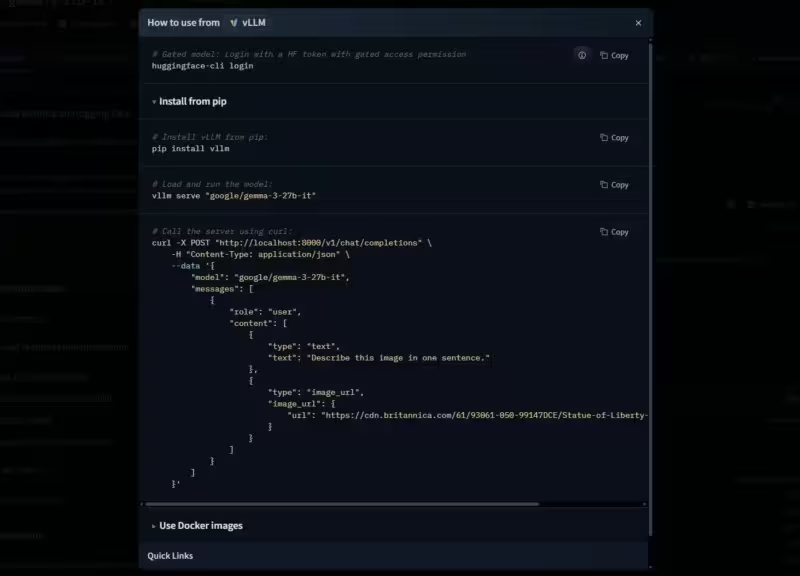

- Pas de hub de modèles intégré : l’utilisateur doit aller chercher les modèles sur HuggingFace. Pour simplifier le processus, Hugging Face fournit une aide pour installer le modèle avec vLLM et également d’autres solutions comme Ollama, Llama.cpp, LM Studio, Docker Model Runner …

En résumé : vLLM est la solution idéale pour exploiter au maximum une station GPU (RTX 4090/5090, A100, H100) et déployer des LLM en production. Dans le monde professionnel, c’est un outil utilisé dans des environnements de production, monter en compétence sur vLLM vous sera donc plus utile si vous êtes développeur / consultant ou ingénieur IA.

Exemple de workflow : télécharger un modèle HuggingFace, configurer vLLM pour utiliser deux GPU, brancher l’API sur une interface comme Open WebUI ou LangChain, et servir des centaines de requêtes en parallèle sans saturer la machine.

vLLM est le moteur sur-vitaminé à déployer quand l’autoroute est libre et qu’on veut vraiment passer à la vitesse supérieure.

Installation et configuration

Pour utiliser vLLM, il faut :

- Un environnement Linux ou WSL sur Windows

- Un environnement Python moderne (idéalement Python 3.10 ou 3.12)

- Au moins un GPU NVIDIA récent avec un driver CUDA à jour

- Installer vLLM via pip (pip install vllm) ou avec un gestionnaire comme UV (pour l’isolation d’environnements)

- Télécharger un modèle compatible (ex : Gemma, Mistral, Llama, DeepSeek …) sur HuggingFace, puis le servir avec une commande simple

vllm serve <nom_du_modèle> --host 127.0.0.1 --port 8000 - Ajuster les paramètres selon le matériel : multi-GPU, gestion VRAM (–gpu-memory-utilization), etc.

L’installation demande donc plus de maîtrise technique qu’Ollama, mais reste accessible à toute personne habituée à Python et à l’administration de serveurs IA.

Alternatives à Ollama et vLLM

Même si Ollama et vLLM dominent le marché de l’inférence LLM locale, d’autres backends méritent d’être mentionnés :

- Hugging Face Transformers : flexible, incontournable pour l’écosystème, mais plus lent et avec une scalabilité limitée sans backend optimisé.

- Text Generation Inference (TGI) : solution officielle de Hugging Face, taillée pour la production.

- TensorRT-LLM (NVIDIA) : ultra-optimisé pour CUDA, mais plus complexe à mettre en œuvre.

- LM Studio : alternative multiplateforme conviviale, orientée usage personnel.

Benchmarks Ollama vs vLLM : performance et latence

Pour bien comprendre la différence entre Ollama et vLLM en situation réelle, rien ne vaut un vrai benchmark, sur le même matériel et avec le même modèle. Cette approche a été détaillée par Robert McDermott. Il s’agit d’un test qui se concentre sur la latence, scalabilité et la performance. Toutefois il ne couvre pas la capacité de vLLM a faire des tourner des grands modèles tout en conservant leur précision, un critère clef même pour l’inférence en local.

Débit et scalabilité

- Ollama plafonne rapidement : environ 22 requêtes par seconde avec un modèle 14B sur GPU.

- vLLM continue de monter en charge et délivre jusqu’à 3,2x plus de requêtes par seconde avec 128 connexions simultanées.

Latence

- Ollama reste fluide pour quelques utilisateurs, mais la latence explose au-delà de 10-20 connexions.

- vLLM garde une latence basse même sous forte charge.

Utilisation VRAM

- Ollama exploite la VRAM de manière plus conservatrice, ce qui limite son efficacité sur GPU haut de gamme.

- vLLM alloue massivement la VRAM (paramétrable), ce qui maximise le throughput.

Stabilité

- Ollama peut devenir instable sur de longues sessions ou des usages intensifs.

- vLLM est largement reconnu pour sa robustesse en production.

Cas d’usage recommandés

Quand choisir Ollama ?

- Test rapide d’un modèle LLM.

- Usages personnels ou exploratoires (chatbot, résumé de texte, génération de contenu).

- Travaux offline sur portable, PC sans GPU, ou Mac M1/M2/M3.

- Scénarios où la simplicité prime sur la performance brute.

Quand choisir vLLM ?

- Déploiement en entreprise (API interne, chatbot d’équipe, SaaS).

- Conserver la précision des modèles

- Besoins de scalabilité avec des centaines d’utilisateurs.

- Exploitation optimale de cartes comme la RTX 5090 ou les GPU professionnels (A100, H100).

- Cas d’usage nécessitant grands contextes et stabilité longue durée.

Pour aller plus loin : Installer vLLM avec Docker Compose sur Linux (compatible Windows WSL2)

Synthèse comparative Ollama vs vLLM

| Critère | Ollama | vLLM |

|---|---|---|

| Installation | Simple, multiplateforme | Complexe, Linux/WSL |

| Matériel supporté | CPU, GPU NVIDIA/AMD, Apple Silicon | GPU NVIDIA uniquement |

| Performance | Très bon <10 users, plafonne vite | Scalabilité extrême (1000+ users) |

| Modèles | GGUF packagés Import possible d’Hugging Face | Hugging Face Transformers (safetensors, PyTorch) support partiel des GGUF |

| Précision | Quantifié Q4_K_M par défaut Import possible d’autres formats | FP16, BF16, quantifié |

| Gestion VRAM | Conservatrice | Optimisée (90 % VRAM) |

| Multi-GPU | Basique | Avancé (Ray, clustering) |

| Stabilité | Bonne en usage léger | Excellente en production |

| API | Compatible OpenAI | Compatible OpenAI |

| Cas d’usage | Tests, perso, petits projets, nombre d’utilisateurs limité | Production, SaaS, recherche |

Conclusion : Ollama vs vLLM, quelle solution choisir ?

Le duel Ollama vs vLLM illustre deux visions de l’inférence LLM locale.

- Ollama : l’outil grand public, simple, rapide, parfait pour découvrir et tester.

- vLLM : le moteur de course, pensé pour la performance, la présicion, la scalabilité et les environnements professionnels.

Si vous débutez ou cherchez un chatbot local facile à lancer, Ollama est imbattable. Si vous voulez exploiter au maximum un GPU haut de gamme, conserver la précision des grands modèles et/ou servir des centaines d’utilisateurs en parallèle, vLLM est la référence.

En pratique, le meilleur conseil reste de tester les deux solutions sur votre matériel et vos cas d’usage réels. Vous verrez rapidement si vos besoins sont mieux couverts par la simplicité d’Ollama ou la puissance de vLLM.

FAQ Ollama vs vLLM : réponses aux questions fréquentes

vLLM fonctionne-t-il sur Windows ou CPU ?

Non, vLLM fonctionne exclusivement sur Linux ou via WSL sous Windows, avec un ou plusieurs GPU NVIDIA CUDA. Il n’y a pas de support officiel pour MacOS, GPU AMD, Apple Silicon ni pour une exécution CPU-only. Pour un usage multiplateforme ou sans GPU, Ollama est la solution recommandée.

Ollama est-il limité aux modèles quantifiés ?

Oui, par défaut Ollama privilégie les modèles quantifiés (Q4_K_M, Q5, Q6) au format GGUF, pour réduire la consommation mémoire et tourner même sur des PC modestes. Cela permet de faire tourner un LLM de 7B ou 13B sur une simple carte grand public. En revanche, cela implique une perte de précision par rapport aux modèles FP16 ou BF16 utilisés par vLLM.

Peut-on utiliser plusieurs GPU avec Ollama ou vLLM ?

- Ollama supporte plusieurs GPU, mais le contrôle reste limité et peu transparent.

- vLLM, au contraire, gère nativement le multi-GPU et le clustering multi-node via Ray, avec des paramètres comme –tensor-parallel-size ou CUDA_VISIBLE_DEVICES. C’est un point fort pour la scalabilité en entreprise.

vLLM gère-t-il mieux les contextes longs qu’Ollama ?

Oui. vLLM prend en charge des context windows étendus (jusqu’à 128k tokens), un atout pour le RAG (Retrieval-Augmented Generation), l’analyse de documents longs ou les applications nécessitant beaucoup de contexte. Ollama, plus limité, reste efficace pour des prompts classiques mais n’offre pas la même profondeur contextuelle.

Quels sont les avantages de l’inférence locale par rapport au cloud ?

- Confidentialité : vos prompts et données restent dans votre infrastructure, sans fuite potentielle.

- Réactivité : pas de latence réseau ni dépendance à une connexion Internet.

- Maîtrise des coûts : une fois le matériel acquis (ex. RTX 5090), plus besoin de payer chaque requête comme avec une API cloud.

- Personnalisation : fine-tuning, prompts systèmes, intégration dans vos workflows internes.

Quelle solution choisir pour un usage professionnel ?

- Ollama : suffisant pour une petite équipe, des tests rapides ou des usages offline.

- vLLM : incontournable pour des environnements professionnels à grande échelle (SaaS, API interne, laboratoire de recherche, chatbot d’entreprise), grâce à sa stabilité et sa capacité à gérer des centaines d’utilisateurs en parallèle.

Peut-on intégrer Ollama et vLLM avec Open WebUI ou d’autres interfaces ?

Oui, les deux exposent une API compatible OpenAI. Cela signifie qu’ils peuvent être utilisés avec Open WebUI, LangChain, des scripts Python ou même des applications no-code. Il suffit de changer l’URL de l’API pour basculer d’un backend à l’autre.

Comment limiter la consommation VRAM avec vLLM ?

Lors du lancement, il est possible de régler l’utilisation mémoire GPU avec l’option :

--gpu-memory-utilization 0.5Cela permet de limiter vLLM à 50 % de la VRAM, pratique pour conserver des ressources pour d’autres applications.

Faut-il choisir FP16, BF16 ou un modèle quantifié ?

- FP16/BF16 : meilleure qualité de génération, mais exige beaucoup de VRAM

- Quantifié (Q4/Q5/Q6) : permet de lancer des modèles plus lourds sur des GPU plus modestes, au prix d’une légère perte de qualité. Ollama propose de nombreux modèles quantifiés packagés, vLLM est plus orienté FP16/BF16.

Quelle licence pour Ollama et vLLM ?

Les deux sont open source, sous licence permissive (MIT ou équivalent). Attention cependant : la licence d’usage dépend du modèle LLM lui-même (par exemple, LLaMA 3 est soumis à des restrictions d’utilisation).

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !