Open Sora 2.0 : le modèle open source qui dépasse Sora d’OpenAI

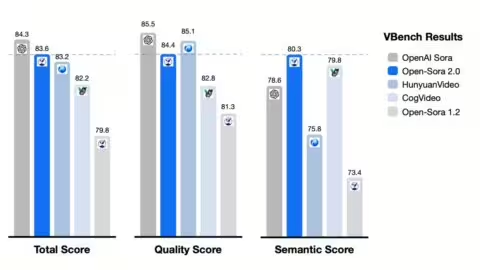

Open-Sora 2.0 s’impose comme une alternative crédible aux modèles propriétaires dans le domaine de la génération vidéo par IA. Selon les résultats du benchmark VBench, il dépasse Sora d’OpenAI sur plusieurs critères clés, notamment la fidélité au prompt, la fluidité du mouvement et la qualité visuelle.

Un modèle unique pour le T2V et I2V

Contrairement à d’autres approches segmentées, Open-Sora 2.0 intègre dans un même modèle (11B) :

- La génération de vidéos à partir de texte (Text-to-Video),

- La conversion d’image en vidéo (Image-to-Video),

- Le Prompt Refine pour ajuster les résultats à partir d’un prompt initial,

- Une reproductibilité visuelle entre deux générations, assurant une cohérence spatio-temporelle.

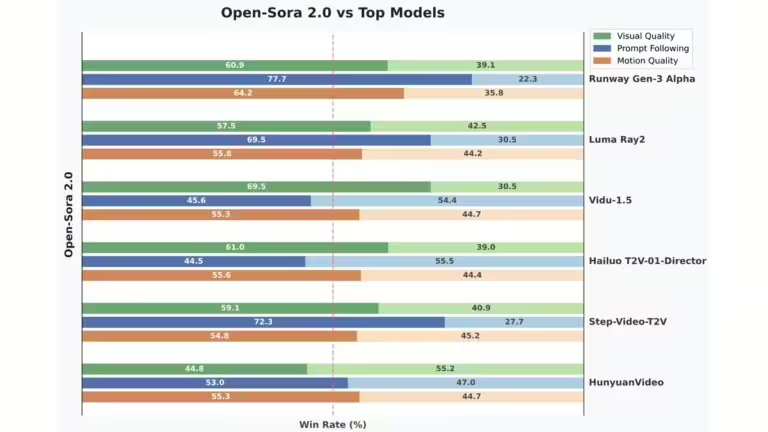

Performances face aux meilleurs modèles

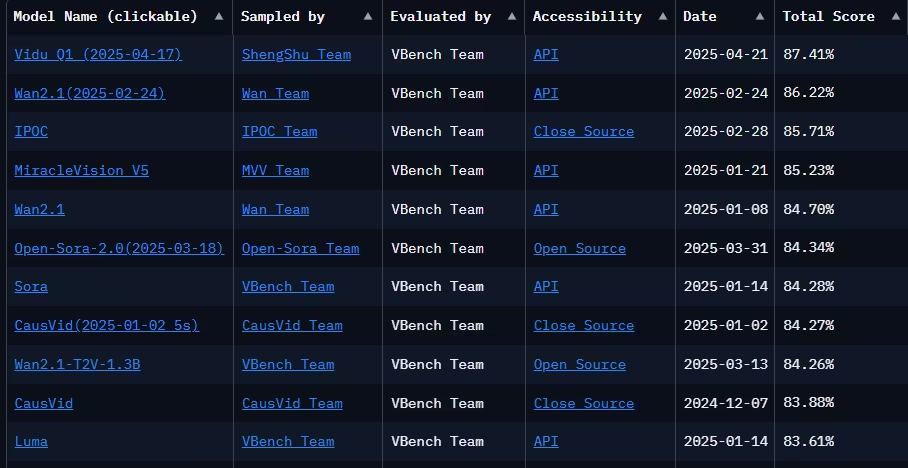

Le graphe suivant (issu du benchmark VBench) compare les performances d’Open-Sora 2.0 avec les meilleurs modèles du moment :

- Il surclasse Runway Gen-3 Alpha, Luma Ray2, Hailuo T2V, Vidu-1.5 ou encore HunyuanVideo dans plusieurs catégories.

Notamment :

- Fidélité au prompt : 77.7 % contre 22.3 % pour Runway Gen-3 Alpha

- Qualité visuelle : 60.9 % contre 39.1 %

- Qualité du mouvement : 64.2 % contre 35.8 %

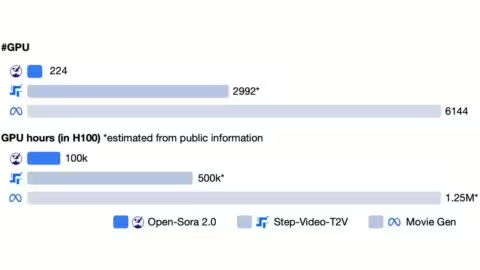

Des performances obtenues avec peu de ressources

Un autre aspect impressionnant est l’efficacité du modèle. Open-Sora a été entraîné avec seulement :

- 224 GPU H100,

- 100 000 heures GPU estimées.

C’est très inférieur aux ressources utilisées par ses concurrents :

- Step-Video-T2V : 2992 GPU / 500k GPUh,

- Movie Gen (Meta) : 6144 GPU / 1.25M GPUh.

Cela montre l’optimisation du modèle et la puissance des approches open source bien structurées.

Un modèle open source, mais exigeant

Bien que le projet soit librement accessible sur Github, l’inférence reste coûteuse :

- Une vidéo en 768×768 pixels prend 27,6 minutes à générer sur une seule H100 (1656 s),

- Le temps peut être réduit à 4,6 minutes avec 8 GPU (276 s).

| Résolution | 1 GPU | 2 GPU | 4 GPU | 8 GPU |

|---|---|---|---|---|

| 256×256 | 60 s | 40 s | 34 s | – |

| 768×768 | 1656 s | 863 s | 466 s | 276 s |

Résultats détaillés du VBench

D’après les données du benchmark (mars 2025), Open-Sora 2.0 obtient un score global de 84,34 %, supérieur à Sora (84,28 %) et proche des meilleurs modèles propriétaires :

Avec des scores très compétitifs sur :

- subject consistency : 97.71 %

- motion smoothness : 94.50 %

- imaging quality : 95.40 %

Conclusion : une nouvelle ère pour la vidéo générée par IA

Open-Sora 2.0 démontre qu’un modèle open source peut rivaliser, voire surpasser, les solutions des géants du secteur. S’il reste gourmand en ressources pour l’inférence, son efficacité à l’entraînement, sa transparence, et ses capacités en font un véritable tournant pour l’écosystème IA vidéo. Pour évaluer les résultats des vidéos, je vous invite à consulter la page de démonstration d’Open Sora. Vous y trouverez de nombreuses vidéo pour illustrer ses capacités.

Cette avancée soulève aussi une question stratégique : OpenAI peut-elle encore tenir son avance sans revoir son approche ? Entre le coût massif d’entraînement, les coûts d’inférence souvent élevés et l’accessibilité limitée, la pression monte sur Open AI. Face à des alternatives comme Open-Sora, plus légères, ouvertes et compétitives, la supériorité des modèles propriétaires n’est plus une évidence.

Pour une utilisation local avec moins de ressources, des projets comme FramePack reste à privilégier, capable de tourner sur une simple carte graphique avec 6 Go de VRAM.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !