Pénurie de GPU : pourquoi les data centers tournent au ralenti en 2025

En 2025, les géants du cloud se heurtent à une pénurie de GPU qui ralentit l’ensemble de l’écosystème IA, des startups aux entreprises les plus avancées. Les files d’attente, les quotas et les retards de mise en production témoignent d’une crise d’infrastructure sans précédent. Pourquoi les data centers manquent-ils de GPU ? Ce que cela implique pour les organisations et quelles solutions permettent de limiter l’impact aujourd’hui.

Retrouvez les dernières actualités de la semaine en cours sur notre page principale, mise à jour régulièrement

Réponse rapide : pourquoi il n’y a plus de GPU en 2025 ?

La pénurie GPU dans les data centers résulte d’un déséquilibre structurel entre une demande explosive en accélérateurs IA et une capacité de production qui ne suit plus. Les GPU haut de gamme comme les Nvidia H100, H200 et Blackwell nécessitent un packaging avancé rare, ce qui limite mécaniquement les volumes disponibles. Les hyperscalers, confrontés à des files d’attente de plusieurs mois, rationnent l’accès aux accélérateurs et priorisent leurs plus gros clients. Dans le même temps, les modèles IA de très grande échelle, comme Gemini 3 Pro ou GPT 5.1 Codex Max, accentuent cette pression en exigeant de vastes ressources pour l’entraînement et l’inférence. Le résultat est une véritable “compute famine”, où la puissance de calcul devient une ressource rare et stratégique.

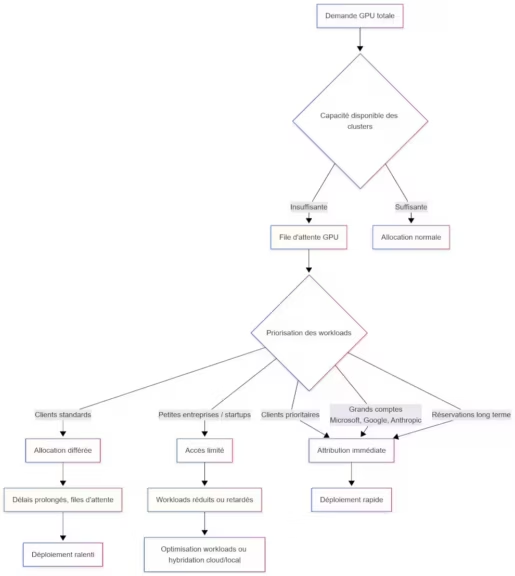

Les files d’attente record chez les hyperscalers (Azure, AWS, Google)

Les clouds publics font face à une saturation généralisée. Les entreprises doivent réserver leurs GPU très en amont, parfois avant même l’ouverture de nouveaux data centers. Les délais varient fortement selon les régions et les capacités disponibles, ce qui complique la planification des projets IA. Cette congestion entraîne une priorisation forcée des workloads et réduit la flexibilité des équipes techniques.

(Cliquez pour agrandir)

Blackwell et H100 : demande supérieure à la capacité de production

Les accélérateurs Nvidia dominent le marché, mais leur production repose sur un assemblage avancé limité et coûteux. Même avec des efforts d’expansion, les chaînes CoWoS* ne peuvent absorber la demande générée par les modèles IA actuels. Les GPU haut de gamme deviennent alors des ressources disputées, entraînant une inflation des délais et une instabilité dans l’approvisionnement.

*Une chaîne CoWoS désigne l’ensemble des étapes industrielles nécessaires au packaging avancé d’un GPU ou d’une puce IA utilisant la technologie TSMC CoWoS, acronyme de Chip-on-Wafer-on-Substrate. C’est l’étape la plus critique dans la fabrication des GPU H100, H200, Blackwell et de nombreux accélérateurs IA modernes.

Les causes industrielles de la pénurie GPU

La crise GPU de 2025 ne trouve pas son origine dans un événement isolé mais dans une accumulation de contraintes industrielles. Les technologies nécessaires à la production des GPU IA modernes sont complexes, coûteuses et difficiles à étendre rapidement. À cela s’ajoute une croissance sans précédent de la demande en puissance de calcul, alimentée par l’adoption massive de l’IA générative et multimodale.

Le goulet d’étranglement CoWoS chez TSMC

CoWoS, la technologie de packaging essentielle aux GPU IA, constitue l’un des points les plus critiques de la chaîne de fabrication. Elle permet d’intégrer des piles de mémoire HBM au plus près des puces, mais son processus est lent et nécessite des capacités limitées que peu d’acteurs maîtrisent. Les commandes passées par les géants de l’IA saturent les lignes disponibles, empêchant toute montée en puissance rapide.

HBM et packaging avancé : pénurie des composants critiques

La mémoire HBM, indispensable à la performance des GPU IA, manque elle aussi. Les fournisseurs doivent faire face à une explosion de la demande sans pouvoir augmenter immédiatement leurs volumes. Les yields restent complexes à stabiliser, et la combinaison HBM plus packaging avancé ralentit encore la production. Sans HBM, aucun GPU AI haut de gamme ne peut être finalisé

Explosion des modèles IA (Gemini 3, GPT 5.1, ERNIE 5.0)

Les modèles IA récents requièrent des quantités massives de compute. Gemini 3 Pro exploite un contexte d’un million de tokens, ERNIE 5.0 multiplie les capacités multimodales, tandis que GPT 5.1 Codex Max gère des workflows complexes sur de longues durées. Ces évolutions font grimper les besoins en GPU, tant pour l’entraînement que pour l’inférence. Les infrastructures, déjà sous tension, ne parviennent plus à absorber cette charge.

| Année | Modèle IA | Paramètres (approx.) | Contexte / capacité | Impact sur la demande GPU |

|---|---|---|---|---|

| 2020 | GPT-3 | 175 milliards | Contexte court, inference légère | Début de la montée en charge GPU |

| 2021 | Megatron-Turing NLG | 530 milliards | Modèle massif mais peu déployé | Charge GPU surtout sur entraînement |

| 2022 | PaLM | 540 milliards | Raisonnement amélioré | Infrastructure GPU encore suffisante |

| 2023 | LLaMA 2, GPT-4 | 70B → 1T (estimé) | Premiers usages généralisés | Début de tension sur clusters |

| 2024 | Gemini 1.5, Mixtral, LLaMA 3 | 70B → 1,5T | Contextes très longs (→ compute) | Hausse marquée de la demande H100 |

| 2025 | Gemini 3 Pro, ERNIE 5.0, GPT-5.1 | 1T → multi-trillion | Multimodalité avancée, contexte 1M tokens | Saturation compute, files d’attente hyperscalers |

Comment la pénurie paralyse les géants du cloud

La saturation des GPU dans les data centers touche directement les clouds publics. Malgré l’ouverture de nouveaux sites et l’achat massif d’accélérateurs, les capacités disponibles restent insuffisantes pour répondre à l’usage intensif de l’IA générative et des modèles à très longue portée. Les hyperscalers doivent adapter leurs opérations, instaurer des quotas et réviser leurs priorités afin de gérer un compute devenu rare et stratégique.

Quotas, rationnement et retards de déploiement

Les clouds ont instauré des règles d’allocation strictes afin d’éviter la surcharge totale de leurs clusters. Les entreprises doivent parfois réserver leurs GPU plusieurs semaines à l’avance, ce qui retarde les phases de test, d’entraînement ou de mise en production. Dans certaines régions, les délais peuvent doubler selon la disponibilité locale et la pression sur la demande. Ces contraintes modifient en profondeur la planification des projets IA et obligent les équipes techniques à revoir leurs cycles de développement.

Priorité aux très grands comptes (Microsoft, Anthropic, Google)

Les hyperscalers accordent leur priorité aux organisations capables de réserver des volumes importants sur plusieurs mois. Microsoft, Google et plusieurs laboratoires IA figurent parmi les premiers clients servis, grâce à des engagements contractuels majeurs. Cette priorisation crée une asymétrie importante pour les entreprises de taille moyenne, qui doivent composer avec des files d’attente plus longues et une disponibilité plus incertaine.

Impact sur l’inférence et les cycles de mise en production IA

L’inférence, essentielle pour les applications de production, subit elle aussi les effets de la saturation. Lorsque les clusters sont trop sollicités, les latences augmentent, ce qui affecte la réactivité des services alimentés par l’IA. Les équipes doivent parfois réduire la fréquence des mises à jour de modèles, limiter certains scénarios temps réel ou décaler des déploiements pour éviter les pics de charge.

Les conséquences pour les entreprises et projets IA

Les tensions sur la disponibilité GPU ont un impact direct sur les entreprises qui développent ou exploitent des outils d’IA. Les coûts augmentent, les performances deviennent moins prévisibles et les cycles d’innovation ralentissent. Les organisations doivent ajuster leurs priorités et parfois revoir leurs architectures pour compenser la rareté du compute.

Coûts en hausse et délais multipliés

La demande élevée et la disponibilité limitée entraînent une augmentation significative des coûts. Certains GPU facturés à l’heure voient leurs tarifs monter en fonction des régions ou des périodes de forte demande. Cette hausse, combinée à des délais de provisioning plus longs, impacte la maîtrise des budgets et complique la prévision des charges de travail.

| Type de ressource GPU IA | 2023 (estimé) | 2025 (estimé, basé sur tendances et reports) | Évolution 2023 → 2025 |

|---|---|---|---|

| Location H100 (cloud, /h) | 3,00 à 4,00 USD/h | 6,50 à 9,00 USD/h | ×2 à ×2,5 (pénurie + demande IA) |

| Location H100 multi-GPU (cluster 8× / h) | 25 à 32 USD/h | 55 à 75 USD/h | ×2 à ×3 |

| Location A100 (cloud, /h) | 1,80 à 2,50 USD/h | 3,50 à 5,00 USD/h | ×1,5 à ×2 |

| Achat GPU H100 | ~30 000 USD | 45 000 à 60 000 USD (marché saturé) | +50 % à +100 % |

| Achat GPU A100 | ~12 000–15 000 USD | ~20 000 USD (prix secondaire) | +30 % à +60 % |

| Coût slot datacenter (H100 dédié) | ~2 500 USD/mois | 5 000 à 7 000 USD/mois | ×2 à ×3 |

| Provisioning moyen (délai) | 3–7 jours | 30–90 jours | ×10 à ×20 (files d’attente) |

| Prix spot H100/H200 | Stable | En forte hausse (hausse continue 2024–2025) | Marché tendu |

Baisse des performances dans les environnements saturés

Les clusters surchargés entraînent des ralentissements. Les tâches d’entraînement peuvent prendre plus de temps, et les services d’inférence peuvent présenter des latences irrégulières. Ces variations poussent certaines organisations à revoir la répartition de leurs workloads ou à privilégier des infrastructures hybrides pour garantir une performance plus stable.

Impact sur l’innovation : entraînement ralenti, tests limités

Lorsque la disponibilité GPU est insuffisante, les équipes R&D doivent limiter leurs expérimentations. Les itérations rapides deviennent plus rares, ce qui freine le développement de nouvelles fonctionnalités IA. Les projets nécessitant un entraînement intensif voient leurs délais allongés, ce qui réduit la capacité des entreprises à innover à un rythme soutenu.

Quelles solutions pour survivre à la pénurie GPU ?

Même si la crise GPU est structurelle, plusieurs stratégies concrètes permettent d’en atténuer les effets. Elles consistent à optimiser la consommation, diversifier les architectures et tirer parti d’approches hybrides pour réduire la pression sur les ressources cloud.

Optimiser les workloads : quantification, sparsité, batching

La quantification en 8 bits ou 4 bits, les techniques de sparsité et les stratégies de batching réduisent la consommation en mémoire et en calcul. Ces approches permettent d’exécuter davantage de requêtes sur des GPU plus accessibles ou de mieux exploiter les ressources allouées. Les bibliothèques modernes facilitent désormais ces optimisations, ce qui permet de diminuer les besoins en compute sans dégrader fortement la qualité des résultats.

Déployer en hybride : cloud + GPU local

Les architectures hybrides permettent d’amortir la pénurie en répartissant les workloads entre les infrastructures internes et le cloud. Les entreprises peuvent entraîner des modèles de plus petite taille localement ou exécuter certaines étapes d’inférence en interne, tout en réservant les GPU cloud pour des tâches intensives. Cette flexibilité permet de réduire les délais et de mieux contrôler les coûts.

Explorer les alternatives : TPU, FPGA, modèles open-weight optimisés

Lorsque les GPU sont rares, les alternatives gagnent en pertinence. Les TPU peuvent offrir des performances compétitives selon les modèles utilisés, tandis que les FPGA permettent d’accélérer des tâches spécifiques grâce à leur flexibilité architecturale. Les modèles open-weight optimisés, plus légers que certains modèles propriétaires, réduisent aussi la pression sur le compute.

| Technologie | Points forts | Limites | Cas d’usage typiques |

|---|---|---|---|

| GPU | Très polyvalents, excellentes perfs pour l’entraînement et l’inférence, écosystème riche | Consommation élevée, forte demande donc coûts en hausse | Entraînement LLM, vision, multimodal, IA générative |

| TPU | Optimisés pour le calcul matriciel, efficacité énergétique, performances élevées pour le deep learning | Spécifiques Google, moins flexibles, disponibilité limitée hors cloud | Entraînement massif, production sur Google Cloud |

| FPGA | Latence très faible, haute efficacité énergétique, reconfigurables matériellement | Programmation complexe, performances brutes inférieures aux GPU pour l’IA moderne | Inférence embarquée, edge AI, workloads déterministes |

Jusqu’à quand la pénurie va-t-elle durer ?

La tension sur les GPU devrait persister au moins jusqu’en 2026. L’augmentation des capacités de production se fera progressivement et ne suffira pas immédiatement à rattraper la demande accumulée. La croissance continue des applications IA, combinée aux contraintes du packaging avancé, signifie que la situation restera tendue pendant plusieurs trimestres.

Capacité CoWoS et production Blackwell en 2025–2026

Les extensions des capacités CoWoS chez les fabricants devraient commencer à produire des effets à partir de 2025, mais la demande reste largement supérieure. Les GPU de nouvelle génération comme Blackwell nécessitent encore davantage de packaging avancé, ce qui prolonge la tension sur la chaîne d’approvisionnement. Les commandes déjà en file d’attente limitent aussi la disponibilité immédiate.

Nouveaux data centers et priorités géopolitiques

Les hyperscalers investissent dans de nouveaux sites, mais la construction, l’équipement et la mise en service prennent du temps. À cela s’ajoutent les tensions géopolitiques autour des exportations de technologies avancées, qui influencent la répartition mondiale des GPU. Certaines régions prioritaires absorberont la majorité des premiers lots disponibles, laissant les autres, notamment l’Europe, dans une situation plus prolongée.

Ce qu’il faut retenir

La pénurie de GPU qui ralentit les data centers en 2025 résulte d’un ensemble de contraintes industrielles, d’une dépendance accrue au packaging avancé et de la montée fulgurante des modèles IA. Les clouds publics doivent composer avec une demande qui dépasse leurs capacités, ce qui se traduit par des retards, des coûts en hausse et une baisse de performance. Pourtant, des solutions existent, qu’il s’agisse d’optimiser les workloads, de déployer des architectures hybrides ou d’explorer des alternatives au GPU. Alors que les capacités de production augmenteront progressivement d’ici 2026, la puissance de calcul restera un atout stratégique et un facteur de compétitivité déterminant pour les organisations capables d’anticiper et de s’adapter.

A lire également : DFloat11, la compression lossless qui allège les modèles IA malgré la pénurie de GPU

Sources et références

Médias technologiques

- CNN, 19 novembre 2025, hausse record de la demande GPU et tensions sur l’offre, https://edition.cnn.com/2025/11/19/tech/nvidia-earnings-ai-bubble-fears

- The Wall Street Journal (mentionné dans A1), résultats Nvidia et demande Blackwell supérieure à l’offre, https://www.wsj.com/tech/ai/nvidia-earnings-q3-2025-nvda-stock-9c6a40fe

- TechCrunch, 18 novembre 2025, montée en puissance des workloads IA (Gemini 3 Pro), contribuant à la demande compute, https://techcrunch.com/2025/11/18/google-launches-gemini-3-with-new-coding-app-and-record-benchmark-scores/

Entreprises

- Microsoft Blog, 18 novembre 2025, partenariat stratégique avec Nvidia et Anthropic incluant l’accès à un gigawatt de compute Blackwell et Vera Rubin, illustrant la tension sur l’approvisionnement, https://blogs.microsoft.com/blog/2025/11/18/microsoft-nvidia-and-anthropic-announce-strategic-partnerships/

- Anthropic, intégration Claude dans Microsoft Foundry, décrivant la dépendance croissante aux GPU haut de gamme, https://www.anthropic.com/news/claude-in-microsoft-foundry

- OpenAI, présentation GPT-5.1 Codex Max, montrant la croissance des workloads nécessitant davantage de GPU, https://openai.com/index/gpt-5-1-codex-max/

Sources officielles

- Nvidia, données financières et pression sur les GPU data center (via WSJ et CNN), https://www.nvidia.com

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !