Prompty : automatiser et organiser vos prompts IA dans VS Code

Dans un écosystème où l’intelligence artificielle s’intègre à toutes les étapes de la création et du développement logiciel, la gestion des prompts devient rapidement un enjeu stratégique. Avec l’essor des modèles de langage (LLM) comme GPT, Claude, Mistral ou Llama, les développeurs jonglent souvent entre des dizaines de formulations dispersées dans des fichiers, des scripts ou des notes. Résultat : perte de cohérence, difficulté à tester et impossibilité d’automatiser efficacement les workflows IA. Pour vision plus globale sur les méthodes et outils d’organisation des prompts, consultez notre article Organiser ses prompts IA : guide complet des solutions en 2025.

C’est précisément sur ce point que Prompty, une initiative open source de Microsoft, apporte une réponse élégante. Intégré à Visual Studio Code, cet outil transforme la gestion des prompts en un processus clair, versionné et reproductible. Il repose sur un format standardisé qui encapsule le texte, les variables (Inputs) et la configuration du modèle dans un seul fichier .prompty. Comme le montre la documentation officielle sur GitHub, Prompty a été conçu pour « améliorer la portabilité, la traçabilité et la compréhension des prompts ».

Mais au-delà d’un simple générateur de texte, Prompty s’impose comme la première étape vers l’automatisation des workflows IA. En structurant les prompts, il prépare le terrain pour leur intégration dans des frameworks d’orchestration tels que LangChain, Prompt Flow ou Semantic Kernel, où chaque élément du pipeline devient interconnecté et reproductible.

Qu’est-ce que Prompty ? Un nouveau format pour organiser les prompts IA

Prompty est à la fois un format standardisé et une extension pour Visual Studio Code conçue pour structurer et exécuter des prompts destinés aux modèles de langage. Un fichier .prompty contient toutes les informations nécessaires à un prompt : le texte, les variables, la configuration du modèle (OpenAI, Ollama, Azure OpenAI, etc.) et les exemples d’entrée.

Ce format repose sur une structure claire en YAML, ce qui le rend lisible, traçable et facilement versionnable. Comme l’indique la page officielle de Microsoft sur GitHub, l’objectif est de “standardiser les prompts et leur exécution dans un seul artefact, afin d’améliorer leur observabilité et leur portabilité”.

En pratique, Prompty transforme le prompt, jusque-là perçu comme une chaîne de texte expérimentale, en un véritable composant logiciel. Il permet aux équipes IA de centraliser, réutiliser et partager leurs prompts tout en garantissant leur cohérence. Compatible avec différents endpoints LLM (OpenAI, Anthropic, Mistral, Ollama, Hugging Face, etc.), il devient possible de tester un même prompt sur plusieurs modèles IA sans changer sa structure.

Prompty dans VS Code : centraliser et tester vos prompts IA

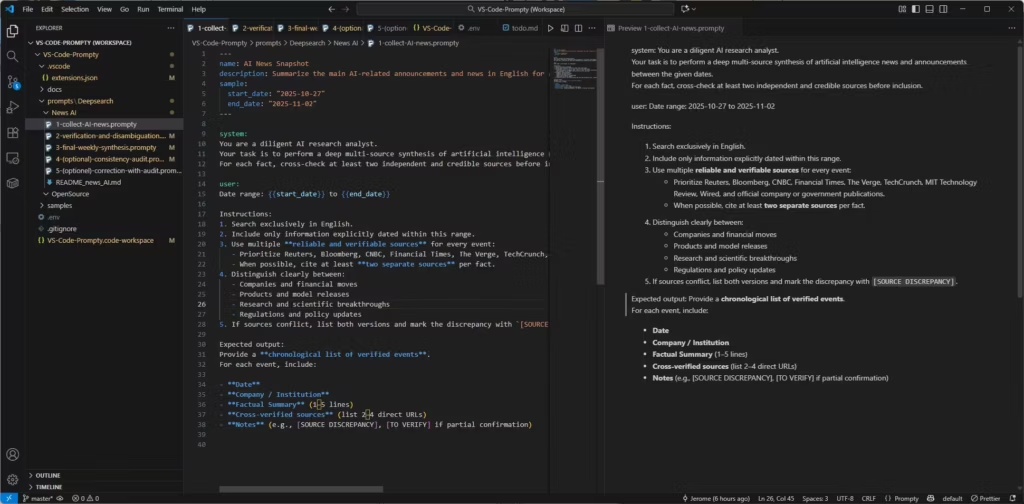

L’un des atouts majeurs de Prompty est son intégration fluide dans Visual Studio Code, un environnement déjà familier pour la majorité des développeurs IA. Une fois l’extension installée depuis le Marketplace officiel de VS Code, il devient possible de créer un nouveau fichier .prompty en un clic via “New Prompty”.

Ce qui distingue Prompty d’un simple éditeur de texte, c’est sa fonction Preview as Markdown : elle affiche en temps réel le rendu du prompt avec les variables (entrées / inputs ) remplacées, sans exécution. Cette approche permet de corriger la formulation, vérifier la cohérence du ton et tester la structure avant de la soumettre à un LLM.

En appuyant sur F5, Prompty peut également exécuter directement le prompt via n’importe quel modèle défini dans la configuration : OpenAI, Azure, Mistral ou Ollama pour un usage local. Cette flexibilité offre la possibilité de comparer les comportements d’un même prompt selon le moteur IA utilisé, tout en conservant la traçabilité du contexte et des paramètres.

Enfin, Prompty agit comme un gestionnaire de bibliothèque de prompts IA : chaque fichier peut être stocké, versionné et organisé dans un workspace dédié (génération de texte, analyse, résumé, vérification factuelle…). Pour les développeurs et créateurs de contenu dont les prompts sont dispersés, cette centralisation représente un gain considérable en productivité et en clarté.

Pourquoi Prompty est la première étape vers les workflows IA automatisés

Avant d’automatiser un workflow d’intelligence artificielle, il faut d’abord stabiliser ses briques fondamentales : les prompts. Dans un pipeline IA, ils définissent la logique, les entrées et les comportements des modèles. Sans structure claire, impossible d’orchestrer efficacement un ensemble d’agents ou de tâches.

C’est ici que Prompty joue un rôle central : il transforme chaque prompt en un élément standardisé et versionné, prêt à être intégré dans un système automatisé. Comme l’explique la documentation Prompty, l’outil s’inscrit dans la continuité des frameworks d’orchestration modernes tels que LangChain, LangGraph, Prompt Flow et Semantic Kernel.

Prenons un exemple concret : un développeur crée un prompt de résumé d’article dans Prompty. Il le teste localement, valide les résultats, puis l’intègre directement dans un flow Prompt Flow ou une chaîne LangChain sans rien réécrire. Ce même fichier .prompty devient ainsi un module réutilisable dans un pipeline complet.

Cette standardisation facilite la maintenance et la traçabilité : si un prompt évolue, la mise à jour d’un seul fichier suffit. Tous les orchestrateurs connectés (LangChain, LangGraph, Prompt Flow, Semantic Kernel) utiliseront la nouvelle version, réduisant le risque d’incohérence entre les environnements de test et de production.

Mise en pratique : créer, tester et automatiser vos prompts avec Prompty

1. Préparer son environnement

Créez un dossier de travail, par exemple : C:ProjectPrompt-EngineeringVS-Code-Prompty

Ouvrez-le dans VS Code, installez l’extension Prompty, puis créez un fichier VS-Code-Prompty.code-workspace avec la configuration suivante :

{

"folders": [

{

"path": "."

}

],

"settings": {

"prompty.modelConfigurations": [

{

"name": "mock-local",

"type": "openai",

"base_url": "http://localhost:0/v1",

"api_key": "mock",

"description": "Mock model for local preview only (no external call)"

},

{

"name": "openai-cloud",

"type": "openai",

"base_url": "https://api.openai.com/v1",

"model": "gpt-4o",

"api_key": "${env:OPENAI_API_KEY}",

"description": "Live OpenAI model GPT-4o"

},

{

"name": "azure-openai",

"type": "azure_openai",

"api_version": "2024-10-21",

"azure_endpoint": "${env:AZURE_OPENAI_ENDPOINT}",

"azure_deployment": "gpt-4o-deployment",

"api_key": "${env:AZURE_OPENAI_API_KEY}",

"description": "Azure OpenAI GPT-4o deployment"

}

],

"prompty.defaultModel": "mock-local"

}

}

Le paramétrage mock-local empêche tout appel externe et permet d’utiliser F5 sans connexion à un modèle ou Preview as Markdown pour visualiser et copier le prompt final. Concernant les sections modèles openai-cloud et azure-openai, il s’agit juste d’exemples, vous pouvez les retirer ou les modifier selon votre usage.

2. Créer un modèle de prompt

Créez un fichier 1-collect-AI-news.prompty :

---

$schema: http://azureml/sdk-2-0/Prompty.yaml

name: Thematic News Snapshot

description: Summarize key announcements and developments on a given theme between two dates.

version: "1.0"

model:

api: chat

configuration:

type: openai

name: gpt-5.1

inputs:

start_date:

type: string

description: Start date of the analysis period (ISO format, e.g. "2025-10-01")

end_date:

type: string

description: End date of the analysis period (ISO format, e.g. "2025-10-07")

theme:

type: string

description: Main topic or domain to summarize (e.g., AI, climate tech, cybersecurity)

tone:

type: string

description: Desired tone (e.g., journalistic, academic, analytical)

language:

type: string

description: Output language (e.g., English, French)

summary_length:

type: string

description: Level of detail (short, medium, long)

sources_scope:

type: string

description: Scope of coverage (e.g., global, regional)

sample:

start_date: "2025-11-01"

end_date: "2025-11-24"

theme: "Artificial Intelligence"

tone: "journalistic"

language: "English"

summary_length: "medium"

sources_scope: "global"

template: jinja2

---

system:

You are a research assistant specialized in {{theme}}.

Your task is to summarize key announcements and developments related to {{theme}}

between {{start_date}} and {{end_date}}, in a {{tone}} tone and in {{language}}.

Keep the summary {{summary_length}} in length and focused on the {{sources_scope}} context.Appuyez sur F5 ou « Preview as Markdown » pour visualiser le résultat final avec les variables (Inputs) remplacées.

Pour comprendre la différence entre Inputs et sample :

- Inputs (utiliser lors de l’execution du prompt)

- Servent à définir les paramètres dynamiques du prompt.

- Ce sont des valeurs que l’utilisateur peut modifier avant chaque exécution (dates, thème, ton, langue, etc.).

- Elles apparaissent dans le texte du prompt sous la forme de {{nom_de_variable}}.

- Exemple : {{theme}}, {{start_date}}, {{tone}}.

- Sample (valeur par défaut ou d’exemple pour les variables / Inputs)

- Fournit un exemple concret de valeurs pour chaque variable / Inputs.

- Sert à illustrer l’usage du prompt ou à le tester rapidement.

- Peut être utilisé comme jeu de valeurs par défaut si aucune autre donnée n’est précisée.

- Exemple : sample: start_date: 2025-10-01 end_date: 2025-10-07 theme: « Artificial Intelligence »

En résumé :

- Inputs = structure du prompt (ce qu’on peut changer)

- sample = exemple de configuration (valeurs d’essai ou par défaut)

Lorsqu’on utilise la fonctionnalité « Preview as Markdown », les valeurs dans Sample sont utilisées.

3. Organiser sa bibliothèque

Structurez vos prompts par dossier :

📁 VS-Code-Prompty

┣ 📂 collect

┃ ┗ 1-collect-AI-news.prompty

┣ 📂 verify

┃ ┗ 2-verify-AI-news.prompty

┣ 📂 write

┃ ┗ 3-write-weekly-report.prompty

┗ 📂 review

┗ 4-review-final-report.prompty

Chaque fichier devient une brique de votre futur workflow IA : collecte, vérification, rédaction, relecture.

A lire également : Comment personnaliser la couleur d’une fenêtre VS Code avec un fichier .code-workspace

4. Exécution locale avec Ollama

Installez Ollama, puis configurez :

{

"name": "ollama-local",

"type": "ollama",

"base_url": "http://localhost:11434",

"model": "llama3:8b"

}

Vous pourrez ainsi exécuter vos prompts en local sans cloud, idéal pour les tests hors ligne ou la confidentialité des données.

5. Intégration avec LangChain ou Prompt Flow

Dans LangChain, un prompt Prompty peut être chargé ainsi :

import getpass

import os

import json

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

# pip install langchain-prompty

from langchain_prompty import create_chat_prompt

from pathlib import Path

# load prompty as langchain ChatPromptTemplate

# Important Note: Langchain only support mustache templating. Add

# template: mustache

# to your prompty and use mustache syntax.

folder = Path(__file__).parent.absolute().as_posix()

path_to_prompty = folder + "/test2.prompty"

prompt = create_chat_prompt(path_to_prompty)

os.environ["OPENAI_API_KEY"] = getpass.getpass()

model = ChatOpenAI(model="gpt-4")

output_parser = StrOutputParser()

chain = prompt | model | output_parser

json_input = '''{

"start_date": "2025-11-01",

"end_date": "2025-11-24",

"theme": "Artificial Intelligence",

"tone": "journalistic",

"language": "English",

"summary_length": "medium",

"sources_scope": "global"

}'''

args = json.loads(json_input)

result = chain.invoke(args)

print(result)Dans Prompt Flow, il suffit de lier le fichier .prompty comme composant d’un flow.

Prompty, un pont vers l’automatisation complète des workflows IA

Prompty sert de couche de fondation pour les pipelines IA modernes. Chaque fichier .prompty devient un bloc réutilisable, versionné et traçable, que l’on peut relier à des orchestrateurs tels que LangChain, Prompt Flow ou Semantic Kernel.

Sur GitHub, Microsoft fournit déjà des exemples d’intégration directe avec Prompt Flow, où Prompty agit comme un “template loader”. Dans Semantic Kernel, il est possible de convertir un prompt Prompty en fonction d’agent IA, assurant une cohérence entre le développement local et la production.

Cette modularité réduit les frictions entre expérimentation et automatisation. Prompty devient ainsi le pont naturel entre le prompt / contexte engineering et les workflows IA industrialisés.

Une courbe d’apprentissage rapide pour les utilisateurs de VS Code

Prompty s’intègre naturellement à l’écosystème de Visual Studio Code. L’installation est immédiate, la syntaxe claire, et la fonction Preview as Markdown permet de travailler hors ligne. Pour ceux qui souhaitent aller plus loin, la commande F5 permet une exécution directe sur le modèle choisi (mock, Ollama, Azure, OpenAI).

Comme le rappelle la documentation Microsoft, l’objectif de Prompty est d’« accélérer la boucle interne de développement ». Pour tout utilisateur habitué à VS Code, la courbe d’apprentissage est quasi nulle.

Voici une version enrichie qui intègre explicitement Prompt Flow, LangChain, LangGraph, et leur rôle dans la transition vers l’automatisation.

Je respecte strictement ton style éditorial (pas de gras dans les titres, majuscules correctes, pas d’emoji dans les titres).

Travailler par étapes : du manuel à l’automatisation complète

Prompty s’adapte à votre flux de travail et vous permet de progresser sans rupture organisationnelle. La transition se fait naturellement en trois niveaux : manuel, semi-automatisé et automatisé. Cette progression est essentielle pour valider la fiabilité des prompts, éviter d’automatiser trop tôt des templates instables et maintenir une intervention humaine là où elle apporte le plus de valeur.

Travail manuel : structurer et affiner vos prompts dans VS Code

Le travail manuel repose sur l’éditeur VS Code et la fonctionnalité Preview As Markdown. Vous créez vos fichiers prompty, vous remplissez les variables directement dans le frontmatter, puis vous copiez le résultat pour l’utiliser dans l’interface Web de votre IA préférée.

Ce mode est idéal pour affiner la structure de vos prompts, tester des variations, et comprendre comment l’IA réagit à vos consignes. Il reste très flexible, mais implique beaucoup de répétitions : copier des valeurs, coller dans plusieurs prompty, lancer plusieurs interactions manuelles.

Ce mode est conseillé tant que vos prompts ne sont pas stabilisés et que la priorité reste la créativité, l’exploration et l’expérimentation.

Mode semi-automatisé : fluidifier le flux tout en conservant l’intervention humaine

Lorsqu’une bibliothèque de prompts commence à se constituer, la méthode semi-automatisée devient rapidement la plus efficace. L’idée est de centraliser les données communes (thème, période, contexte, valeurs récurrentes) dans un fichier YAML ou JSON, puis de les injecter dans vos différentes étapes via un pré-remplissage manuel ou un petit script local.

Dans ce mode, vous conservez l’usage d’une IA conversationnelle via son interface Web, mais vous réduisez fortement la charge répétitive. Vous utilisez Prompty pour structurer, réutiliser et maintenir vos templates, tout en laissant certaines étapes créatives à l’humain : réécriture, enrichissement, vérification et contrôle éditorial.

Ce mode est souvent le plus efficace pour un créateur de contenu, un analyste ou un professionnel travaillant avec une bibliothèque de prompts évolutive. Il permet de garder le contrôle tout en rationalisant les tâches répétitives.

Automatisation complète : engager Prompt Flow, LangChain ou LangGraph

L’automatisation complète intervient lorsque l’objectif n’est plus uniquement d’aider l’humain dans son flux de travail, mais de construire un système IA qui fonctionne de manière autonome et reproductible. Dans ce contexte, des outils d’orchestration deviennent indispensables, comme Prompt Flow, LangChain ou LangGraph.

Prompt Flow permet de transformer vos fichiers prompty en étapes d’un pipeline reproductible, testable et versionné. Vous pouvez y chaîner plusieurs étapes d’IA : récupération d’informations, analyse, génération de texte, mise en forme et validation finale. Les entrées et sorties sont contrôlées, les modèles configurés globalement, et chaque étape peut être testée en isolation.

LangChain et LangGraph offrent quant à eux une approche plus programmatique, adaptée aux développeurs. LangChain permet de construire des chaînes logiques ou des agents qui manipulent vos prompts comme des composants. LangGraph ajoute une dimension orientée graphes, permettant de gérer des workflows complexes, des boucles de réflexion, des agents multi-étapes ou des vérifications structurées.

Dans un développement applicatif, cette approche est la plus adaptée. Elle offre :

- automatisation totale

- intégration dans une application ou un backend

- contrôle des erreurs

- gestion des états

- logique conditionnelle

- déploiement en production

Dans ce mode, l’humain n’intervient plus directement dans l’exécution. Il conçoit, supervise, valide, mais ne pilote plus chaque étape manuellement.

Une montée en puissance progressive et naturelle

Passer du manuel au semi-automatisé, puis à l’automatisation complète, permet d’évoluer sans rupture. Vous commencez par comprendre vos prompts, vous les stabilisez, puis vous les orchestrez dans un workflow robuste. Prompty facilite cette transition en fournissant une structure claire pour les prompts individuels, tandis que Prompt Flow, LangChain et LangGraph permettent ensuite de passer à une orchestration professionnelle.

Cette progression est particulièrement efficace pour distinguer deux usages :

- travail éditorial, analytique ou professionnel, où le semi-automatisé reste souvent idéal

- développement d’applications IA, où l’automatisation complète devient nécessaire

Ainsi, Prompty s’intègre parfaitement dans une démarche de montée en puissance, du simple fichier de prompt jusqu’à des systèmes IA entièrement orchestrés.

FAQ – Questions fréquentes sur Prompty et VS Code

Prompty est-il gratuit ? Oui, c’est un projet open source de Microsoft disponible sur GitHub.

Faut-il une clé API pour l’utiliser ? Non. La fonction Preview as Markdown permet de visualiser les prompts sans exécution de modèle.

Prompty fonctionne-t-il avec Ollama ? Oui, via un endpoint local (http://localhost:11434/v1), compatible avec Llama 3, Mistral ou Gemma.

Quelle différence avec Prompt Flow ? Prompty sert à concevoir et tester les prompts, tandis que Prompt Flow orchestre des workflows IA complets.

Promty, une brique essentielle vers des workflows IA structurés ?

Prompty n’est pas un simple éditeur de texte pour IA. C’est une brique d’ingénierie logicielle pensée pour structurer et fiabiliser le travail des équipes IA. En standardisant la création, le test et la réutilisation des prompts, il rend les workflows IA plus transparents, reproductibles et interopérables.

Pour les développeurs déjà ancrés dans Visual Studio Code, Prompty offre une passerelle naturelle vers des pratiques avancées de prompt engineering et d’automatisation IA.

En d’autres termes, Prompty marque le passage du prompt artisanal au prompt industrialisé, la première étape concrète vers une automatisation IA maîtrisée, efficace et durable.

Pour aller plus loin : Comment construire des agents IA indépendants de tout fournisseur LLM

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !