Public AI arrive sur Hugging Face : une nouvelle ère pour l’inférence open source

L’écosystème Hugging Face s’agrandit. Depuis septembre 2025, Public AI est officiellement intégré comme Inference Provider sur le Hugging Face Hub (source : Hugging Face). Cette arrivée n’est pas anodine : elle ouvre la voie à un accès simplifié, gratuit et souverain à des modèles d’intelligence artificielle open source directement depuis la plateforme de référence pour les chercheurs, développeurs et passionnés d’IA.

L’annonce a fait réagir la communauté, car elle ne se limite pas à l’ajout d’un simple prestataire d’inférence. Elle illustre une tendance plus large : la construction d’un écosystème public d’IA, capable de rivaliser avec les grands clouds privés tout en défendant la transparence et la souveraineté numérique.

Public AI sur Hugging Face : une intégration stratégique

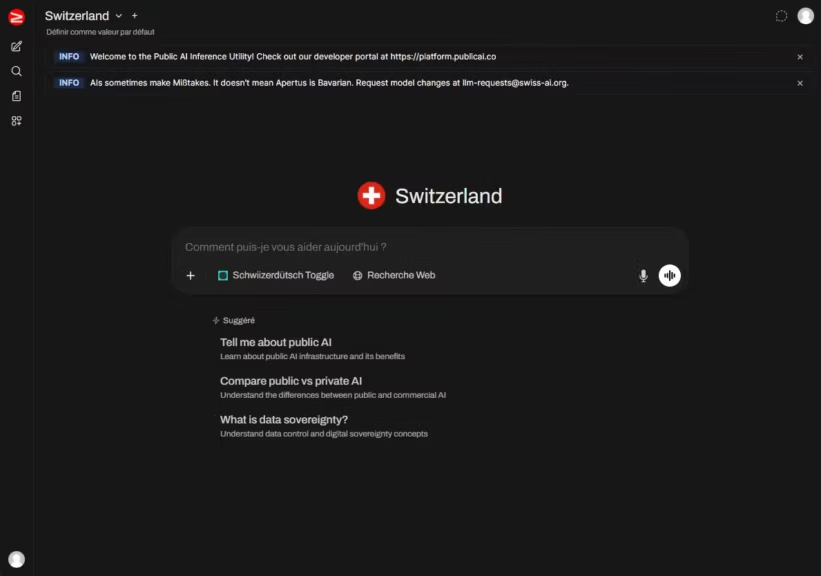

Avec cette intégration, les utilisateurs peuvent désormais sélectionner Public AI comme fournisseur d’inférence directement depuis les pages modèles du Hugging Face Hub. Concrètement, cela signifie qu’il devient aussi simple de lancer une requête sur un modèle hébergé par Public AI que d’utiliser les providers historiques comme Together AI ou Fireworks.

Les bénéfices sont multiples :

- Accessibilité immédiate : aucun besoin d’infrastructure propre pour tester un modèle.

- Interopérabilité : l’API est compatible avec celle d’OpenAI (source : Hugging Face), ce qui facilite la migration des projets existants.

- Souveraineté numérique : les modèles disponibles proviennent d’initiatives publiques et nationales comme Swiss AI Initiative ou AI Singapore (source : Public AI).

En pratique, les développeurs peuvent appeler ces modèles soit via leur clé API Hugging Face, soit via une clé générée sur la plateforme Public AI. Cette flexibilité s’adresse aussi bien aux utilisateurs occasionnels qu’aux équipes souhaitant intégrer durablement Public AI dans leurs flux de travail.

Une intégration fluide dans l’interface Hugging Face

Hugging Face a pensé cette intégration pour qu’elle soit quasi transparente. Trois points méritent d’être soulignés :

- Paramétrage utilisateur : dans les paramètres de compte Hugging Face, il est désormais possible d’ordonner ses fournisseurs d’inférence par préférence. Ainsi, un développeur peut choisir de privilégier Public AI par défaut (documentation Hugging Face).

- Widget sur les pages modèles : chaque page modèle affiche les fournisseurs compatibles. Si Public AI est disponible, il est listé dans les options d’inférence, facilitant les tests en quelques clics.

- SDK Python et JS : Hugging Face a mis à jour ses bibliothèques (huggingface_hub et @huggingface/inference) pour supporter Public AI. L’exemple officiel avec le modèle suisse Apertus-70B montre qu’une simple ligne provider= »publicai » suffit à basculer sur cette infrastructure.

Ce soin apporté à l’expérience utilisateur illustre la volonté de Hugging Face de diversifier son offre tout en réduisant la dépendance à ses propres serveurs, et surtout de donner de la visibilité à des projets qui défendent une autre vision de l’IA.

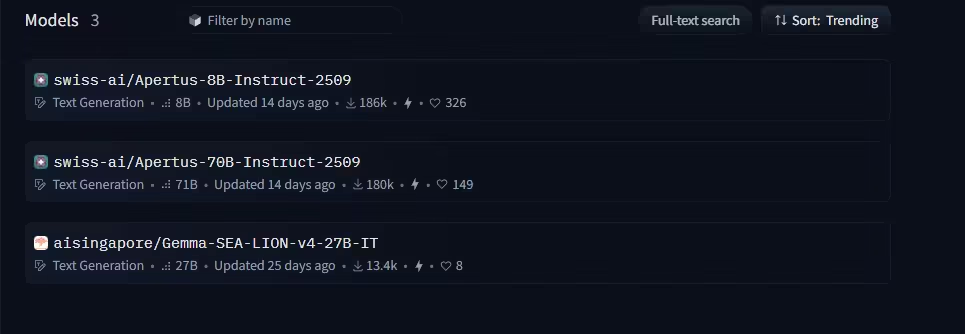

Quels modèles sont disponibles via Hugging Face et Public AI ?

Pour l’instant, Public AI propose principalement deux modèles phares :

- Apertus-70B (Suisse), développé par la Swiss AI Initiative. Le modèle 8B est également disponible.

- SEA-LION v4 (Singapour), porté par AI Singapore.

Ils sont accessibles aussi bien via l’API Hugging Face que via l’interface Web chat.publicai.co. Cette dernière repose sur Open WebUI, un projet open source qui a gagné en popularité pour ses interfaces de chat intuitives et modulables (source : Public AI Inference Utility).

La roadmap officielle mentionne de futurs partenariats avec d’autres pays, notamment l’Espagne et le Canada (About the Inference Utility). Il sera intéressant de suivre l’évolution du catalogue directement sur la liste des modèles compatibles.

Une infrastructure pensée pour la résilience

Derrière cette intégration se cache une architecture technique ambitieuse :

- Backend vLLM : moteur d’inférence optimisé pour la rapidité et l’efficacité mémoire.

- Déploiement distribué : serveurs hébergés par des clusters publics et privés, répartis à l’échelle mondiale.

- API compatibles OpenAI : standardisation qui facilite la prise en main par les développeurs.

- Load balancing global : routage transparent des requêtes selon les ressources disponibles (source : Hugging Face).

Cette approche vise à offrir une disponibilité stable, malgré la dépendance à des ressources en partie données par des partenaires industriels et nationaux.

Il reste quelques inconnues, comme la capacité réelle de cette infrastructure face à une montée en charge massive.

Gratuité aujourd’hui, viabilité demain ?

L’un des points qui attire l’attention : l’utilisation de Public AI via Hugging Face est actuellement gratuite. Selon la documentation officielle, cette gratuité repose sur deux leviers :

- Temps GPU donnés par des institutions et partenaires privés.

- Subventions publicitaires pour couvrir une partie des coûts.

À long terme, la pérennité devrait être assurée par :

- des contributions publiques (États, institutions),

- des modèles d’abonnement (tiers Plus ou Pro envisagés),

- et une logique d’utilité publique, comparable à celle de services publics comme l’eau ou l’électricité (About the Inference Utility).

Le calendrier et les conditions d’introduction de ces abonnements n’ont pas encore été clarifiés.

Un pas de plus vers une IA publique et souveraine

Au-delà de l’aspect technique, cette intégration marque une étape importante dans la stratégie de Hugging Face :

- Offrir plus de choix aux développeurs.

- Soutenir un projet open source et non lucratif qui mise sur la transparence et la gouvernance publique.

- Donner une vitrine à des initiatives nationales qui cherchent à proposer une alternative crédible aux API privées dominantes.

Comme le souligne le manifeste de Public AI, il s’agit de penser l’IA comme une infrastructure publique, à l’image des bibliothèques ou des réseaux électriques.

L’arrivée de Public AI sur Hugging Face ne résout pas tous les défis : financement, scalabilité, attractivité face aux géants du secteur restent des enjeux majeurs. Mais elle envoie un signal clair : l’écosystème open source cherche à construire des alternatives solides, accessibles et durables.

Conclusion

Avec l’intégration de Public AI sur Hugging Face, l’inférence open source franchit une étape décisive. Désormais, tester et utiliser des modèles souverains comme Apertus-70B ou SEA-LION v4 devient aussi simple que de lancer une requête sur GPT ou LLaMA.

Apertus-70B est dans la ligue des meilleurs open source, mais reste bien en dessous des LLM fermés de nouvelle génération comme ChatGPT 5 ou Claude 4 en termes de polyvalence et de performance.

Cette collaboration entre une plateforme mondiale et une initiative publique illustre un mouvement de fond : faire de l’IA un bien commun plutôt qu’un simple produit commercial.

Point à suivre :

- Quels nouveaux modèles nationaux seront intégrés ?

- Comment évolueront les quotas gratuits et la politique tarifaire ?

- Quelles performances concrètes face aux providers privés déjà installés ?

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !