Quel modèle Qwen 3 choisir ? Comparatif complet des versions 235B, 32B, 30B, 14B, 8B et 4B

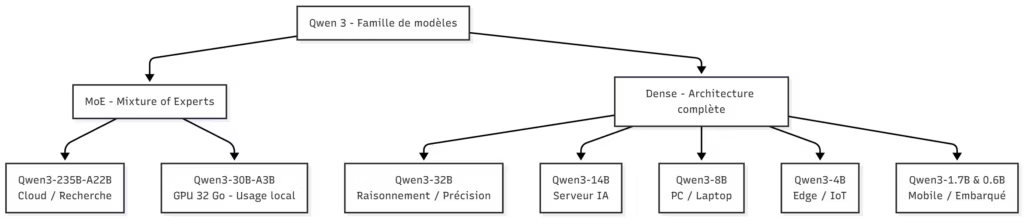

Lancée en 2025 par Alibaba Cloud, la série Qwen 3 s’impose comme l’une des gammes de modèles IA open source, open weight pour être plus précis, les plus complètes du marché. De la version ultra-légère Qwen3-1.7B pensée pour les PC modestes, jusqu’au monstre de calcul Qwen3-235B-A22B, chaque modèle répond à un profil bien précis : recherche, développement, inférence locale, ou déploiement cloud à grande échelle.

Mais quel modèle Qwen 3 choisir selon votre matériel et vos besoins ? Faut-il opter pour la version Dense Qwen3-32B privilégiée pour sa précision, ou pour le modèle Mixture-of-Experts Qwen3-30B-A3B, réputé plus rapide et plus économe en VRAM ? Et que valent réellement les versions intermédiaires comme les Qwen3-14B ou Qwen3-8B, souvent sous-estimées mais idéales pour une inférence locale sur GPU 16 Go ?

Le projet Qwen 3 ne se limite pas à une simple évolution technique : il redéfinit la hiérarchie des modèles de langage open source. Chaque déclinaison combine une fenêtre de contexte étendue (jusqu’à 128K tokens voire 1 million selon le rapport QwenLM) et une prise en charge de 119 langues, du français au chinois en passant par l’arabe.

Dans ce guide, nous passons en revue les versions 235B, 32B, 30B, 14B, 8B et 4B, en comparant leurs performances, leur consommation VRAM et leurs usages typiques. Objectif : vous aider à choisir le modèle Qwen 3 le plus adapté à votre configuration, qu’il s’agisse d’une RTX 5090, d’un laptop ou d’un serveur IA.

Souhaitez-tu que je continue avec la section suivante : “Panorama de la gamme Qwen 3 : Dense, MoE et Thinking Mode” ?

Panorama de la gamme Qwen 3 : Dense, MoE et Thinking Mode

La gamme Qwen 3 s’appuie sur une architecture flexible, pensée pour s’adapter à différents environnements : du PC portable à la ferme de GPU. Le principe est simple : proposer un modèle optimisé pour chaque type d’usage, sans sacrifier la qualité du raisonnement ni la rapidité d’inférence.

Selon le blog officiel QwenLM, la famille se divise en deux grands ensembles : les modèles “Dense” et les modèles “Mixture of Experts (MoE)”, auxquels s’ajoute une innovation clé introduite avec cette génération : le “Thinking Mode”.

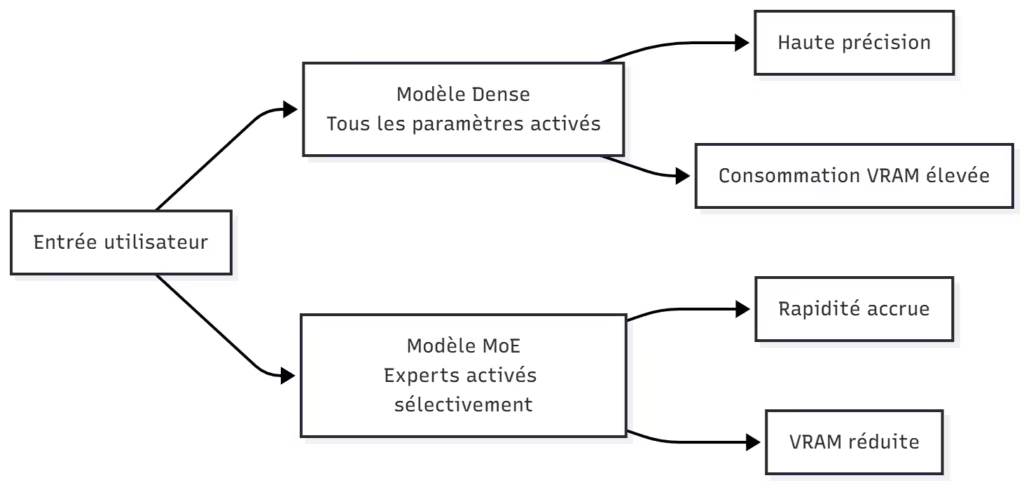

Les deux architectures principales

Les modèles Dense, comme Qwen3-32B ou Qwen3-14B, suivent une architecture classique où tous les paramètres sont activés à chaque étape du calcul. Cela garantit une stabilité maximale et une précision supérieure sur les tâches complexes : mathématiques, codage, logique ou analyse de texte. En revanche, cette structure consomme davantage de VRAM et ralentit légèrement la génération de tokens.

Les modèles MoE (Mixture-of-Experts), à l’image du Qwen3-30B-A3B ou du Qwen3-235B-A22B, utilisent une approche plus intelligente : seuls quelques “experts” sont activés à chaque token, réduisant la charge mémoire et augmentant la vitesse d’exécution. Cette architecture permet de générer jusqu’à 4 à 6 fois plus vite qu’un modèle dense de taille équivalente, sans perte majeure de qualité sur les tâches courantes.

Le mode “Thinking”

Autre nouveauté majeure : le Thinking Mode. Intégré nativement dans Qwen 3 (et non réservé à QwQ), ce mode active un raisonnement étape par étape, proche du chain-of-thought. Le modèle peut ainsi “réfléchir” avant de répondre, ce qui améliore la précision sur les questions complexes. Il est possible de l’activer ou de le désactiver via les commandes /think et /no_think, comme le mentionne la page Hugging Face de Qwen3-32B.

Le Thinking Mode est particulièrement utile pour :

- le codage avancé (analyse et planification de code),

- les problèmes mathématiques ou logiques,

- les agents IA autonomes, où la rigueur du raisonnement est essentielle.

Fenêtres de contexte et compatibilité

L’un des atouts majeurs de la série Qwen 3 réside dans sa fenêtre de contexte étendue. Tous les modèles gèrent au moins 128 K tokens, certains atteignant 256 K voire 1 million de tokens grâce aux techniques d’extension (RoPE scaling, YaRN). Cette capacité fait de Qwen 3 une alternative crédible aux modèles propriétaires comme GPT-4-Turbo, surtout pour les projets de RAG (Retrieval-Augmented Generation) et d’analyse documentaire à grande échelle.

En pratique, le contexte effectif dépend du modèle et du matériel : un Qwen3-30B-A3B quantisé à 4 bits peut traiter un contexte étendu sur une RTX 5090 (32 Go), alors qu’un Qwen3-8B fonctionnera plus confortablement avec une fenêtre de 64 K tokens.

Comparatif rapide des modèles Qwen 3

La famille Qwen 3 regroupe une large gamme de modèles, allant du 0.6B conçu pour les appareils mobiles, jusqu’au 235B destiné au cloud. Chaque version a été pensée pour un équilibre différent entre vitesse, précision et consommation mémoire.

Le tableau ci-dessous résume les caractéristiques principales, afin d’aider à visualiser en un coup d’œil les différences entre les versions Dense et MoE (Mixture-of-Experts).

| Modèle | Type | Paramètres totaux | Paramètres actifs | VRAM (Q4) | Fenêtre de contexte | Usage typique |

|---|---|---|---|---|---|---|

| Qwen3-235B-A22B | MoE | 235 B | 22 B | 80 Go + | 256 K – 1 M | Recherche, cloud, IA avancée |

| Qwen3-32B | Dense | 32 B | 32 B | 27 Go | 128 K | Raisonnement complexe, précision maximale |

| Qwen3-30B-A3B | MoE | 30 B | 3 B | 19 Go | 128 K | Inference locale haut de gamme, rapidité |

| Qwen3-14B | Dense | 14 B | 14 B | 12 Go | 128 K | Serveur IA, usage professionnel |

| Qwen3-8B | Dense | 8 B | 8 B | 8 Go | 128 K | PC, laptop, applications IA locales |

| Qwen3-4B | Dense | 4 B | 4 B | 5 Go | 128 K | Appareils embarqués, edge computing |

| Qwen3-1.7B | Dense | 1.7 B | 1.7 B | 3 Go | 128 K | Mobile, IA offline |

| Qwen3-0.6B | Dense | 0.6 B | 0.6 B | 2 Go | 128 K | IoT, outils légers |

Points clés du comparatif

- Les modèles MoE (30B-A3B et 235B-A22B) offrent une efficacité inégalée : seuls certains experts sont activés, réduisant la VRAM consommée tout en maintenant une performance de haut niveau.

- Les modèles Dense, comme Qwen3-32B ou 14B, restent les plus précis sur les tâches logiques et analytiques.

- Les modèles intermédiaires (14B, 8B) se démarquent par leur équilibre entre puissance et accessibilité, parfaits pour un déploiement sur GPU 16 Go.

- Les petits modèles (4B, 1.7B) assurent une latence très faible, idéale pour l’embarqué ou le prototypage rapide.

D’après les mesures rapportées par RunPod et LLM-Stats, le Qwen3-30B-A3B reste le meilleur compromis global pour une inférence locale sur GPU 32 Go. Il dépasse souvent le 32B Dense en rapidité, tout en restant plus léger à charger.

Qwen3-235B-A22B : le modèle flagship

Le Qwen3-235B-A22B est le fleuron de la gamme. Développé par Alibaba Cloud, il incarne l’ambition de la série Qwen : offrir un modèle open weight capable de rivaliser avec les géants propriétaires comme GPT-4 ou Gemini 1.5 Ultra.

Ce modèle adopte une architecture Mixture-of-Experts (MoE) : sur 235 milliards de paramètres totaux, seuls 22 milliards sont activés à chaque token. Cette approche réduit drastiquement la consommation GPU tout en maintenant un raisonnement profond et une cohérence linguistique très élevée. Selon le blog QwenLM, chaque passe active 8 experts sur 128, assurant un équilibre entre diversité et performance.

Capacités et performances

- Fenêtre de contexte : 256 K tokens en natif, extensible jusqu’à 1 million grâce aux techniques YaRN et RoPE scaling (rapport arXiv Qwen3).

- Langues prises en charge : 119 langues et dialectes, couvrant le français, l’anglais, le chinois, l’arabe et l’espagnol.

- Performances : scores supérieurs à 90 % sur AIME 2025, LiveBench Math et Arena Hard, selon LLM-Stats.

- Usage : fine-tuning pour la recherche, inférence distribuée, RAG massif, analyse multimodale avec Qwen3-VL.

Contraintes matérielles

Ce modèle reste réservé aux environnements puissants : une exécution complète requiert plus de 80 Go de VRAM, voire plusieurs GPU reliés en NVLink. Même en quantisation 4-bit, un seul GPU de 32 Go (RTX 5090, A100 ou H100) ne suffit pas pour une inférence fluide. Les utilisateurs locaux devront donc se tourner vers :

- un cluster multi-GPU,

- ou un service cloud comme RunPod, Lambda Labs ou vLLM Cloud.

Selon Tech Reviewer, un serveur 2×H100 atteint environ 120 tokens/s en INT4, mais nécessite plus de 600 W de consommation GPU.

Pour aller plus loin : Installer vLLM avec Docker Compose sur Linux (compatible Windows WSL2)

En résumé

| Atout | Détail |

|---|---|

| Architecture | Mixture-of-Experts (22 B actifs / 235 B totaux) |

| Context window | 256 K à 1 M tokens |

| Langues | 119 langues et dialectes |

| Performance | > 90 % sur benchmarks logiques et mathématiques |

| Usage idéal | Cloud, recherche, IA autonome, RAG massif |

| Limite | Non exécutable en local sans cluster multi-GPU |

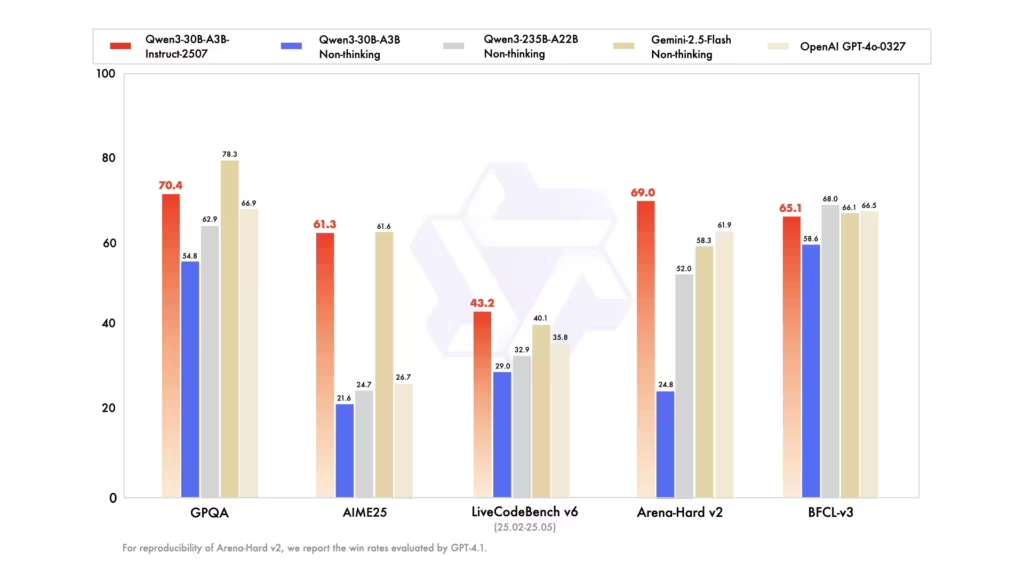

Qwen3-32B vs Qwen3-30B-A3B : la comparaison clé

C’est ici que se joue le vrai dilemme pour la plupart des utilisateurs. Le Qwen3-32B (Dense) et le Qwen3-30B-A3B (MoE) sont les deux modèles les plus utilisés pour une inférence locale sur GPU haut de gamme. Tous deux offrent un excellent équilibre entre puissance de raisonnement, rapidité et consommation mémoire, mais leur approche technique diffère profondément.

Performances et vitesse

Les mesures communautaires confirment un avantage net pour le 30B-A3B en termes de vitesse. D’après les tests partagés sur Reddit /r/LocalLLaMA, le modèle atteint jusqu’à 190 tokens/s sur une RTX 5090 en quantisation Q4_K_M, avec un contexte de 8K tokens. Le 32B Dense, quant à lui, plafonne souvent autour de 50 à 60 tokens/s dans les mêmes conditions. Il n’y a pour l’instant pas de données avec le nouveau format NVFP4, pourtant ces modèles sont disponibles sur Hugging Face avec le format optimisé NVFP4.

Cette différence provient du principe MoE : seuls quelques experts sont activés à chaque étape, réduisant la charge GPU. Sur des prompts longs ou des usages de type chat multi-turn, le Qwen3-30B-A3B maintient une latence stable et une excellente cohérence contextuelle.

Selon l’analyse de Kaitchup Substack, ce modèle peut être jusqu’à 6× plus rapide dans certains scénarios de génération à batch équivalent, tout en offrant une précision “quasi dense” sur les benchmarks généralistes.

VRAM et efficacité

Le Qwen3-30B-A3B est clairement plus léger :

- ~19 Go de VRAM en quantisation INT4,

- contre 27 Go pour le Qwen3-32B Dense comme l’indique Unsloth.

Cela permet à la plupart des utilisateurs équipés d’une RTX 4090 ou 5090 (32 Go) de charger le modèle sans offload CPU, tout en conservant de la marge pour un contexte élargi (jusqu’à 128 K tokens).

Précision et comportement

Sur les benchmarks logiques et mathématiques (AIME, Arena Hard, LiveBench), le Qwen3-32B Dense garde une légère avance. Il produit moins d’erreurs arithmétiques et hallucine moins dans les scénarios complexes de raisonnement explicite. C’est le choix privilégié pour :

- les agents de calcul,

- la recherche scientifique,

- ou la vérification de code complexe.

Le 30B-A3B, en revanche, surpasse souvent le Dense dans les usages conversationnels, génératifs ou créatifs. Son comportement plus fluide et sa rapidité en font un excellent choix pour la production de texte, le RAG local ou les assistants IA.

En résumé

| Critère | Qwen3-30B-A3B (MoE) | Qwen3-32B (Dense) |

|---|---|---|

| Architecture | Mixture-of-Experts (3B actifs / 30B totaux) | Dense complète |

| VRAM (Q4) | ~19 Go | ~27 Go |

| Vitesse (RTX 5090) | ~140 à 190 tok/s | ~50 à 60 tok/s |

| Précision logique | Bonne | Excellente |

| Usage idéal | IA locale, agents rapides, prototypage | Raisonnement, math, codage analytique |

| Langues supportées | 119 | 119 |

| Fenêtre de contexte | 128 K | 128 K |

En pratique, le Qwen3-30B-A3B est la référence actuelle pour une inférence locale fluide sur GPU 32 Go, tandis que le Qwen3-32B s’adresse à ceux qui privilégient la stabilité et la rigueur logique avant la vitesse.

Les modèles intermédiaires : Qwen3-14B et Qwen3-8B

Entre les géants du cloud et les modèles ultra-légers, Qwen3-14B et Qwen3-8B occupent une place stratégique. Ils ciblent les utilisateurs qui recherchent un équilibre entre performance, consommation mémoire et accessibilité, sans nécessiter un GPU hors de prix. Ces deux versions “Dense” conservent la philosophie Qwen : des modèles ouverts, multilingues et capables de raisonnement avancé, tout en restant exploitables en local.

Qwen3-14B : le bon compromis

Le Qwen3-14B est souvent qualifié de sweet spot dans la gamme. Il offre une stabilité proche du 32B tout en réduisant les besoins matériels d’environ 40 %. Selon les benchmarks publiés sur Hugging Face, le modèle gère sans difficulté des contextes de 128 K tokens, avec une excellente compréhension linguistique et une cohérence soutenue sur les conversations longues.

Caractéristiques clés :

- Architecture : Dense, 14 milliards de paramètres

- VRAM (Q4) : ~12 Go

- Vitesse : ~70 tok/s sur une RTX 5090 (mesure RunPod)

- Usages recommandés : serveurs d’entreprise, assistants IA internes, agents conversationnels complexes

Le 14B s’adapte parfaitement aux GPU 16 Go – 24 Go (RTX 4080 / 4090). Il est donc idéal pour les développeurs indépendants ou les petites structures souhaitant bénéficier d’un modèle robuste sans infrastructure cloud.

Qwen3-8B : la polyvalence locale

Le Qwen3-8B marque la frontière entre performance et légèreté. Avec seulement 8 milliards de paramètres, il reste fluide sur des GPU 8 Go tout en offrant des résultats nettement supérieurs aux modèles de taille similaire (comme Mistral 7B). La documentation QwenLM sur GitHub précise qu’il a été entraîné sur 36 000 milliards de tokens multilingues, garantissant une excellente couverture linguistique et une grammaire stable.

Points notables :

- VRAM (Q4) : ~8 Go

- Fenêtre de contexte : 128 K tokens

- Vitesse : ~120 tok/s sur RTX 4070

- Usage typique : prototypage IA, génération de texte, outils créatifs, chatbots embarqués

Pour les utilisateurs de PC gamer ou laptop récent, le Qwen3-8B est le meilleur point d’entrée dans l’écosystème Qwen 3. Il permet de tester le Thinking Mode, de manipuler les prompts complexes et de développer des agents personnalisés sans recourir au cloud.

En résumé

| Critère | Qwen3-14B | Qwen3-8B |

|---|---|---|

| Architecture | Dense | Dense |

| VRAM (Q4) | ~12 Go | ~8 Go |

| Vitesse (RTX 5090) | ~70 tok/s | ~120 tok/s |

| Fenêtre de contexte | 128 K tokens | 128 K tokens |

| Usage idéal | Serveur IA, entreprise, projet multi-agents | PC local, laptop, prototypage IA |

| Langues supportées | 119 | 119 |

Ces deux modèles représentent une porte d’entrée idéale dans l’univers Qwen 3 : assez puissants pour traiter des tâches complexes, mais suffisamment légers pour une exécution confortable sur GPU grand public.

Les modèles légers : Qwen3-4B, Qwen3-1.7B et Qwen3-0.6B

Les modèles Qwen3-4B, 1.7B et 0.6B représentent la base la plus accessible de la gamme. Pensés pour fonctionner sur des machines modestes, voire sans GPU dédié,, ils permettent d’exploiter les avancées de l’IA générative dans des contextes où la puissance de calcul est limitée : mini-serveurs, PC portables, terminaux embarqués ou appareils IoT.

Malgré leur taille réduite, ces modèles conservent la compatibilité complète avec les outils et frameworks de la gamme Qwen 3, notamment Hugging Face Transformers, vLLM, Ollama et LM Studio.

Qwen3-4B : la version portable mais sérieuse

Le Qwen3-4B est le plus petit modèle réellement polyvalent. Avec ses 4 milliards de paramètres, il peut tenir dans environ 5 Go de VRAM en quantisation Q4, tout en produisant un texte cohérent sur de longues séquences. Il convient parfaitement aux petits serveurs personnels, aux stations de travail compactes ou à une inférence locale sous Windows 11 avec GPU 8 Go.

Selon RunPod, le modèle conserve des temps de réponse inférieurs à 300 ms/token, tout en supportant des contextes de 128 K tokens. Ses limites principales apparaissent sur les tâches nécessitant du raisonnement logique approfondi ou de la génération multi-tour longue.

Usage recommandé : chatbot offline, outils de résumé local, automatisations légères, IA embarquée sur micro-serveurs.

Qwen3-1.7B : la solution pour PC et laptop

Le Qwen3-1.7B est une version encore plus compacte, conçue pour tourner sur des GPU 4 Go ou même sur CPU. Il reste compatible avec le Thinking Mode et la structure multilingue complète (119 langues). Sa force réside dans sa réactivité instantanée : il démarre en moins de deux secondes et produit du texte fluide sans chargement prolongé.

Il est idéal pour :

- les assistants personnels fonctionnant offline ;

- les scripts d’automatisation IA sous Windows ou Linux ;

- les interfaces conversationnelles embarquées dans des logiciels tiers.

Malgré sa petite taille, son style de génération reste naturel et bien calibré, surtout sur les phrases courtes et les instructions concises.

Qwen3-0.6B : le modèle ultra-léger pour l’IoT et le edge computing

Avec seulement 600 millions de paramètres, le Qwen3-0.6B est taillé pour les micro-appareils, Raspberry Pi 5, ou les environnements IoT. Son empreinte mémoire est inférieure à 2 Go, et son inference peut se faire en temps réel sur CPU ARM. Il est évidemment limité en raisonnement ou en contexte long, mais excelle dans les tâches basiques : classification, détection de mots-clés, génération de commandes textuelles.

Cette version prouve que l’écosystème Qwen 3 couvre l’intégralité du spectre : du serveur IA de plusieurs centaines de Go au mini-module d’analyse offline.

En résumé

| Modèle | Paramètres | VRAM (Q4) | Contexte | Usage idéal |

|---|---|---|---|---|

| Qwen3-4B | 4 B | 5 Go | 128 K | IA locale, serveur compact |

| Qwen3-1.7B | 1.7 B | 3 Go | 128 K | Laptop, PC basique |

| Qwen3-0.6B | 0.6 B | 2 Go | 128 K | IoT, edge computing |

Ces modèles illustrent la philosophie modulaire de la série Qwen 3 : chacun peut exploiter l’IA générative, quel que soit son matériel. Ils ne rivalisent pas en raisonnement avec les versions 30B ou 32B, mais garantissent une latence minimale et une intégration facile dans des pipelines logiciels légers.

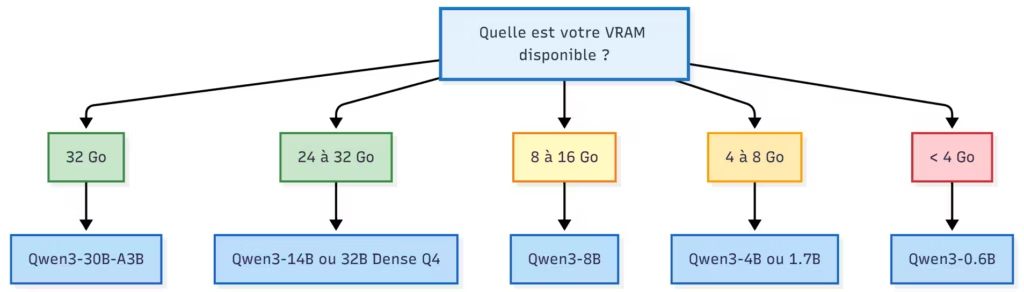

Critères pour bien choisir son modèle Qwen 3

Choisir le bon modèle Qwen 3 dépend avant tout de ton usage, de ton matériel et de ton niveau d’exigence en précision. Tous les modèles partagent la même base technique, mais leur comportement diffère sensiblement selon la VRAM disponible, la longueur du contexte ou la nature des tâches. Voici les principaux critères à prendre en compte avant de te lancer.

1. Capacité VRAM disponible

La mémoire GPU est le premier facteur limitant. Les modèles Dense sollicitent plus de VRAM car tous les paramètres sont actifs en permanence, contrairement aux MoE, qui n’activent qu’une fraction des experts. Selon les mesures de RunPod et Unsloth :

- Qwen3-30B-A3B (MoE) → ~19 Go (Q4)

- Qwen3-32B (Dense) → ~27 Go (Q4)

- Qwen3-14B → ~12 Go

- Qwen3-8B → ~8 Go

- Qwen3-4B → ~5 Go

Conseil : vise un modèle qui laisse au moins 2 à 4 Go de marge libre sur ton GPU pour éviter le swap VRAM et les ralentissements du KV cache.

2. Vitesse de génération souhaitée

La vitesse (tokens/seconde) dépend directement du type de modèle, de la quantisation et du batch size. Les modèles MoE comme le 30B-A3B sont en moyenne 4 à 6 fois plus rapides que leurs équivalents denses, selon les tests de Kaitchup Substack. Si tu cherches un modèle réactif pour du chat ou du développement interactif, choisis :

- Qwen3-30B-A3B sur GPU ≥ 24 Go,

- ou Qwen3-8B / 14B sur GPU ≤ 16 Go.

Pour des tâches longues (analyse de documents, RAG, génération technique), la vitesse importe moins que la stabilité du flux de tokens, où les modèles Dense reprennent l’avantage.

3. Niveau de précision attendu

Les benchmarks montrent que :

- Qwen3-32B obtient les meilleurs scores sur AIME, Arena Hard et LiveBench Math ;

- Qwen3-30B-A3B reste très proche sur le plan conversationnel, mais légèrement moins stable sur le raisonnement formel ;

- Qwen3-14B et 8B assurent une précision correcte pour la majorité des tâches de génération, rédaction, code ou support client.

👉 Si tu vises une IA d’assistance technique ou analytique, privilégie le 32B Dense. Pour des usages polyvalents (agents IA, chat, prototypage), le 30B-A3B suffit largement.

4. Taille de contexte nécessaire

Tous les modèles Qwen 3 supportent un contexte d’au moins 128 K tokens, et certains (notamment 235B-A22B et 30B-A3B) atteignent 256 K à 1 million de tokens via YaRN ou RoPE scaling (rapport QwenLM sur arXiv). Si tu travailles avec des documents volumineux, des PDFs ou du code long, choisis un modèle compatible avec une fenêtre étendue. Dans les autres cas, 128 K tokens suffisent largement pour un usage standard.

5. Environnement d’exécution

| Environnement | Recommandation | Justification |

|---|---|---|

| PC haut de gamme (RTX 5090, 32 Go) | Qwen3-30B-A3B | rapide, fluide, excellent rapport VRAM/perf |

| Station pro (RTX 4090, 24 Go) | Qwen3-14B ou 30B-A3B quantisé | équilibre entre précision et poids |

| PC moyen (RTX 4070 / 4070 Ti) | Qwen3-8B | fluide, stable, support multilingue complet |

| Laptop IA / GPU 8 Go | Qwen3-4B | faible latence, démarrage instantané |

| Serveur cloud / multi-GPU | Qwen3-235B-A22B | performances maximales |

| Edge / IoT / CPU ARM | Qwen3-1.7B ou 0.6B | consommation minimale |

En résumé, le meilleur modèle Qwen 3 dépend du compromis que tu acceptes entre puissance, rapidité et VRAM. Les configurations à 32 Go VRAM profitent pleinement du 30B-A3B, tandis que les GPU plus modestes trouvent leur équilibre avec le 14B ou le 8B. Les modèles ultra-légers (4B, 1.7B, 0.6B) ouvrent la voie à des usages embarqués, là où la vitesse prime sur la complexité.

Recommandations selon votre profil

La richesse de la gamme Qwen 3 permet à chacun de trouver un modèle parfaitement adapté à son matériel et à ses besoins. Que vous soyez développeur, chercheur ou simple curieux de l’IA locale, le choix optimal dépend de votre usage, de la puissance de votre GPU et du type de tâches que vous exécutez.

Voici des recommandations concrètes pour orienter votre décision.

Pour les utilisateurs exigeants : GPU 32 Go et plus

Si vous disposez d’une RTX 5090, d’une A100 ou d’une H100, vous pouvez exploiter les modèles haut de gamme. Le meilleur choix en local reste Qwen3-30B-A3B (MoE) : il combine rapidité, efficacité et une VRAM maîtrisée (~19 Go en Q4). C’est le modèle idéal pour :

- les assistants IA avancés,

- les agents multi-prompts,

- ou les projets RAG nécessitant une réponse rapide.

Le Qwen3-32B Dense, plus lourd mais plus rigoureux, est recommandé pour :

- le raisonnement logique,

- le codage complexe,

- la vérification de données scientifiques.

Selon LLM-Stats, ce dernier conserve une avance notable sur les benchmarks de raisonnement pur, mais au prix d’une vitesse réduite.

Pour les stations professionnelles et développeurs IA

Avec une RTX 4090 (24 Go) ou une station IA dédiée, deux modèles se distinguent :

- Qwen3-14B, pour les serveurs internes, assistants de code ou IA d’entreprise,

- Qwen3-30B-A3B quantisé, si la VRAM le permet.

Le 14B offre une excellente couverture linguistique et un raisonnement stable, tout en restant économe en ressources. Il est souvent utilisé pour des agents conversationnels multilingues et des applications de support automatisé.

Pour les créateurs, tinkerers et chercheurs indépendants

Sur un GPU 8 à 16 Go, les meilleurs choix sont :

- Qwen3-8B pour le prototypage local,

- Qwen3-4B pour les tests rapides ou les applications offline.

Le Qwen3-8B est suffisamment puissant pour alimenter un assistant IA de bureau ou un outil de génération de texte créatif. Sa vitesse et sa réactivité le rendent idéal pour l’expérimentation via LM Studio ou Ollama. Selon Hugging Face, il prend en charge l’intégralité des 119 langues et reste fluide sur un GPU 8 Go.

Pour les environnements mobiles ou embarqués

Les modèles Qwen3-1.7B et 0.6B brillent par leur légèreté. Ils fonctionnent même sur CPU et s’intègrent facilement dans :

- les applications offline,

- les systèmes embarqués (Raspberry Pi, edge AI),

- ou des outils autonomes de commande vocale / texte.

Ces modèles restent limités en raisonnement, mais parfaits pour des tâches simples comme la classification, la reformulation ou le dialogue basique. C’est une excellente porte d’entrée pour expérimenter la génération de texte embarquée.

Pour le cloud et la recherche à grande échelle

Le Qwen3-235B-A22B est réservé aux infrastructures professionnelles. Il excelle sur les tâches de RAG massif, de fine-tuning distribué ou d’IA multimodale avancée. Selon TechCrunch, ce modèle démontre une efficacité comparable à GPT-4, tout en restant open weight et extensible.

Tableau récapitulatif

| Profil utilisateur | Modèle recommandé | Points forts | Environnement idéal |

|---|---|---|---|

| GPU 32 Go et + | Qwen3-30B-A3B | Vitesse, MoE efficace, RAG local | RTX 5090, H100 |

| Station IA 24 Go | Qwen3-14B | Stable, précis, usage professionnel | RTX 4090 |

| GPU 8–16 Go | Qwen3-8B | Fluide, multilingue, léger | PC, laptop |

| Mini PC / edge | Qwen3-4B / 1.7B | Latence minimale | Laptop, IoT |

| Cloud / cluster | Qwen3-235B-A22B | Précision ultime, raisonnement profond | Serveur distribué |

Ces recommandations couvrent l’ensemble du spectre matériel, du laptop au supercalculateur. Qwen 3 se distingue par son évolutivité : un même pipeline peut utiliser plusieurs tailles de modèles selon les contraintes de performance ou d’énergie, tout en conservant une base technologique commune.

FAQ – Questions fréquentes sur les modèles Qwen 3

Cette section regroupe les questions les plus courantes posées par la communauté autour des modèles Qwen 3, de leur installation à leurs performances. Elle s’appuie sur les retours utilisateurs des forums Hugging Face, Reddit /r/LocalLLaMA et la documentation officielle QwenLM GitHub.

Quelle est la différence entre les modèles “Dense” et “MoE” ?

Un modèle Dense active tous ses paramètres à chaque token généré. Cela garantit une cohérence et une précision maximales, mais augmente la consommation GPU. Un modèle MoE (Mixture-of-Experts), en revanche, ne mobilise qu’une fraction des experts (souvent 8 sur 128) à chaque étape, ce qui réduit la VRAM utilisée et améliore la vitesse.

👉 Exemple : le Qwen3-30B-A3B n’active que 3 milliards de paramètres par token, contre 32 milliards pour le Qwen3-32B Dense. Résultat : une inférence 4 à 6 fois plus rapide, selon Kaitchup Substack.

Peut-on faire tourner Qwen3-32B sur un GPU 24 Go ?

Oui, mais uniquement en quantisation forte (Q4) et avec un offload partiel sur la RAM via vLLM ou ExLlama V2. Le modèle consomme environ 27 Go de VRAM et nécessite un système stable avec un cache KV bien géré. Pour une expérience fluide, il vaut mieux privilégier le Qwen3-30B-A3B, plus rapide et moins gourmand.

Quelle version est la plus précise pour le raisonnement logique ou mathématique ?

Le Qwen3-32B Dense obtient les meilleurs scores sur les benchmarks de raisonnement :

- AIME 2025,

- Arena Hard,

- LiveBench Math.

Le Qwen3-30B-A3B reste proche sur les tâches générales, mais légèrement moins stable sur les suites d’équations ou la planification complexe. Source : LLM-Stats.

Les modèles Qwen 3 supportent-ils le français et d’autres langues ?

Oui. Tous les modèles ont été entraînés sur 36 000 milliards de tokens couvrant 119 langues et dialectes. Selon le rapport Qwen 3 sur arXiv, cette couverture linguistique est l’une des plus étendues parmi les modèles open source, dépassant Qwen 2.5 et rivalisant avec Gemini 1.5. Le français est pleinement pris en charge, avec un très bon équilibre entre grammaire, cohérence et ton naturel.

Où télécharger les modèles Qwen 3 ?

Les modèles officiels sont disponibles sur :

Les formats proposés incluent :

- Safetensors (FP16, FP8),

- GGUF (Q4, Q5, Q6, Q8),

- et des versions optimisées pour vLLM et Unsloth.

Qwen 3 est-il compatible avec Ollama ou LM Studio ?

Oui. Les versions quantisées (GGUF) sont déjà disponibles pour LM Studio, Ollama et KoboldCPP. La communauté a confirmé la compatibilité avec Windows, macOS et Linux. Les performances varient selon la quantisation :

- Q4_K_M pour un compromis vitesse/qualité,

- Q6_K pour un rendu plus précis,

- Q8_0 pour la génération longue ou la traduction.

Quelle version choisir pour un usage offline ou mobile ?

- Qwen3-4B → PC bas/moyen de gamme (GPU 8 Go).

- Qwen3-1.7B → laptop, exécution CPU rapide.

- Qwen3-0.6B → Raspberry Pi, IoT, commandes textuelles simples.

Ces modèles légers se chargent instantanément, mais restent limités en raisonnement et en cohérence longue.

Qwen 3 est-il open source ?

Oui. Tous les modèles Qwen 3 sont publiés en poids ouverts (open weight) sous une licence permissive similaire à celle de Qwen 2.5. Cela permet un usage commercial, la modification et le fine-tuning local. Les fichiers sont disponibles en FP16, INT8, FP8 et Q4, facilitant l’intégration dans tout pipeline IA.

Conclusion

La gamme Qwen 3 illustre parfaitement la nouvelle génération de modèles IA open source : performants, scalables et accessibles à tous les niveaux de matériel. De la puissance du Qwen3-235B-A22B, taillée pour les clusters de recherche, jusqu’au Qwen3-4B conçu pour le local computing, chaque version a une raison d’être.

Le Qwen3-30B-A3B s’impose comme le meilleur choix global pour une exécution locale fluide sur GPU 32 Go. Il combine la vitesse du Mixture-of-Experts et la stabilité nécessaire pour les tâches de production ou d’assistance IA. Pour ceux qui cherchent la précision absolue, notamment en raisonnement logique, le Qwen3-32B Dense reste la référence. Les modèles 14B et 8B constituent quant à eux d’excellents points d’entrée pour les utilisateurs grand public ou les équipes R&D disposant d’un GPU moyen.

Enfin, les petites variantes (4B, 1.7B, 0.6B) confirment la polyvalence du projet : elles rendent possible une IA locale, économe et instantanée, même sur CPU ou micro-appareils. Ce spectre complet fait de Qwen 3 une alternative sérieuse aux modèles fermés, notamment pour les développeurs cherchant à intégrer une IA multilingue et rapide dans leurs outils sans dépendre du cloud.

Pour aller plus loin, tu peux explorer :

- la documentation officielle QwenLM,

- les fiches modèles sur Hugging Face,

- et les comparatifs communautaires sur LLM-Stats.

En résumé

| Besoin | Modèle recommandé | Points forts |

|---|---|---|

| IA de recherche / Cloud | Qwen3-235B-A22B | puissance extrême, long contexte |

| IA locale haut de gamme | Qwen3-30B-A3B | rapidité, efficacité, MoE |

| Précision maximale / raisonnement | Qwen3-32B Dense | stabilité, rigueur logique |

| Polyvalence / serveur IA | Qwen3-14B | bon équilibre VRAM / performances |

| PC grand public | Qwen3-8B | fluide, léger, multilingue |

| Edge / embarqué | Qwen3-4B / 1.7B / 0.6B | latence faible, CPU compatible |

En 2025, Qwen 3 confirme la maturité de l’open source face aux solutions propriétaires. Il offre une modularité et une efficacité qui font écho aux besoins actuels : performance, indépendance et transparence. Que tu sois chercheur, développeur ou simple passionné, il existe désormais un modèle Qwen 3 à ton image, du GPU de salon au data center.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !