Actualités IA pour développeurs : les mises à jour essentielles

L’accélération des évolutions IA impose aux développeurs, ingénieurs machine learning et équipes MLOps une veille continue. Les semaines récentes ont apporté une vague dense de changements côté API, modèles, runtimes, frameworks open source et outils d’orchestration. Cette page, mise à jour régulièrement, synthétise les signaux techniques vraiment utiles, ceux qui influencent directement vos pipelines, votre performance et vos coûts d’inférence. L’objectif est simple, séparer l’essentiel du bruit et identifier ce que les développeurs doivent ajuster maintenant. Pour un aperçu complémentaire et les tendances générales de l’intelligence artificielle, vous pouvez également consulter les actualités IA de la semaine.

L’essentiel pour les développeurs IA

Entre l’évolution rapide des API multimodales, la montée en complexité du pricing et les optimisations des runtimes, l’écosystème IA bascule vers un modèle où la performance ne dépend plus seulement du modèle choisi, mais de l’ensemble de la chaîne, du raisonnement contrôlé aux optimisations hardware. Les modèles majeurs, Gemini 3, Claude 4.5, DeepSeek V3.2, ont tous introduit des ajustements structurels, tandis que vLLM, TensorRT-LLM et ONNX Runtime poursuivent une course à la latence minimale et à la compatibilité maximale.

Cette section offre une vue panoramique avant d’entrer dans les détails.

| Domaine | Outil / Modèle | Version / Changement | Impact pour les développeurs |

|---|---|---|---|

| APIs et SDK | Gemini 3 | Contexte 1M, contrôle thinking_level, outils concurrents | Meilleur contrôle de la profondeur de raisonnement, latence réduite, coûts multimodaux plus bas. |

| APIs et SDK | Claude 4.5 | Raisonnement hybride renforcé, sécurité anti-injection | Comportement plus prévisible des agents, meilleure gestion des entrées non fiables. |

| APIs et SDK | DeepSeek V3.2 | Architecture reasoning-first, tool-use amélioré | Reproductibilité accrue et étapes de raisonnement plus lisibles pour workflows d’évaluation. |

| Runtimes d’inférence | vLLM | Scheduler plus stable, meilleur support multimodal | Throughput plus constant et latence réduite sur workloads longs ou mixtes. |

| Runtimes d’inférence | TensorRT-LLM | Optimisations MoE et kernels adaptés Hopper | Inférence GPU plus rapide et plus déterministe pour déploiements sensibles à la latence. |

| Runtimes d’inférence | ONNX Runtime | Optimisations attention CPU/ARM et opérateurs | Meilleure performance edge et hybride, sans dépendance au GPU. |

| Runtime local | MLX (Apple Silicon) | Améliorations kernel et mécanismes de cache | Prototypage plus rapide sur machines M-series, inférence long-contexte plus fluide. |

| Frameworks | LangGraph 1.0 | Agents durables, orchestration structurée | Agents multi-étapes plus fiables, workflows résumables, meilleure auditabilité. |

| Multimodal | HunyuanVideo 1.5 | Attention longue SSTA pour vidéo | Usage VRAM réduit, meilleure cohérence temporelle pour la génération vidéo. |

| Multimodal | FLUX.2 | Encodeur Mistral 3 Small, multi-image conditioning | Alignement prompt amélioré et pipelines de diffusion plus contrôlables. |

| Infrastructure | SageMaker | Plans d’inférence flexibles | Capacité GPU plus prévisible, moins de cold starts, latence plus stable. |

| Infrastructure | NVIDIA PyTorch 25.11 | Support FP8, dépréciation Volta | Efficacité accrue sur Hopper, nécessité de planifier la transition des anciens GPU. |

| Pricing | Gemini Grounding | Passage à une facturation à l’usage | Demande un monitoring serré des workloads avec retrieval intensif. |

Ce qui change dans les API IA

Les API constituent la couche la plus visible pour les développeurs, mais aussi la plus sujette à des modifications opaques. Les dernières semaines ont vu plusieurs changements significatifs qui influencent prompts, coûts et structure des appels modèles.

Ajustements majeurs dans Gemini 3

Gemini 3 introduit un contrôle explicite du niveau de raisonnement, documenté dans son changelog officiel. Cette granularité permet d’équilibrer coût et précision sans modifier profondément les prompts. Pour les workloads documentaires ou les pipelines utilisant un long contexte, la nouvelle gestion de la vision et des résolutions d’image réduit la charge en tokens, ce qui améliore la performance et diminue la facture d’inférence.

| Fonction / Mise à jour | Description | Impact pour les développeurs |

|---|---|---|

| Fenêtre de contexte 1M tokens | Support long-contexte étendu pour le texte et les entrées multimodales | Permet d’ingérer de grands documents, d’allonger les chaînes de raisonnement et de regrouper plusieurs sources dans un même contexte |

| Paramètre thinking_level | Profondeur de raisonnement et complexité des étapes ajustables | Contrôle précis de la latence par rapport à la qualité du raisonnement |

| Exécution concurrente d’outils | Possibilité d’exécuter plusieurs outils dans un seul appel API | Réduit l’overhead d’orchestration, accélère les workflows d’agents multi-étapes |

| Résolution média ajustable | Granularité configurable pour les entrées image et vidéo | Diminue la consommation de tokens dans les pipelines multimodaux |

| Gestion multimodale améliorée | Meilleur alignement entre texte, images et vidéo | Sorties plus fiables dans les tâches multimodales complexes |

| Changement de tarification Grounding API | Passage à une facturation basée sur l’usage | Nécessite optimisation des appels, monitoring actif et stratégies de batching |

| Planning et retrieval améliorés | Comportement plus stable dans les workflows augmentés par la recherche | Meilleure performance pour les systèmes agentiques utilisant Search Grounding |

| Amélioration des sorties structurées | Réponses basées sur des schémas plus prévisibles | Intégration facilitée dans les pipelines de production nécessitant un format strict |

Claude 4.5, sécurité renforcée et stabilité accrue

Anthropic détaille sur son Transparency Hub les améliorations de Claude 4.5. La principale concerne la résistance aux attaques par injection, notamment pour les agents manipulant du code utilisateur ou des instructions structurées. Les équipes MLOps gagneront en prévisibilité, car Claude stabilise davantage la transition reasoning interne → final output.

(Cliquez pour agrandir)

DeepSeek V3.2, logique reasoning-first

Les notes publiques indiquent un renforcement de la séparation entre reasoning interne et tool use. Cette approche améliore la traçabilité, rend les logs plus lisibles et facilite les tests multiruns. Pour les pipelines nécessitant reproductibilité et auditabilité, DeepSeek V3.2 devient particulièrement pertinent.

Impacts directs sur vos workflows

Ces évolutions nécessitent quatre types d’ajustements :

- réviser les prompts dont la structure repose sur un pattern reasoning fixe,

- contrôler les tokens consommés pour les workloads multimodaux,

- auditer la stabilité multirun,

- ajuster les tests CI/CD pour refléter les nouvelles signatures de sortie.

Les mises à jour introduites par Gemini 3, Claude 4.5 et DeepSeek V3.2 modifient la manière dont les développeurs doivent écrire, tester et optimiser leurs appels API. Même si leurs approches diffèrent, les trois modèles s’accordent sur une tendance claire, davantage de contrôle sur le raisonnement, plus de stabilité multirun et une granularité plus fine dans les coûts liés au multimodal et aux opérations tool-use. Le tableau ci-dessous synthétise les actions concrètes à appliquer pour maintenir des workflows fiables, prévisibles et économiquement viables.

| API / Modèle | Actions sur les prompts | Tests multirun | Validation des sorties | Contrôle des coûts |

|---|---|---|---|---|

| Gemini 3 | Ajuster thinking_level, limiter la résolution multimodale | Vérifier cohérence du reasoning | Tester schémas d’output, cohérence image/texte | Réduire résolution médias, surveiller appels Grounding API |

| Claude 4.5 | Renforcer contraintes structurelles, expliciter étapes | Tester robustesse injection | Vérifier outputs structurés, cohérence reasoning hybride | Minimiser étapes inutiles, optimiser chaîne agentique |

| DeepSeek V3.2 | Exploiter reasoning-first, prompts plus courts et directs | Vérifier stabilité reasoning interne | Contrôler logs reasoning vs tool-use | Optimiser longueur des appels, réduire usage outils externes |

| API multimodales | Segmenter textes, limiter nombre d’images | Tester alignement texte-image | Vérifier cohérence intermodale | Ajuster résolution images, batcher les appels |

| API agentiques | Définir rôle, objectifs, limites des outils | Tester outils concurrents | Vérifier transitions reasoning → tool-use | Réduire appels superflus, mutualiser étapes |

| API long-contexte | Préparer documents propres, éviter duplications | Tester variance selon volume | Valider extraction et ancrage corrects | Segmenter documents, réduire contexte inutile |

Nouveaux comportements modèles

L’IA moderne repose désormais autant sur les comportements internes que sur les capacités déclarées. Les modèles évoluent plus vite que jamais, ce qui impose aux développeurs une compréhension précise de leurs zones de force et de leurs limites.

Comparatif express entre Gemini, Claude et DeepSeek

Les différences observées dans l’article anglais se retrouvent consolidées ici :

- Gemini 3 : excellentes capacités multimodales, vision avancée, solide gestion du long contexte, bon compromis entre coût et performance en tâches documentaires.

- Claude 4.5 : performance remarquable en raisonnement structuré, cohérence élevée, meilleure sécurité intégrée, idéal pour agents procéduraux ou manipulation de code.

- DeepSeek V3.2 : très bonne explicabilité interne, particulièrement robuste pour workflows nécessitant traçabilité, moins coûteux en tokens sur certains usages.

Les modèles Gemini 3, Claude 4.5 et DeepSeek V3.2 adoptent des stratégies très différentes pour gérer le raisonnement, la multimodalité et la cohérence interne. Pour les développeurs, comprendre ces distinctions permet d’adapter prompts, workloads et runtimes afin d’obtenir des performances plus stables et des coûts mieux maîtrisés. Le tableau suivant résume les capacités clés réellement observables dans des environnements de production.

| Modèle | Raisonnement (qualité / structure) | Multimodalité | Long contexte | Reproductibilité / Traçabilité | Coûts et efficacité |

|---|---|---|---|---|---|

| Gemini 3 | Raisonnement flexible avec thinking_level, bon équilibre cohérence/latence | Excellent en image et vidéo, alignement texte-image fort | Très performant sur long contexte (documents volumineux) | Reproductibilité correcte mais moins explicite que DeepSeek | Coûts optimisables via résolution multimodale et batching |

| Claude 4.5 | Raisonnement hybride très structuré, cohérence élevée | Multimodalité fiable mais moins avancée que Gemini | Gère bien le long contexte avec stabilité reasoning | Très forte prévisibilité, comportement agentique stable | Coût stable, bonne efficacité en prompts structurés |

| DeepSeek V3.2 | Raisonnement-first, étapes internes très lisibles, idéal pour audit | Multimodalité correcte mais non spécialisée | Long contexte bien supporté, adapté analyse séquentielle | Reproductibilité supérieure grâce à séparation reasoning/tool-use | Très efficace en tokens, surtout workflows auditables |

Multimodalité et traitements complexes

Les modèles évoluent vers une meilleure synchronisation image ↔ texte, particulièrement Gemini et HunyuanVideo côté open source. La réduction de l’incohérence entre frames, combinée au support de résolutions ajustables, ouvre des usages plus complexes : aide à l’analyse d’écrans, extraction structurée depuis supports visuels, contrôles qualité sur pipelines industriels.

Recommandations selon cas d’usage

- agents décisionnels : Claude,

- pipelines vidéo ou image-riches : Gemini + HunyuanVideo,

- systémes nécessitant auditabilité : DeepSeek,

- environnements budget contraint : modèles reasoning-first compressés ou quantifiés via runtimes optimisés.

Runtimes, les optimisations critiques à connaître

Les runtimes conditionnent la performance réelle d’inférence. Ils représentent aujourd’hui un élément stratégique pour réduire la latence, stabiliser les workloads et maîtriser les coûts opérationnels.

vLLM continue d’améliorer son scheduler

Les dernières évolutions publiées dans les releases GitHub corrigent des variations de latence et stabilisent la gestion du batch. Le multimodal est mieux pris en charge, ce qui rend vLLM plus adapté à des agents où texte et image coexistent.

Pour un aperçu plus pratique des usages locaux et des différences d’implémentation entre serveurs LLM, un comparatif dédié présente les avantages et limites d’Ollama et de vLLM, ainsi que les cas où chaque solution s’impose réellement. Comme détaillé dans l’article Ollama vs vLLM : quelle solution choisir pour servir vos modèles LLM en local ?

TensorRT-LLM, gain notable sur Hopper et MoE

Les release notes NVIDIA mettent en avant :

- une latence fortement réduite pour les architectures MoE,

- des gains significatifs pour les modèles FP8 sur H100/H200,

- une meilleure parallélisation pour tâches séquentielles.

TensorRT-LLM devient un choix naturel pour applications temps réel ou assistants embarqués.

ONNX Runtime, le retour du CPU/ARM dans la course

Les améliorations CPU/ARM décrites dans la documentation ONNX Runtime permettent désormais des workloads IA viables sans GPU. Cela ouvre des usages edge, industrial IoT ou serveurs à ressources limitées.

MLX pour Apple Silicon

MLX facilite un prototypage rapide sur Mac, permettant d’itérer prompts et workflows avant de déployer dans des environnements cloud hybrides.

Quel runtime choisir ?

Le choix du runtime d’inférence dépend désormais autant de l’environnement matériel que du modèle utilisé. Les optimisations récentes de vLLM, TensorRT-LLM, ONNX Runtime et MLX modifient les arbitrages habituels entre latence, VRAM, scalabilité et coûts. Le tableau suivant synthétise les critères opérationnels pour sélectionner le runtime le mieux adapté à votre infrastructure.

| Environnement | Runtime recommandé | Avantages techniques clés | Limites / Points de vigilance | Quand l’utiliser |

|---|---|---|---|---|

| Cloud GPU | vLLM | Excellent throughput, batching efficace, stabilité multimodale | Peut nécessiter tuning batch pour workloads hétérogènes | Déploiements scalables, assistants multimodaux, long contexte |

| TensorRT-LLM | Latence minimale, kernels optimisés Hopper, support MoE performant | Dépend fortement des GPU NVIDIA récents | Temps réel, agents interactifs, production à forte contrainte | |

| On-prem GPU | TensorRT-LLM | Très performant sur H100/H200, predictable scheduling | Moins flexible que vLLM pour workloads mixtes | Infra interne haute performance, workloads déterministes |

| vLLM | Mise en œuvre simple, bon scaling, support large modèles | Moins optimisé que TensorRT-LLM pour latence extrême | On-prem généraliste, RAG, assistants internes | |

| CPU / ARM | ONNX Runtime | Optimisations attention CPU/ARM, opérateurs légers | Moins efficace sur très long contexte | Edge computing, IoT, environnements à ressources limitées |

| Apple Silicon (M-series) | MLX | Prototypage rapide, inference local fluide, faible overhead | Pas conçu pour production intensive | Développement, tests de prompts, workflows exploratoires |

Open source et nouveaux outils

L’écosystème open source continue de progresser à un rythme soutenu, influençant directement la façon dont les agents, workflows et outils de production sont construits.

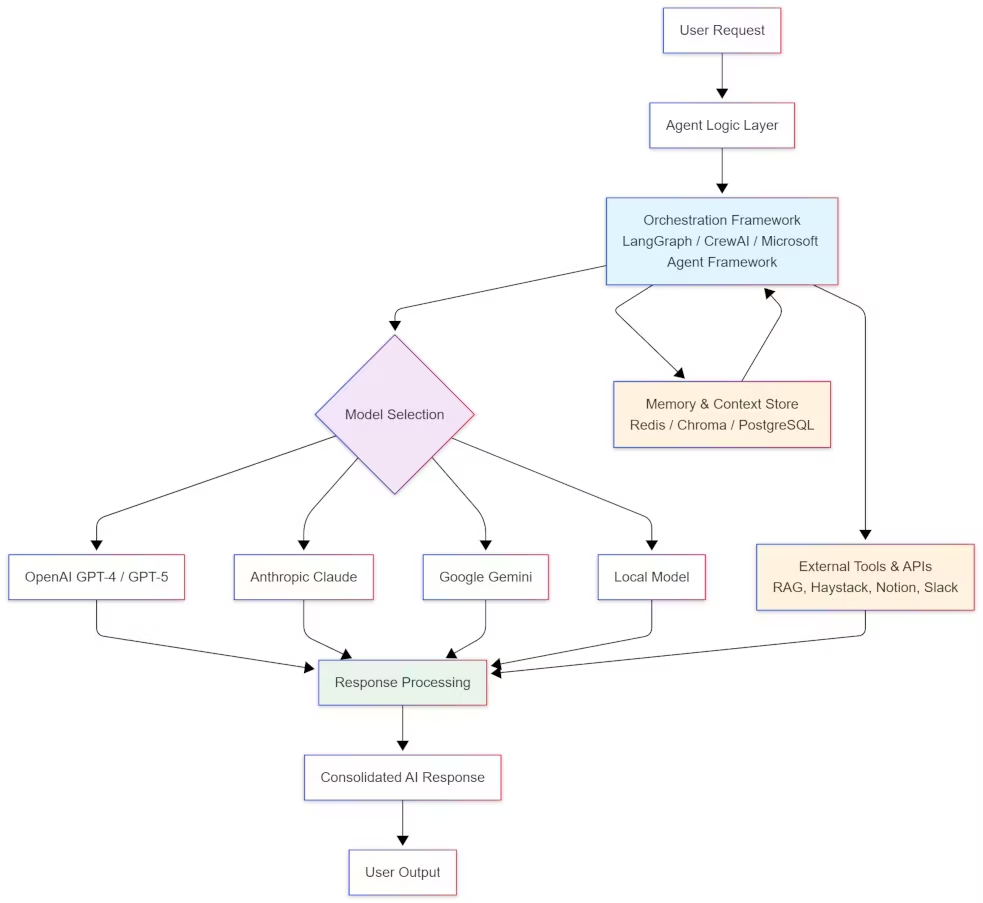

LangGraph 1.0, vers des agents réellement durables

LangGraph introduit une orchestration robuste et traçable, idéal pour des systèmes multiétapes où les interruptions ne doivent pas rompre la logique du workflow. L’annonce détaillée est disponible sur le changelog LangGraph.

Pour une analyse approfondie du rôle de cette version 1.0 dans la maturation de l’écosystème LangChain, un article dédié détaille les avancées majeures introduites par LangGraph 1.0. Une seconde analyse explique également pourquoi LangGraph s’impose aujourd’hui comme l’ossature open source des agents IA modernes et comment ce cadre redéfinit les architectures d’orchestration.

Diffusers, HunyuanVideo 1.5 et FLUX.2

Open source multimodal :

- HunyuanVideo 1.5 améliore la cohérence vidéo longue, https://huggingface.co/tencent/HunyuanVideo-1.5

- FLUX.2 propose une meilleure précision du multi-image conditioning, https://huggingface.co/blog/flux-2

Ces outils deviennent centraux pour les développeurs construisant des assistants multimodaux complexes.

Mettre en place une veille GitHub pour anticiper les changements critiques

Les dépôts vLLM, TensorRT-LLM, ONNX Runtime, Diffusers et LangGraph publient des correctifs fréquents. Une veille par équipe devient indispensable pour éviter les régressions et anticiper les dépréciations.

Performance, latence et throughput

L’ensemble de l’écosystème IA s’oriente vers l’optimisation. Les développeurs ont désormais besoin de mesures précises et régulières pour comprendre comment évoluent leurs workloads.

Tests recommandés

- latence moyenne et p95,

- throughput en batch,

- consommation VRAM,

- cohérence multirun,

- stabilité du streaming sur long contexte.

Ces tests doivent être relancés à chaque mise à jour des runtimes ou SDK.

Les évolutions rapides des API, runtimes et modèles imposent une discipline opérationnelle stricte. Pour éviter les régressions silencieuses, contenir les coûts et maintenir la fiabilité des systèmes, les équipes doivent réaliser chaque semaine une série d’actions de vérification. Le tableau ci-dessous synthétise les contrôles essentiels inspirés des comportements observés dans Gemini 3, Claude 4.5, DeepSeek V3.2, vLLM, TensorRT-LLM et ONNX Runtime.

| Domaine | Actions hebdomadaires recommandées | Objectif opérationnel |

|---|---|---|

| APIs (Gemini / Claude / DeepSeek) | Vérifier variations de latence et cohérence reasoning sur mêmes prompts | Détecter changements de comportement non documentés |

| Tester multirun (mêmes entrées, sorties stables ?) | Surveiller dérives dans reasoning, hallucinations, format des outputs | |

| Auditer consommation de tokens, surtout multimodal | Maîtriser les coûts, ajuster résolutions et structure des prompts | |

| Valider schémas d’output dans pipelines à format strict | Éviter erreurs silencieuses dans systèmes de production | |

| Runtimes (vLLM / TensorRT-LLM / ONNX Runtime) | Mesurer latence p50/p95, throughput batch et VRAM consommée | Identifier régressions après upgrades |

| Tester streaming sur long contexte | Vérifier stabilité sur workloads complexes | |

| Comparer résultats avant / après mise à jour runtime | Prévenir divergences silencieuses | |

| Surveiller compatibilité hardware (Hopper, CPU/ARM, M-series) | Optimiser l’environnement selon le runtime choisi | |

| Modèles IA (Gemini / Claude / DeepSeek) | Vérifier cohérence image ↔ texte pour les workloads multimodaux | Détecter régressions sur les alignements |

| Tester prompts critiques en production | S’assurer qu’aucune mise à jour n’affecte les cas sensibles | |

| Valider behavior sur agents multi-outils | Surveiller transitions reasoning → tool-use | |

| Coûts & Pricing | Monitorer coûts API (Grounding, multimodal, appels agents) | Éviter surprises de facturation |

| Identifier appels inutiles ou trop fréquents | Optimiser structure des workflows | |

| Ajuster résolutions images/vidéo et batchs | Réduire la consommation de tokens | |

| Qualité & Observabilité | Vérifier logs reasoning, tool-use, étapes internes | Améliorer auditabilité et traçabilité |

| Mettre à jour tableaux internes de compatibilité | Maintenir vues consolidées des versions supportées | |

| Tester mécanismes de fallback et retries | Assurer résilience en production |

Impacts sur vos pipelines

Ces évolutions cumulées entraînent une série d’ajustements nécessaires pour maintenir des workflows fiables.

Vérifications CI/CD

Les tests contractuels doivent être mis à jour pour s’adapter aux changements de formats, aux sorties multimodales et aux variations de reasoning interne.

Ajustements prompts et configurations

Réduire la profondeur de reasoning pour diminuer les coûts, ajuster les batchs en fonction des optimisations runtime, revoir la segmentation des tâches agentiques.

Monitoring et observabilité

Les mises à jour fréquentes des API et des runtimes introduisent des variations parfois subtiles dans le raisonnement interne, la latence ou la structure des sorties. L’observabilité devient donc un composant essentiel des workflows IA. Elle doit suivre non seulement les métriques classiques de performance, mais aussi la cohérence multirun, les transitions reasoning → tool-use et la stabilité des formats de sortie. Les modèles comme DeepSeek V3.2, qui explicitent la séparation entre raisonnement interne et actions, montrent à quel point cette traçabilité est devenue indispensable. Un monitoring fin, associé à l’audit systématique des logs et des dérives de coûts, est désormais la seule manière de maintenir des systèmes IA fiables à mesure que les modèles évoluent.

Points clés et perspectives

Les trois priorités immédiates

- Auditer les API et ajuster les prompts pour éviter les dérives de coûts.

- Tester les runtimes sur l’infrastructure réelle afin d’optimiser latence et throughput.

- Mettre à jour les tests CI/CD et surveiller les formats de sortie des modèles.

Risques à court terme

- breaking changes dans runtimes et frameworks,

- variations du comportement multimodal,

- coûts cachés liés aux appels agentiques,

- incompatibilités GPU (dépréciation Volta, Turing).

Perspectives

L’écosystème bascule vers des workflows plus modulaires, mieux observables, et optimisés pour des environnements hybrides mêlant GPU, CPU/ARM et edge. Les équipes capables d’industrialiser leur veille technique et leur observabilité auront un avantage significatif dans les mois à venir.

Pour aller plus loin sur les approches indépendantes des fournisseurs et concevoir des agents réellement portables, un guide dédié explique comment construire des agents IA autonomes par rapport aux LLM sous-jacents.

Pour une analyse encore plus détaillée, incluant des benchmarks, des comparaisons de runtimes et des perspectives techniques étendues, vous pouvez consulter la version anglaise de cet article : Developer AI News : Latest Updates for Engineers, disponible sur cosmo-edge.com.

Sources et références

Médias technologiques

- Ars Technica souligne l’importance croissante des runtimes dans la maîtrise des coûts IA. https://arstechnica.com

- The Verge note la montée en puissance des modèles multimodaux complexes. https://www.theverge.com

Entreprises

- Google détaille les nouveautés Gemini dans son changelog officiel. https://ai.google.dev/gemini-api/docs/changelog

- Anthropic explique les protections renforcées de Claude 4.5. https://www.anthropic.com/transparency

- DeepSeek documente les évolutions reasoning-first. https://api-docs.deepseek.com/news/news251201

- NVIDIA détaille ses optimisations Hopper et MoE pour TensorRT-LLM. https://nvidia.github.io/TensorRT-LLM/release-notes.html

Open source et runtimes

- Releases vLLM, améliorations batch et multimodal. https://github.com/vllm-project/vllm/releases

- ONNX Runtime, optimisations CPU/ARM. https://onnxruntime.ai/docs/get-started/with-python.html

- LangGraph 1.0, agent orchestration. https://changelog.langchain.com/announcements/langgraph-1-0-is-now-generally-available

- HunyuanVideo 1.5. https://huggingface.co/tencent/HunyuanVideo-1.5

- FLUX.2. https://huggingface.co/blog/flux-2

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !