Comment construire des agents IA indépendants de tout fournisseur LLM

En 2025, la question de l’indépendance technologique dans l’intelligence artificielle est devenue centrale. Les entreprises, comme les développeurs, cherchent à créer des agents IA indépendants, capables de fonctionner sans dépendre d’un fournisseur unique de modèle de langage. Cette évolution marque une rupture avec les premières générations d’agents intégrés exclusivement à OpenAI ou Claude, et ouvre la voie à une nouvelle ère : celle de l’autonomie IA.

Derrière cette tendance, une idée clé : reprendre le contrôle. Le marché des LLM (Large Language Models) évolue vite, les coûts et politiques d’accès changent souvent, et le risque de vendor lock-in devient une menace directe pour la souveraineté des données et la pérennité des applications. Construire un framework open source IA, capable de dialoguer avec plusieurs modèles en parallèle, n’est plus une option : c’est une condition pour garantir la résilience, la conformité et la maîtrise des coûts.

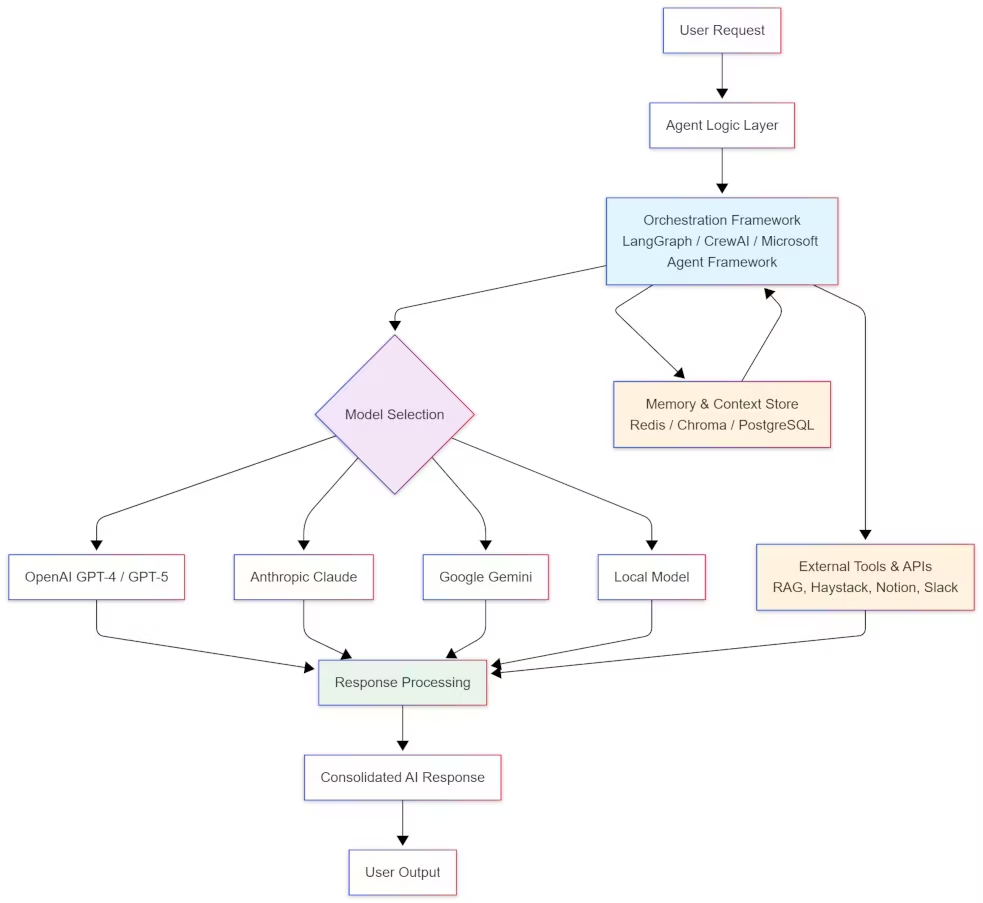

Cette approche, dite LLM-agnostique, repose sur des frameworks comme LangGraph, CrewAI ou le Microsoft Agent Framework, qui incarnent aujourd’hui l’avant-garde de l’orchestration d’agents IA. Ces outils permettent d’exécuter une même logique agentique sur différents modèles : OpenAI, Claude, Gemini, Mistral ou d’autres LLM, même executés sur vLLM ou Ollama. L’objectif : combiner performance, indépendance et souveraineté sans compromettre la qualité de l’expérience utilisateur.

Une évolution stratégique : du modèle unique à l’architecture multi-LLM

Jusqu’à récemment, la majorité des agents d’intelligence artificielle dépendaient d’un seul fournisseur de modèle. Cette centralisation simplifiait le développement, mais enfermait les systèmes dans des logiques propriétaires. En 2025, la situation s’est inversée : les grandes plateformes (OpenAI, Anthropic, Google) imposent des changements tarifaires et techniques fréquents, tandis que l’écosystème open source progresse à grande vitesse avec des alternatives comme Llama, Mistral, Qwen, GPT-OSS ou DeepSeek.

Le multi-LLM est donc devenu la norme. En s’appuyant sur des frameworks open source IA, les développeurs peuvent intégrer plusieurs modèles dans un même pipeline, selon les besoins : rapidité, coût, précision ou contexte. Un agent conversationnel peut par exemple utiliser Claude pour la compréhension, ChatGPT pour la génération de code et un modèle local Mistral pour la synthèse rapide de texte.

Comme le souligne la documentation de LangGraph, cette approche découple la logique de l’agent du modèle sous-jacent, permettant de changer de fournisseur sans réécrire le code. C’est un pas vers une architecture agentique réellement interopérable, capable de s’adapter aux contraintes du marché.

Pourquoi l’indépendance LLM devient essentielle

Résilience et souveraineté des données

La résilience technologique est l’un des piliers des architectures modernes. Une panne, un changement d’API ou une hausse de prix d’un fournisseur peut désormais paralyser une application critique. En rendant les agents IA LLM-agnostiques, les entreprises se prémunissent contre ce type de risque.

L’autre enjeu est la souveraineté des données. Comme le rappelle Microsoft dans la présentation du Microsoft Agent Framework, les entreprises doivent pouvoir exécuter leurs agents sur site (on-prem), dans un cloud privé ou hybride pour respecter les réglementations (RGPD, FedRAMP). Les architectures hybrides et le concept BYOC (Bring Your Own Cloud) deviennent alors des garanties de conformité et de contrôle.

Optimisation économique et performance adaptative

Le multi-LLM introduit aussi une nouvelle forme d’arbitrage économique. Les tâches simples peuvent être déléguées à un modèle open source léger, tandis que les requêtes critiques utilisent des LLM premium. CrewAI et LangGraph permettent ce routage dynamique grâce à des politiques conditionnelles intégrées, comme détaillé dans leurs documentations respectives.

Ce principe optimise la performance tout en réduisant les coûts : un agent peut basculer automatiquement d’un modèle commercial à un modèle local si le premier atteint ses quotas ou si la qualité de réponse diminue. Un LLM personnalisé avec les données de l’entreprise peut également être utilisé. Ce type de stratégie, déjà appliqué par les équipes Azure via le Microsoft Agent Framework, redéfinit la gestion des flux IA à grande échelle.

Les trois frameworks de référence : LangGraph, CrewAI, Microsoft Agent Framework

| Critère | LangGraph | CrewAI | Microsoft Agent Framework |

|---|---|---|---|

| Origine / Éditeur | Développé par LangChain | Projet open source indépendant | Microsoft (fusion d’AutoGen et Semantic Kernel) |

| Architecture | Basée sur un graphe d’exécution (chaque nœud = étape, outil ou sous-agent) | Organisation en équipes d’agents spécialisés (“crew”) | Infrastructure modulaire et centralisée, pensée pour la production |

| Philosophie | Orchestration robuste et mémoire persistante | Collaboration multi-agents, approche distribuée | Gouvernance, conformité et observabilité d’entreprise |

| Persistance d’état / Mémoire | Oui, via Redis, PostgreSQL ou Chroma (mémoire externe durable) | Non native, dépend des intégrations externes | Oui, intégrée à Azure (stockage et reprise de contexte) |

| Multi-LLM | Support indirect via LangChain | Oui, un LLM différent par agent possible | Oui, compatible avec plusieurs LLM via connecteurs Azure |

| Interopérabilité | Compatible LangChain, LangSmith, Qdrant, Chroma | Intégration avec +100 outils (Gmail, Notion, Slack, etc.) + MCP | Connecté à l’écosystème Microsoft (Azure, Entra ID, Power Platform) |

| Observabilité / Supervision | Oui, via LangSmith (self-hosted ou cloud) | Basique, orientée logs ou monitoring externe | Intégrée (Azure Monitor, Log Analytics) |

| Cas d’usage typique | Orchestration d’agents complexes, mémoire longue, projets multi-LLM | Collaboration IA entre rôles spécialisés, automatisation de tâches variées | Déploiements en entreprise nécessitant conformité et traçabilité |

| Niveau de maturité | Très stable, éprouvé en production | En développement actif, flexible mais moins standardisé | Récent mais soutenu par Microsoft, adoption rapide |

| Cible principale | Développeurs et architectes IA | Équipes d’automatisation et makers | Entreprises soumises à des normes de sécurité et conformité |

| Licence / Open Source | Open source (LangChain ecosystem) | Open source | Open source (MIT, Microsoft GitHub) |

LangGraph : orchestration robuste et mémoire durable

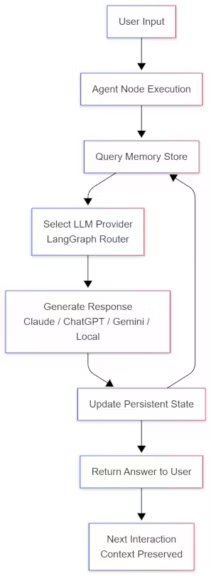

Développé par LangChain, LangGraph est devenu la référence des frameworks open source IA pour orchestrer des agents complexes et durables. Il repose sur une architecture en graphe, où chaque nœud représente une étape, un outil ou un sous-agent. Cette structure rend les flux de décision transparents et parallélisables, ce qui facilite la maintenance et le débogage.

LangGraph se distingue par sa persistance d’état, notamment grâce à l’intégration de bases vectorielles et de systèmes de stockage externes comme Redis, PostgreSQL ou Chroma, qui conservent le contexte et la mémoire à long terme entre les sessions. Un agent peut ainsi reprendre sa tâche après une interruption sans perdre son contexte, grâce à sa mémoire externe intégrée. Associé à LangSmith, il offre une observabilité complète des workflows, indispensable pour les projets multi-LLM en production.

Pour aller plus loin : LangGraph : l’ossature open source des agents IA modernes

CrewAI : collaboration multi-agents et flexibilité opérationnelle

CrewAI adopte une approche plus collaborative. Il permet de composer des équipes d’agents IA (ou “crew”), chacun doté d’un rôle spécifique : chercheur, rédacteur, développeur, validateur. Chaque agent peut exploiter un LLM différent selon sa spécialité, une logique multi-LLM par agent bien décrite dans la documentation officielle.

Ce modèle reflète la réalité des workflows modernes : une organisation de tâches décentralisée, orchestrée par des rôles IA spécialisés. CrewAI s’intègre avec plus de 100 outils externes (Gmail, Notion, Slack, HubSpot) et prend en charge le Model Context Protocol (MCP), un standard d’interopérabilité adopté par Microsoft et OpenAI.

Microsoft Agent Framework : gouvernance et conformité d’entreprise

Dernier entrant mais déjà influent, le Microsoft Agent Framework unifie les projets AutoGen et Semantic Kernel dans une nouvelle base open source. Son objectif : offrir une infrastructure d’orchestration d’agents IA prête pour la production, conforme aux standards SOC2 et FedRAMP.

Ce framework s’adresse aux entreprises soumises à des contraintes fortes : il intègre la gestion des identités via Entra ID, des contrôles d’accès (RBAC), et une observabilité native avec Azure Monitor et Log Analytics. Son adoption rapide confirme que la gouvernance des agents IA devient un critère de confiance aussi important que la performance.

Architecture technique : les piliers d’un agent IA indépendant

Une logique découplée du modèle

La base d’un framework multi-LLM est la séparation entre logique métier et modèle de langage. La configuration s’effectue par variables d’environnement :

AGENT_LLM_PROVIDER=openai

AGENT_LLM_MODEL=gpt-5Ce découplage permet de substituer le modèle sans refondre le code. LangGraph et CrewAI s’appuient sur cette approche, garantissant une portabilité totale vers tout fournisseur compatible.

Recherche sémantique et RAG local

Les agents IA indépendants reposent souvent sur une stratégie RAG (Retrieval-Augmented Generation). En intégrant un moteur comme Haystack ou FAISS, l’agent peut rechercher des informations dans des bases vectorielles locales, limitant la dépendance aux API externes. Comme l’explique la documentation de Haystack, cette approche améliore la précision tout en renforçant la confidentialité.

Mémoire et contexte durable

Une architecture agentique efficace doit conserver l’historique des décisions. LangGraph et CrewAI offrent des systèmes de mémoire persistante basés sur une base vectorielle, comme Chroma, ainsi que Redis ou PostgreSQL. Ces composants assurent une continuité de raisonnement même après un redémarrage, élément clé de l’autonomie IA.

Sécurité, gouvernance et audit

Les agents multi-LLM interagissent avec des données sensibles. La gestion des secrets passe par des vaults comme HashiCorp Vault ou Azure Key Vault, tandis que le Microsoft Agent Framework intègre nativement l’authentification via Entra ID. Pour renforcer la conformité, Microsoft expérimente déjà des prompt shields et la détection automatique des PII, une approche que les frameworks open source peuvent reproduire via des middlewares comme Guardrails AI ou Rebuff.

Observabilité et traçabilité

L’observabilité est indispensable dans une architecture multi-LLM. LangGraph et LangSmith assurent le suivi des appels, de la latence et des erreurs. Les journaux d’exécution peuvent être exportés vers des tableaux de bord analytiques ou reliés à des outils de BI. CrewAI Studio offre un suivi visuel des flux et permet de rejouer les interactions pour ajuster les prompts ou les politiques de routage.

Routage multi-LLM : flexibilité, coût et résilience

Le routage multi-LLM transforme la dépendance en avantage. En fonction de la charge, du coût ou du délai, un agent peut sélectionner dynamiquement le modèle le plus approprié.

LangGraph propose une configuration simple :

AGENT_LLM_PROVIDER=anthropic

AGENT_LLM_MODEL=claude-opusChaque nœud peut ainsi utiliser un modèle différent. Cette modularité autorise un arbitrage intelligent : Claude pour la synthèse analytique, ChatGPT pour la génération, Gemini pour la recherche contextuelle, et un modèle local pour les requêtes internes.

Les stratégies les plus efficaces reposent sur un équilibre coût-latence-qualité :

- Heuristique : sélection fixe selon la tâche ;

- Apprentissage adaptatif : sélection dynamique selon la qualité de réponse ;

- Failover automatique : bascule vers un modèle secondaire en cas de panne ou quota atteint.

Le Microsoft Agent Framework documente déjà ces stratégies d’arbitrage dans Azure AI Foundry. Associées à des outils d’observabilité comme LangSmith ou Power BI, elles permettent un contrôle précis du coût par fournisseur et une traçabilité complète des décisions de routage.

Déploiement : cloud, on-prem et infrastructures hybrides

L’indépendance LLM passe aussi par le déploiement. Les frameworks modernes s’adaptent à tous les environnements :

- Cloud managé : via Azure AI Foundry pour un déploiement rapide avec supervision intégrée.

- On-prem ou BYOC : contrôle complet des données et coûts prévisibles. LangGraph fonctionne entièrement en autohébergé, avec monitoring via LangSmith.

- Hybride : combinaison des deux approches ; CrewAI permet de connecter des modèles locaux via Ollama ou vLLM, et des modèles distants selon le rôle des agents.

Les architectures hybrides offrent une solution équilibrée entre performance et souveraineté : le calcul intensif reste dans le cloud, tandis que les données sensibles demeurent sur site. C’est une approche privilégiée par les acteurs européens pour concilier conformité et innovation.

Évaluation continue et bonnes pratiques

L’efficacité d’un agent IA indépendant ne se mesure pas uniquement à la vitesse de réponse. Les frameworks comme LangGraph et le Microsoft Agent Framework introduisent des outils de benchmark qualité et de QA automatisée :

- Exact match, F1, évaluation humaine, latence p50/p95 ;

- Taux de fallback, coût par tâche, taux d’erreur ;

- A/B testing et canary releases pour comparer les modèles.

Les bonnes pratiques communes sont désormais claires :

- Externaliser la configuration (jamais de modèle codé en dur).

- Documenter chaque outil et le rendre idempotent. Plus simplement, garantir que plusieurs exécutions successives donnent toujours le même état final.

- Mettre en place une gouvernance claire : chiffrement, anonymisation, audit.

- Maintenir une observabilité constante (LangSmith, Azure Monitor).

Ces éléments, autrefois réservés au cloud, deviennent essentiels dans les déploiements on-prem IA ou hybrides.

Vers une autonomie IA réelle : analyse du marché 2025

L’émergence d’agents IA indépendants traduit un changement de paradigme. Après des années de domination du modèle “LLM centralisé”, les acteurs du marché explorent désormais la décentralisation de l’intelligence.

Cette tendance s’aligne avec l’évolution plus large de l’écosystème :

- OpenAI et Anthropic se recentrent sur des services premium ;

- Microsoft pousse le modèle agentic via Azure AI Foundry ;

- l’open source se structure autour d’initiatives comme LangGraph, CrewAI et vLLM, qui rendent la construction d’agents IA plus accessible, moins dépendantes des solutions propriétaire. Cela facilite également le prototypage avec des infrastructures hybrides et des LLM executés sur des serveurs d’entreprise ou postes de travail.

À moyen terme, les architectures multi-LLM devraient devenir la norme, avec des frameworks capables d’intégrer aussi bien des modèles propriétaires, personnalisés ou encore communautaires. L’autonomie IA ne signifie pas l’isolement, mais une capacité à orchestrer plusieurs intelligences selon le contexte, la confidentialité et le coût.

Le mouvement LLM-agnostique s’impose ainsi comme le prolongement naturel de l’open source : une recherche d’équilibre entre performance et indépendance, entre innovation rapide et gouvernance durable.

Conclusion : bâtir la résilience par l’ouverture

Construire un agent IA indépendant de tout fournisseur LLM n’est plus un simple défi technique : c’est une stratégie d’avenir. Les frameworks comme LangGraph, CrewAI et le Microsoft Agent Framework offrent déjà tous les outils nécessaires pour créer des systèmes LLM-agnostiques, capables de combiner plusieurs modèles, de s’exécuter en local ou dans le cloud, et de respecter les contraintes de conformité les plus strictes.

Cette approche garantit trois avantages majeurs :

- Liberté de choix technologique (plus de dépendance à un fournisseur) ;

- Optimisation des coûts et des performances via le routage multi-LLM ;

- Souveraineté et conformité grâce à des déploiements hybrides et audités.

L’autonomie IA n’est pas un idéal théorique. C’est déjà une réalité pour les organisations qui adoptent une architecture ouverte, résiliente et interopérable. En combinant la puissance du cloud et la maîtrise du local, elles préparent le futur d’une intelligence artificielle plus distribuée, plus transparente et véritablement durable.

Ressources et frameworks mentionnés

- LangGraph (LangChain) – orchestration d’agents IA et mémoire persistante.

- CrewAI – framework multi-agents open source avec support multi-LLM.

- Microsoft Agent Framework – gouvernance et conformité pour les agents d’entreprise.

- Haystack – moteur RAG open source pour recherche sémantique locale.

- LangSmith – observabilité et traçage des flux multi-LLM.

- Guardrails AI et Rebuff – sécurité et filtrage des prompts pour agents IA.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !