Réguler ou freiner ? L’Europe face à la pression de l’IA mondiale

Alors que les États-Unis et la Chine accélèrent leur course à l’intelligence artificielle, l’Union européenne temporise. Son texte phare, l’AI Act, voit son application reportée, victime d’un tiraillement entre innovation, sécurité et souveraineté numérique. Derrière cette hésitation, une question majeure se dessine : l’Europe peut-elle réguler l’IA sans se marginaliser sur la scène mondiale ?

Retrouvez les dernières actualités de la semaine en cours sur notre page principale, mise à jour régulièrement

L’AI Act européen : ambitions et réalités

Un cadre légal inédit pour encadrer l’intelligence artificielle

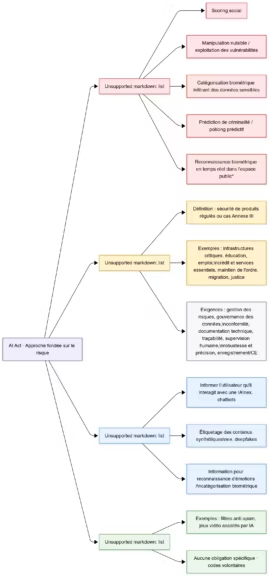

Adopté en 2024, l’AI Act est le premier cadre réglementaire global dédié à l’intelligence artificielle. Inspiré du RGPD, il vise à encadrer les systèmes d’IA selon leur niveau de risque, du chatbot grand public aux modèles de fondation comme ChatGPT ou Claude.

L’objectif est clair : garantir une IA digne de confiance, transparente, et respectueuse des droits fondamentaux. Le texte impose aux entreprises des obligations de documentation, d’audit et de supervision adaptées au niveau de risque identifié.

Mais derrière cette ambition éthique, l’Europe espère aussi s’imposer comme leader mondial de la régulation IA, à l’image du rôle qu’elle a tenu dans la protection des données personnelles.

Cliquez pour agrandir

Les ambitions politiques d’une régulation pionnière

L’AI Act traduit la volonté de Bruxelles d’affirmer sa souveraineté technologique. En fixant ses propres normes, l’Union cherche à imposer un modèle fondé sur la responsabilité, la sécurité et les droits humains.

Cette approche séduit de nombreux chercheurs et défenseurs du numérique éthique. Elle positionne l’Europe comme contrepoids aux logiques purement commerciales des États-Unis et au contrôle centralisé de la Chine.

Mais la mise en œuvre soulève une inquiétude persistante : une régulation trop contraignante pourrait freiner l’innovation et accentuer le retard européen en matière d’intelligence artificielle.

Premiers obstacles techniques et juridiques

Les premières critiques convergent sur trois points : complexité du texte, coûts élevés de conformité et flou juridique autour de la définition des “systèmes d’IA”.

Les obligations de conformité risquent de pénaliser les PME et start-ups européennes, déjà confrontées à des ressources limitées. En réaction, plusieurs États membres, dont la France et l’Allemagne, plaident pour une application progressive afin de ne pas étouffer leur compétitivité.

Une Europe qui temporise sous la pression mondiale

Le report partiel de l’application du texte

Selon Financial Times, la Commission européenne envisagerait des pauses ciblées dans la mise en œuvre du texte, notamment pour les modèles dits “fondationnels”. Officiellement, il s’agit d’un ajustement technique pour laisser aux États le temps de s’adapter.

Mais en pratique, ce report traduit une crainte économique : celle de voir les entreprises européennes distancées par leurs concurrentes américaines et chinoises, qui évoluent sans contrainte réglementaire comparable.

Cette prudence révèle le dilemme central de Bruxelles : comment protéger les citoyens sans freiner la compétitivité de l’écosystème technologique européen ?

Le lobbying intensif des géants américains

Les grandes entreprises technologiques ont déployé un lobbying d’envergure pour influencer l’AI Act. OpenAI, Microsoft, Google et Anthropic ont multiplié les interventions auprès des institutions européennes pour assouplir certaines obligations, notamment sur la transparence et la divulgation des données d’entraînement.

Leur argument est récurrent : une régulation trop stricte risquerait de ralentir l’innovation et de priver l’Europe de l’accès aux dernières avancées de l’IA. Ces pressions, associées à la dépendance européenne aux technologies américaines, ont conduit Bruxelles à reconsidérer son calendrier.

L’équilibre fragile entre innovation et contrôle

Entre protection et innovation, l’Europe tente de trouver un équilibre. Une partie des eurodéputés appelle à une régulation “agile”, capable de s’adapter à l’évolution rapide des modèles. D’autres estiment qu’un encadrement ferme est indispensable pour éviter les dérives sociales et éthiques.

Cette opposition interne illustre le double visage de la régulation européenne : modèle de prudence pour certains, frein à la compétitivité pour d’autres.

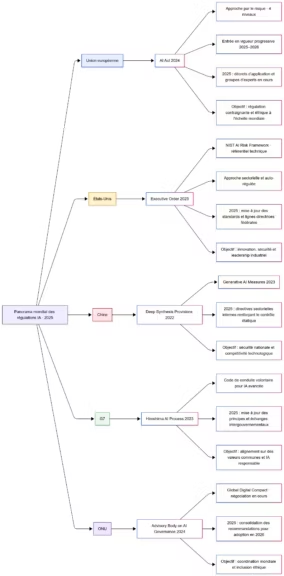

États-Unis et Chine : deux approches opposées, un même objectif

Les États-Unis misent sur la régulation par le marché

Outre-Atlantique, la régulation IA reste largement autodéterminée par les entreprises. L’administration américaine privilégie une approche flexible, fondée sur la collaboration public-privé.

Les lignes directrices du National Institute of Standards and Technology (NIST) et les engagements volontaires des Big Tech fixent des principes de sécurité sans réelle contrainte juridique. Résultat : un environnement favorable à la croissance rapide des modèles IA, porté par une culture de l’expérimentation.

Cette stratégie offre aux États-Unis un avantage structurel : leur régulation s’adapte plus vite à l’innovation que celle de Bruxelles.

La Chine, un contrôle étatique au service de la compétitivité

À l’inverse, la Chine mise sur une régulation centralisée, intégrée à sa stratégie industrielle. Pékin encadre strictement les algorithmes tout en finançant massivement la recherche et les infrastructures.

Les règles de conformité, notamment sur les contenus générés, sont appliquées pour maintenir le contrôle politique et garantir la cohérence du marché intérieur. Ce modèle autoritaire mais efficace permet à la Chine d’accélérer dans les secteurs stratégiques comme la robotique, la défense et les semi-conducteurs.

Conséquence pour l’Europe : entre prudence et marginalisation

Face à ces deux modèles, l’Europe avance à contretemps. Elle se distingue par son cadre éthique avancé, mais manque de moyens industriels et financiers pour rivaliser.

Pendant que Washington et Pékin investissent massivement dans les GPU, les data centers et les start-ups, Bruxelles multiplie les consultations et les amendements. Le risque est clair : réguler sans produire.

Une gouvernance technologique sous tension

La régulation comme outil de pouvoir géopolitique

Dans la guerre de l’IA, réguler devient un acte de puissance. L’Europe espère que l’AI Act lui permettra d’imposer ses standards au reste du monde, comme elle l’a fait avec le RGPD.

Mais cette stratégie suppose de détenir un poids industriel suffisant pour influencer les acteurs mondiaux. Or, faute d’infrastructures compétitives et de champions européens, la régulation risque de devenir un instrument symbolique plutôt qu’un véritable levier géopolitique.

Les divergences entre États membres de l’UE

Les désaccords internes ralentissent la mise en œuvre du texte. Tandis que la France et l’Allemagne défendent une approche “pro-innovation”, des pays comme la Suède ou les Pays-Bas insistent sur la protection des citoyens et la transparence.

Ces divergences révèlent un défi politique majeur : créer une voix européenne unifiée dans un domaine où la vitesse d’adaptation est cruciale.

Les appels à une gouvernance mondiale de l’intelligence artificielle

Devant l’ampleur des enjeux, les institutions internationales, G7, ONU et Partenariat mondial sur l’IA (GPAI), appellent à une coordination globale. L’objectif : harmoniser les normes de sécurité, de transparence et de traçabilité.

Mais sans consensus sur la propriété des données, la souveraineté numérique ou la surveillance, cette gouvernance mondiale reste embryonnaire.

Innovation et compétitivité : l’Europe dans la balance

Fuite des talents et écosystèmes fragilisés

Le durcissement réglementaire inquiète les entrepreneurs. Plusieurs start-ups européennes choisissent déjà de délocaliser leurs activités vers les États-Unis ou le Royaume-Uni, où les cadres légaux sont plus favorables à l’expérimentation.

Ce phénomène alimente un brain drain technologique, aggravant la dépendance de l’Europe aux solutions étrangères. Si rien ne change, le continent pourrait devenir un consommateur d’IA, plutôt qu’un producteur.

La dépendance croissante aux modèles américains

Les modèles d’OpenAI, Anthropic ou Google Gemini sont déjà omniprésents dans les entreprises européennes. L’absence d’alternatives locales renforce une dépendance structurelle à l’écosystème américain, aussi bien pour les modèles que pour les infrastructures cloud.

Cette situation limite la souveraineté technologique européenne et accentue les risques économiques à long terme.

A lire également : OpenAI change d’échelle : vers une IA mondiale à plusieurs nuages

Vers une harmonisation européenne de l’innovation responsable

Face à ce constat, la Commission européenne tente de rééquilibrer sa stratégie. Des programmes tels qu’AI Made in Europe et des fonds dédiés à l’open source visent à soutenir une innovation responsable, ancrée dans les valeurs européennes.

L’enjeu est de concilier progrès technologique et encadrement éthique, sans céder sur la sécurité ni perdre la dynamique d’innovation.

Quelles perspectives pour la régulation mondiale de l’IA ?

L’AI Act comme modèle international potentiel

Malgré ses retards, l’AI Act conserve une influence mondiale. Des pays comme le Canada, le Japon ou le Brésil s’en inspirent pour élaborer leurs propres cadres réglementaires.

Si l’Union européenne parvient à démontrer qu’une régulation équilibrée peut coexister avec une économie innovante, elle pourrait encore devenir une référence en matière de gouvernance technologique.

De la régulation à la coopération mondiale

L’avenir de la régulation IA passera par la coopération internationale. Les modèles et leurs impacts dépassent les frontières nationales. L’Europe, forte de son expérience normative, a un rôle à jouer dans la création d’un cadre global garantissant à la fois innovation, sécurité et équité.

L’IA entre régulation et puissance technologique

L’Europe se trouve à un tournant. Si elle réussit à concilier régulation et innovation, elle pourrait incarner une troisième voie entre dérégulation américaine et contrôle centralisé chinois.

Mais si la prudence se transforme en inertie, le risque est grand de voir le continent devenir un simple observateur de la révolution de l’intelligence artificielle. L’avenir de l’AI Act déterminera si l’Europe choisit de réguler pour exister ou de réguler au ralenti.

Sources et références

Médias technologiques

- 7 nov 2025, selon Financial Times

- 7 nov 2025, d’après Reuters

- 6 nov 2025, selon TechCrunch

- 4 nov 2025, d’après Wired

- 3 nov 2025, selon Forbes

Entreprises

- 6 nov 2025, communiqué Business Wire

- 6 nov 2025, site Anthropic

- 4 nov 2025, newsroom IBM

Institutions

- 7 nov 2025, d’après Euronews

- 6 nov 2025, selon Wall Street Journal

Sources officielles

- 7 nov 2025, site Google Blog

- 6 nov 2025, newsroom Lockheed Martin

- 6 nov 2025, site CNBC

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !