Pourquoi ChatGPT, Claude et Gemini deviennent plus lents en 2025

Si ChatGPT, Claude, Mistral ou Gemini semblent plus lents qu’avant, le problème ne vient pas de votre connexion. Les IA de chat ralentissent parce que les data centers sont saturés, victimes d’une pénurie mondiale de GPU. Cette compute famine touche directement les services que vous utilisez au quotidien. Voici pourquoi vos IA rament et ce que personne n’explique clairement.

Ce que vous voyez, vos IA deviennent plus lentes

Temps de réponse plus longs et IA qui “rame”

Les utilisateurs constatent des réponses plus lentes, des pauses prolongées ou des messages d’erreur temporaires. Ces ralentissements deviennent fréquents en soirée et en heures de pointe. Les requêtes sur Google “ChatGPT lent”, “Claude lent” ou “Gemini lent” augmentent fortement, signe que cette expérience concerne désormais tous les grands modèles.

Les fausses causes, ce n’est pas votre réseau

Le réflexe est souvent d’accuser le WiFi, le navigateur ou l’appareil. Pourtant, vider le cache ou changer de réseau n’a quasiment aucun effet. Les lenteurs persistent même avec une connexion fibre, preuve que le problème n’est pas chez vous mais du côté des serveurs. Les IA ne rament pas parce que votre PC est lent, mais parce que les clouds sont saturés.

Ce que personne ne vous dit, la pénurie mondiale de GPU

Les data centers manquent de GPU

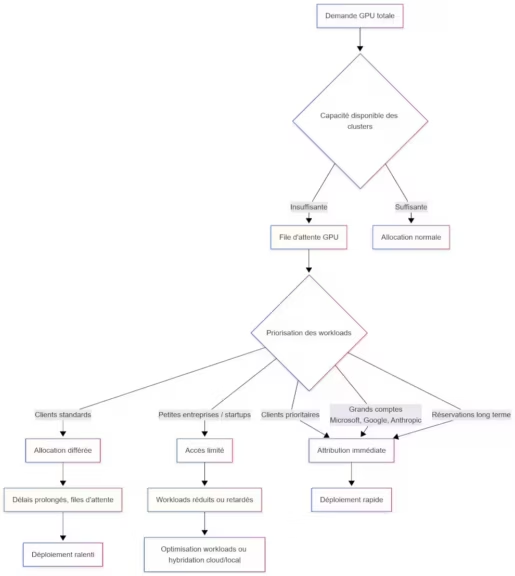

Les clouds qui hébergent ces IA disposent de moins de GPU qu’il n’en faudrait pour répondre à la demande. Une pénurie mondiale touche les accélérateurs H100, H200 et Blackwell, essentiels pour faire tourner les modèles IA modernes. Résultat, les plateformes doivent rationner, prioriser et gérer des files d’attente internes pour traiter les requêtes, comme l’indique notre article sur la pénurie de GPU pour les data centers en 2025.

(Cliquez pour agrandir)

Les modèles IA géants consomment toutes les ressources

Les modèles de 2025, comme Gemini 3 Pro ou GPT-5.1, exploitent des contextes plus longs, davantage de multimodalité et des agents plus sophistiqués, ce qui augmente naturellement la demande en mémoire et en capacité de calcul. Cependant, les principaux acteurs ont aussi réalisé des progrès notables pour réduire le coût d’inférence, avec des modèles plus efficaces comme Claude Haiku 4.5 ou les optimisations de ChatGPT 5.1, qui sélectionne automatiquement la version la plus adaptée selon la requête. Malgré ces gains d’efficacité, la croissance rapide de l’usage, la taille des modèles et la demande exponentielle finissent par dépasser les capacités disponibles. Résultat, même optimisés, ces modèles contribuent à accentuer la pression sur les data centers déjà limités par la pénurie mondiale de GPU.

Les grands acteurs de l’IA adoptent désormais une stratégie multi-cloud, non seulement pour réduire leur dépendance à un fournisseur unique, mais aussi pour sécuriser autant de capacité GPU que possible. Cette approche permet de répartir la charge entre plusieurs data centers, d’éviter que la saturation d’une seule région ne provoque des ralentissements massifs, et surtout de garantir une continuité de service face à la pénurie. OpenAI, par exemple, a renforcé ses partenariats avec plusieurs clouds afin de réserver du compute à long terme, comme nous l’expliquons dans notre article. Toutefois, même avec ces stratégies de diversification, la demande dépasse tellement l’offre mondiale que les ralentissements restent inévitables pour les utilisateurs finaux.

Une crise structurelle, CoWoS, HBM et Blackwell

La pénurie n’est pas liée à un incident ponctuel. Elle vient de limites industrielles : la production CoWoS, indispensable aux GPU IA, est saturée, tandis que la mémoire HBM reste difficile à produire en quantité. Même en augmentant l’offre, la demande mondiale reste bien supérieure. La compute famine est durable.

Comment la pénurie impacte ChatGPT, Claude, Mistral et Gemini

Priorité aux clients entreprise, le grand public passe après

Les clouds allouent en priorité les GPU aux contrats entreprise, beaucoup plus rentables. Les utilisateurs grand public, surtout en version gratuite ou low-cost, sont servis ensuite. Cela explique pourquoi ChatGPT, Claude ou Gemini deviennent plus lents quand les serveurs sont saturés, même si vous n’avez rien changé à votre usage.

Modèles downgradés ou limités en heures de pointe

Quand la capacité GPU manque, certaines plateformes réduisent temporairement la puissance disponible. Les services peuvent basculer vers des modèles plus petits ou optimisés, restreindre la longueur des réponses ou ralentir la génération. Ces ajustements sont invisibles pour l’utilisateur, mais perceptibles sous forme de lenteur ou de perte de qualité.

Ce que vous pouvez faire pour réduire la lenteur

Astuces utiles, mais qui ne résolvent pas la pénurie

Actualiser votre session, simplifier votre prompt, réduire la taille de vos demandes ou éviter les heures de pointe peut légèrement améliorer la vitesse. Cependant, ces astuces contournent le problème sans le résoudre. La limitation principale reste la saturation GPU côté data center.

| Action | Effet sur le calcul | Bénéfice attendu |

|---|---|---|

| Réduire la longueur du prompt | Moins de tokens à traiter | Réponse initiale plus rapide |

| Éviter les médias inutiles | Supprime les chemins d’inférence | Moins d’utilisation GPU |

| Limiter la longueur de sortie | Fenêtre de génération réduite | Latence plus stable |

| Retirer le contexte redondant | Moins de mémoire et d’attention | Cohérence améliorée |

| Utiliser des instructions concises | Simplifie le routage du modèle | Meilleure vitesse et précision |

Quand le problème vient uniquement du cloud

Si ChatGPT, Claude ou Gemini sont lents alors que tout fonctionne chez vous, il n’existe aucune action locale capable d’accélérer la réponse. Le service dépend de la capacité GPU disponible au moment où vous envoyez votre requête. Cette information n’est jamais affichée dans les interfaces, mais elle explique la majorité des ralentissements constatés aujourd’hui.

Points clés

Le compute (capacité de calcul), une ressource devenue rare

La lenteur des IA ne vient pas d’un bug mais d’un manque mondial de GPU. ChatGPT, Claude et Gemini ralentissent parce que les data centers ne disposent plus de suffisamment de capacité pour servir toutes les requêtes en temps réel. Le compute est désormais une ressource critique.

2025–2026, des lenteurs encore fréquentes

La pénurie GPU devrait durer au moins jusqu’en 2026, le temps que les capacités de production CoWoS et HBM augmentent. Entre-temps, les ralentissements resteront courants, surtout aux heures de forte affluence. Les fournisseurs capables de sécuriser davantage de compute offriront les meilleures performances.

Pour une analyse plus complète des causes techniques et des limites d’infrastructure, vous pouvez consulter la version détaillée de cet article sur Cosmo-Edge.

A lire également : DFloat11, la compression lossless qui allège les modèles IA malgré la pénurie de GPU

Sources et références

Médias technologiques

- CNN, 19 novembre 2025, analyse de la demande GPU et des tensions sur l’infrastructure, https://edition.cnn.com/2025/11/19/tech/nvidia-earnings-ai-bubble-fears

- The Wall Street Journal, 2025, résultats Nvidia et demande Blackwell supérieure à l’offre, https://www.wsj.com/tech/ai/nvidia-earnings-q3-2025-nvda-stock-9c6a40fe

- TechCrunch, 18 novembre 2025, présentation de Gemini 3 Pro et implications compute, https://techcrunch.com/2025/11/18/google-launches-gemini-3-with-new-coding-app-and-record-benchmark-scores/

Entreprises

- Microsoft, 18 novembre 2025, partenariat sur l’accès à Blackwell et Vera Rubin, https://blogs.microsoft.com/blog/2025/11/18/microsoft-nvidia-and-anthropic-announce-strategic-partnerships/

- Anthropic, intégration de Claude dans Foundry, https://www.anthropic.com/news/claude-in-microsoft-foundry

- OpenAI, présentation GPT-5.1 Codex Max, https://openai.com/index/gpt-5-1-codex-max/

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !