Context Packing vs RAG : comment Google Gemini 3 résout l’amnésie des IA

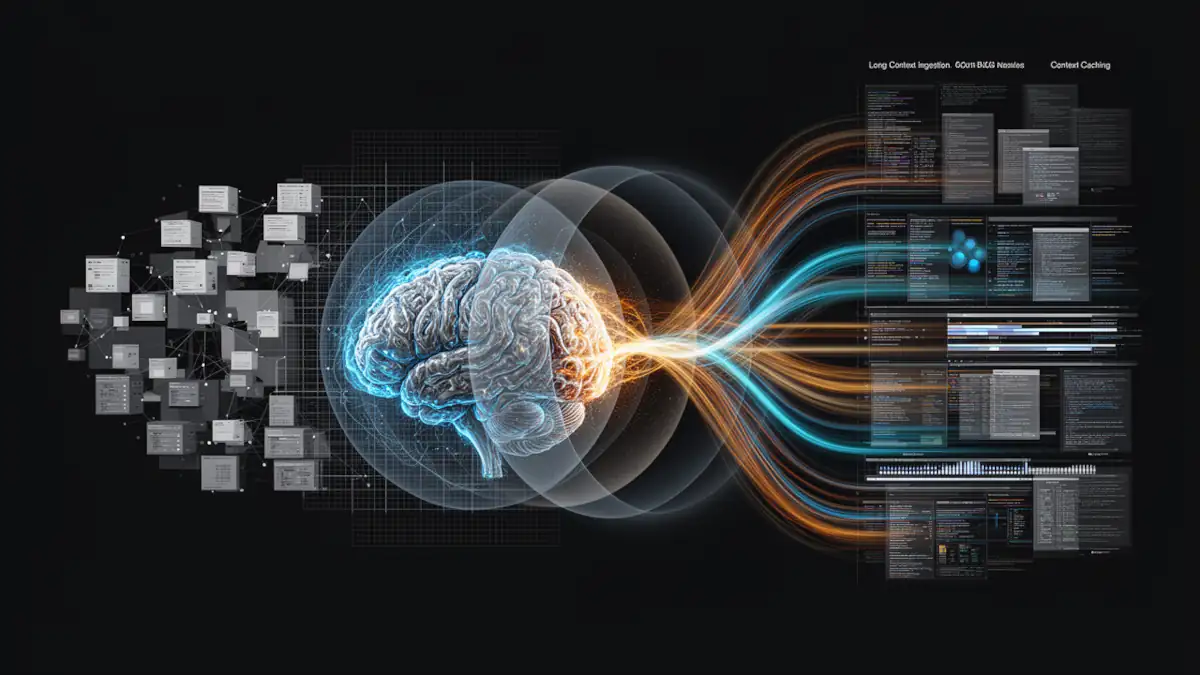

Dans la course à l’intelligence artificielle personnalisée, la gestion de la mémoire à long terme est devenue le principal goulot d’étranglement technique. Si le standard industriel repose sur le RAG (Retrieval-Augmented Generation), Google propose avec Gemini 3 une approche hybride que nous qualifierons ici de « Context Packing ».

Note : Le terme « Context Packing » est une appellation éditoriale utilisée pour désigner la synergie entre le long contexte natif de Gemini, le context caching et le retrieval outillé. Bien qu’il ne s’agisse pas d’une dénomination officielle, ce concept permet de structurer la compréhension de l’architecture logicielle de Google, déjà évoquée dans notre analyse de la stratégie globale Google Gemini vs OpenAI.

Le problème du RAG classique : une mémoire fragmentée

Pour que l’IA accède à vos documents, le standard actuel est le RAG traditionnel. Ce processus consiste à découper vos données en petits segments (« chunks ») stockés dans une base de données vectorielle pour créer une mémoire contextuelle, puis à extraire les fragments jugés mathématiquement proches d’une requête.

Bien qu’efficace, cette implémentation basique souffre de limites réelles :

- Perte de structure : En ne lisant que des fragments isolés, l’IA peut perdre la hiérarchie d’un document ou la chronologie fine d’une discussion.

- Imprécision du retrieval : La pertinence dépend entièrement du moteur de recherche vectoriel. Si l’extraction échoue, l’IA manque d’informations pour raisonner correctement.

L’évolution vers le « Context Packing » sous Gemini 3

Plutôt que de rompre avec le RAG, Google fait évoluer le modèle vers un RAG à très long contexte. Cette architecture s’appuie sur la capacité native de Gemini 3 à traiter jusqu’à 1 million de tokens de manière simultanée.

Selon le Whitepaper Building Personal Intelligence, le processus n’est plus une simple extraction de fragments, mais une synthèse dynamique structurée en trois phases :

- Compréhension de l’intention (Query Understanding) : Identification fine de ce que l’utilisateur recherche.

- Récupération outillée (Tool-driven Retrieval) : Identification des sources entières ou de sous-ensembles cohérents.

- Synthèse et injection (The Packing) : Les données pertinentes sont synthétisées et « paquetées » directement dans la fenêtre de contexte de l’IA.

Grâce aux Google TPU de dernière génération (Trillium), ce mécanisme permet de maintenir une précision extrême. Si les benchmarks publics affichaient déjà des scores supérieurs à 99 % au test « Needle-in-a-Haystack », Gemini 3 optimise cette capacité de récupération quasi-parfaite au sein de contextes massifs.

Pourquoi Google n’emploie pas un seul terme pour cette architecture ?

Contrairement à un produit « boîte noire », l’infrastructure de Google est modulaire. Elle combine des briques distinctes comme le Context Caching et le retrieval sémantique. Cette complexité interdit l’usage d’un terme unique dans la documentation technique, bien que l’effet produit pour l’utilisateur soit celui d’une mémoire unifiée et immédiate.

Comparatif : Une nouvelle norme de précision

| Caractéristique | RAG « Basique » | Approche Gemini 3 |

| Granularité | Fragments isolés (Chunks) | Sous-ensembles synthétisés |

| Précision | Dépendante du moteur vectoriel | Proche de 100% (Contexte natif) |

| Raisonnement | Limité aux segments extraits | Global et chronologique |

| Infrastructure | Cloud standard / GPU | Optimisation TPU Trillium |

Les limites : le coût de l’utilisation intensive du contexte

Cette omniscience a un prix : une utilisation intensive des tokens à chaque requête. Si Google peut absorber ce coût grâce à son intégration verticale, cette centralisation pose la question de la souveraineté et de la confidentialité des données que nous avons abordée dans notre article. De plus, nous avons identifié plusieurs limites techniques spécifiques à la Personal Intelligence qui montrent que la technologie est encore en phase d’affinage.

Pour les utilisateurs recherchant un équilibre différent, comprendre les différences entre l’IA locale et le Cloud devient essentiel.

Conclusion : Une lecture architecturale du futur de l’IA

Le « Context Packing » de Gemini 3 démontre que la fenêtre de contexte n’est plus un simple réservoir passif, mais un espace de raisonnement dynamique. En fusionnant recherche et synthèse, Google propose une réponse robuste au défi de la personnalisation de masse.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !