Détecter les liens morts : comparatif des crawlers Open Source et installation de LinkChecker sous Windows 11

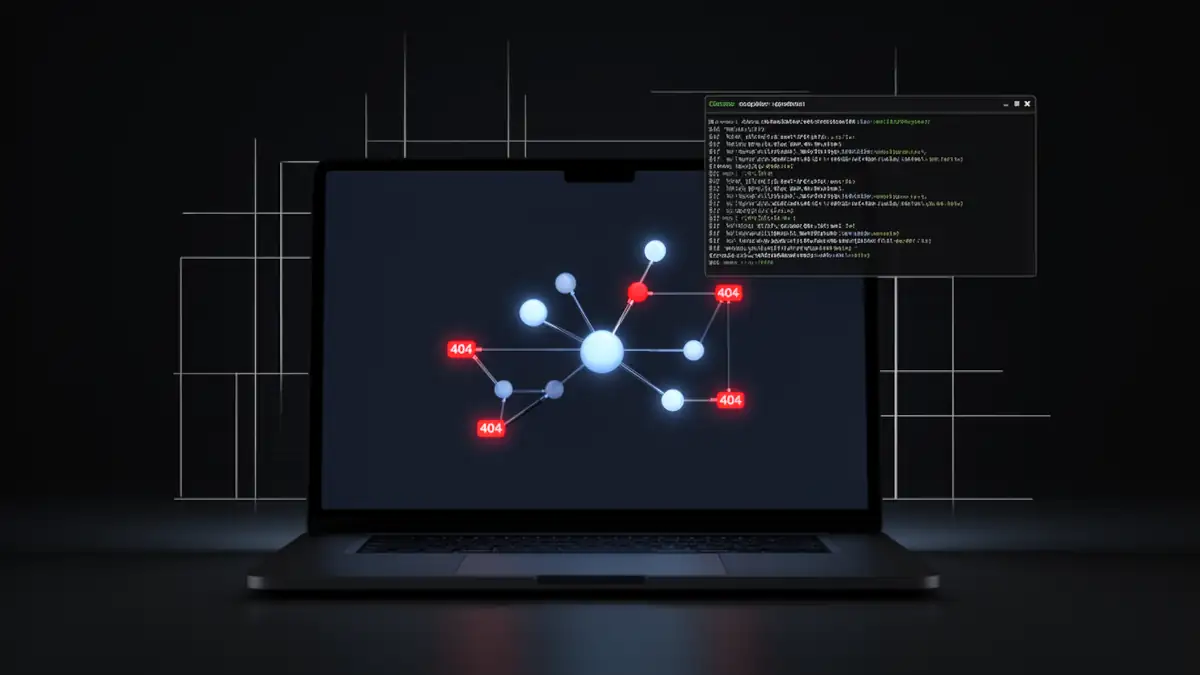

Dans l’écosystème du SEO technique, un lien mort est une rupture de flux. Pour l’utilisateur, c’est une impasse ; pour les moteurs de recherche, c’est un signal de dégradation de la qualité du site. Identifier ces erreurs nécessite un outil capable de simuler le comportement des robots d’indexation : le crawler. Si les solutions SaaS dominent le marché, la maîtrise d’outils locaux et Open Source comme LinkChecker ou Wget offre une souveraineté technique indispensable pour tout ingénieur web ou consultant SEO.

Pourquoi l’audit des liens morts est critique pour votre SEO technique

Avant de choisir son outil, il faut comprendre l’enjeu sous-jacent. Un lien rompu n’est pas qu’une simple page manquante, c’est une faille dans votre architecture de données.

Impact sur le crawl budget et le maillage interne

Chaque site dispose d’un crawl budget (budget d’exploration) limité alloué par Googlebot. Lorsque vous forcez un robot à suivre un lien menant vers une erreur 404, vous gaspillez une unité de ce budget sur du vide. À terme, cela ralentit l’indexation de vos nouveaux contenus.

De plus, les liens internes transmettent la « puissance » (le PageRank thématique) entre vos pages. Un lien mort brise cette chaîne, provoquant une dilution d’autorité interne.

La subtilité technique : 404 vs 410

Il est crucial de distinguer ces deux codes d’état HTTP, comme le souligne la documentation de Google sur les codes de réponse :

- 404 (Not Found) : La ressource est absente, mais pourrait revenir. Google reviendra vérifier.

- 410 (Gone) : La ressource est définitivement supprimée. C’est un signal fort pour désindexer immédiatement l’URL et optimiser le budget de crawl.

Comparatif des solutions : Wget, LinkChecker et Screaming Frog

Le choix de l’outil dépend de la complexité de votre site et de votre besoin d’automatisation.

| Critère | Wget | LinkChecker | Screaming Frog |

|---|---|---|---|

| Précision | Faible (codes HTTP bruts) | Haute (analyse HTML/CSS) | Très haute (SEO avancé) |

| Rendu JS | Non | Non | Oui (via Chromium) |

| Automatisation | Native (CLI / Scripts) | Native (CLI / Python) | Partielle (API/CLI payante) |

| Coût | Gratuit (Open Source) | Gratuit (Open Source) | Gratuit < 500 URLs / Payant |

| Cas d’usage | Vérification rapide infra | Audit récursif précis | Audit SEO global complexe |

LinkChecker : le standard Open Source pour l’audit de liens

Contrairement aux idées reçues, LinkChecker n’est pas un projet obsolète. Le dépôt officiel de LinkChecker est activement maintenu et supporte désormais pleinement Python 3.10+. C’est une alternative gratuite à Screaming Frog particulièrement puissante pour ceux qui rejettent les modèles SaaS fermés.

Installation de LinkChecker sous Windows 11

L’installation est simple pour quiconque maîtrise son environnement Python. Si vous n’avez pas encore configuré votre système, consultez mon guide sur les différents types d’installation de Python sur Windows 11 pour choisir la méthode la plus propre.

Pour une installation sécurisée, je vous renvoie vers les bonnes pratiques pour installer Python sur Windows. Une fois Python opérationnel, ouvrez votre terminal et utilisez la méthode recommandée :

pip install linkcheckerLimite technique : le rendu JavaScript

Il est important de noter que LinkChecker, tout comme Wget, ne possède pas de moteur de rendu Chromium. Il analyse le code source HTML statique. Si votre maillage interne est généré dynamiquement via du JavaScript côté client (CSR), l’outil ne verra pas ces liens. Pour ces cas spécifiques, la fonction de rendu JS de Screaming Frog ou une solution Dockerisée avec un navigateur headless reste nécessaire. À ce sujet, explorer les meilleures solutions pour installer Docker sous Windows 11 peut s’avérer utile pour déployer des crawlers plus lourds.

Automatisation avancée de l’audit SEO

La force de LinkChecker réside dans sa capacité à être intégré dans des workflows DevOps.

Tâche planifiée et détection des 404

Sur Windows 11, vous pouvez automatiser un crawl hebdomadaire via l’utilitaire schtasks. Cela permet de passer d’un audit manuel réactif à une surveillance proactive de votre santé technique.

Extraction et parsing des données

Une fois le crawl terminé, LinkChecker peut exporter un fichier CSV. Voici un exemple minimaliste de script Python pour isoler les erreurs critiques :

import pandas as pd

# Chargement du rapport LinkChecker

df = pd.read_csv('rapport_audit.csv', sep=';')

# Filtrage des erreurs 404 et 410

broken_links = df[df['result'].str.contains('404|410', na=False)]

if not broken_links.empty:

print(f"Alerte : {len(broken_links)} liens morts détectés.")

# Ici, intégration possible d'un envoi mail via SMTPCette approche permet de filtrer le « bruit » des redirections 301 pour se concentrer sur les ruptures de liens internes, garantissant une maintenance locale sans dépendre d’un tiers.

FAQ : Maîtriser l’audit technique et les comportements serveurs

L’utilisation d’un crawler open source nécessite une compréhension fine des interactions entre votre machine et le serveur cible. Voici les réponses aux problématiques souvent rencontrées par les ingénieurs DevOps et les experts en SEO technique.

Pourquoi mon crawler reçoit-il des erreurs 403 ou 406 ?

L’accès à un site par un robot peut provoquer un blocage au niveau du Pare-feu Applicatif Web (WAF). Ces systèmes identifient l’User-Agent par défaut de LinkChecker et, pour prévenir le scraping abusif, rejettent la requête. Pour auditer sereinement votre site, vous devrez configurer LinkChecker pour simuler un navigateur réel ou un robot de confiance (Googlebot).

LinkChecker peut-il détecter les liens morts dans les PDF ?

Oui, c’est l’un de ses points forts par rapport à un simple script Wget. Il peut extraire et vérifier la validité des liens présents dans les documents non-HTML, ce qui est crucial pour les sites industriels ou les plateformes de documentation technique où le Link Rot dans les fichiers statiques est fréquent.

Comment limiter l’impact du crawl sur les performances du serveur ?

Pour ne pas saturer votre bande passante ou déclencher des alertes de déni de service (DoS), utilisez le fichier de configuration .linkcheckerrc pour limiter le nombre de threads simultanés. Une approche respectueuse du serveur est la base d’une automatisation audit SEO éthique.

Vers une hygiène numérique automatisée

La détection des erreurs 404 ne doit plus être perçue comme une corvée manuelle effectuée lors d’une refonte. En utilisant des outils comme la documentation Wget GNU ou LinkChecker en ligne de commande, vous reprenez le contrôle total sur vos données d’audit.

L’objectif final de cette démarche est la souveraineté technique. En hébergeant vos propres scripts d’audit sur votre machine Windows 11 ou vos propres serveurs, vous évitez la dépendance aux plateformes SaaS dont le coût augmente avec le volume d’URLs. La mise en place d’une surveillance proactive, couplée à un parsing automatisé des résultats, transforme une simple vérification technique en un véritable levier de croissance pour votre maillage interne.

La traque des liens morts est la première étape d’une stratégie de maintenance robuste. En 2026, la capacité d’un développeur ou d’un SEO à automatiser ces tâches répétitives via Python est ce qui différencie une gestion artisanale d’une infrastructure web de classe mondiale.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !