Comment détecter IA : texte, image, audio, guide complet 2025

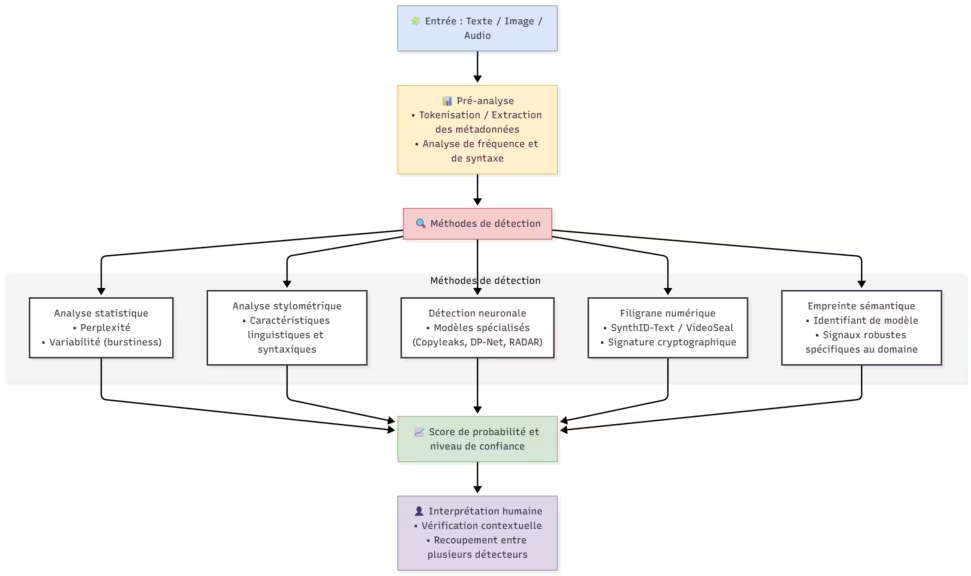

Détecter un contenu généré par intelligence artificielle est devenu un vrai casse-tête en 2025. Les modèles de dernière génération, ChatGPT 5, Claude 4.5 et Gemini 2.5 Pro, produisent désormais des textes, des images et des voix si naturels qu’ils rivalisent avec la création humaine. Pourtant, savoir détecter IA reste essentiel : pour préserver l’intégrité académique, identifier les deepfakes et garantir la transparence dans les médias ou le marketing.

Ce guide complet 2025 s’appuie sur les études les plus récentes et les outils de détection les plus fiables pour apprendre à identifier un texte IA, une image générée par IA ou une voix synthétique. Car si les modèles deviennent plus subtils, les détecteurs s’adaptent eux aussi, combinant linguistique, analyse neuronale et watermarking statistique.

Pourquoi détecter IA est devenu incontournable

Depuis l’arrivée de ChatGPT 5, la frontière entre le texte humain et le contenu généré par IA s’est pratiquement effacée. Rédactions, universités et plateformes sociales font face à un flot de textes et visuels produits par machine. Mais il ne s’agit pas d’interdire l’IA. L’enjeu est la transparence : différencier l’usage légitime (aide à la rédaction, synthèse de données, création artistique) de l’usage trompeur ou frauduleux.

Google, par exemple, précise qu’il ne pénalise pas le contenu IA en soi, mais sanctionne le scaled content abuse, la production de masse sans valeur ajoutée ni supervision humaine (SEOpital, 2024). Dans ce contexte, savoir détecter IA n’est plus une curiosité technique, c’est une compétence critique.

Détecter IA dans les textes : les méthodes et leurs limites

Identifier un texte généré par une IA moderne comme ChatGPT 5, Claude 4.5 ou Gemini 2.5 Pro est devenu une course d’endurance. Les chercheurs s’accordent : aucun détecteur ne peut garantir une fiabilité absolue. Selon les contextes, les taux de précision varient de 52 % à 99 % (PMC, 2025). Les meilleurs outils repèrent bien les productions brutes, mais peinent face aux textes paraphrasés ou co-écrits par des humains.

Analyse de perplexité et burstiness : la méthode historique

Les premiers outils comme GPTZero ou ZeroGPT reposaient sur l’analyse de perplexité, la mesure de prévisibilité d’un texte. Plus le texte est fluide et régulier, plus il a de chances d’être généré par IA. Cette approche fonctionne encore sur de vieux modèles, mais échoue face à ChatGPT 5 et Claude 4.5, capables d’imiter la variabilité naturelle du style humain.

De plus, elle souffre d’un biais majeur : les locuteurs non natifs sont faussement identifiés comme IA dans 61,3 % des cas (Stanford HAI, 2023). Résultat : la perplexité est désormais considérée comme un indicateur faible, utile seulement en combinaison avec d’autres signaux.

Stylométrie : la signature linguistique humaine

La stylométrie analyse le style plutôt que le contenu. Elle mesure la richesse lexicale, la complexité syntaxique, le rythme des phrases, ou encore la fréquence de certains mots rares. Le modèle StyloAI (2024) a montré qu’un algorithme bien calibré pouvait atteindre jusqu’à 98 % de précision sur des textes académiques, en utilisant 31 caractéristiques linguistiques. Avantage : cette méthode est interprétable, chaque décision peut être justifiée. Limite : elle dépend du domaine (technique, littéraire, scientifique) et nécessite une adaptation continue aux nouveaux styles des modèles IA.

Watermarking : la nouvelle génération de signatures invisibles

Le watermarking statistique est la piste la plus prometteuse pour 2025. Google DeepMind a déployé SynthID-Text, un système open-source qui intègre une signature invisible lors de la génération de texte. Concrètement, chaque mot produit par le modèle suit une probabilité légèrement ajustée selon une clé secrète. Ce motif est indétectable à la lecture, mais vérifiable par un outil autorisé.

Les tests internes montrent que 20 millions de réponses Gemini ont pu être marquées sans perte de qualité perceptible (Euronews, 2024). OpenAI expérimente une approche similaire intégrée à ChatGPT 5. Mais tout n’est pas parfait : une paraphrase via un autre modèle efface souvent la signature, et certaines attaques peuvent même insérer de faux watermarks dans du texte humain (EY, 2024).

Détecteurs neuronaux fine-tuned : l’approche “apprise”

Les détecteurs les plus récents, comme Copyleaks, Originality.ai Turbo ou DP-Net, utilisent des modèles entraînés sur des millions de textes IA et humains. Ces systèmes atteignent jusqu’à 99 % de précision sur des corpus bien calibrés (Copyleaks, 2025), mais perdent en efficacité sur des domaines ou des modèles non vus en entraînement.

Leur talon d’Achille reste la généralisation cross-model : un détecteur conçu pour GPT-4 échouera souvent face à Claude 4.5 ou Gemini 2.5 Pro. C’est pourquoi de nouveaux projets comme RADAR ou DP-Net intègrent un entraînement adversarial, capable de s’adapter dynamiquement aux styles émergents (ACL Anthology, 2025).

Détecter IA dans les images et vidéos

La détection d’images générées par IA a fait d’immenses progrès depuis 2023, mais les modèles de 2025 comme Gemini 2.5 Pro Vision ou Midjourney V7 brouillent les frontières entre photo et synthèse. Les visuels produits sont si réalistes qu’ils échappent souvent à l’œil humain, même entraîné. Pourtant, il reste possible de détecter une image IA grâce à une combinaison d’analyses visuelles, statistiques et neuronales.

Les indices visuels classiques

Avant même d’utiliser un outil, certains détails peuvent trahir une génération IA :

- Incohérences physiques : ombres impossibles, reflets déformés, proportions étranges.

- Problèmes de texte et de logos : caractères flous ou mal espacés, typographies non cohérentes.

- Détails anatomiques imparfaits : doigts en trop, bijoux déformés, regard asymétrique.

- Textures ou motifs répétitifs : particulièrement visibles dans les cheveux, tissus ou feuillages.

Ces anomalies sont encore présentes, même si Midjourney et Gemini ont considérablement amélioré la cohérence visuelle depuis 2024.

Les outils de détection d’images IA

La détection automatisée s’appuie aujourd’hui sur des modèles entraînés à reconnaître les artefacts statistiques laissés par les générateurs. Parmi les meilleurs outils en 2025 :

- SynthID Image (Google DeepMind) : watermark invisible intégré dans les pixels lors de la génération.

- Intel FakeCatcher : analyse des micro-fluctuations lumineuses sur le visage pour repérer les deepfakes vidéo.

- Forensically : outil open source d’analyse forensique des métadonnées et du bruit numérique.

- Content Authenticity Initiative (Adobe / Nikon / Microsoft) : standard d’authentification croisée des images et vidéos, de plus en plus adopté dans les rédactions.

Les détecteurs neuronaux basés sur transformers visuels, comme le Swin Transformer V2-B ou VideoSeal de Meta, atteignent jusqu’à 98 % de précision dans les benchmarks récents (Arxiv, 2025).

Les limites de la détection d’images

La robustesse au post-traitement reste le défi majeur. Une simple compression JPEG, un filtre de couleur ou un recadrage peut effacer les traces statistiques d’un watermark. En outre, les modèles multi-modaux comme Gemini 2.5 Pro génèrent des visuels réalistes intégrant du texte parfaitement lisible, ce qui rend obsolètes les tests simples fondés sur la typographie.

Les chercheurs explorent donc des solutions hybrides combinant watermarking cryptographique et vérification de provenance via métadonnées vérifiées sur blockchain, une approche soutenue par Adobe, Sony et Nikon dans leurs flux d’édition professionnels.

Détecter IA dans l’audio et les voix

La génération vocale a, elle aussi, franchi un cap en 2025. Les systèmes VoiceCraft 3, ElevenLabs Prime Voice v2 ou ChatGPT Audio 5 peuvent reproduire n’importe quelle voix avec un réalisme troublant. Résultat : les deepfakes audio sont désormais utilisés pour la fraude, la manipulation politique ou les arnaques téléphoniques. Détecter IA dans l’audio est donc devenu une priorité.

Les signes d’un audio IA

Même si la qualité est bluffante, certains indices permettent encore de repérer une voix synthétique :

- Manque de micro-imperfections : respiration trop régulière, transitions trop propres.

- Accent neutre et rythme constant : les IA ont du mal à reproduire les hésitations naturelles.

- Manque d’émotion réelle : la prosodie paraît souvent mécanique ou uniformément “parfaite”.

- Coupures subtiles : petites ruptures entre syllabes, audibles avec un casque.

Outils de détection audio fiables

- Resemble Detect : API d’analyse spectrale capable d’identifier les signatures acoustiques de synthèse.

- Deepware Scanner : repère les manipulations vocales et vidéos en combinant analyse fréquentielle et machine learning.

- Loki LibrAI : outil open source mentionné par Cosmo Games, conçu pour la vérification des faits et la traçabilité des sources audio et textuelles.

Les modèles neuronaux de détection audio atteignent désormais 92 à 96 % de précision, selon les études publiées dans Frontiers in AI et IEEE 2025.

Les limites et risques de confusion

Les voix hybrides, mi-synthétiques, mi-humaines, posent le plus grand défi. De nombreux créateurs de contenu utilisent des IA pour lisser ou corriger leur voix, rendant la détection floue. De plus, certains outils comme VoiceHumanizer ou BypassAudioAI réinjectent du bruit naturel pour contourner les détecteurs. La tendance actuelle est donc de coupler les analyses acoustiques à des vérifications contextuelles : date, source, cohérence de l’enregistrement, et historique du locuteur.

Outils de détection IA : le comparatif 2025

Le marché des outils pour détecter IA s’est professionnalisé en 2025. Fini les gadgets approximatifs : les solutions de nouvelle génération s’appuient sur des modèles neuronaux fine-tuned, des bases de données cross-model et, pour certaines, sur des approches hybrides mêlant machine learning et watermarking.

Voici un comparatif des outils les plus fiables selon les études récentes et les tests indépendants.

Comparatif des détecteurs de texte IA (2025)

| Outil | Précision moyenne | Faux positifs | Points forts | Limites |

|---|---|---|---|---|

| Scribbr Premium | 84 % | 0 % | Très fiable sur textes académiques, interface claire | Peu adapté aux contenus créatifs |

| Copyleaks AI Detector | 98-99 % | < 1 % | Haute précision sur locuteurs non natifs (Copyleaks, 2025) | Performances moindres sur paraphrases |

| Originality.ai Turbo | 95-99 % | 1-2 % | Excellente robustesse aux reformulations simples | Coût élevé sur gros volumes |

| GPTZero v4 | 70-92 % | 5-15 % | Rapide, interface grand public | Sensible aux erreurs sur courts textes |

| DetectGPT / Fast-DetectGPT | 87-98 % | 1-10 % | Open source, adaptable | Nécessite modèle proxy adapté |

| Turnitin AI Detector | 60-85 % | Non communiqué | Intégré aux LMS | Fiabilité variable selon les universités |

| DP-Net / RADAR | 86 % (cross-domain) | < 2 % | Entraînement adversarial dynamique (ACL Anthology, 2025) | En phase de test |

Verdict : les outils commerciaux Copyleaks et Originality.ai Turbo restent les plus fiables, mais l’open-source Fast-DetectGPT offre une alternative crédible pour les développeurs et chercheurs. Les modèles universels de 2025 comme DP-Net commencent à résoudre le problème de généralisation entre modèles (GPT-5, Claude 4.5, Gemini 2.5 Pro).

Détecteurs d’images et vidéos IA

| Outil | Type | Spécificité | Précision |

|---|---|---|---|

| SynthID (DeepMind) | Watermark intégré | Marqueur cryptographique invisible | ~99 % sur images Gemini |

| VideoSeal (Meta) | Deepfake detector | Analyse des frames par réseau diffusion | 95-98 % |

| FakeCatcher (Intel) | Bio-signal facial | Détection par micro-variations lumineuses | 92 % |

| Forensically | Open-source | Analyse forensique classique (EXIF, bruit) | Variable |

| Content Authenticity Initiative | Standard industriel | Suivi de provenance blockchain/métadonnées | Déploiement en cours |

Les résultats les plus probants proviennent du watermarking natif : une approche proactive adoptée par Google, Meta et Adobe. Cependant, la compression, le redimensionnement ou la capture d’écran peuvent neutraliser ces marqueurs, d’où la nécessité d’une vérification multi-niveaux.

Détecteurs audio et voix IA

| Outil | Précision | Méthode | Remarques |

|---|---|---|---|

| Resemble Detect | 93-95 % | Analyse spectrale | API fiable pour studios et médias |

| Deepware Scanner | 90-94 % | Machine learning fréquentiel | Bon compromis grand public |

| FakeCatcher Audio | 92-96 % | Corrélation temporelle | Efficace sur discours politiques |

| Loki LibrAI | ~90 % | Open-source / fact-checking | Utile pour vérification journalistique |

Les modèles modernes, capables d’imiter souffle, accent et hésitation, rendent la tâche difficile ; d’où l’émergence de systèmes de vérification contextuelle (analyse de source, métadonnées, et date d’enregistrement).

Limites, biais et contournements

Même les meilleurs outils ont leurs failles. En 2025, la détection IA reste une course entre générateurs et détecteurs.

1. Les paraphrases et humanizers

Les reformulateurs IA (Quillbot, Undetectable AI, Humanize Pro) réduisent les scores de détection à moins de 15 % selon l’étude DAMAGE 2025 (ACL, 2025). Le modèle DIPPER T5 est capable de paraphraser récursivement un texte IA tout en préservant son sens, annihilant la plupart des signatures détectables.

2. Les biais linguistiques

Les détecteurs basés sur la perplexité continuent de discriminer les locuteurs non natifs, avec jusqu’à 61 % de faux positifs (Stanford HAI, 2023). Les nouveaux modèles comme Copyleaks ou DP-Net réduisent ce biais à moins de 1 %, mais le problème persiste dans les contextes éducatifs.

3. Les textes courts et hybrides

Les outils peinent sur les textes inférieurs à 300 tokens : tweets, légendes, commentaires. Les analyses montrent qu’un minimum de 400-500 tokens est nécessaire pour un verdict statistiquement fiable (Arxiv, 2024). Les textes co-écrits homme + IA brouillent aussi les pistes : la détection phrase par phrase tombe souvent sous 60 % de précision.

4. L’adaptation rapide des modèles

Les modèles génératifs évoluent plus vite que les détecteurs. ChatGPT 5 ou Gemini 2.5 Pro peuvent reformuler leurs propres sorties pour échapper à un outil spécifique. Les chercheurs appellent cela le “feedback adversarial loop” : chaque amélioration côté détection est immédiatement neutralisée par les LLMs eux-mêmes.

Recommandations pratiques et conclusion

Utiliser les détecteurs avec discernement

- Ne jamais accuser sur un score seul. Un résultat supérieur à 90 % doit susciter une vérification, pas une sanction automatique.

- Combiner plusieurs outils : Copyleaks + GPTZero + Originality.ai réduit la probabilité de faux positif à moins de 0,01 % (Journal of Physiology, 2024).

- Croiser avec un jugement humain : la lecture experte reste irremplaçable pour repérer incohérences conceptuelles ou stylistiques.

Privilégier la transparence

Les institutions et rédactions devraient adopter une politique claire :

- Déclaration de l’usage d’IA dans les productions.

- Formation à la littératie IA pour étudiants, enseignants et journalistes.

- Audit régulier des détecteurs pour vérifier équité et biais.

Vers une détection plus fiable

L’avenir se joue dans trois directions :

- Watermarking natif universel, intégré à tous les grands modèles (OpenAI, Anthropic, Google).

- Détection intégrée : les LLMs eux-mêmes signaleront leur propre authorship.

- Certification de contenu via le Content Authenticity Initiative et l’AI Model Passport européen (EU AI Act, 2025).

En résumé

La détection IA en 2025 progresse vite, mais la fiabilité reste conditionnelle. Les outils les plus précis atteignent 95-99 % de réussite, mais tombent à 60 % dès qu’ils affrontent du contenu paraphrasé ou hybride. Le seul protocole sûr repose sur une combinaison : détection automatisée + analyse humaine + transparence sur l’usage de l’IA.

L’objectif n’est pas de traquer la technologie, mais de rétablir la confiance entre créateurs, institutions et lecteurs à l’ère de l’intelligence artificielle.

FAQ – Détecter IA : les questions les plus fréquentes en 2025

Comment détecter si un texte a été écrit par une IA comme ChatGPT 5 ?

Les outils les plus fiables en 2025 sont Copyleaks, Originality.ai Turbo et Scribbr Premium. Ils analysent la structure, la cohérence et la signature statistique du texte. Cependant, aucun détecteur n’est infaillible : une reformulation via un autre modèle (Claude 4.5, Gemini 2.5 Pro…) peut tromper l’analyse. L’idéal est de croiser plusieurs outils et de compléter par une relecture humaine.

Quels sont les meilleurs outils gratuits pour détecter IA ?

Pour un usage ponctuel, les plus efficaces sont :

- Fast-DetectGPT (open source, gratuit)

- GPTZero (version gratuite limitée)

- Forensically pour les images

- Deepware Scanner pour les vidéos et les voix

Ils offrent de bons résultats sur du contenu simple, mais les outils professionnels restent indispensables pour une vérification fiable.

Peut-on détecter IA dans les images et les vidéos ?

Oui, grâce à des technologies comme SynthID (Google DeepMind) ou VideoSeal (Meta). Elles repèrent des motifs statistiques invisibles ou des incohérences lumineuses. Les versions 2025 atteignent jusqu’à 98 % de précision, mais perdent en fiabilité si l’image est recadrée ou compressée.

Est-ce qu’on peut détecter IA dans une voix ?

Oui. Des outils comme Resemble Detect ou FakeCatcher Audio analysent les fréquences et les micro-variations naturelles de la voix humaine. Les deepfakes audio sont de plus en plus réalistes, mais une écoute attentive révèle souvent un rythme trop constant ou une émotion artificielle.

Comment éviter les faux positifs des détecteurs IA ?

- Ne jamais se fier à un seul score.

- Éviter les textes trop courts (< 300 mots).

- Vérifier le contexte : auteur, style habituel, date.

- Combiner plusieurs détecteurs pour réduire les erreurs. Les universités et médias recommandent toujours une validation humaine avant toute conclusion.

Un texte généré par IA est-il pénalisé par Google ?

Non, tant qu’il est utile et original. Google pénalise uniquement les contenus IA de masse sans valeur ajoutée, dits scaled content abuse. Un article relu, corrigé et enrichi par un humain reste parfaitement conforme aux consignes Google 2025.

Quelle est la méthode la plus fiable pour détecter IA en 2025 ?

Le watermarking natif, intégré directement dans les modèles (SynthID-Text, OpenAI Watermark), constitue la voie la plus prometteuse. Mais comme la paraphrase efface souvent ces signatures, la meilleure stratégie reste hybride : → Détection automatisée + analyse humaine + vérification de provenance.

Les détecteurs IA sont-ils biaisés ?

Oui, surtout ceux basés sur la perplexité. Ils confondent souvent le style des locuteurs non natifs ou des personnes neurodivergentes avec celui d’une IA. Les modèles récents comme Copyleaks 2025 corrigent partiellement ce biais, mais les études académiques (Stanford HAI, 2023 ; Frontiers in AI, 2025) recommandent prudence et transparence.

Peut-on contourner les détecteurs IA ?

Oui, facilement. Les outils comme Quillbot, BypassGPT ou Humanize Pro peuvent reformuler un texte IA pour passer inaperçu. Les chercheurs parlent d’attaques adversariales, capables de réduire la détection à 0-15 %. C’est pourquoi la détection purement algorithmique ne suffit plus : le jugement humain reste essentiel.

Quelle est la future tendance de la détection IA ?

L’avenir repose sur trois axes :

- Watermarking cryptographique universel (Google, OpenAI, Meta).

- AI Model Passport, imposé par le règlement européen AI Act pour assurer traçabilité et auditabilité.

- Détection intégrée aux LLM, où les modèles signaleront eux-mêmes leurs productions.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !