Google présente Gemma 3 270M, un modèle d’IA miniature mais surprenant

Depuis plusieurs mois, les géants de la tech rivalisent pour proposer des modèles d’intelligence artificielle toujours plus massifs, nécessitant des dizaines de milliards de paramètres et des fermes de GPU pour fonctionner. Pourtant, Google choisit une autre voie avec la sortie de Gemma 3 270M, un modèle d’IA miniature, conçu pour tourner localement sur des appareils comme un smartphone, un ordinateur portable ou même directement dans un navigateur web. Et le plus étonnant, c’est que malgré sa taille réduite, ce modèle parvient à se montrer utile et efficace dans de nombreux cas d’usage concrets.

Gemma 3 270M : petit modèle IA, grands usages

Avec ses 270 millions de paramètres, Gemma 3 270M se situe à l’opposé des modèles géants comme Llama 3 ou Gemini Ultra. Là où ces derniers visent des performances maximales et une large connaissance, Google a pensé Gemma 3 comme un outil pratique, rapide et léger, capable de fonctionner sans infrastructure lourde. Bien sûr avec une taille de 292 Mo, les connaissances embarquées sont limitées, mais ce n’est pas l’objectif du modèle.

Classification de texte et analyse de données

L’un des cas d’usage immédiats est la classification de texte. Imaginez un service qui trie automatiquement des emails, des avis clients ou des rapports en quelques secondes, sans connexion à Internet. Gemma 3 270M est taillé pour ce genre de tâches légères mais répétitives, où la rapidité et la faible consommation de ressources sont essentielles.

De la même manière, il peut être utilisé en analyse de données textuelles. Par exemple, une entreprise pourrait l’intégrer dans un outil de veille pour analyser des articles ou des notes internes, sans avoir besoin d’envoyer ses données sensibles vers un serveur externe. Cela permet non seulement de gagner en confidentialité, mais aussi de réduire la latence, car tout se fait en local.

Assistants embarqués et IA locale

L’autre grand avantage de Gemma 3 270M est son potentiel dans les assistants embarqués. Sur un Pixel 9 Pro équipé du processeur Tensor G4, Google a montré que le modèle pouvait gérer 25 conversations tout en ne consommant que 0,75 % de la batterie. C’est une prouesse en termes d’efficacité énergétique, qui ouvre la voie à des assistants personnels intégrés directement dans nos appareils : plus besoin de connexion cloud constante pour avoir des réponses rapides.

Un modèle pensé pour les développeurs

Tuning rapide et peu coûteux

L’un des points forts de Gemma 3 270M, c’est qu’il peut être personnalisé rapidement. Avec un modèle géant de plusieurs milliards de paramètres, le fine-tuning coûte cher, demande du matériel puissant (GPU haut de gamme, VRAM conséquente) et beaucoup de temps. Ici, la petite taille de Gemma rend le processus rapide, peu coûteux et accessible même pour des développeurs indépendants ou de petites équipes.

En clair, un développeur peut créer une version adaptée à un usage précis (par exemple un assistant médical, un outil d’analyse de données financières, ou un chatbot éducatif) sans avoir besoin d’une infrastructure démesurée, ni même de GPU. C’est un modèle flexible, taillé pour des projets concrets et spécialisés.

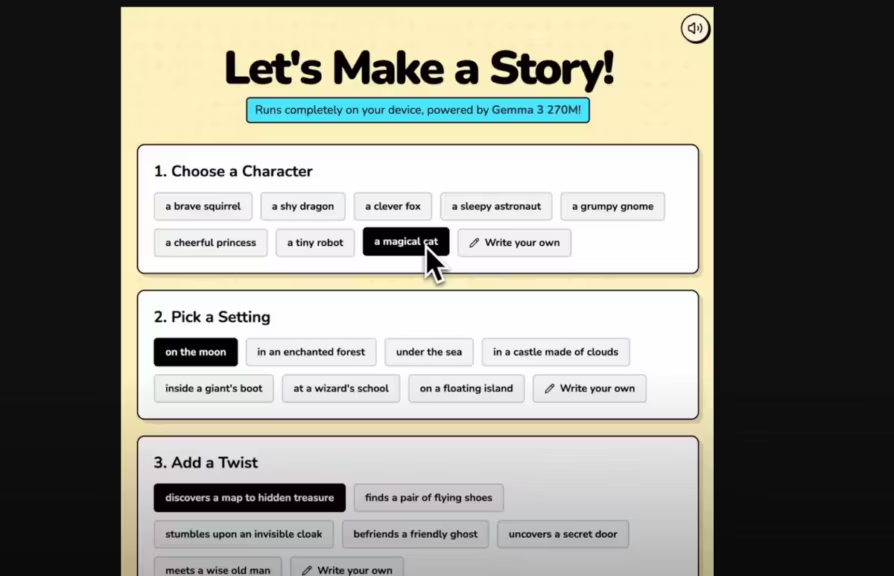

Exemple concret : un générateur d’histoires dans le navigateur

Pour illustrer le potentiel, Google a mis en avant un story generator fonctionnant entièrement dans le navigateur grâce à Transformer.js. Sans téléchargement lourd, sans serveur distant, il est possible de générer des histoires interactives directement depuis Chrome ou Firefox. Cet exemple montre à quel point Gemma 3 270M peut être intégré dans des expériences ludiques, pédagogiques ou créatives sans dépendance au cloud.

Un pas vers la démocratisation de l’IA

Là où les modèles géants restent réservés aux grands laboratoires et aux services cloud, Gemma 3 270M démocratise l’accès à l’IA. Sa petite taille ouvre la porte à :

- des applications mobiles intelligentes qui fonctionnent sans connexion ;

- des outils éducatifs accessibles dans un simple navigateur ;

- des solutions métiers spécialisées, adaptées via un tuning rapide ;

- des usages où la confidentialité des données est une priorité.

- une personnalisation et une confidentialité accrue avec un usage entièrement local

Google ne cherche pas à concurrencer les géants de la puissance brute, mais plutôt à montrer qu’une petite IA peut être utile au quotidien, s’executer sur des appareils que nous utilisons déjà. Nous abordons régulièrement le sujet des IA local sur Cosmo Games, cette tendance devrait s’accroitre dans les années à vvenir pour aboutir à des IA personnalisables et surtout plus confidentielles.

Performances et benchmarks : un petit modèle qui surprend

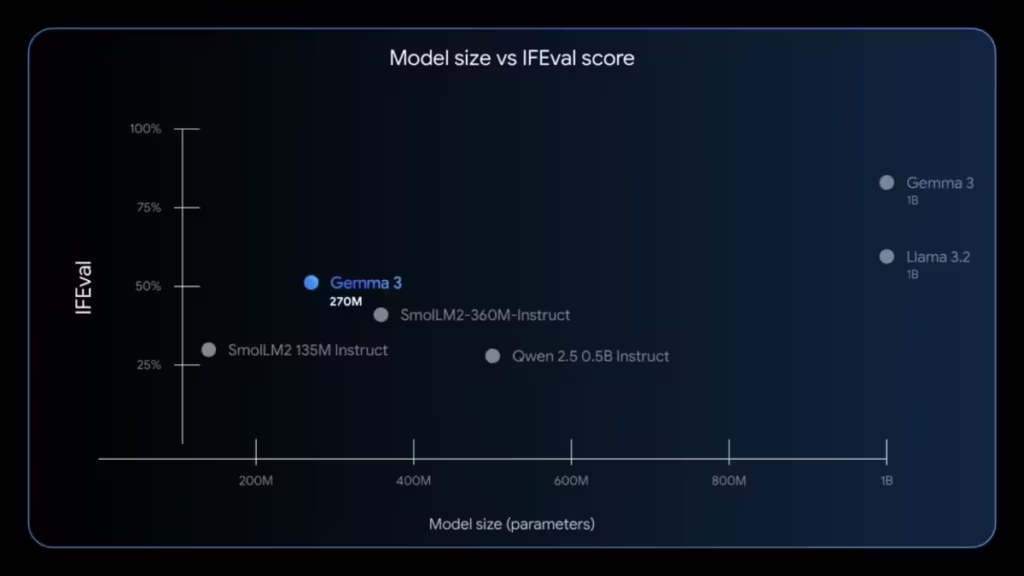

On pourrait croire qu’avec seulement 270 millions de paramètres, Gemma 3 270M ne peut rivaliser avec les modèles plus volumineux comme Llama 3.2 ou Mistral 7B. Pourtant, Google a publié des résultats encourageants.

Sur le benchmark IFEval (Instruction Following Evaluation), qui mesure la capacité d’un modèle à suivre correctement des instructions, Gemma 3 270M atteint un score de 51,2 %. Cela peut sembler modeste comparé aux modèles de plusieurs milliards de paramètres, mais ce score est en réalité supérieur à d’autres modèles “légers” disposant pourtant de plus de paramètres.

En clair, même s’il ne peut pas remplacer un modèle géant dans la génération de texte complexe ou la programmation avancée, Gemma 3 270M prouve que “miniature” ne veut pas dire “inefficace”.

Open, mais pas vraiment open source

Google qualifie Gemma de modèle “open”, mais il faut être clair : ce n’est pas de l’open source au sens strict.

- Les poids du modèle sont disponibles gratuitement sur Hugging Face, Kaggle et Vertex AI.

- Les développeurs peuvent télécharger, utiliser, modifier et déployer leurs propres dérivés.

- Mais les conditions d’utilisation imposent certaines restrictions :

- interdiction de tuner le modèle pour produire du contenu nuisible

- obligation de transmettre les conditions d’utilisation dans toutes les versions dérivées

- responsabilité laissée au développeur en cas de non-respect de la vie privée.

En d’autres termes, Gemma 3 270M se situe dans une zone intermédiaire : plus ouvert que des modèles fermés comme GPT-4 ou GPT-5, mais moins libre que des projets 100 % open source comme Mistral ou Falcon.

Une stratégie claire de Google : Tiny AI + Cloud IA

Avec Gemma 3 270M, Google montre qu’il veut occuper plusieurs segments du marché IA :

- Les modèles géants pour le cloud (Gemini 2.5 Pro), destinés aux datacenters, avec des performances maximales.

- Les modèles moyens (Gemma 3 27B) : destinés aux entreprises et développeurs qui souhaitent un modèle à executer en local sur des postes de travail (GPU conseillé) pour la confidentialité.

- Les modèles miniatures pour le local (Gemma 3 270M), destinés aux développeurs, aux particuliers et aux projets embarqués, sans nécessité de GPU.

Ce positionnement a plusieurs avantages :

- fidéliser les développeurs qui veulent tester des projets sans infrastructure coûteuse ;

- multiplier les cas d’usage dans le grand public, directement sur smartphone ou navigateur ;

- renforcer l’écosystème Vertex AI et Android, en intégrant Gemma dans des produits existants.

C’est aussi une manière de se différencier de Meta (avec LLaMA), Mistral, GPT-OSS, qui misent surtout sur des modèles open source intermédiaires, nécessitant un GPU. Un petit modèle comme Gemma 3 270M peut s’executer sur n’importe quel appareil ou même un serveur sans GPU. Cela ouvre la voie à de nombreux usages, plus spécialisés.

Limites et perspectives

Bien entendu, Gemma 3 270M n’est pas une solution miracle.

- Ses performances restent limitées face aux modèles de plus grande taille : pas question de lui demander d’écrire un essai scientifique ou de coder une application complexe.

- Ses connaissances sont limités, comme tous modèles de petite taille.

- Sa licence “open” mais restreinte peut rebuter les puristes de l’open source.

- Certains usages (traduction avancée, génération créative de haut niveau) nécessiteront toujours un modèle plus puissant.

Mais ses avantages sont clairs :

- accessibilité (téléchargeable gratuitement, utilisable partout) ;

- efficacité énergétique (batterie préservée sur smartphone) ;

- flexibilité (fine-tuning rapide et peu coûteux).

Avec ce modèle, Google envoie un signal : l’avenir de l’IA ne repose pas uniquement sur les géants de plusieurs dizaines de milliards de paramètres. Les petits modèles, eux aussi, ont un rôle clé à jouer dans la démocratisation de l’intelligence artificielle. L’intégration dans différents outils devient ainsi plus facile.

Conclusion : une IA pragmatique, pour des usages concrets

Gemma 3 270M n’est pas là pour impressionner par sa puissance brute. Son ambition est autre : offrir une IA miniature, surprenante par son efficacité, et surtout utile dans des cas d’usage réels, mais spécifiques.

Que ce soit pour classer des textes, analyser rapidement des données, créer des assistants embarqués ou tester un story generator directement dans un navigateur via Transformer.js, ce modèle ouvre la voie à une nouvelle génération de projets IA accessibles à tous.

Google mise sur la Tiny AI pour compléter ses offres cloud et répondre à une demande croissante : celle d’une IA locale, rapide, sobre et respectueuse de la confidentialité.

Gemma 3 270M est disponible sur des plateformes comme Hugging Face, Kaggle, Ollama, aussi bien en version pré-entraînée qu’en version optimisée pour le suivi d’instructions. Le modèle est également accessible via Google Vertex AI pour effectuer des tests.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !