Google TPU Trillium : c’est quoi cette puce IA et en quoi diffère-t-elle d’un GPU ?

Le Google TPU Trillium, ou TPU v6e, est la nouvelle puce IA conçue par Google pour entraîner et faire tourner des modèles géants comme Gemini 3, à un moment où l’industrie fait face à une pénurie mondiale de GPU. Selon l’annonce officielle « Introducing Trillium » publiée sur le blog Google Cloud (source), cette génération apporte un gain de 4,7× en puissance de calcul, une bande passante mémoire doublée et une efficacité énergétique largement améliorée, ce qui en fait l’accélérateur le plus avancé du géant de Mountain View.

Contrairement aux GPU, conçus comme des composants polyvalents, Trillium est une puce spécialisée, optimisée pour les énormes multiplications de matrices qui alimentent les LLM et les modèles multimodaux modernes. Dans cet article, nous verrons ce qu’est réellement le TPU Trillium, en quoi son fonctionnement diffère d’un GPU, et pourquoi cette puce arrive à un moment critique pour le marché de l’IA et les coûts d’entraînement des modèles.

Google TPU Trillium : c’est quoi exactement ?

Le TPU Trillium est un processeur dédié à l’intelligence artificielle, utilisé dans les data centers de Google. Il est déjà intégré à l’infrastructure AI Hypercomputer, dont les détails sont présentés dans le billet officiel « Scaling AI workloads with the AI Hypercomputer » (source).

Une puce IA pensée pour les calculs massifs

Trillium exécute des calculs massifs sur des matrices, qui constituent l’opération fondamentale des réseaux neuronaux. Google précise dans sa documentation que le MXU (Matrix Multiply Unit) représente le cœur de cette accélération, et que l’ensemble de la puce est conçu pour alimenter des modèles lourds comme les LLM longue séquence, les modèles de diffusion ou les architectures Mixture-of-Experts.

Google utilise ces TPU pour entraîner des modèles avancés, comme Gemini 3, dans ses data centers. Cette intégration verticale matériel + logiciel permet d’optimiser les performances et la consommation énergétique par rapport aux GPU génériques.

Pourquoi Google fabrique ses propres TPU ?

Deux raisons principales :

- Réduire la dépendance aux GPU Nvidia, qui dominent le marché.

- Contourner la pénurie de GPU, qui ralentit les centres de données depuis 2024.

Google dispose déjà de dizaines de milliers de puces Trillium déployées, ce qui lui offre une capacité d’entraînement autonome et une meilleure maîtrise des coûts. C’est aussi l’un des facteurs qui lui permet de proposer des tarifs Gemini, en particulier sur les API, plus bas que de nombreux concurrents, en profitant d’un matériel optimisé en interne plutôt que de dépendre exclusivement des GPU Nvidia.

Comment fonctionne le TPU Trillium ?

Le fonctionnement de Trillium repose sur trois piliers techniques essentiels :

- le MXU, conçu pour multiplier d’immenses matrices,

- la mémoire HBM à très haute bande passante,

- une interconnexion torus 2D, permettant aux puces de communiquer très rapidement.

Ces éléments sont décrits en détail dans la documentation officielle TPU v6e publiée par Google Cloud (source).

L’architecture MXU : le cœur du calcul IA

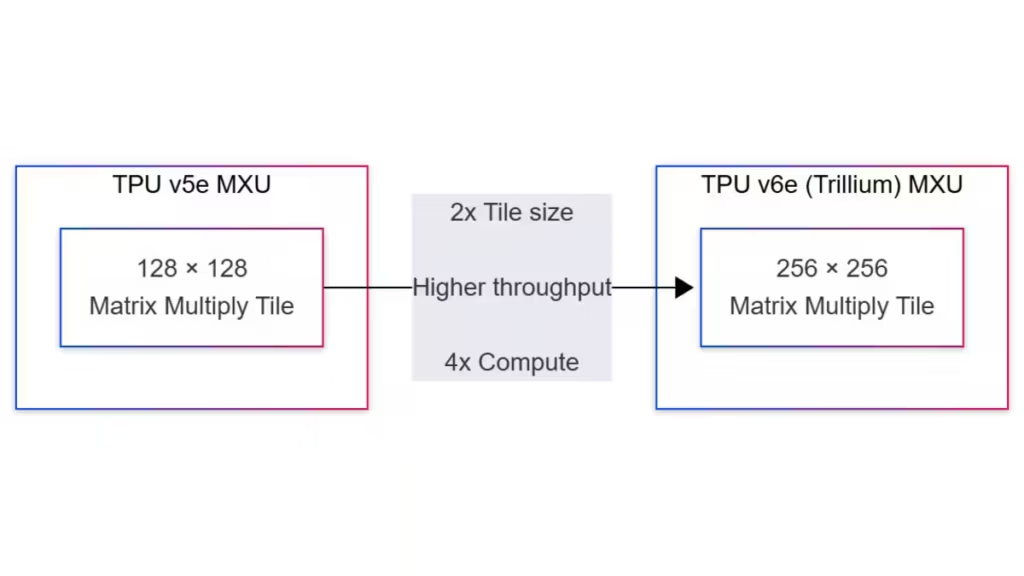

La principale unité de calcul de Trillium est le MXU. Trillium passe à un tile de 256 × 256, soit 4× la surface de calcul du v5e. Ce changement améliore fortement le débit pour les modèles IA nécessitant de très grandes matrices, comme les LLM longue séquence, les modèles multimodaux ou les pipelines de diffusion.

HBM, bande passante et interconnexion

Trillium intègre 32 Go de HBM et une bande passante mémoire de 1600 Go/s, contre 800 Go/s pour la génération précédente. Comme expliqué dans la documentation TPU v6e, cela permet d’alimenter efficacement le MXU sans créer de goulots d’étranglement.

Son interconnexion interne en torus 2D, visible dans les schémas techniques de Google, permet de relier jusqu’à 256 TPU avec une bande passante agrégée dépassant les 100 To/s.

| Métrique | TPU v5e | TPU v6e (Trillium) | Amélioration |

|---|---|---|---|

| Débit SDXL | Baseline, limité par la HBM | Débit nettement supérieur | Substantielle |

| Capacité HBM | 16 Go | 32 Go | 2× |

| Bande passante mémoire | ~800 Go/s | 1600 Go/s | 2× |

| Taille de tuile MXU | 128 × 128 | 256 × 256 (surface de calcul ×4) | Performances supérieures |

| Efficacité pour la diffusion | Modérée | Fortes améliorations | Améliorée |

| Taille de lot idéale | Petits lots | Lots plus grands sans blocages | Augmentée |

| Cas d’usage recommandés | Tâches de diffusion légères/moyennes | SDXL, modèles de diffusion volumineux | Étendus |

Pour aller plus loin : TPU Trillium v6e vs v5e et v5p, les gains de performances expliqués simplement

TPU vs GPU : quelles différences majeures ?

Les comparaisons entre TPU et GPU sont fréquentes, mais leurs objectifs sont différents. Le GPU reste polyvalent, alors que le TPU est spécialisé pour les calculs IA massifs.

Le GPU : polyvalent et compatible logiciels

Les GPU Nvidia restent la référence du marché, grâce à CUDA, leur écosystème logiciel ultra mature. Comme indiqué dans plusieurs analyses (CNBC, HyperFrame Research, MLCommons), les GPU sont utilisés partout :

- PC de bureau,

- serveurs,

- calcul scientifique,

- entraînement IA généraliste.

Les GPU AMD existent aussi, mais leur écosystème logiciel n’égale pas encore celui de Nvidia, ce qui limite leur adoption pour les charges IA critiques.

Le TPU : spécialisé et optimisé pour les LLM

Le TPU Trillium est conçu pour les charges très structurées et les modèles géants. Son architecture MXU et sa bande passante mémoire élevée permettent de traiter efficacement les LLM, les pipelines multimodaux et la diffusion. Contrairement au GPU, il n’est pas destiné à être utilisé sur un PC personnel, mais dans les data centers.

Performances : quand le TPU prend l’avantage

Pour les charges massivement parallélisables comme l’entraînement de LLM ou la diffusion, Trillium offre une meilleure efficacité énergétique et une mise à l’échelle plus stable. Les données publiées indiquent un pic de 918 TFLOPS en BF16, ce qui le place sous les GPU Nvidia H100/H200 en performance brute spécialisée. À titre de comparaison, une H100 atteint entre 1 671 TFLOPS (version PCIe) et 1 979 TFLOPS (SXM5) en BF16 grâce à ses Tensor Cores.

| Spécification | TPU v5e | TPU v6e (Trillium) | Amélioration |

|---|---|---|---|

| Calcul BF16 | ~195 TFLOPS (estimation) | 918 TFLOPS | ~4,7× |

| Capacité HBM par puce | 16 Go | 32 Go | 2× |

| Bande passante HBM par puce | ~800 Go/s | 1600 Go/s | 2× |

| Bande passante interconnect | ~1,6 Tb/s | 3,2 Tb/s | 2× |

| Efficacité énergétique | Baseline | +67 % | +67 % |

| Taille d’un pod | 256 puces | 256 puces | Meilleure montée en charge |

| Charges de travail visées | LLM, ML général | LLM longs contextes, diffusion | Plage d’usage élargie |

Pourquoi Trillium arrive au bon moment ?

Le lancement du TPU Trillium intervient dans un contexte où la demande mondiale en calcul IA dépasse largement la capacité de production des GPU. Comme le soulignions dans un précédent article, les entreprises se battent pour accéder aux GPU haute performance. Les délais d’approvisionnement s’allongent et les coûts explosent, ce qui freine le développement de nouveaux modèles IA.

Dans cette situation, Google dispose d’un avantage décisif : la capacité de déployer ses propres accélérateurs. Avec plus de 100 000 puces Trillium déjà intégrées à son infrastructure AI Hypercomputer, Google assure une indépendance matérielle rare dans l’industrie.

La pénurie mondiale de GPU depuis 2024

Depuis 2024, les centres de données font face à une pénurie chronique de GPU, principalement liée à la demande explosive des LLM, des modèles multimodaux et des systèmes génératifs. Les analyses marché, notamment celles de HyperFrame Research (source), montrent que cette rareté provoque une hausse significative des coûts d’entraînement et ralentit les cycles d’innovation.

En développant ses propres TPU, Google peut contrôler son approvisionnement et contourner la volatilité du marché des GPU Nvidia. Trillium améliore aussi le ratio performance par watt, un facteur critique pour les data centers où l’électricité représente une part croissante des dépenses.

A lire également : Pourquoi ChatGPT, Claude et autres IA deviennent plus lents en 2025 ?

L’essor des LLM, agents IA et modèles multimodaux

Les usages de l’IA se multiplient à un rythme inédit : assistants conversationnels, agents IA autonomes, génération d’images et de vidéos, outils multimodaux et systèmes de recommandation. Ces modèles nécessitent des capacités de calcul colossales, en particulier pour les longues séquences et les contextes étendus.

Comme détaillé dans la documentation Google TPU v6e (source), Trillium est optimisé pour ces charges modernes grâce à une combinaison équilibrée entre compute BF16, bande passante mémoire et interconnexion rapide. Cette architecture répond parfaitement aux besoins des modèles actuels comme Gemini 3, dont les capacités multimodales exigent une gestion efficace de flux de données beaucoup plus complexes.

Quels usages concrets pour le TPU Trillium ?

Au delà de ses caractéristiques techniques, le TPU Trillium se distingue par des applications très concrètes au sein des infrastructures Google. Il alimente directement les services IA utilisés par des millions de personnes.

Entraîner des modèles comme Gemini 3

Le TPU Trillium joue un rôle essentiel dans l’entraînement de Gemini 3 et des modèles de nouvelle génération. Avec ses 918 TFLOPS BF16, son tile MXU élargi et sa bande passante mémoire doublée, Trillium réduit les temps d’entraînement et améliore la capacité à gérer des séquences longues et des modèles multimodaux.

Les explications techniques provenant de la documentation officielle Google Cloud confirmant l’usage du torus 2D pour relier jusqu’à 256 puces (source) montrent que cette architecture permet une synchronisation rapide lors des opérations collectives, essentielles à l’entraînement distribué.

Accélérer la génération d’images et la diffusion

Le TPU Trillium montre également des progrès dans la génération d’images, notamment pour des modèles de diffusion. Comme expliqué sur Cosmo Edge, la mémoire HBM doublée réduit les micro-goulots d’étranglement et améliore le débit de la diffusion, utile pour les pipelines complexes tels que SDXL.

Même si Google n’a pas publié de benchmarks chiffrés SDXL pour Trillium, les améliorations architecturales, confirment une progression naturelle par rapport au v5e sur les workloads impliquant des calculs matriciels large bande passante.

Google vs Nvidia : un vrai rival ou un complément ?

L’arrivée du TPU Trillium soulève une question fréquente dans l’industrie : Google est-il en train de devenir un concurrent direct de Nvidia, ou développe-t-il un outil complémentaire au GPU ?

Selon les analyses, notamment les rapports de Investing.com, AICerts et CNBC, l’annonce du TPU Trillium a provoqué une légère baisse du cours de Nvidia en raison des inquiétudes des investisseurs concernant la montée des alternatives. Cependant, comme le précise CNBC dans son article sur l’impact du partenariat Google-Meta (source), Nvidia conserve une position dominante grâce à son écosystème logiciel complet et à l’adoption massive de CUDA.

La place dominante des GPU

Les GPU Nvidia H100, H200 et B100 restent la référence pour les développeurs, les data scientists et les entreprises. Ils offrent une polyvalence incomparable, une compatibilité avec tous les frameworks IA et une disponibilité commerciale large. Google reste un client important de Nvidia, même après le déploiement massif de Trillium, ce qui illustre une relation compétitive mais aussi complémentaire.

Les GPU AMD sont aussi présents sur le marché, mais leur écosystème logiciel ne rivalise pas encore avec celui de Nvidia, ce qui limite leur usage pour les modèles IA les plus critiques.

L’arrivée de Trillium change-t-elle la donne ?

Le TPU Trillium propose une alternative solide pour les modèles de très grande échelle, mais il reste destiné exclusivement aux infrastructures Google. Pour le reste du marché, les GPU restent incontournables. Le rôle de Trillium est donc celui d’un complément stratégique, permettant à Google de gérer ses charges massives sans dépendre entièrement de Nvidia.

Cette diversification renforce la compétition, sans pour autant remettre en cause la domination immédiate des GPU dans l’écosystème IA.

À retenir

Le Google TPU Trillium arrive à un moment clé où l’industrie fait face à une pénurie mondiale de GPU, ralentissant les déploiements de centres de données et augmentant le coût d’entraînement des modèles IA géants. Dans ce contexte, Trillium constitue une réponse stratégique au goulet d’étranglement provoqué par la dépendance au matériel Nvidia. Grâce à des dizaines de milliers de puces déjà déployées dans l’AI Hypercomputer, Google bénéficie d’une capacité d’entraînement autonome, plus prévisible et mieux maîtrisée sur le plan énergétique. La société offre ainsi une puissance de calcul spécialement optimisée pour les modèles géants comme Gemini 3

L’association d’un matériel spécialisé et d’optimisations logicielles joue également un rôle crucial dans la réduction des coûts. Des techniques comme l’amélioration des kernels d’attention, la gestion avancée du KV-cache ou encore des formats de compression comme le DFloat11 montrent comment l’innovation logicielle peut compléter les gains matériels, tout en rendant l’inférence plus abordable pour les entreprises et les développeurs.

Trillium renforce aussi la position de Google comme concurrent crédible face à Nvidia. Ses progrès en débit, en efficacité énergétique et en mise à l’échelle par « pods » en font une alternative attractive pour les modèles multimodaux ou les architectures Mixture-of-Experts. Ces avancées ont même entraîné des réactions ponctuelles sur les marchés financiers, la concurrence des TPU ayant provoqué une baisse modérée de l’action Nvidia. Nvidia reste toutefois le leader incontesté grâce à l’écosystème CUDA et à la polyvalence de ses GPU, tandis que Google continue d’utiliser massivement des GPU Nvidia dans ses propres infrastructures.

Enfin, plusieurs signaux laissent penser que Google pourrait, à terme, proposer ses TPU pour des déploiements on-premise destinés aux hyperscalers ou aux grandes entreprises. Même si un TPU « desktop » reste improbable, cette évolution dessine un futur où l’infrastructure IA pourrait devenir hybride, combinant accélérateurs cloud et serveurs locaux spécialisés.

Comprendre aujourd’hui les choix techniques derrière le TPU Trillium, c’est donc anticiper une partie de l’évolution de l’IA à grande échelle pour les prochaines années.

Sources et références

Médias technologiques

- 2025 — Comme le rapporte CNBC dans son analyse de l’impact du partenariat Google Meta sur Nvidia, la concurrence des TPU commence à influencer les marchés. https://www.cnbc.com/2025/11/25/nvidia-shares-today-google-meta-ai-chip-report.html

- 2024 — HyperFrame Research discute en détail du potentiel des TPU Trillium face aux GPU Nvidia et de leur impact sur le marché des accélérateurs IA. https://hyperframeresearch.com/2024/12/12/can-googles-trillium-tpu-challenge-nvidias-dominance-in-ai-hardware/

Entreprises

- 2025 — Annonce officielle de Google Cloud présentant le TPU Trillium, ses gains de performance et ses optimisations architecturales. https://cloud.google.com/blog/products/compute/introducing-trillium-6th-gen-tpus

- 2025 — Présentation de l’architecture AI Hypercomputer, décrivant l’intégration des TPU Trillium dans l’infrastructure Google. https://cloud.google.com/blog/products/compute/scaling-ai-workloads-with-the-ai-hypercomputer

Institutions

- 2024 — MLCommons publie les benchmarks MLPerf, utilisés pour comparer les performances matérielles des puces IA à grande échelle. https://mlcommons.org

Sources officielles

- 2025 — Documentation technique officielle du TPU v6e détaillant l’architecture, la mémoire HBM et la topologie du torus 2D. https://docs.cloud.google.com/tpu/docs/v6e

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !