IA local : guide complet pour installer et utiliser un modèle sur votre ordinateur

L’intelligence artificielle (IA) n’est plus limitée aux services en ligne. Il est possible d’installer un modèle LLM localement sur votre ordinateur pour profiter d’une IA privée et sans connexion internet. Ce guide vous explique comment installer et utiliser un modèle IA local en toute simplicité avec LM Studio, en prenant DeepSeek comme exemple.

J’ai testé cette solution sur deux machines :

- Un PC portable équipé d’un Intel i7-12700H, 32 Go de RAM et une RTX 3060.

- Un PC fixe doté d’un Ryzen 9 5900X, 32 Go de RAM et une RTX 3070 Ti.

En prenant un LLM avec un paramétrage de 7B et une quantization (je vous conseille de lire rapidement le lexique simplifié du LLM, si ce termes ne vous parlent pas), les performances étaient bonnes, avec une vitesse de réponse similaire à celle de ChatGPT. Sans GPU, la génération de texte est sans surprise plus lente.

Pourquoi utiliser une IA local sur votre ordinateur ?

L’installation d’un modèle LLM localement présente plusieurs avantages :

- Confidentialité : Aucune donnée ne transite par des serveurs externes.

- Performance : Les réponses peuvent être plus rapides en fonction du matériel.

- Accès illimité : Plus besoin d’abonnement ou de connexion internet pour utiliser votre IA.

Cependant, exécuter une IA localement nécessite des ressources matérielles adaptées. Un processeur puissant et un GPU avec suffisamment de VRAM sont recommandés.

A lire : Peut-on installer un LLM en local sur un PC avec une carte Nvidia ?

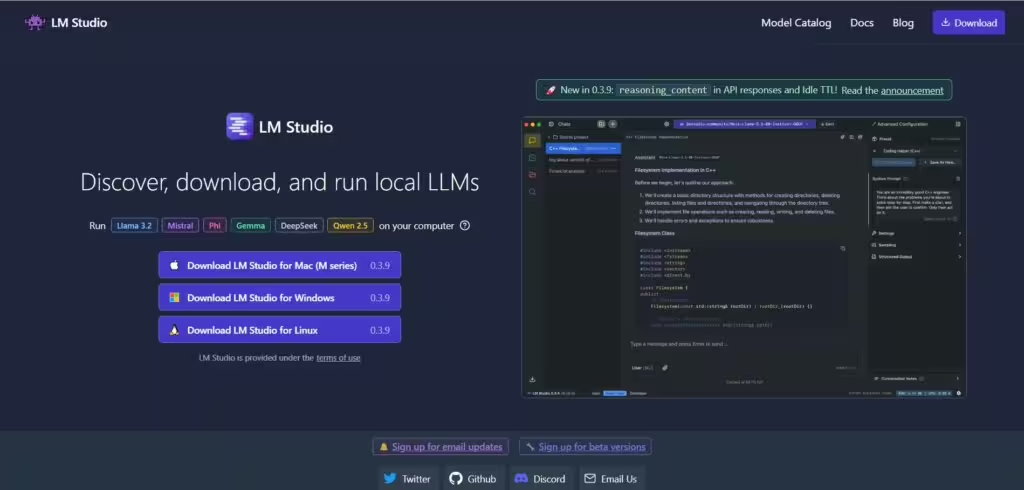

LM Studio : la solution simple pour exécuter une IA en local

LM Studio est un logiciel open source permettant d’installer et de faire fonctionner un modèle IA en local sur un ordinateur Windows, macOS ou Linux. Son interface intuitive facilite le téléchargement et l’utilisation des modèles LLM.

A l’heure où j’écris ces lignes, il se concentre sur la génération de texte. Il y a d’autres solutions pour installer un modèle d’IA en local, nous les aborderons plus loin sur cette page.

Étape 1 : Installer LM Studio

- Rendez-vous sur le site officiel de LM Studio et téléchargez la version compatible avec votre système d’exploitation.

- Installez le programme en suivant les instructions à l’écran.

- Lancez LM Studio après l’installation.

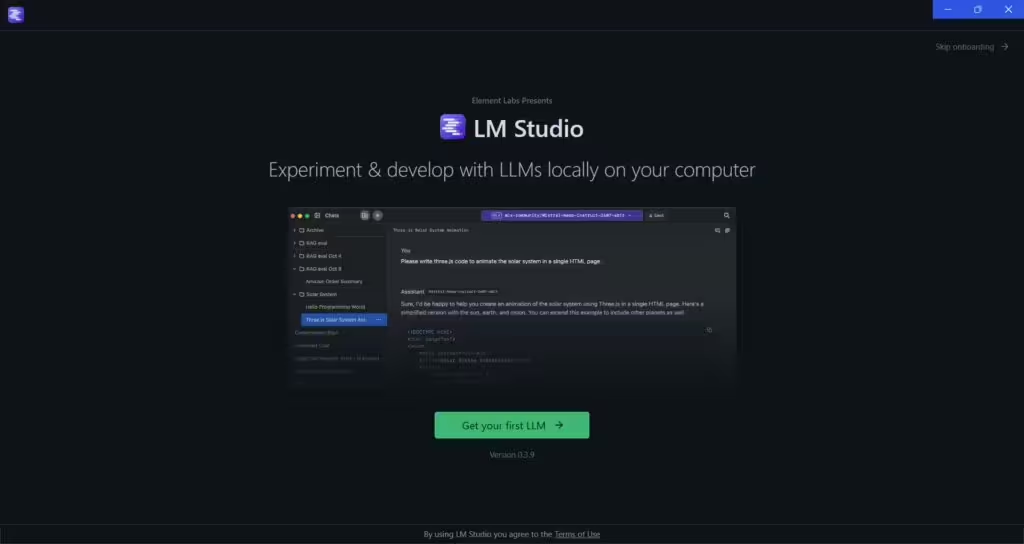

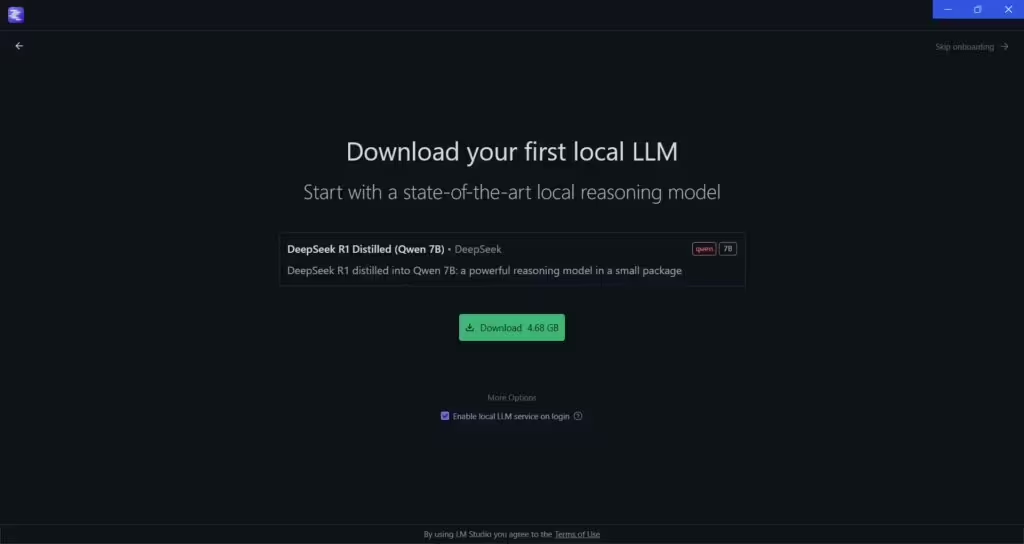

Étape 2 : Télécharger et installer un modèle LLM localement

- Ouvrez LM Studio et cliquez sur « Get your First LLM ».

- Dans la liste des modèles disponibles, recherchez par exemple DeepSeek.

- Cliquez sur « Download » pour commencer le téléchargement du modèle.

- Une fois le téléchargement terminé, sélectionnez DeepSeek dans le menu déroulant « Select a model to load ».

- Cliquez sur « Load model » pour le charger dans LM Studio.

Lorsque vous avez terminé, n’oubliez pas de cliquer sur « Eject » afin de décharger le modèle de votre mémoire (RAM ou VRAM en fonction de votre matériel). Attention pour le GPU, le modèle restera en mémoire et occupera votre VRAM si vous ne faites pas cette opération.

Étape 3 : Utiliser DeepSeek en local sur votre ordinateur

Une fois le modèle IA chargé, vous pouvez commencer à l’utiliser directement depuis LM Studio. Le menu de gauche propose plusieurs options :

- Chat : Interagissez avec l’IA comme avec ChatGPT. Rédigez un prompt et obtenez la réponse.

- Developper : Utilisez l’API LM Studio. Avec cette API, vous pourrez automatiser des tâches (sélectionner un model, charger un model, envoyer un prompt, récupérer la réponse ….)

- My Models : retrouvez ici tous vos modèles téléchargés.

- Discover : Explorez, téléchargez et gérez les différents LLMs.

Étape 4 : Optimiser les performances

Pour améliorer l’exécution du modèle sur votre ordinateur, voici quelques recommandations :

- Privilégiez un modèle quantifié (ex. DeepSeek en 4-bit) pour réduire la consommation de VRAM ou RAM.

- Assurez-vous d’avoir suffisamment de mémoire vive (16 Go de RAM minimum conseillés).

- Utilisez un GPU compatible pour accélérer le traitement des requêtes.

IA locale : une alternative viable aux services en ligne ?

L’utilisation d’une IA en local sur un ordinateur est une solution idéale pour les utilisateurs souhaitant garder le contrôle de leurs données et ne pas dépendre d’une connexion internet. C’est également parfait pour explorer les différents modèles d’IA. Cependant, les performances dépendent fortement du matériel disponible. Pour des tâches complexes, les solutions cloud restent plus performantes.

Pour les développeurs ou les utilisateurs avancés, c’est une excellente occasion d’explorer les possibilités des LLM. Enfin en combinant différents modèles dans votre flux de travail, en tenant compte de leurs forces et faiblesses, vous améliorer votre productivité.

En conclusion, installer un modèle IA localement sur votre PC est une option accessible et pertinente, surtout avec des outils comme LM Studio. Vous pouvez ainsi profiter d’un assistant IA privé, rapide et optimisé selon vos besoins. Pour les plus curieux, c’est aussi l’occasion d’explorer toutes les possibilités des différentes LLM.

Pour aller plus loin : Comment choisir le bon LLM pour ses besoins ?

Alternatives à LM Studio

LM Studio a l’avantage d’être très accessible. Toutefois pour ceux qui souhaitent aller plus loin,il existe d’autres solutions pour installer une IA en local.

Si vous êtes un dévelloppeur ou tout simplement à l’aise avec les outils avancés, je vous recommande de déployer les modèles avec des conteneurs Docker avec WSL2 (et pas Docker Desktop pour des problèmes de performance). Utiliser Hugging Face pour identifier les modèles et obtenir les intructions d’installation. Cela requiert quelques lignes de commande, mais c’est la solution la plus efficace, performante, souple et ouverte.

Autrement pour se simplifier la vie, voici les alternatives à LM Studio :

1. Ollama

- Plateformes : Windows, macOS, Linux

- Facilité : Très simple à installer

- Modèles supportés : Llama 2, Mistral, Gemma

- Avantages :

- Interface en ligne de commande intuitive

- API intégrée pour usage local

- Compatible CPU/GPU

- Site officiel

A lire également : Comment installer Ollama sur Windows, Mac et Linux : guide complet pour débutants

2. GPT4All

- Plateformes : Windows, macOS, Linux

- Facilité : Interface graphique + CLI

- Modèles supportés : Plusieurs LLM allégés

- Avantages :

- Facile d’utilisation avec une interface graphique

- Fonctionne hors ligne

- Supporte divers modèles optimisés

- Site officiel

3. Text Generation WebUI (ex-Oobabooga)

- Plateformes : Windows, Linux

- Facilité : Interface avancée

- Modèles supportés : Llama, Mistral, Falcon, GPTQ, GGUF

- Avantages :

- Interface web intuitive et personnalisable

- Compatible avec exllama et CUDA pour Nvidia

- Support des modèles optimisés CPU/GPU

- Dépôt GitHub

4. LM Deploy

- Plateformes : Windows, Linux

- Facilité : Pour utilisateurs avancés

- Modèles supportés : LLM optimisés pour GPU Nvidia

- Avantages :

- Ultra-performant avec CUDA et TensorRT

- Support des modèles quantifiés

- Pensé pour un usage industriel

- Dépôt GitHub

5. KoboldCPP

- Plateformes : Windows, Linux

- Facilité : Facile d’installation

- Modèles supportés : GGUF

- Avantages :

- Léger et optimisé pour CPU/GPU

- Interface simple pour le chat et les jeux de rôle textuels

- Très rapide en exécution locale

- Dépôt GitHub

6. llama.cpp

- Plateformes : Windows, macOS, Linux

- Facilité : Ligne de commande

- Modèles supportés : Llama, Mistral en format GGUF

- Avantages :

- Très léger, fonctionne même sans GPU puissant

- Optimisé pour CPU

- Open-source et très actif

- Dépôt GitHub

Conclusion : Quelle alternative choisir ?

- Débutants → ? Ollama ou ? GPT4All

- Utilisateurs avancés → ? Text Generation WebUI ou ? LM Deploy

- PC sans GPU puissant → ? KoboldCPP ou ? llama.cpp

- Optimisation GPU et performances maximales → ? LM Deploy

- Pour les utilisateurs avancés et un contrôle total → Docker et déploiement en ligne de commande.

? Pour un bon équilibre entre facilité et performance, GPT4All et Ollama sont de très bons choix !

Si vous êtes développeur ou que la technique ne vous fait pas peur, je vous recommande d’utiliser Docker pour installer différents modèles d’IA. Ce guide vous présente les meilleures solutions pour installer Docker sous Windows 11. Et si vous n’êtes pas réticent aux procédures d’installation, n’hésitez pas à consulter ce tutoriel pour installer Docker avec WSL 2 (sans Docker Desktop). Cette méthode vous permettra d’optimiser les performances et d’exploiter pleinement votre GPU.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !