Comment installer Ollama sur Windows, Mac et Linux : guide complet pour débutants

Vous cherchez un guide Ollama vraiment simple pour installer un LLM open source sur votre machine ? Que vous soyez sur Windows, Mac ou Linux, ce tutoriel pas à pas est conçu pour tous les débutants qui veulent se lancer dans l’aventure de l’IA locale, sans prise de tête. Que ce soit pour écrire, coder ou générer des descriptions d’images, Ollama est un excellent outil pour installer un LLM local facilement et en toute sécurité.

Avant de plonger dans le tutoriel, petit rappel : Ollama est un logiciel qui permet de télécharger, gérer et lancer des modèles d’intelligence artificielle (LLM) open source directement sur votre ordinateur. Fini la dépendance au cloud : vous gardez la main sur vos données et votre puissance de calcul !

Ollama est en ligne de commande, mais il est possible d’ajouter des outils pour obtenir une interface Web complète et efficace comme Open WebUI (lien le site officiel et le Github). Si vous hésitez sur le choix du logiciel, je vous recommande la lecture du guide pour installer une IA local sur votre ordinateur. Il y a des options plus simples, mais plus limitées, idéal pour découvrir les possibilités et vous familiarisez avec le concept.

Pourquoi choisir Ollama pour installer un LLM local ?

Installer un LLM local avec Ollama n’est pas qu’une question de geek attitude. C’est surtout un vrai choix stratégique pour les développeurs, chercheurs, entreprises ou tout utilisateur souhaitant garder la maîtrise de ses données et de son budget, sans sacrifier la simplicité. Voici les principaux atouts :

Confidentialité et sécurité des données

Avec Ollama, vos données et vos prompts restent sur votre propre machine. C’est la garantie qu’aucune information sensible ne part dans le cloud – un point crucial pour les projets soumis à des exigences de confidentialité, ou les secteurs réglementés (santé, finance, etc.). Cette approche “privacy by design” est saluée par des experts comme Agathon.

Maîtrise des coûts et indépendance vis-à-vis des abonnements

Ollama fonctionne localement : aucun coût à l’usage, pas d’abonnement mensuel ou de facturation à la requête comme sur les API cloud (OpenAI, Gemini…). Après l’installation initiale, l’utilisation est gratuite, ce qui en fait une solution idéale pour les tests, le développement, ou les usages intensifs.

Rapidité, faible latence et fonctionnement hors-ligne

Travailler avec Ollama, c’est bénéficier d’une réactivité quasi-instantanée, puisque tout se passe sur votre machine, sans délai de réseau. Idéal pour les applications en temps réel, mais aussi pour continuer à utiliser l’IA même sans connexion Internet !

Facilité d’utilisation et prise en main rapide

Ollama est pensé pour les débutants comme pour les utilisateurs avancés. Quelques commandes suffisent pour télécharger, lancer ou supprimer un modèle IA. Son interface en ligne de commande (CLI) et son API REST sont réputées pour leur simplicité, comme le souligne Arjun sur Dev.to.

Large choix de modèles IA et personnalisation avancée

Que vous cherchiez un modèle généraliste (Llama, Gemma, Mistral, DeepSeek-R1, Qwen …), un modèle spécialisé (Phi, WizardCoder), ou un modèle multimodal (LLaVA…), Ollama vous donne accès à une vaste bibliothèque. Grâce au système “Modelfile”, vous pouvez aussi personnaliser vos modèles, affiner leur comportement (Fine Tunning) ou même en créer de nouveaux. AlphaBravo propose une analyse détaillée des possibilités offertes. Ollama propose une liste de modèles reconnus et fiables, la liste est donc plus limitée que sur Hugging Face. Toutefois, il est possible d’utiliser les modèles présents sur Hugging Face.

Multi-plateforme et communauté active

Ollama fonctionne sur Windows, macOS et Linux, mais aussi en container Docker pour une intégration facile dans tous les environnements. Les mises à jour sont régulières, portées par une communauté open source très dynamique, comme le constate AlphaBravo ou Cohorte.co. Cette communauté active et les mises à jour régulières sont un très bon indicateur, cela vous assure que l’outil est là pour durer.

Optimisé pour le matériel grand public

Contrairement à d’autres solutions parfois très exigeantes, Ollama sait tirer parti du matériel disponible : il fonctionne sur des PC “classiques”, en exploitant CPU et GPU selon la configuration. Cela le rend accessible, même pour ceux qui n’ont pas un serveur professionnel sous la main. Pour une utilisation avancée, une bonne configuration sera nécessaire en particulier votre GPU.

En résumé, choisir Ollama, c’est faire le pari d’une IA locale, privée, économique, rapide et modulable, avec une vraie communauté pour avancer et un accès direct à la nouvelle génération de modèles open source. Un excellent point de départ pour toutes les expérimentations autour de l’IA générative – qu’on soit développeur, créateur, ou simple curieux !

Pré-requis pour l’installation Ollama sur Windows, Mac et Linux

Avant de commencer ce guide Ollama, assurez-vous d’avoir :

- Une connexion internet rapide (les modèles peuvent peser plusieurs gigas)

- Un PC, un Mac ou un ordinateur sous Linux avec quelques gigas d’espace libre

- Un minimum de curiosité et l’envie de découvrir l’IA locale !

Certains modèles LLM nécessitent beaucoup de VRAM et de mémoire vive (RAM). Si vous souhaitez utiliser de gros modèles, vérifiez la compatibilité avec votre matériel.

Installation Ollama sur Windows

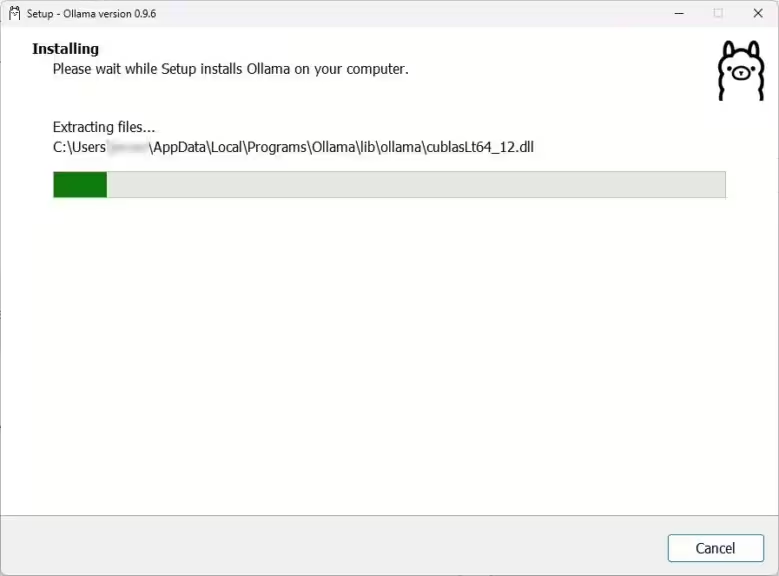

Télécharger Ollama pour Windows

- Rendez-vous sur le site officiel https://ollama.com/download pour télécharger la version Windows.

- Lancez le fichier .exe une fois le téléchargement terminé et cliquez sur « Installer »

- Suivez les instructions à l’écran pour installer Ollama. L’installation est rapide et ne nécessite pas de compétences particulières.

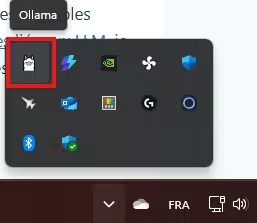

Après l’installation, Ollama se lance en arrière-plan. Vous pouvez vérifier sa présence dans la barre des tâches (icône cachée dans la zone de notifications).

Ollama s’ajoute automatiquement au démarrage de Windows. Si vous ne souhaitez pas qu’il se lance à chaque démarrage, ouvrez le Gestionnaire des tâches (Ctrl+Shift+Échap), allez dans l’onglet “Démarrage”, faites un clic droit sur “Ollama” et choisissez “Désactiver”.

Vou pouvez maintenant passer directement à la section « Premiers pas avec Ollama », plus bas sur cette page.

Configuration du dossier des modèles (optionnel mais conseillé)

Vous pouvez spécifier où seront stockés les modèles téléchargés (pratique si votre disque principal est limité) et si vous souhaitez utiliser les modèles avec d’autres logiciels ou solutions. Cela évite de dupliquer ces fichiers volumineux :

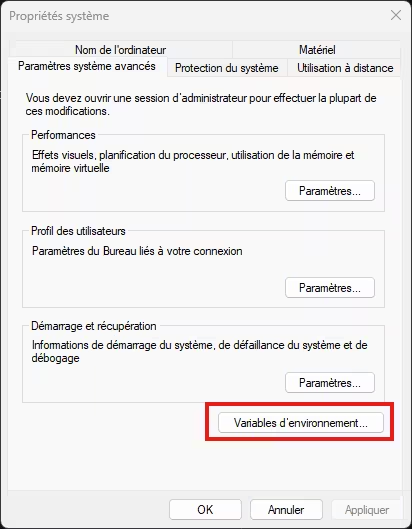

- Tapez “ENV” dans la barre de recherche Windows

- Cliquez sur “Modifier les variables d’environnement système”

- Puis « Variables d’environnement »

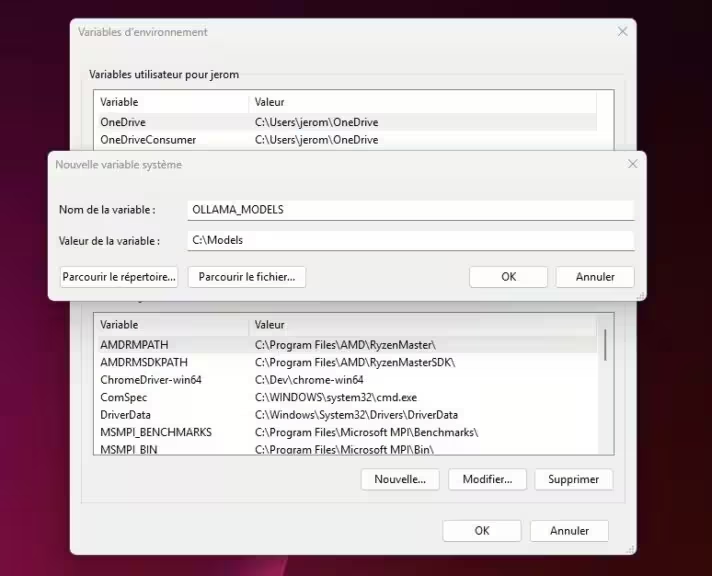

- Ajoutez une nouvelle variable utilisateur :

- Nom de la variable : OLLAMA_MODELS

- Valeur : chemin du dossier de stockage (ex : C:Models ou D:Models)

- Validez et redémarrez Ollama pour que la variable d’environnement soit prise en compte

Installation Ollama sur Mac

Télécharger et installer Ollama pour macOS

- Allez sur la page Ollama download et téléchargez la version Mac.

- Décompressez l’archive téléchargée, puis faites glisser le dossier “Ollama.app” dans le dossier Applications.

- Lancez Ollama comme n’importe quelle autre application Mac.

Si l’application est bloquée par la sécurité macOS, faites un clic droit sur “Ollama.app” > “Ouvrir”, puis confirmez l’ouverture. Plus d’infos sur le support Apple.

Gérer le stockage des modèles sur Mac

Pour spécifier le dossier de stockage des modèles sur Mac, vous devrez passer par le Terminal et les variables d’environnement. Pour les utilisateurs avancés, créez une variable d’environnement OLLAMA_MODELS dans votre fichier ~/.zshrc ou ~/.bash_profile selon le shell utilisé.

Installation Ollama sur Linux

Installer Ollama sur Ubuntu, Debian, Fedora…

- Ouvrez un terminal et copiez la commande officielle :

curl -fsSL https://ollama.com/install.sh | sh - Laissez le script s’exécuter. Il installe Ollama et toutes ses dépendances.

- Lancez le serveur Ollama avec la commande :

ollama serve

Selon la distribution, il peut être nécessaire d’installer des dépendances additionnelles (par exemple, curl, git ou des bibliothèques spécifiques). Si une erreur apparaît, consultez la documentation officielle d’Ollama ou la communauté GitHub.

Premiers pas avec Ollama – Vérification de l’installation et commandes de base

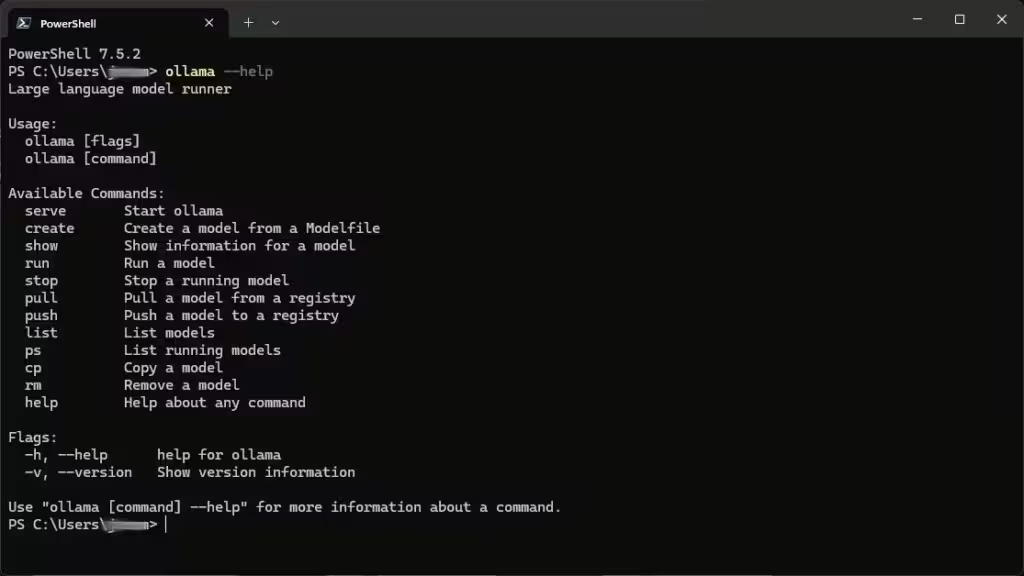

Peu importe votre OS, ouvrez un terminal ou une invite de commandes et tapez :

ollama --helpVous verrez la liste des commandes disponibles :

- ollama serve : démarre le serveur Ollama

- ollama list : liste les modèles téléchargés

- ollama run <nom_du_modèle> : télécharge et lance un modèle IA

- ollama pull <nom_du_modèle> : télécharge uniquement un modèle sans le lancer

- ollama rm <nom_du_modèle> : supprime un modèle de votre machine

Utiliser simplement Ollama

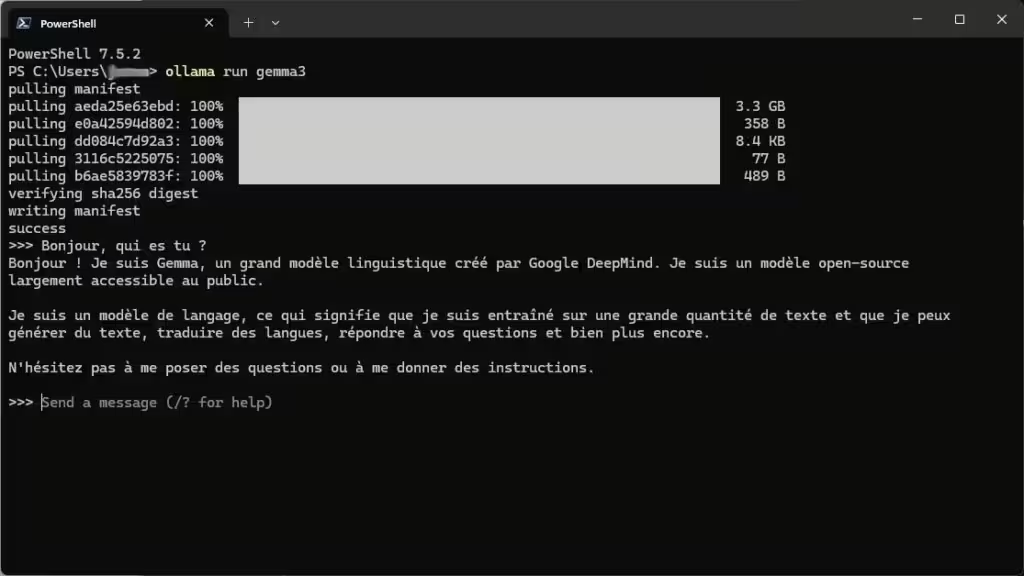

Pour lancer rapidement un modèle IA local, par exemple “gemma3”, tapez simplement :

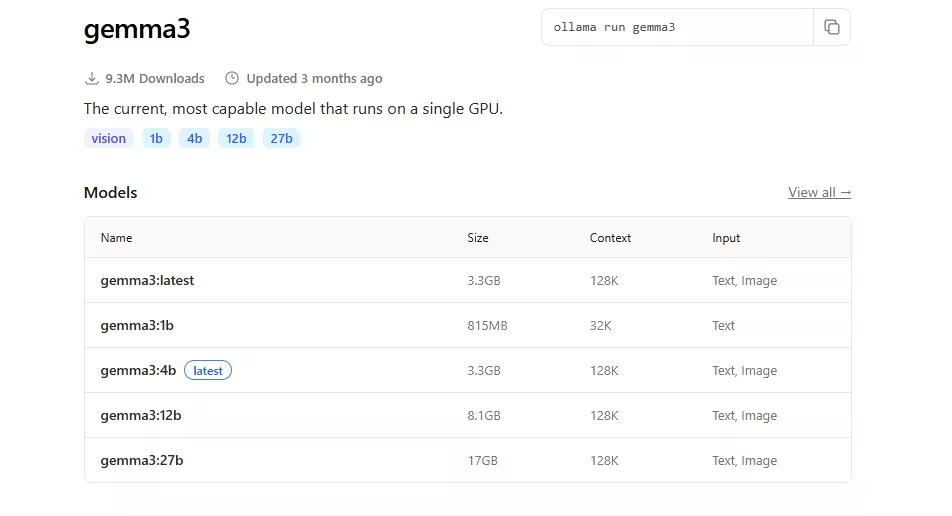

ollama run gemma3Le modèle sera automatiquement téléchargé puis exécuté. Vous pourrez ensuite lui poser vos questions directement dans le terminal. Pour quitter la conversation, appuyez sur « CTRL + d ». A noter, si vous ne spécifiez pas le nombre de paramètres du modèle, Ollama téléchargera le modèle indiqué comme « lastest ». Dans notre cas, gemma3:4b.

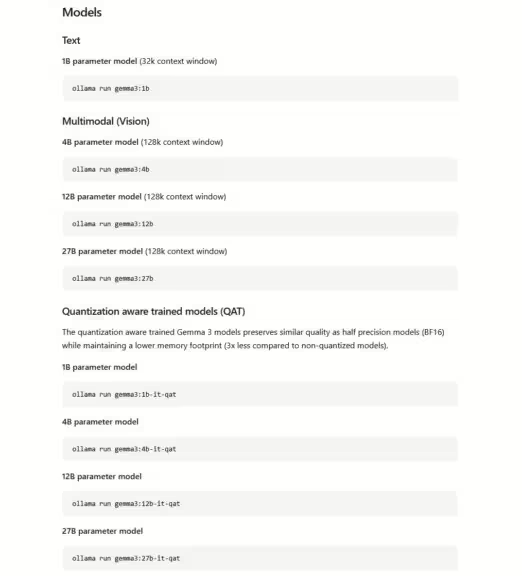

Pour spécifier un modèle avec un nombre de paramètres spécifique, consulter la liste des modèles sur le site d’Ollama.

Choisissez le modèle qui vous convient, naviguez sur la fiche du modèle, vous trouverez alors toutes les informations pour installer une autre version avec le nombre de paramètres et les modèles quantifiés qui conviennent à votre configuration.

L’interface en ligne de commande ne conviendra pas à tout le monde, mais il est possible d’ajouter une interface Web, comme Open WebUI très similaires à ChatGPT. Ce qui rendra l’expérience beaucoup plus agréable, personnalisable avec des possibilités d’intégration nombreuses et variées.

L’installation de Open WebUI est très simple, suivez ce guide rapide pour profiter d’une meilleure expérience et exploiter le plein potentiel de votre LLM en local.

Ces derniers points font que des solutions comme Ollama avec Open WebUI offrent un véritable intérêt même face aux mastodontes de l’IA.

FAQ Installation Ollama et dépannage rapide

Vérifiez que votre antivirus ne bloque pas l’exécutable.

Sur Windows, essayez de lancer Ollama en mode administrateur.

Consultez la bibliothèque Ollama officielle ou parcourez les modèles proposés dans la commande ollama list.

Utilisez la commande : ollama rm u003cnom_du_modèleu003e

Oui, sur Windows 11, Ollama se met à jour automatiquement :

Dès qu’une nouvelle version est disponible, Ollama la télécharge en arrière‑plan, sans intervention de votre part.

Une notification apparaît dans la zone de notifications (en bas à droite). Il suffit alors de cliquer sur l’icône Ollama et de sélectionner “Restart to update” (redémarrer pour appliquer la mise à jour)

Conseils pour aller plus loin avec Ollama et l’IA locale

- Essayez différents modèles selon vos usages (chat, rédaction, analyse d’image, génération de code…)

- Intégrez Ollama dans des outils comme ComfyUI pour enrichir vos workflows IA créatifs

- Rejoignez la communauté Reddit r/Ollama pour des astuces et des exemples de workflow

- Installez Open WebUI pour une interface Web avec de nombreuses options (dont l’intégration d’un générateur d’image, par exemple ComfyUI)

- Identifier le bon modèle qui correspond à votre configuration matériel est un point essentiel. Si le modèle est trop lent, son utilisation sera moins pertinente. Consultez le guide pour savoir comme choisir un LLM en fonction de votre GPU.

- Une fois le ou les bons modèles identifiés, ajuster les paramètres pour les optimiser. Effectuez des recherches sur internet pour savoir comment optimiser efficacement un modèle. Par exemple avec un peu d’optimisation, Llama 4 Scout quantifié tourne bien sur une RTX 5090 (10 tokens/s), alors que le modèle en Q3 fait 48 Go.

- Utilisez le Fine Tunning pour personnaliser et le RAG

Conclusion – Installation Ollama, un jeu d’enfant pour débuter avec un LLM local

Installer Ollama sur Windows, Mac ou Linux, c’est à la portée de tout le monde, même sans être un expert ! Ce guide Ollama montre que, pour débuter avec un LLM local, il suffit de quelques clics et d’un peu de curiosité. L’IA open source n’a jamais été aussi accessible. Lancez-vous, expérimentez, et profitez des possibilités infinies offertes par les modèles génératifs !

Pour aller plus loin, consultez le guide officiel sur le site d’Ollama ou consulter notre page dédiée à l’IA, il y a de nombreux guides sur l’execution en local.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !