Installer Open WebUI dans un conteneur Docker sur Windows 11 : guide complet et conseils pratiques

Vous cherchez à installer Open WebUI sur Windows 11 pour profiter d’une interface moderne et puissante avec vos modèles LLM, sans prise de tête ? Bonne nouvelle : la méthode la plus fiable et accessible, c’est l’installation via un conteneur Docker. Ce tutoriel vous guide pas à pas, même si vous êtes débutant, et partage des astuces pour éviter les pièges fréquents. On abordera aussi les points clés à vérifier et les bonnes pratiques pour une installation sans stress.

Pourquoi installer Open WebUI via Docker sur Windows 11 ?

Avant d’entrer dans le vif du sujet, rappelons que de nombreuses méthodes existent pour installer Open WebUI : via pip/Python, conda, installation manuelle depuis le code source… Mais l’installation avec Docker présente des avantages imbattables pour la grande majorité des utilisateurs, débutants comme avancés :

- Simplicité : pas de galère avec les dépendances ou les versions de Python, tout est contenu et isolé.

- Facilité de maintenance : la mise à jour ou la suppression se fait en une commande.

- Sécurité et stabilité : votre système principal reste propre, tout tourne dans une “bulle”.

- Performance : Open WebUI tourne très bien sous Docker, il n’a pas besoin d’un accès optimisé au GPU. Ce n’est qu’une interface, en revanche Ollama, vLLM ou plus globalement les moteurs de LLM ont besoin d’une optimisation poussée avec le GPU.

D’ailleurs, la documentation officielle Open WebUI (docs.openwebui.com) et les retours d’utilisateurs sur Reddit (reddit.com) plébiscitent cette méthode.

Prérequis avant d’installer Open WebUI dans Docker sur Windows 11

Avant de commencer l’installation d’Open WebUI dans un conteneur Docker, assurez-vous d’avoir :

- Ollama installé sur Windows 11 (le moteur LLM qui exécute les modèles), déjà fonctionnel.

- Docker Desktop installé et configuré sur votre machine (télécharger ici).

- Un accès administrateur sur votre ordinateur (obligatoire pour certaines opérations réseau).

À noter : Open WebUI n’exécute pas les modèles LLM : il sert simplement d’interface web. C’est Ollama qui gère la puissance GPU et l’inférence des modèles. Vous pouvez donc installer Open WebUI dans Docker sans craindre de limiter vos performances IA et il n’est pas nécessaire non plus d’activer les optimisations GPU sur le conteneur.

Étape 1 – Vérifier que Ollama fonctionne bien sur Windows 11

Avant de passer à Docker, assurez-vous que Ollama est lancé et tourne bien sur votre PC :

- Ouvrez le terminal Windows (cmd ou PowerShell).

- Tapez :

ollama listSi la commande répond sans erreur, Ollama est opérationnel sur http://localhost:11434.

Si Ollama ne répond pas, il faut régler le souci avant d’installer Open WebUI.

Étape 2 – Installer et lancer Docker Desktop

Si ce n’est pas déjà fait, installez Docker Desktop pour Windows.

Après installation :

- Lancez Docker Desktop (une icône doit apparaître en bas à droite de l’écran).

- Patientez jusqu’à ce que Docker affiche “Docker Desktop is running”.

- Point d’attention : Docker Desktop nécessite l’activation de la virtualisation dans le BIOS et idéalement WSL2. Suivez les instructions affichées en cas de problème de démarrage.

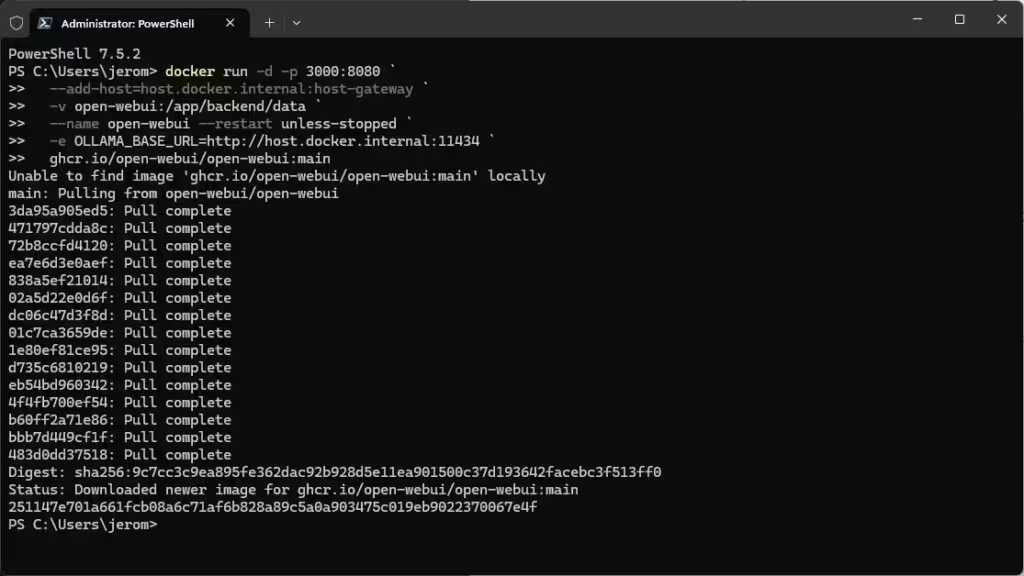

Étape 3 – Lancer Open WebUI dans un conteneur Docker

C’est ici que la magie opère. Ouvrez PowerShell ou un terminal, idéalement en mode administrateur, et copiez la commande suivante :

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainExplications des options :

- -p 3000:8080 : l’interface sera accessible sur http://localhost:3000

- –add-host=host.docker.internal:host-gateway : donne à Docker l’accès au Ollama tournant sur Windows

- -v open-webui:/app/backend/data : sauvegarde des données utilisateurs

- -e OLLAMA_BASE_URL=http://host.docker.internal:11434 : configure Open WebUI pour communiquer avec Ollama natif

- –restart unless-stopped : redémarre le conteneur automatiquement en cas de redémarrage du PC

Lorsque vous lancez la commande, Docker se charge de télécharger les éléments nécessaires (Open WebUI et les packages nécessaires à son fonctionnement) :

👉 Pour plus de détails, voir la doc officielle Open WebUI.

Si le port 3000 est déjà utilisé, modifiez-le (-p 3100:8080 par exemple).

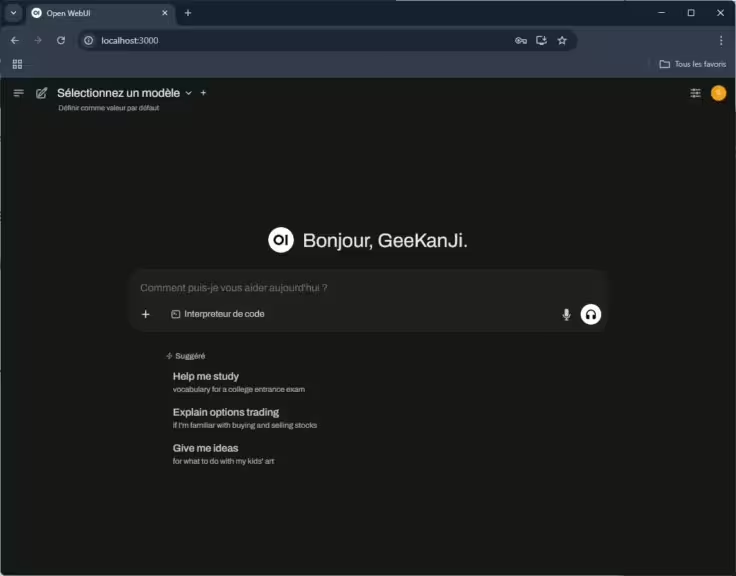

Étape 4 – Accéder à l’interface Open WebUI

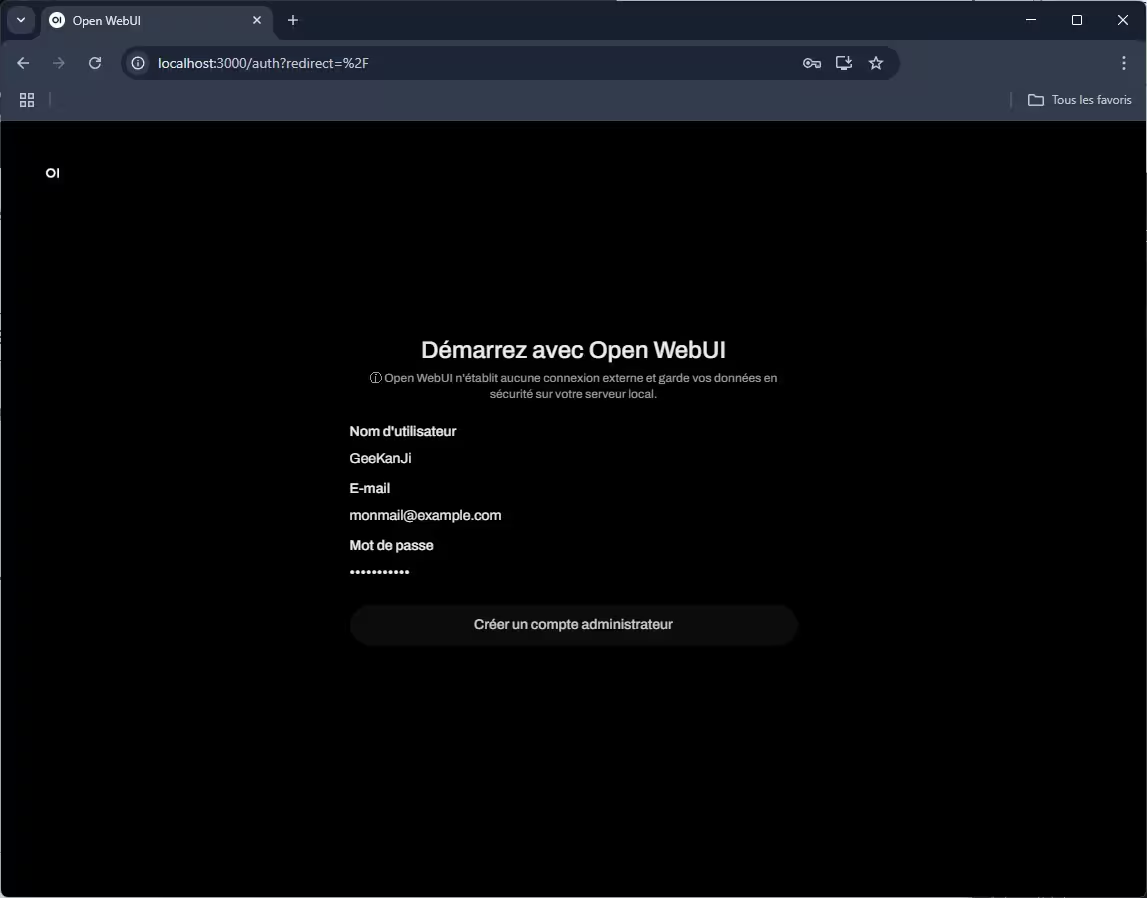

- Lancez votre navigateur préféré et allez à l’adresse http://localhost:3000

- Lors de la première connexion, créez votre compte admin. Un compte est obligatoire, mais il n’est que local, les informations ne sont pas communiqué à un serveur distant. Open WebUI peut être utilisé par plusieurs personnes sur votre réseau local (ou même à l’extérieur avec la configuration adhoc), c’est ce qui justifie la création d’un compte Administrateur.

- Open WebUI détectera automatiquement Ollama via l’adresse configurée. Si ce n’est pas le cas, allez dans les paramètres et corrigez l’URL du backend.

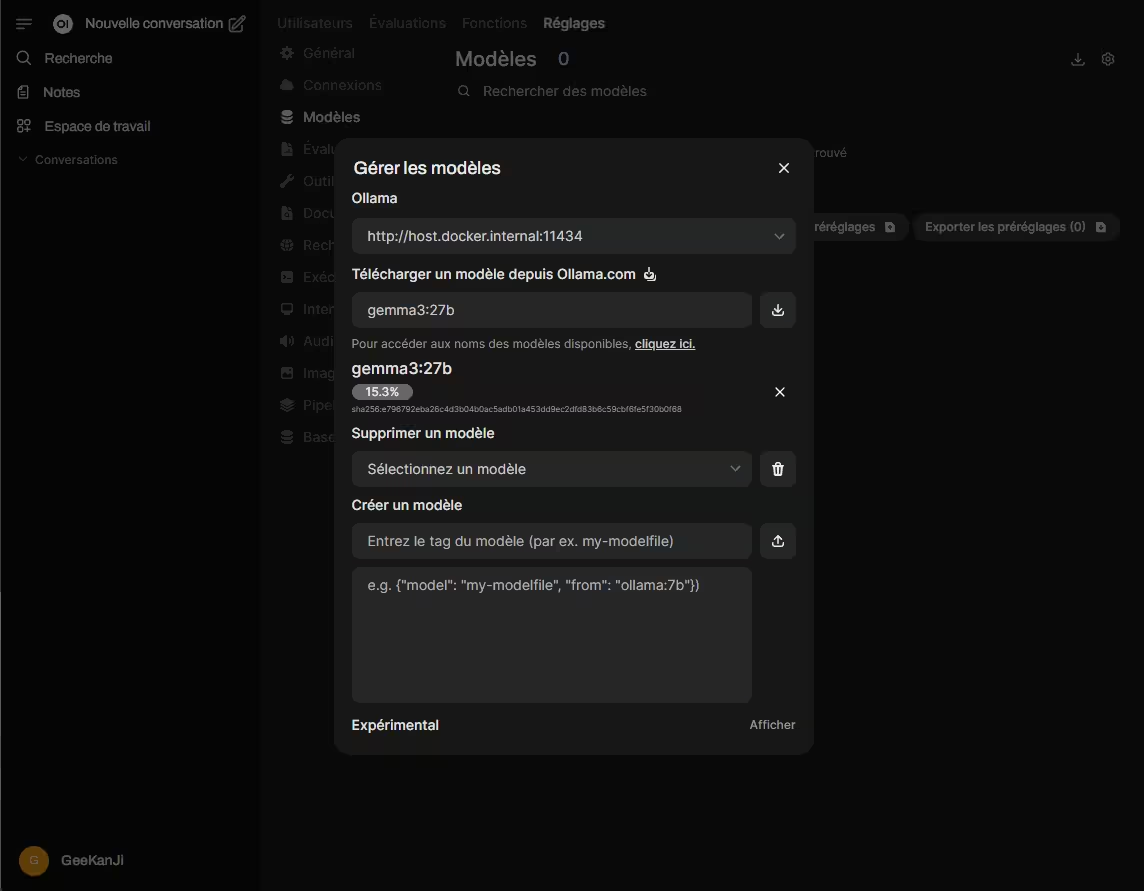

Étape 5 – Testez votre installation Open WebUI + Ollama

Si vous n’avez pas installé de modèles avec Ollama, il est possible de la faire directement avec Open WebUI en utilisant cette URL : http://localhost:3000/admin/settings/models (si vous avez choisir le port 3000 par défaut). Accédez à la liste des modèles disponibles sur le site d’Ollama avec ce lien, choisissez un modèle, ouvrez la fiche du modèle et vous aurez la référence à indiquer par exemple : deepseek-r1:32b ou encore gemma3:27b

Je vous recommande la lecture rapide de cette page pour savoir comment choisir vos modèles LLM en fonction de votre configuration.

Dans l’interface de discussion d’Open WebUI :

- Choisissez un modèle Ollama (Llama, Gemma, Phi, etc.)

- Tapez une requête de test

- Vérifiez que la réponse arrive sans erreur

Si ça coince :

- Vérifiez que Ollama tourne toujours (ollama list)

- Assurez-vous que le pare-feu Windows ne bloque pas la communication entre Docker et Ollama

- Consultez la FAQ Open WebUI en cas d’erreur persistante

Si vous avez plusieurs interfaces réseau, ou si vous utilisez un VPN, il peut y avoir des soucis de routage à corriger.

Alternative : installer via un docker compose

Personnellement, l’usage d’un fichier docker-compose.yml me parait plus pratique, même pour un simple conteneur. Plus facile à maintenir, changer les paramètres et également pour mettre à jour l’image avec un simple « docker compose pull ». Enfin, si j’ai besoin de le faire communiquer avec un autre conteneur, je peux l’ajouter plus facilement sur le même réseau. bref… c’est une histoire de préférence.

L’installation avec un docker-compose.yml en bref :

- Placer vous dans le repertoire pour vos projets (par exemple /srv )

- Créer un répertoire : mkdir open-webui puis cd open-webui

- Créer le fichier docker-compose.yml vide : touch docker-compose.yml

- A l’aide de l’explorateur de Windows ou via Visual Studio Code, éditer le fichier comme ceci :

services:

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

restart: always

ports:

- "3000:8080"

extra_hosts:

- "host.docker.internal:host-gateway"

volumes:

- open-webui:/app/backend/data- Enfin lancer le service

docker compose up -dAstuces et conseils pratiques

- Mettre à jour Open WebUI : dans le menu « Réglages », puis « à propos », cliquez sur le bouton « Vérifier les mises à jour disponibles ».

- Données persistantes : vos historiques, paramètres et comptes sont sauvegardés dans le volume Docker, même après une mise à jour.

- Changer le port d’accès : modifiez l’option -p si nécessaire.

- Utiliser un autre backend IA : il est possible de connecter Open WebUI à d’autres moteurs compatibles.

Limites et autres méthodes à explorer

Même si cette méthode avec Docker est la plus simple et la plus recommandée, sachez qu’il existe d’autres moyens d’installer Open WebUI sur Windows 11 :

- Installation directe via pip et Python 3.11

- Utilisation d’environnements virtuels Conda/uvx

- Compilation depuis les sources GitHub (pour développeurs avancés)

- Service Windows via NSSM (pour lancer Open WebUI au démarrage)

Pour en savoir plus, consultez le guide d’installation Open WebUI sans Docker.

Conclusion

Installer Open WebUI dans un conteneur Docker sur Windows 11, c’est la solution idéale pour bénéficier rapidement d’une interface moderne pour vos modèles IA, tout en évitant la complexité technique et les risques d’incompatiblité. La méthode présentée ici est adaptée aussi bien aux débutants qu’aux utilisateurs avancés : une configuration fiable, modulaire et facile à maintenir.

Besoin d’aide ou envie d’explorer des usages plus poussés ? Les forums Open WebUI et la documentation officielle sont d’excellentes ressources pour aller plus loin.

FAQ Open WebUI + Docker sur Windows 11

C’est une interface web moderne pour interagir avec des LLM (Large Language Models) via Ollama (ou autres backends compatibles). Il ne fait tourner aucun modèle lui-même.

Docker permet d’éviter les galères de dépendances, d’avoir un environnement propre, et de séparer Open WebUI du reste du système.

→ Voir les avantages dans la doc officielle.

Non : Ollama peut rester natif, Open WebUI s’y connectera en réseau local. C’est la solution la plus simple sur Windows.

Non, seul Ollama a besoin d’un GPU si tu utilises des modèles qui le supportent.

Dans l’interface d’Open WebUI, Réglages/A propos/Vérifier les mises à jour disponible.

Autrement : docker stop open-webui docker rm open-webui docker pull ghcr.io/open-webui/open-webui:main

Puis relancer la commande d’installation initiale.

Tout est dans le volume Docker open-webui:/app/backend/data (par défaut).

Astuce : tu peux faire une sauvegarde avec :docker run u002du002drm -v open-webui:/data -v ${PWD}:/backup busybox tar cvf /backup/open-webui-backup.tar /data

Docker Desktop n’est pas lancé

Le pare-feu Windows bloque le port

Port déjà utilisé (modifie-le avec -p 3100:8080 par exemple)

Change la variable d’environnement OLLAMA_BASE_URL lors du lancement du conteneur Docker.

Exemple :-e OLLAMA_BASE_URL=http://ip_autre_backend:port

Script automatisé d’installation Open WebUI + Docker sur Windows 11

Voici un script PowerShell à copier-coller pour tout automatiser :

# 1. Vérifier que Docker Desktop est lancé

Start-Process "Docker Desktop" -ErrorAction SilentlyContinue

Start-Sleep -Seconds 10

# 2. Lancer le conteneur Open WebUI

docker run -d -p 3000:8080 `

--add-host=host.docker.internal:host-gateway `

-v open-webui:/app/backend/data `

--name open-webui --restart unless-stopped `

-e OLLAMA_BASE_URL=http://host.docker.internal:11434 `

ghcr.io/open-webui/open-webui:main

Write-Host "Open WebUI installé ! Accédez à http://localhost:3000"

Il est recommandé d’exécuter ce script en tant qu’administrateur.

Comparatif des principales méthodes d’installation Open WebUI sur Windows 11

| Méthode | Simplicité | Isolation | Maintenance | Pour qui ? |

|---|---|---|---|---|

| Docker | ★★★★★ | ★★★★★ | ★★★★★ | 95% des utilisateurs |

| pip/Python | ★★★★☆ | ★★☆☆☆ | ★★☆☆☆ | Développeurs Python |

| Conda/uvx | ★★★☆☆ | ★★★☆☆ | ★★★☆☆ | Data scientists |

| GitHub/Dev (from source) | ★★☆☆☆ | ★★★★★ | ★☆☆☆☆ | Utilisateurs avancés |

| Service Windows (nssm) | ★★★☆☆ | ★★★★☆ | ★★★★☆ | Pour démarrage auto |

- Docker : isolé, fiable, facile à mettre à jour, peu d’entretien.

- pip/Python : rapide, mais dépendances et conflits possibles.

- Conda/uvx : idéal si vous avez déjà un workflow Python/Conda.

- GitHub (source) : pour customisation avancée, plus complexe.

- Service Windows (nssm) : idéal pour intégration profonde à Windows, mais plus technique.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !