Meilleures IA génératives en mars 2025 : vers une croissance exponentielle des coûts ?

L’intelligence artificielle générative connaît une évolution fulgurante en 2025, avec des modèles toujours plus performants et spécialisés. Cependant, cette montée en puissance s’accompagne d’une hausse exponentielle des coûts, rendant ces technologies moins accessibles pour certains utilisateurs.

Quels sont aujourd’hui les meilleurs modèles IA génératives en termes de performances et de rentabilité ? Quels sont les modèles les plus économiques pour un usage professionnel ou personnel ? Découvrez notre classement actualisé des IA génératives en mars 2025, ainsi que les tendances qui redéfinissent ce marché.

Classement des IA par intelligence (mars 2025)

Voici un comparatif basé sur l’index d’intelligence des principaux modèles IA, où un score plus élevé indique une meilleure capacité de compréhension, de génération de texte et de raisonnement.

A noter, ChatGPT 4.5 (Preview) n’est pas indiqué dans la tableau. Les tests sur le dernier modèle de ChatGPT sont en cours. Toutefois, nous savons déjà qu’il est supérieur à o3-mini.

| Modèle | Index d’intelligence |

|---|---|

| o3-mini (high) | 66 |

| o1 | 62 |

| DeepSeek R1 | 60 |

| Gemini 2.0 Pro Experimental | 49 |

| Claude 3.7 Sonnet | 48 |

| Gemini 2.0 Flash | 48 |

| GPT-4o (Nov 24) | 41 |

| Llama 3-708B | 41 |

| Mistral Large 2 (Nov 24) | 38 |

| Nova Pro | 37 |

| GPT-4o mini | 36 |

| Claude 3.5 Haiku | 35 |

Source : Artificial Analysis

💡 Analyse :

Les modèles propriétaires comme o3-mini (high), o1 et DeepSeek R1 dominent en termes de performance. Gemini 2.0 Pro Experimental et Claude 3.7 Sonnet s’imposent également dans la course à l’intelligence générative.

Toutefois, ces modèles avancés affichent des coûts d’utilisation très variés, influencés par des facteurs tels que l’infrastructure de calcul, la consommation énergétique et l’optimisation logicielle.

Classement des IA par coût d’utilisation (mars 2025)

L’un des défis majeurs de l’intelligence artificielle réside dans son coût d’accès, notamment pour les API et services cloud. Voici le prix par million de tokens traités pour chaque modèle :

| Modèle | Prix (USD par 1M Tokens) |

|---|---|

| GPT-4.5 (Preview) | 93.8 |

| o1 | 26.3 |

| Claude 3.7 Sonnet | 6.0 |

| GPT-4o (Nov 24) | 4.4 |

| Mistral Large 2 (Nov 24) | 3.0 |

| o3-mini (high) | 1.9 |

| Claude 3.5 Haiku | 1.6 |

| Nova Pro | 1.4 |

| DeepSeek R1 | 1.0 |

| Llama 3-708B | 0.6 |

| GPT-4o mini | 0.3 |

| Gemini 2.0 Flash | 0.2 |

💡 Analyse :

L’IA générative ultra-performante s’accompagne d’un coût d’exploitation élevé. GPT-4.5 (Preview) et o1 sont les plus chers, ce qui les rend moins accessible. En revanche, des alternatives comme DeepSeek R1, Mistral, Llama 3-708B et Gemini 2.0 Flash offrent un excellent rapport qualité/prix, avec des tarifs attractifs.

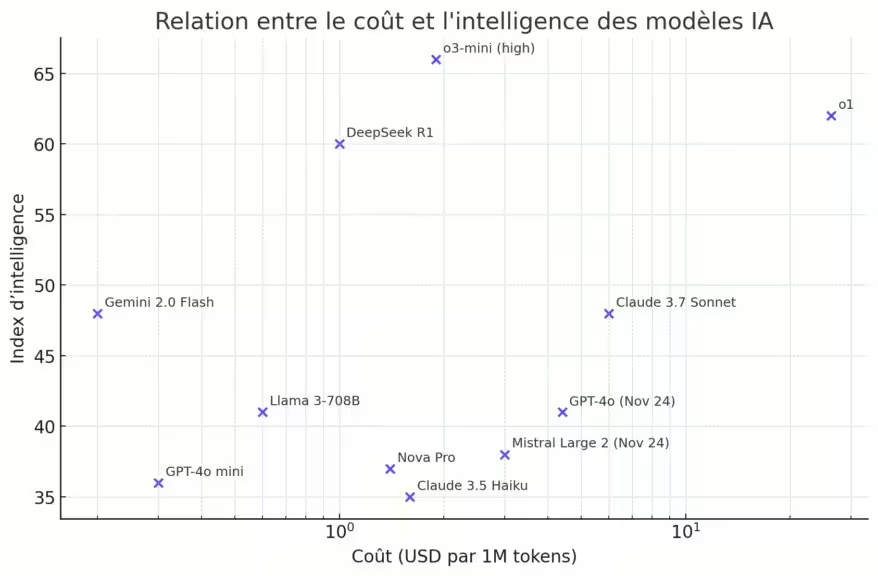

Les meilleures IA en terme de relation coût et intelligence

Voici le nuage de points montrant la relation entre le coût (USD par million de tokens) et l’index d’intelligence des modèles IA. Les modèles les plus intéressants sont ceux situés en haut à gauche, c’est-à-dire offrant une intelligence élevée à un coût faible. DeepSeek R1, Gemini 2.0 Flash et Llama 3-708B semblent être parmi les meilleurs choix en termes de rapport coût/intelligence. A noter o3-mini high reste une bonne option intéressante.

Comme indiqué précédemment, il y a pas suffisamment de données sur ChatGPT 4.5 (Preview) pour évaluer son index d’intelligence. De plus aujourd’hui, son coût est élevé, mais OpenAI travaille sur l’amélioration de son modèle. Son coût et également son efficacité seront donc amélioré avec le temps, comme les autres modèles lors de leur lancement.

Une inflation des coûts due à des besoins exponentiels

L’intelligence artificielle avancée nécessite une infrastructure toujours plus puissante. Pourquoi les coûts explosent-ils en 2025 ?

- Complexification des architectures : Plus un modèle possède de paramètres, plus il est précis, mais plus il demande de puissance de calcul.

- Consommation énergétique accrue : L’entraînement et l’inférence des modèles s’effectuent sur des GPU de dernière génération comme les Nvidia H100 et les futurs B200, augmentant les dépenses en électricité.

- Exigences matérielles plus élevées : Les modèles IA de nouvelle génération nécessitent des quantités de mémoire et de stockage massives, notamment pour gérer des contextes plus grands.

📈 Corrélation coût-performance : linéaire ou exponentielle ?

Contrairement à ce que l’on pourrait penser, les coûts ne progressent pas de manière linéaire avec la performance. Une légère amélioration des capacités demande des ressources disproportionnées. Par exemple, GPT-4.5 coûte plus du triple de GPT-4o, alors que l’amélioration de la qualité de génération est modeste. A noter, le coût de GPT-4.5 devrait diminuer, il s’agit d’une première version (Preview).

Open source vs. modèles propriétaires : quel avenir ?

L’écart se creuse entre les IA ultra-premium (GPT-4.5, Claude 3.7) et les solutions open source optimisées comme DeepSeek R1, Llama 3 et Mistral.

🟢 Avantages des modèles open source :

- Coût réduit : Ils peuvent être déployés localement sans dépendance aux API et infrastructures coûteuses.

- Flexibilité : Possibilité d’entraîner des versions adaptées à des besoins spécifiques.

- Confidentialité accrue : Aucune donnée utilisateur envoyée sur le cloud.

🔴 Limites par rapport aux modèles propriétaires :

- Moins optimisés : Les performances restent en deçà des géants comme GPT-4.5, Claude 3.7 ou Gemini Ultra.

- Support limité : Pas de garantie de maintenance ou de mise à jour régulière.

Stratégies pour réduire les coûts d’utilisation de l’IA

Face à ces enjeux, plusieurs solutions émergent pour rendre l’IA plus accessible :

- Quantification et compression des modèles : OpenAI et Google optimisent leurs modèles pour réduire la consommation de mémoire et améliorer l’efficacité.

- Utilisation des NPU (Neural Processing Units) : Microsoft pousse l’exécution locale sur les PC Copilot+. Une tendance qui pourrait se généraliser, comme nous l’expliquons sur notre guide pour installer une IA en local et notre article sur « L’exécution d’IA en local : une tendance en forte croissance«

- Hybridation cloud + local : Certaines entreprises combinent serveurs distants et exécution locale pour limiter les coûts.

💡 Vers une IA plus démocratique ?

L’avenir de l’IA générative dépendra de sa capacité à offrir un bon compromis entre coût et performance. Si les modèles ultra-premium restent réservés aux grandes entreprises, les alternatives open source et hybrides pourraient séduire un public plus large.

Conclusion : Quel modèle choisir en 2025 ?

- 🎯 Vous privilégiez la performance ? Optez pour Claude 3.7 ou GPT-4.5, mais préparez-vous à payer un prix élevé.

- 💰 Vous recherchez un bon rapport qualité/prix ? DeepSeek R1 et Llama 3-708B offrent une puissance satisfaisante pour un coût réduit.

- 🛠 Vous préférez une IA locale et indépendante ? Les modèles open source comme Mistral, DeepSeek R1 ou Qwen sont une alternative viable.

👉 Et vous, quel modèle d’IA utilisez-vous en 2025 ? Partagez votre avis en commentaire ! 💬

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !