Les meilleures pratiques pour gérer une bibliothèque de prompts IA

Construire une bibliothèque de prompts IA, c’est un peu comme aménager une cave à vin : sans organisation rigoureuse, vous finissez par perdre vos meilleures bouteilles au fond d’un carton poussiéreux. Que vous soyez freelance jonglant avec ChatGPT au quotidien ou membre d’une équipe qui déploie des workflows d’intelligence artificielle à grande échelle, la gestion de vos templates de prompts devient vite un enjeu stratégique. Pour une vue d’ensemble, consultez notre page principale : Organiser ses prompts IA : guide complet des solutions en 2025.

Au fil des semaines, votre collection de prompts s’étoffe : instructions pour la génération de contenu, templates d’extraction de données, scripts de classification… Sans méthode claire, cette richesse se transforme en casse-tête. Vous perdez du temps à retrouver le bon prompt, vous dupliquez sans le savoir des instructions existantes, et pire encore, vous ne savez plus quelle version fonctionnait le mieux.

Dans cet article, nous allons décortiquer les bonnes pratiques reconnues pour organiser, documenter et maintenir une bibliothèque de prompts IA performante. Que vous travailliez en solo ou en équipe, ces méthodes éprouvées vous permettront de capitaliser sur vos efforts et d’améliorer votre productivité au quotidien.

Structurer sa bibliothèque de prompts avec méthode

Créer une architecture logique par dossiers et catégories

La première étape pour gérer efficacement votre bibliothèque de prompts consiste à établir une structure de classement cohérente. Plutôt que d’entasser tous vos templates pêle-mêle dans un unique fichier, organisez-les par dossiers thématiques basés sur leur usage principal.

Voici une architecture type qui fait ses preuves :

/prompts

├── /generation-contenu

│ ├── documentation

│ ├── articles-blog

│ ├── descriptions-produits

│ └── emails-marketing

├── /extraction-donnees

│ ├── analyse-sentiments

│ └── extraction-entites

├── /classification

│ ├── tri-emails

│ └── categorisation-feedback

└── /conversation

├── support-client

└── assistant-personnel

Cette approche par catégorisation fonctionnelle permet de retrouver instantanément le type de prompt recherché. Cette structuration par usage constitue la fondation d’une gestion efficace des templates d’IA.

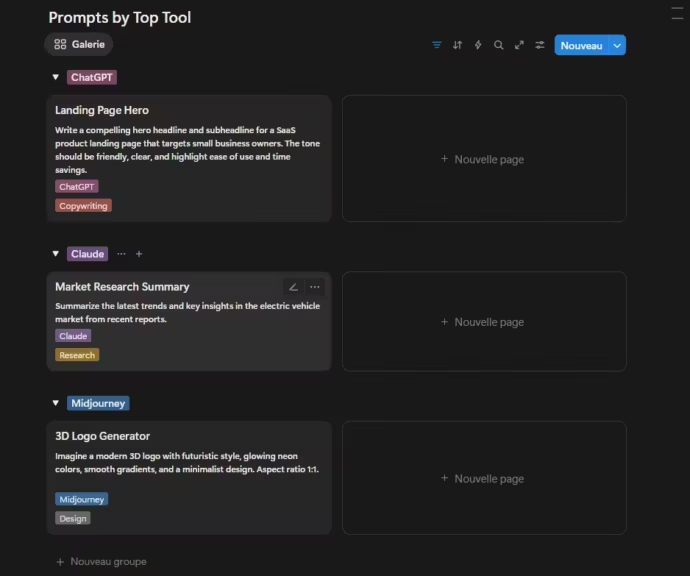

Adopter un système de tags intelligent

Au-delà des dossiers, les tags ou étiquettes ajoutent une couche de flexibilité indispensable. Un même prompt peut servir plusieurs contextes : un template de génération d’article peut être pertinent à la fois pour le marketing et la documentation technique.

Privilégiez un système de tags multi-dimensionnels :

- Par thématique : marketing, tech, finance, santé…

- Par complexité : débutant, intermédiaire, avancé

- Par modèle cible : GPT-4, Claude, Gemini, modèles open source

- Par langue : français, anglais, multilingue

- Par output attendu : court, long, structuré, créatif

Cette taxonomie enrichie transforme votre bibliothèque en véritable base de connaissance consultable selon plusieurs axes.

Établir une nomenclature standard et cohérente

Rien de plus frustrant que de chercher un prompt nommé « prompt-marketing-final-v3-vraiment-final ». Pour éviter l’anarchie dans votre bibliothèque de prompts IA, définissez dès le départ une convention de nommage claire.

Format recommandé : [type]-[contexte]-[fonction]-v[version]

Exemples concrets :

- generation-blog-article-seo-v2

- extraction-feedback-client-sentiments-v1

- classification-emails-urgence-v3

Cette nomenclature standardisée facilite non seulement le repérage visuel mais aussi les recherches par mots-clés. Selon les experts de Langfuse, une convention de nommage rigoureuse devient cruciale dès que votre bibliothèque dépasse la cinquantaine de templates.

Créer des métadonnées descriptives

Pour chaque prompt de votre bibliothèque, documentez les métadonnées essentielles :

- Créateur : qui a développé ce template

- Date de création et date de dernière modification

- Dépendances : modèles IA testés et validés

- Cas d’usage : contexte d’utilisation optimal

- Paramètres requis : variables obligatoires vs optionnelles

- Performance : taux de succès, temps de réponse moyen

Ces informations contextuelles transforment un simple fichier texte en asset documenté et réutilisable par toute l’équipe. C’est une bonne pratique et elle devient très utile avec de large bibliothèque.

Versioning et documentation des prompts IA

Pourquoi le versioning est crucial pour vos templates

Imaginez que vous modifiez un prompt qui fonctionnait parfaitement, et que la nouvelle version produit des résultats décevants. Sans historique, impossible de revenir en arrière proprement. Le versioning des prompts n’est pas un luxe, c’est une nécessité pour toute bibliothèque professionnelle.

Contrairement au code informatique classique, les prompts évoluent de façon itérative et parfois imprévisible. Une simple reformulation peut améliorer radicalement les résultats… ou les dégrader complètement. D’où l’importance de tracer chaque modification et de pouvoir comparer les versions.

Selon Mirascope, le versioning des prompts devrait suivre les mêmes principes que le versioning logiciel, avec quelques adaptations spécifiques au contexte de l’IA générative.

Documenter l’historique des modifications

Pour chaque version d’un prompt dans votre bibliothèque, consignez :

- La date et l’auteur de la modification

- Les changements apportés : qu’est-ce qui a été modifié exactement

- La raison : pourquoi cette modification (amélioration des résultats, adaptation à un nouveau modèle, correction d’erreurs…)

- Les résultats observés : impact mesurable sur la qualité des outputs

Exemple de documentation :

## Version 2.1 - 15 mars 2025

**Auteur** : Marie Dupont

**Modifications** : Ajout d'exemples de format attendu dans l'instruction

**Raison** : Les outputs manquaient de structure cohérente

**Résultats** : +35% de conformité au format demandé

Cette traçabilité complète permet non seulement de revenir en arrière si nécessaire, mais aussi d’apprendre de vos expérimentations. Vous capitalisez ainsi sur chaque itération.

Créer une documentation complète pour chaque prompt

Un prompt sans documentation, c’est comme une recette de cuisine sans liste d’ingrédients : techniquement utilisable, mais galère assurée. Pour chaque template de votre bibliothèque, rédigez une fiche documentaire structurée :

1. Objectif du prompt

- À quoi sert ce template concrètement

- Quel problème résout-il

- Dans quels contextes l’utiliser

2. Paramètres et variables

- Liste des variables à remplacer ({{nom_variable}})

- Paramètres obligatoires vs optionnels

- Format attendu pour chaque paramètre

3. Exemples d’utilisation

- Cas d’usage concrets avec inputs et outputs réels

- Variations possibles du prompt

- Erreurs fréquentes à éviter

4. Modèles testés

- Sur quels modèles d’IA ce prompt a été validé

- Performance comparative entre modèles

- Paramètres recommandés (température, tokens max…)

5. Notes et limitations

- Points d’attention particuliers

- Contextes où le prompt fonctionne moins bien

- Améliorations envisagées

Selon Langfuse, cette documentation exhaustive devient indispensable dès qu’une équipe grandit ou qu’un projet évolue sur plusieurs mois.

Utiliser des outils de versioning adaptés

Pour gérer efficacement le versioning de votre bibliothèque de prompts IA, plusieurs approches s’offrent à vous :

Git et contrôle de version classique Si vous êtes à l’aise avec Git, stockez vos prompts dans un dépôt dédié. Chaque modification devient un commit documenté, vous bénéficiez de branches pour tester des variantes, et l’historique complet reste accessible.

Outils spécialisés Des plateformes comme PromptLayer ou PromptHub intègrent nativement le versioning avec interface graphique. Plus accessible qu’un dépôt Git, ces solutions affichent clairement les différences entre versions.

Solutions hybrides Obsidian avec un plugin Git, ou Notion avec historique des versions offrent un compromis intéressant pour les équipes non techniques.

Notion et Obsidian diffèrent profondément dans leurs fonctions de gestion des versions en raison de leurs philosophies de conception distinctes : Notion met l’accent sur un espace de travail collaboratif basé sur le cloud avec un historique des versions intégré, tandis qu’Obsidian privilégie une gestion locale et centrée sur la confidentialité des notes, avec un versionnement optionnel via la synchronisation Cloud et des plugins.

Collaboration et validation des prompts en équipe

Centraliser vos templates sur un outil partagé

Dès que vous travaillez à plusieurs sur des prompts IA, la centralisation devient impérative. Fini les prompts éparpillés dans des Google Docs personnels, des messages Slack perdus ou des fichiers texte sur le bureau de chacun.

Les solutions de gestion collaborative permettent à toute l’équipe d’accéder à la bibliothèque centralisée de prompts :

- Plateformes dédiées : PromptHub, OpenPrompt offrent workspaces d’équipe avec droits d’accès granulaires

- Outils génériques : Notion, Confluence, ou même un wiki interne font parfaitement l’affaire pour débuter

- Dépôts Git : pour les équipes techniques, un repo GitHub/GitLab avec documentation Markdown reste une valeur sûre

L’essentiel est que chaque membre puisse consulter, proposer et améliorer les prompts existants sans friction. Selon Latitude, la centralisation réduit de 40% le temps perdu à rechercher ou recréer des prompts déjà disponibles.

Mettre en place un processus de peer-review

Avant d’ajouter un nouveau prompt à votre bibliothèque de production, instaurez une étape de validation collective. Le principe du peer-review, emprunté au développement logiciel, s’applique merveilleusement bien aux templates d’IA.

Workflow type de validation :

- Proposition : un membre crée un nouveau prompt ou modifie un existant

- Tests préliminaires : l’auteur vérifie que le prompt produit les résultats attendus

- Demande de review : soumission à un ou plusieurs collègues pour relecture

- Retours : les reviewers commentent, suggèrent des améliorations, testent sur leurs propres cas d’usage

- Itération : ajustements basés sur les retours

- Approbation : validation finale et ajout à la bibliothèque officielle

Ce processus peut sembler lourd, mais il garantit la qualité et évite les prompts bancals qui polluent votre bibliothèque. Pour les équipes distribuées, des outils comme PromptHub intègrent directement ce workflow de review avec commentaires et approbations.

Gérer les droits d’accès et les permissions

Toutes les équipes n’ont pas besoin du même niveau d’accès à la bibliothèque de prompts IA. Définissez des rôles et permissions clairs :

- Lecteur : consultation seule, peut utiliser les prompts

- Contributeur : peut proposer des nouveaux prompts ou modifications

- Validateur : peut approuver les modifications proposées

- Administrateur : gère la structure, les permissions, archive les prompts obsolètes

Cette gestion des accès devient critique quand votre bibliothèque contient des prompts sensibles (données clients, stratégies commerciales) ou quand vous travaillez avec des prestataires externes.

Archiver intelligemment les prompts obsolètes

Ne supprimez jamais brutalement un prompt devenu obsolète. Vous pourriez en avoir besoin plus tard, ou simplement vouloir comprendre pourquoi telle approche a été abandonnée.

Créez plutôt une section d’archives dans votre bibliothèque :

/prompts

├── /actifs

│ └── [prompts en production]

├── /experimentaux

│ └── [prompts en test]

└── /archives

├── /obsoletes

│ └── [remplacés par versions plus récentes]

└── /deprecated

└── [abandonnés, avec raisons documentées]

Chaque prompt archivé doit inclure :

- Date et raison de l’archivage

- Par quoi il a été remplacé (si applicable)

- Contexte historique d’utilisation

Cette mémoire organisationnelle évite de réinventer la roue et capitalise sur les apprentissages passés. Selon les praticiens de Latitude, consulter les archives avant de créer un nouveau prompt fait gagner un temps précieux.

Tests, benchmarks et réutilisation des templates

Établir des protocoles de test systématiques

Un prompt qui fonctionne une fois n’est pas forcément un bon prompt. Pour valider la qualité et la robustesse de vos templates, instaurez des tests systématiques avant de les intégrer à votre bibliothèque de production.

Protocole de test recommandé :

- Tests de variabilité : exécuter le même prompt 5 à 10 fois pour vérifier la cohérence des outputs

- Tests avec différents inputs : essayer des variations d’instructions, des cas limites, des formats atypiques

- Tests multi-modèles : si pertinent, tester le prompt sur ChatGPT, Claude, Gemini pour comparer

- Tests de paramètres : ajuster température, tokens max, top_p pour identifier la configuration optimale

Documentez méticuleusement les résultats de ces tests dans votre bibliothèque. Cela permet à toute l’équipe de comprendre dans quelles conditions le prompt performe le mieux.

Existe-t-il des frameworks ou outils open source spécifiques pour automatiser les tests de prompts ?

Oui. Plusieurs frameworks et outils open source permettent d’automatiser les tests de prompts, avec des fonctions dédiées à l’évaluation, la comparaison et le versionnement dans les workflows IA. Les plus notables sont :

- Lilypad : outil open source complet pour tester et versionner les prompts, incluant le contexte complet et les paramètres du modèle. Compatible avec tout fournisseur de LLM, il peut être auto-hébergé via Docker et PostgreSQL.

- OpenPrompt : framework modulaire de prompt engineering avec un système d’évaluation intégré pour comparer les performances des prompts entre plusieurs modèles.

- Promptfoo : outil local orienté développeur pour l’évaluation automatique des prompts, les tests de robustesse (red-teaming) et les comparaisons côte à côte. Intègre les pipelines CI/CD et fonctionne hors ligne pour préserver la confidentialité.

- Helicone : plateforme open source pour exécuter des expériences contrôlées sur des prompts en production. Gère le versionnement, les retours en arrière et l’évaluation automatique via des modèles juges (LLM-as-a-judge).

- Opik : solution de traçage et d’évaluation des LLM conçue pour les environnements de développement et de production. Permet l’annotation, le scoring et l’intégration avec pytest pour des tests complets.

- PromptTools : boîte à outils pour expérimenter et tester des prompts sur plusieurs modèles et bases vectorielles, utilisable via du code, des notebooks ou une interface locale.

Ces solutions rendent les tests de prompts reproductibles et mesurables, avec gestion des versions, collaboration et intégration dans les cycles de développement, facilitant ainsi l’amélioration continue de la qualité des prompts.

Créer des benchmarks de performance

Au-delà des tests fonctionnels, mesurez la performance quantitative de vos prompts. Définissez des métriques claires adaptées à chaque type de template :

Pour la génération de contenu :

- Taux d’acceptation (contenu utilisé tel quel vs nécessitant réécriture)

- Temps moyen de génération

- Nombre de tokens consommés

- Score de qualité subjective (1-5)

Pour l’extraction de données :

- Précision (données correctement extraites / total)

- Rappel (données extraites / données présentes)

- Taux d’erreur ou de hallucinations

Pour la classification :

- Accuracy globale

- Confusion matrix pour identifier les erreurs fréquentes

- Temps de traitement par élément

Conservez ces benchmarks historiques dans votre bibliothèque. Quand vous optimisez un prompt, comparez les nouvelles performances aux anciennes pour valider objectivement l’amélioration.

Automatiser les tests avec des scripts

Pour les équipes techniques, automatiser les tests de prompts via des scripts de validation fait gagner un temps considérable. Plutôt que de tester manuellement chaque modification, laissez un script exécuter votre batterie de tests.

Exemple avec Python (approche conceptuelle) :

def test_prompt_extraction(prompt_template, test_cases):

results = []

for input_text, expected_output in test_cases:

actual_output = execute_prompt(prompt_template, input_text)

results.append({

'input': input_text,

'expected': expected_output,

'actual': actual_output,

'match': compare_outputs(expected_output, actual_output)

})

return generate_report(results)

Des frameworks comme LangChain facilitent la création de ces pipelines de tests automatisés pour vos bibliothèques de prompts IA.

Concevoir des templates réutilisables avec variables

La réutilisabilité est au cœur d’une bibliothèque de prompts performante. Plutôt que de créer 50 variantes d’un même prompt pour différents contextes, concevez des templates flexibles avec variables.

Approche sans variables (rigide) :

Rédige un article de blog sur le marketing digital.

Le ton doit être professionnel et pédagogique.

L'article doit faire environ 1000 mots.

Approche avec variables (flexible) :

Rédige un article de blog sur {{sujet}}.

Le ton doit être {{ton}} et {{style}}.

L'article doit faire environ {{longueur}} mots.

Vous pouvez alors réutiliser ce template pour n’importe quel sujet, en ajustant simplement les variables. Stockez dans votre bibliothèque :

- Le template de base avec variables clairement identifiées

- Des exemples de valeurs pour chaque variable

- Les combinaisons testées qui fonctionnent bien

Selon Langfuse, les templates avec variables bien documentées augmentent de 60% la réutilisation des prompts au sein d’une équipe.

Créer une bibliothèque de composants modulaires

Poussez la réutilisation encore plus loin en décomposant vos prompts en composants modulaires. Certaines instructions se retrouvent dans de nombreux templates :

Composants réutilisables :

- Instructions de format (JSON, Markdown, XML…)

- Contraintes de ton et style

- Exemples types (few-shot learning)

- Instructions de vérification et auto-critique

Stockez ces blocs de construction séparément dans votre bibliothèque. Quand vous créez un nouveau prompt, assemblez les composants pertinents plutôt que de repartir de zéro.

Conclusion : de la théorie à la pratique

Gérer une bibliothèque de prompts IA ne se limite pas à empiler des fichiers texte dans un dossier. C’est une discipline à part entière qui demande méthode, rigueur et outillage adapté. En appliquant les bonnes pratiques détaillées dans cet article, structuration cohérente, versioning systématique, collaboration organisée, tests rigoureux, vous transformez votre collection de templates en véritable asset stratégique.

Les bénéfices sont tangibles : moins de temps perdu à chercher ou recréer des prompts, meilleure qualité des outputs grâce à l’optimisation continue, capitalisation sur l’expérience collective, et surtout productivité démultipliée pour toute l’équipe.

Maintenant que vous maîtrisez les fondamentaux de la gestion d’une bibliothèque de prompts IA, il est temps de passer à la pratique. Selon votre profil et vos besoins, différentes solutions s’offrent à vous :

- Pour une approche accessible et collaborative : consultez notre guide pratique sur l’organisation des prompts avec Notion

- Pour une solution locale et flexible : découvrez comment organiser vos prompts avec Obsidian et Templater

- Pour un workflow orienté développeurs : explorez notre tutoriel sur l’organisation des prompts avec VS Code

Quelle que soit la solution retenue, l’essentiel est de commencer dès maintenant à organiser votre bibliothèque de prompts IA. Vous gagnerez en efficacité, en cohérence et éviterez ces longues minutes passées à rechercher ce prompt “magique” qui avait si bien marché… avant de disparaître dans vos notes. Pour bien démarrer, identifier le bon outil puis mettez en place progressivement les bonnes pratiques.

Série d’articles : organiser ses prompts IA

- Organiser ses prompts IA : guide complet des solutions en 2025

- Les meilleures pratiques pour gérer une bibliothèque de prompts IA ← Vous êtes ici

- Guide pratique : organiser ses prompts IA avec Notion

- Guide pratique : organiser ses prompts IA avec Obsidian et Templater

- Guide pratique : organiser ses prompts IA avec VS Code

- Comparatif des outils open source et commerciaux pour gérer ses prompts IA

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !