Pourquoi la régulation de l’IA est-elle si difficile aux États-Unis ?

Si l’intelligence artificielle révolutionne nos vies à une vitesse folle, la régulation de l’IA aux États-Unis reste un champ de bataille confus. Entre lobbying intense, divisions politiques, tensions populistes et enjeux économiques, les lois encadrant l’IA aux USA se heurtent à des murs invisibles. Mais pourquoi ce blocage permanent, alors même que les risques liés à l’IA sont de plus en plus évidents ?

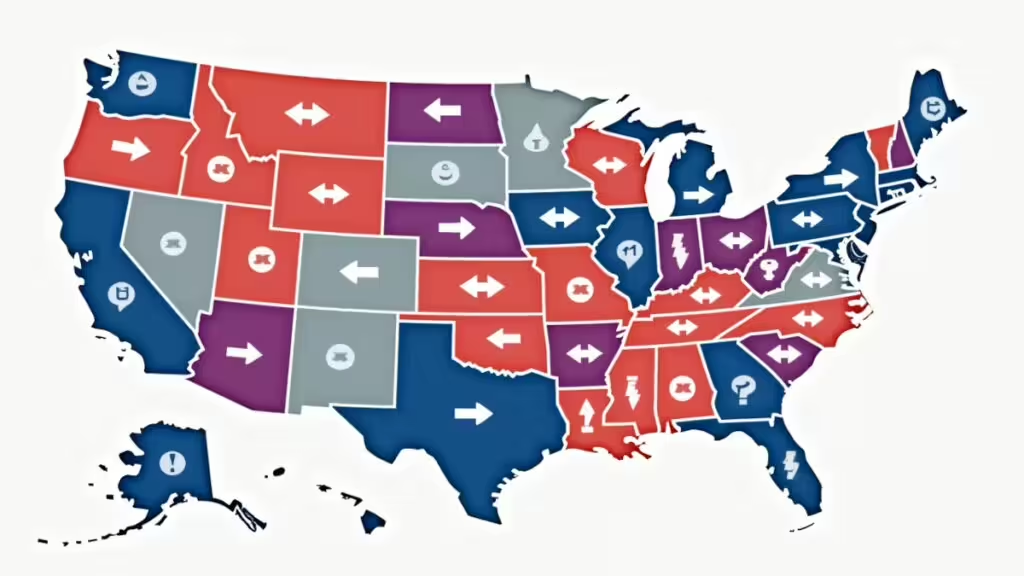

Un pays fragmenté : quand chaque État veut sa propre loi sur l’IA

Contrairement à l’Europe, où l’AI Act vise à encadrer l’IA au niveau communautaire, les États-Unis fonctionnent sous un système fédéral où chaque État peut adopter sa propre régulation IA. C’est le cauchemar des entreprises tech, qui redoutent une mosaïque de règles locales augmentant les coûts et la complexité juridique.

Récemment, un projet surnommé le Big Beautiful Bill Act visait à instaurer un moratoire empêchant les États de voter leurs propres lois sur l’IA pendant cinq ans, le temps de créer un cadre fédéral unifié. Mais selon un article de The Verge, cette tentative a été torpillée en 24 heures sous la pression de l’aile populiste MAGA (Make America Great Again, slogan de campagne de Donal Trump), qui y voyait une atteinte à la souveraineté des États.

Actuellement le Texas et la Californie ont déjà adopté des lois. Les deux états se distinguent par leurs approches opposées mais ambitieuses en matière de régulation IA.

- Le Texas adopte une approche structurée mais orientée gouvernement et innovation. Le Texas Responsible Artificial Intelligence Governance Act (TRAIGA), adopté le 22 juin 2025 et sera effectif au 1er janvier 2026, propose un cadre complet pour le développement, le déploiement et la supervision des systèmes d’IA dans l’État.

- La Californie cible de multiples secteurs pour protéger le consommateur et la société face aux dérives de l’IA. La Californie a choisi une approche plus large avec 18 nouvelles lois sur l’IA entrées en vigueur le 1er janvier 2025, couvrant une variété de domaines : Régulation des deepfakes, notamment dans les élections et le contenu sexuel ; Obligation de divulgation de l’utilisation de chatbots ; Audits de biais pour les agences de justice pénale utilisant l’IA ; Restrictions sur la reconnaissance faciale par la police ; Protection des données des consommateurs et exigences de transparence pour les systèmes d’IA ; Pour les systèmes de génération de contenus IA, la loi AB 2013 impose la transparence sur les données d’entraînement et l’étiquetage des contenus générés.

Le poids du lobbying IA aux USA : un frein constant

Les géants de la tech comme Google, OpenAI ou Microsoft exercent un lobbying puissant pour influencer les lois IA USA, cherchant des cadres souples leur permettant d’innover sans contraintes excessives. Selon le Center for Responsive Politics, les entreprises technologiques ont dépensé des millions de dollars pour bloquer des projets de lois jugés trop restrictifs pour l’innovation.

Ce lobbying IA aux USA s’allie parfois avec des élus favorables à la tech, ralentissant la mise en place d’un cadre légal, même minimal, pour encadrer l’usage des IA génératives, des modèles de langage ou des outils de surveillance algorithmique.

Le populisme aux Etat-Unis, un acteur inattendu du blocage

Dans l’affaire du Big Beautiful Bill, des figures comme Steve Bannon et Mike Davis ont mobilisé la base populiste contre le moratoire, selon The Verge. Pourquoi ? Parce que même si ces leaders sont critiques vis-à-vis des big tech, ils refusent de voir le gouvernement fédéral dicter une ligne nationale aux États.

C’est un paradoxe : la méfiance contre les géants de la technologie cohabite avec un refus de la régulation centralisée, alimenté par la peur d’un État fédéral trop intrusif.

Des divisions politiques qui paralysent le Congrès

Les divisions au Sénat américain sur les lois IA sont symptomatiques. Les démocrates veulent souvent intégrer des règles éthiques strictes (biais algorithmique, transparence, protection des données), tandis que de nombreux républicains veulent avant tout éviter de brider l’innovation et maintenir la compétitivité des USA face à la Chine.

Résultat : des compromis fragiles comme celui négocié par Ted Cruz et Marsha Blackburn sur le moratoire peuvent être défaits en quelques heures sous pression populiste.

La peur de perdre la course mondiale de l’IA

En toile de fond, les États-Unis craignent de perdre leur avance technologique sur la Chine. Réguler trop vite et trop fort risquerait de ralentir le développement de l’IA américaine, tandis que Pékin, avec ses approches autoritaires, pousse des innovations rapides sans se soucier des considérations éthiques ou sociétales.

C’est pourquoi certains élus hésitent à voter des lois IA aux USA trop strictes, malgré les alertes répétées sur les dérives potentielles de l’IA, qu’il s’agisse de biais, de surveillance de masse ou d’impacts sur l’emploi.

Un paysage médiatique polarisé qui amplifie les blocages

Les chaînes et podcasts influents comme War Room (Steve Bannon) mobilisent la base sur le thème de la liberté et de l’anti-fédéralisme, tandis que des médias progressistes appellent à des mesures d’encadrement immédiat. Cette polarisation empêche un débat rationnel sur les lois encadrant l’IA aux États-Unis, chaque camp voyant la régulation soit comme une trahison, soit comme une urgence absolue.

Peut-on s’attendre à une régulation IA aux USA dans les prochaines années ?

Malgré les blocages, certains signaux laissent entrevoir des évolutions. Des sénateurs des deux camps commencent à se rapprocher sur des thématiques transpartisanes comme la protection des enfants face aux deepfakes ou la régulation des systèmes d’IA dans le domaine de la santé.

Mais sans cadre fédéral clair, les États-Unis risquent de voir se multiplier des lois locales contradictoires, rendant le marché intérieur plus complexe et risquant d’affaiblir à terme la compétitivité américaine.

En résumé

- La régulation de l’IA aux États-Unis est freinée par :

- Le système fédéral et la volonté des États de garder le contrôle.

- Le lobbying intense des géants de la tech.

- La polarisation politique et le populisme.

- La peur de ralentir l’innovation face à la Chine.

- Les perspectives : Des avancées ponctuelles sur certains sujets, mais un cadre global reste improbable à court terme.

Pourquoi cela concerne aussi la France et l’Europe ?

L’Europe avance sur l’AI Act, les préoccupations sont nombreuses, mais les entreprises françaises et européennes doivent anticiper que l’absence de régulation claire aux États-Unis créera des distorsions de marché. Cela peut devenir un avantage pour l’Europe en termes de confiance des utilisateurs, mais un handicap si des solutions IA non régulées dominent le marché mondial.

En Europe, des entreprises demandent une « pause » dans l’application de l’AI Act

En Europe, les entreprises de la tech et autres secteurs, quarante-cinq entreprises européennes, dont Total, Carrefour, Airbus et des start-up comme Mistral AI et Pigment, ont adressé une lettre ouverte à la Commission européenne pour demander une pause de deux ans dans l’application de l’AI Act comme l’indique Le Monde.

Selon ces acteurs regroupés sous l’initiative « EU AI Champions Initiative », le règlement européen sur l’intelligence artificielle risque de fragiliser la compétitivité européenne et d’entraver l’émergence de champions européens dans ce secteur en raison de régulations jugées floues et complexes.

Les signataires estiment que l’Europe risque de compromettre ses ambitions en matière d’IA face à la concurrence internationale si l’AI Act est appliqué sans délais. Ils critiquent un déséquilibre entre régulation et innovation, pointant des obligations trop lourdes sans standards techniques ni guides de conformité clairs pour accompagner les entreprises dans leur mise en œuvre, ce qui pourrait freiner le déploiement à grande échelle de l’IA dans tous les secteurs.

Le collectif réclame le report des deux échéances majeures du texte, notamment les obligations prévues dès le 2 août 2025 pour les fabricants de modèles d’IA « à usage général » (comme ChatGPT, Gemini ou Le Chat de Mistral), et celles prévues pour l’été 2026 pour les systèmes d’IA « à haut risque » dans des secteurs stratégiques tels que l’énergie, l’éducation, l’emploi ou la justice. Ces obligations incluent des évaluations des risques, des documentations techniques et la transparence sur les données d’entraînement, éléments jugés difficiles à appliquer sans cadre précis.

La mise en application des RGPD à manquer d’encadrement, de facilité de mise en place et d’accompagnement. Un des secteurs les touchés par la mise en place des RGPD est celui des éditeurs Web, les contraintes réglementaires ont eu un impact sur les revenus des sociétés (absence de tracking, baisse de revenu publicitaire, affiliation). Aujourd’hui encore le problème persiste, ce qui a conduit des entreprises a fermé par manque de revenu.

Plus globalement, la mise en place des RGPD à nécessité des investissements considérables pour de nombreuses entreprises et à retarder de nombreux projets. Avec l’AI Act, les entreprises redoutent des problèmes similaires, alors que le marché est hyper concurrentiel à l’internationnal.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !