Tout savoir sur Qwen 3, l’alternative rapide et ouverte aux modèles LLM actuels

Dans un paysage où les modèles de langage open source ne cessent de gagner en puissance, Qwen 3 se démarque comme une alternative ambitieuse aux poids lourds du domaine tels que LLaMA 3, DeepSeek ou encore Gemma. Conçu par Alibaba Cloud, ce modèle de langage de nouvelle génération s’appuie sur une architecture Mixture of Experts (MoE) pour concilier performance, efficacité et souplesse de déploiement, notamment sur des machines locales.

Si les grands modèles propriétaires comme GPT-4 dominent encore certaines applications, les modèles open source comme Qwen 3 séduisent de plus en plus d’utilisateurs grâce à leur rapidité, leur qualité en mathématiques et leur compatibilité avec des cartes graphiques grand public. Mieux encore, ils sont souvent proposés sous des licences permissives, comme Apache 2.0, ouvrant la voie à une utilisation commerciale sans restriction majeure.

Cet article propose une analyse complète de Qwen 3, fondée à la fois sur les spécifications techniques, les benchmarks indépendants, mais aussi les retours concrets d’utilisateurs disponibles sur Reddit, comme dans ce fil de discussion : Reddit – Expériences avec Qwen 3. Nous le précisons : les avis partagés par la communauté restent subjectifs, mais offrent un aperçu précieux de l’utilisation réelle du modèle. À l’inverse, les benchmarks standardisés ont leurs propres biais, comme nous l’expliquons en détail dans un autre article.

Voyons d’abord ce qui rend Qwen 3 unique dans l’univers des modèles de langage.

Les fondamentaux de Qwen 3

Qwen 3 est la dernière évolution de la famille de modèles Qwen, développée par Alibaba Cloud. Son objectif est clair : fournir un modèle open source capable de rivaliser avec les meilleurs LLMs du moment, tout en restant accessible aux développeurs et chercheurs souhaitant exécuter des modèles localement, sans dépendance au cloud.

Une architecture orientée performance

L’un des aspects les plus notables de Qwen 3 est son architecture MoE (Mixture of Experts), qui permet d’activer seulement une partie des paramètres à chaque inférence. Par exemple, dans le modèle Qwen3-30B-A3B, seuls 8 milliards de paramètres sont activés sur un total de 30 milliards. Cela permet de réduire la consommation de VRAM tout en maintenant de bonnes performances, une caractéristique très appréciée des utilisateurs souhaitant déployer des LLMs sur des cartes comme la RTX 3090 ou 4090. J’ai pu tester la version quantifié Q4 sur une ordinateur avec une RTX 3070 Ti et ses 8 Go de VRAM, le modèle est utilisable avec une vitesse de 16.26 tok/sec.

À côté des modèles MoE, Alibaba propose également des versions denses (tous les paramètres sont activés), comme le Qwen3-32B dense, mieux adaptées à certaines tâches créatives ou au raisonnement complexe, mais qui nécessitent davantage de ressources matérielles.

Un éventail de tailles pour couvrir tous les besoins

La gamme Qwen 3 se décline en plusieurs tailles :

- Qwen3-14B : Un bon compromis pour ceux qui souhaitent coder ou raisonner avec un modèle local, sans carte graphique haut de gamme.

- Qwen3-30B-A3B (MoE) : Le modèle le plus recommandé par les utilisateurs pour son rapport performance/vitesse/efficacité sur matériel local.

- Qwen3-32B dense : Meilleur pour la créativité et les tâches plus variées, mais plus exigeant en termes de ressources.

- Qwen3-235B-A22B (MoE) : Un modèle géant, avec 235 milliards de paramètres dont 22B actifs par token. Réservé aux configurations extrêmes ou aux usages cloud.

Une licence permissive : Apache 2.0

Contrairement à de nombreux modèles récents (Gemma 3, Mistral), Qwen 3 est distribué sous licence Apache 2.0, ce qui autorise son utilisation commerciale, sa modification, et son intégration dans des projets propriétaires. C’est un atout majeur pour les entreprises ou développeurs indépendants cherchant une solution open source sans contrainte juridique forte.

Qwen 3 s’inscrit donc dans une nouvelle génération de LLMs open source qui combinent puissance, flexibilité et accessibilité matérielle. Dans la section suivante, nous explorerons ses performances concrètes, telles que rapportées par les utilisateurs et mesurées dans les benchmarks.

Performances générales de Qwen 3

Les performances de Qwen 3 ont rapidement attiré l’attention de la communauté, notamment pour sa rapidité d’exécution, sa précision en mathématiques et ses capacités avancées en programmation. Plusieurs utilisateurs sur Reddit ont partagé des benchmarks détaillés qui confirment les avancées du modèle, en particulier dans ses versions MoE, dont le rapport puissance/efficacité séduit de nombreux testeurs.

Une vitesse impressionnante en local

L’un des points les plus fréquemment salués dans les retours d’expérience concerne la vitesse d’inférence de Qwen 3, notamment dans sa version 30B-A3B MoE. Avec une carte RTX 4090, plusieurs utilisateurs atteignent des vitesses de plus de 100 tokens par seconde avec une quantification en Q8. Même sur une RTX 3090 avec ses 24 Go de VRAM, les performances restent très solides, autour de 73 t/s, comme le souligne un utilisateur dans ce fil Reddit. Comme pour tous LLM, l’impact de la quantité de VRAM est crucial. J’ai pu faire un test avec une RTX 3070 Ti 8 Go de VRAM, les performances tombes à 16.26 tok/sec, néanmoins Qwen 3 30B-A3B MoE reste utilisable.

Ces résultats font de Qwen 3 l’un des modèles les plus rapides à exécuter localement, tout en conservant un haut niveau de compréhension et de cohérence dans les réponses.

Excellente en mathématiques et raisonnement

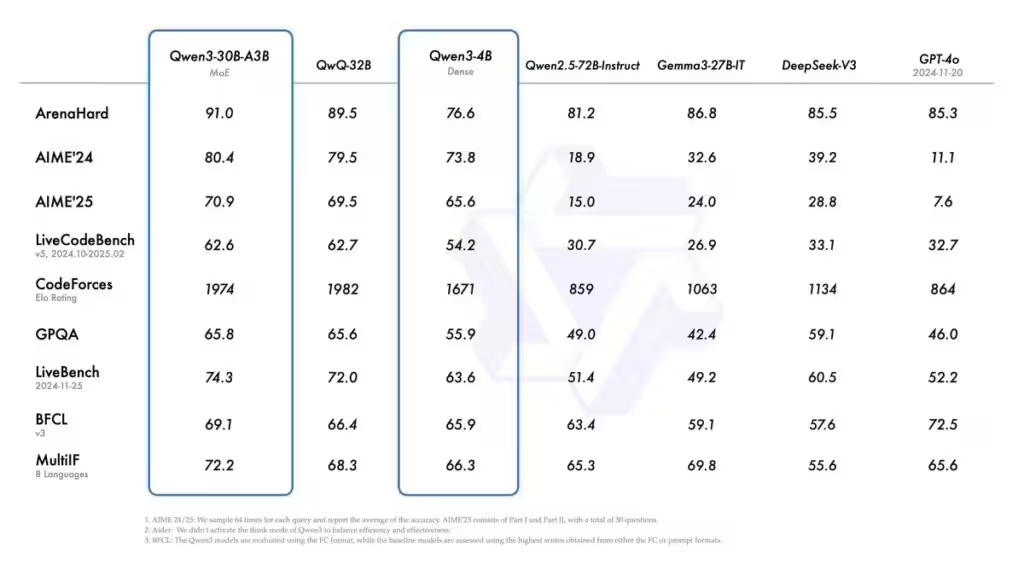

Qwen 3 brille particulièrement dans les tests de raisonnement mathématique. Par exemple, le modèle Qwen3-235B-A22B surpasse ou égalise DeepSeek R1 sur les benchmarks AIME’24/25. Sur GSM8K, un benchmark de résolution de problèmes mathématiques, Qwen 3 atteint un score de 91.5, supérieur à celui de DeepSeek (89.3). Ces résultats illustrent une réelle capacité à effectuer des raisonnements structurés, une fonctionnalité de plus en plus recherchée dans les LLMs.

Capacité de codage : entre puissance et limites

Les performances en génération de code sont globalement très bonnes, en particulier à partir de la version 14B. Les retours utilisateurs confirment que Qwen 3 est capable de générer du code structuré, lisible, et de répondre à des requêtes complexes. Toutefois, certains utilisateurs notent une forme de répétitivité ou un manque de flexibilité dans certaines tâches de programmation complexes. Ce phénomène semble plus fréquent dans les versions MoE et pour les requêtes multitâches impliquant plusieurs langages ou frameworks.

Malgré cela, Qwen 3 reste une référence en local pour les développeurs, comme en témoignent plusieurs retours sur Reddit, où il est régulièrement comparé à DeepSeek, Gemini ou encore LLaMA 3.

J’ai fait une première évaluation en local le modèle Qwen3-30B-A3B (MoE) avec des tests de prompts unique (pas d’itération) en python, javascript et php. Les tâches demandées étaient d’une complexité moyenne, le résultat étaient fonctionnel. Malgré des prompts simples, le modèle a anticipé des problématiques. Des tests multi-prompt avec plusieurs itérations restent nécessaires afin d’évaluer ses capacités. Pour le codage, les IA ont souvent tendance à se perdre (trop de complexité dans le code) ou à halluciner à la suite de nombreuses itérations.

A lire également : Quels modèles LLM installés en local avec 8 ou 16 Go de VRAM ?

Fonction-calling et tâches spécialisées

Un autre domaine où Qwen 3 s’illustre est la gestion des appels de fonctions (function-calling, interaction avec des API ou outils externes). Des utilisateurs qui exploitent le modèle dans des assistants de type domotique ou agents conversationnels rapportent une précision supérieure à celle de modèles comme Gemma 3, notamment pour déclencher des actions en réponse à des requêtes naturelles. Cela confirme la solidité du modèle dans des scénarios appliqués.

En somme, Qwen 3 offre des performances de premier plan, notamment en mathématiques, raisonnement et rapidité, ce qui en fait un candidat sérieux pour les utilisateurs à la recherche d’un LLM polyvalent et rapide à exécuter localement. Passons maintenant à la comparaison directe entre Qwen 3 et les autres grands modèles du moment.

Comparatif avec d’autres modèles de langage

Pour évaluer pleinement les atouts et les limites de Qwen 3, il est essentiel de le comparer avec ses principaux concurrents dans le domaine des LLMs open source. Les comparatifs Reddit ainsi que plusieurs benchmarks communautaires permettent de cerner les cas d’usage où Qwen 3 se démarque — ou au contraire, montre ses limites — face à des modèles comme LLaMA 3, Gemma 3 ou DeepSeek V3.

Qwen 3 vs LLaMA 3

Performances générales

LLaMA 3, notamment dans sa version 70B, est actuellement l’un des modèles open source les plus populaires. Il bénéficie d’une excellente réputation en matière de compréhension linguistique, d’instruction-following et de cohérence conversationnelle. Comparé à lui, Qwen 3 (notamment 30B-A3B et 32B dense) parvient à rivaliser sur de nombreuses tâches en anglais, avec une charge matérielle réduite.

Instruction-following et raisonnement

Les utilisateurs rapportent que LLaMA 3 est plus performant pour suivre des instructions complexes de manière fluide, ce qui le rend plus adapté aux usages orientés chat ou génération de texte créatif. En revanche, Qwen 3 est perçu comme plus intelligent dans les tâches de raisonnement pur et moins enclin à générer des réponses excessivement inventives.

Un retour Reddit pertinent évoque cette différence :

« Qwen est plus strict, parfois trop. LLaMA laisse plus de place à l’imagination, mais ça peut devenir du délire… »

Source Reddit

Qwen 3 vs Gemma 3

Multilinguisme et précision factuelle

Gemma 3 est reconnu pour sa prise en charge des langues autres que l’anglais, un domaine où Qwen 3 montre encore des lacunes. Les utilisateurs francophones, notamment, constatent des résultats de meilleure qualité avec Gemma 3 lorsqu’il s’agit de traduire ou de comprendre des textes dans des langues non anglophones.

Gemma 3 est également souvent jugé plus fiable en termes de réponses factuelles, là où Qwen 3 peut produire des hallucinations, notamment dans les versions MoE de grande taille.

Vitesse et efficacité

Qwen 3 prend toutefois l’avantage en vitesse d’inférence. À titre d’exemple, avec une RTX 4090, Qwen3-30B-A3B dépasse 100 tokens/seconde, alors que Gemma 3 est jusqu’à 40 % plus lent sur le même matériel. Pour une utilisation locale sur des PC haut de gamme, Qwen 3 est donc clairement plus adapté.

Qwen 3 vs DeepSeek V3

Raisonnement vs code réel

Le duel entre Qwen 3 et DeepSeek V3 est particulièrement intéressant dans le domaine du raisonnement logique et du développement. Qwen 3 domine souvent les benchmarks en mathématiques (GSM8K, AIME’24/25), avec des scores supérieurs sur certaines tâches classiques. Cependant, pour des scénarios de codage complexes (projets multi-technologies, interactions API, etc.), DeepSeek est souvent jugé plus stable et plus adaptable.

Architecture et efficacité

DeepSeek V3 repose sur une architecture MoE plus lourde (671B total, 37B activés par token), ce qui augmente la consommation mais peut améliorer la gestion de tâches variées. Qwen 3, avec ses versions plus compactes (ex. 30B-A3B avec 8B actifs), reste plus économique en ressources, ce qui favorise un déploiement local.

Cas d’usage différenciés

- Qwen 3 : idéal pour les calculs complexes, les longues conversations structurées, les assistants offline.

- DeepSeek V3 : mieux pour les outils de développement automatisé, la collaboration code + interface + API.

Dans la prochaine partie, nous verrons comment configurer Qwen 3 pour une exécution locale efficace, avec des recommandations concrètes en fonction de votre matériel.

Configurations matérielles recommandées pour Qwen 3

L’un des plus grands avantages de Qwen 3, notamment dans sa version 30B-A3B (MoE), est sa capacité à fonctionner en local avec des performances impressionnantes, sans nécessiter d’infrastructure cloud ou de matériel ultra-haut de gamme. De nombreux utilisateurs partagent sur Reddit des configurations optimisées qui permettent d’exploiter le modèle efficacement, même sur des PC de bureau puissants.

Cartes graphiques (GPU)

Qwen 3 a été conçu pour tirer parti de l’accélération GPU, avec des résultats très compétitifs en termes de vitesse. Voici quelques configurations testées et documentées :

- RTX 4090 : avec une quantification en Q8, Qwen3-30B-A3B atteint plus de 100 tokens/seconde, ce qui le rend très fluide pour la majorité des usages, y compris la génération de code ou le raisonnement en contexte long.

- RTX 3090 : des utilisateurs rapportent des performances autour de 72.9 tokens/seconde, en Q6 ou Q8, ce qui reste tout à fait viable.

- Cartes 12 Go de VRAM (comme la 3060) : possibilité d’exécuter Qwen 3 en Q6, avec des vitesses de 10 à 15 tokens/seconde, en désactivant CUDA fallback pour éviter les ralentissements dus à l’offloading sur RAM.

Il est fortement déconseillé d’activer l’offloading CPU, car cela utilise la mémoire partagée (RAM) au lieu de la VRAM, ce qui réduit drastiquement les performances.

Exécution sur CPU uniquement

Pour les utilisateurs sans GPU, Qwen3-30B-A3B peut être lancé sur un système avec 16 Go de RAM, en utilisant llama.cpp avec une quantification Q4. Bien que les performances soient limitées (environ 10–15 tokens/seconde), cela reste suffisant pour des tests ou des usages simples en ligne de commande.

Des versions quantifiées plus légères comme Q3_XL permettent une exécution plus rapide mais avec une perte de qualité de génération, surtout sur les tâches complexes.

Outils logiciels recommandés

Voici les principaux outils utilisés par la communauté Reddit pour exploiter Qwen 3 efficacement :

- LM Studio : très apprécié pour sa simplicité d’utilisation et sa compatibilité avec les modèles quantifiés. Idéal pour un déploiement rapide.

- llama.cpp : outil natif en C++ très performant, particulièrement utile pour l’exécution CPU. Il permet d’atteindre 25 t/s avec Qwen 3 contre 15 t/s sur LM Studio, selon certains utilisateurs.

- KoboldCPP : utilisé pour des interfaces plus interactives. Supporte l’offloading complet GPU (81 couches) et un contexte étendu jusqu’à 32 000 tokens, avec de bons résultats en Q4_K_XL.

Optimisations spécifiques

- Préférer les quantifications Q4 ou Q6 pour un bon équilibre entre qualité de sortie et performance.

- Désactiver CUDA fallback pour forcer l’utilisation de la VRAM.

- Pour les utilisateurs Apple : la bibliothèque MLX sur M4 Max permettrait d’atteindre 100+ t/s, ce qui rend Qwen 3 performant même sur Mac haut de gamme.

En résumé, Qwen 3 est l’un des modèles les plus efficaces à exécuter en local, que ce soit sur GPU ou CPU. Ses variantes MoE rendent possible une expérience fluide même avec une consommation réduite de mémoire. Nous allons maintenant explorer les limites identifiées par les utilisateurs pour mieux comprendre dans quels cas le modèle montre ses faiblesses.

Limites identifiées par les utilisateurs

Malgré ses nombreuses qualités, Qwen 3 n’est pas exempt de défauts. Les utilisateurs qui partagent leur expérience sur Reddit soulignent plusieurs points faibles, notamment en ce qui concerne la précision factuelle, la gestion des langues étrangères et, dans certains cas, la qualité du code généré.

Ces retours pratiques, bien qu’utiles, doivent être interprétés avec prudence : ils sont subjectifs, varient selon la configuration utilisée et la demande, et ne remplacent pas une évaluation rigoureuse sur des jeux de tests normalisés. Toutefois, ils apportent un éclairage précieux sur l’usage réel du modèle au quotidien.

Précision factuelle encore en retrait

L’un des reproches récurrents adressés à Qwen 3 concerne sa moindre fiabilité en matière de faits, particulièrement dans ses versions les plus grandes. Des utilisateurs notent que le modèle produit parfois des hallucinations ou des approximations, même sur des sujets relativement simples. Dans certains cas, LLaMA 3 ou Gemma 3 sont jugés plus précis sur des questions encyclopédiques ou des requêtes pointues.

Un utilisateur note par exemple sur Reddit :

« Le Qwen 3 est ultra rapide, mais je me méfie des infos qu’il donne. Je vérifie presque tout ce qu’il sort… »

Source Reddit

Difficultés en multilingue

Qwen 3 a été optimisé pour l’anglais, ce qui se traduit par des résultats médiocres en langues étrangères, notamment en français, espagnol ou encore dans les langues asiatiques non chinoises. Gemma 3, à l’inverse, s’illustre dans ce domaine grâce à une meilleure couverture multilingue et une structure plus adaptée à la diversité linguistique.

Pour les utilisateurs francophones, cela signifie que Qwen 3 peut produire des traductions incorrectes ou des formulations maladroites. Des cas d’usage comme les assistants multilingues ou la traduction automatique restent donc des points faibles du modèle.

Répétitivité et rigidité dans le code

Certains utilisateurs déplorent une forme de rigidité dans la génération de code, en particulier lorsqu’il s’agit de tâches complexes ou de projets nécessitant plusieurs bibliothèques ou langages. Bien que les performances sur des benchmarks comme MBPP soient solides, l’expérience en conditions réelles peut parfois être en retrait. D’autres soulignent une tendance du modèle à répéter certaines structures sans véritable créativité.

Ce problème semble plus prononcé dans les versions MoE, qui privilégient la vitesse d’inférence au détriment parfois de la finesse dans les réponses.

Une base de connaissance limitée à mi-2024

Comme la majorité des modèles open source actuels, Qwen 3 ne dispose pas d’une connaissance à jour. Son cutoff de données s’arrête à mi-2024, ce qui pose problème pour les technologies récentes, les bibliothèques en évolution rapide ou les événements d’actualité. Des utilisateurs évoquent des cas où Qwen 3 recommande des versions obsolètes de frameworks ou des API supprimées.

En résumé, Qwen 3 souffre de quelques limitations classiques des LLMs open source, mais il reste un modèle performant et utile dans de nombreux cas. Pour un usage multilingue, à jour ou très créatif, il faudra toutefois envisager des alternatives ou l’utiliser en complément d’autres outils. Nous allons maintenant explorer quelques cas d’usage concrets dans lesquels Qwen 3 excelle.

Cas d’usage concrets de Qwen 3

Au-delà des benchmarks et des performances théoriques, ce sont les cas d’usage réels qui révèlent la véritable utilité de Qwen 3. Sur Reddit, les témoignages d’utilisateurs montrent que le modèle se distingue dans plusieurs domaines spécifiques, notamment grâce à sa rapidité, sa capacité de raisonnement et sa compatibilité avec les environnements locaux.

Automatisation via agents ou assistants

L’un des cas d’usage les plus intéressants concerne l’intégration de Qwen 3 dans des systèmes domotiques ou d’assistance automatisée. Grâce à ses capacités de function-calling fiables, le modèle peut interpréter des commandes, identifier des fonctions associées et déclencher des actions dans des environnements personnalisés. Des utilisateurs rapportent que Qwen 3 se montre plus fiable que Gemma 3 pour ce type de tâche.

« Pour mes bots maison, Qwen 3 comprend mieux les fonctions à appeler. Moins d’erreurs, et plus rapide. »

Source Reddit

Cette capacité est particulièrement précieuse dans des contextes offline ou autonomes, où la latence et la cohérence dans l’exécution des instructions sont essentielles.

Développement logiciel en local

Qwen 3 est largement utilisé comme assistant de développement, notamment en combinaison avec des outils comme LM Studio ou KoboldCPP. Les développeurs s’en servent pour générer du code, commenter des blocs existants ou proposer des correctifs sur des fonctions.

Les versions 14B et 30B MoE sont privilégiées pour leur équilibre entre consommation mémoire et pertinence du code produit. Même si certains utilisateurs notent une certaine répétitivité, la capacité à travailler localement sans dépendance au cloud constitue un avantage clé pour ceux qui veulent rester maîtres de leur environnement de travail.

RAG et traitement documentaire

Qwen 3 est également exploité dans des scénarios de RAG (Retrieval-Augmented Generation), où il sert à enrichir des réponses à partir de documents indexés localement. Grâce à sa vitesse et à son efficacité contextuelle, le modèle peut gérer des requêtes longues ou complexes avec un contexte étendu allant jusqu’à 32K tokens, voire 1 million de tokens pour la version Turbo de Qwen 2.5.

Cela en fait un outil précieux pour les chercheurs, les juristes ou les analystes ayant besoin d’interroger de gros volumes de documents sans recourir à des API distantes.

Utilisation en contexte long

Enfin, les modèles de la famille Qwen (notamment Qwen2.5-Turbo) se distinguent par leur capacité à gérer de très longs contextes. Des tests montrent qu’ils peuvent maintenir la cohérence sur plusieurs dizaines de milliers de tokens, ce qui est rare parmi les modèles open source.

Cela ouvre la voie à des applications comme :

- L’analyse de transcriptions longues (réunions, procès-verbaux, etc.)

- Le résumé de documents volumineux

- L’assistance à la rédaction de rapports structurés

Ces cas d’usage confirment que Qwen 3 est un modèle polyvalent, particulièrement adapté aux contextes locaux, au développement et aux environnements nécessitant une forte réactivité sans dépendance cloud. Nous allons maintenant examiner quelles versions du modèle choisir selon les besoins et les ressources disponibles.

Quelle version de Qwen 3 choisir selon vos besoins

Avec plusieurs variantes disponibles, le choix de la version de Qwen 3 dépendra essentiellement de trois facteurs : la puissance de votre matériel, votre cas d’usage principal, et le niveau de performance recherché. Grâce à sa structure modulaire, la famille Qwen 3 permet de répondre à des profils variés, allant du simple utilisateur curieux au développeur professionnel.

Qwen 3 14B : l’option légère et accessible

La version 14B est idéale pour les utilisateurs souhaitant expérimenter localement un modèle puissant sans GPU haut de gamme. Avec une quantification en Q4 ou Q5, ce modèle peut fonctionner sur des cartes de milieu de gamme comme la RTX 3060 (12 Go), voire sur des configurations CPU-only à condition d’accepter une vitesse réduite.

Usage recommandé :

- Codage de base

- Rédaction de texte simple

- Agents conversationnels

- Test de capacités LLM en local

Qwen 3 30B-A3B (MoE) : le meilleur équilibre

C’est la version la plus populaire auprès de la communauté Reddit. Grâce à son architecture MoE, elle n’active que 8 milliards de paramètres à chaque inférence, ce qui réduit la charge tout en conservant d’excellentes performances en codage, raisonnement et vitesse. Ce modèle est parfait pour les utilisateurs équipés d’une RTX 3090/4090 ou équivalent.

Usage recommandé :

- Développement logiciel avancé

- Fonction-calling / automation

- Applications type RAG

- Productivité personnelle offline

« Qwen 3 30B MoE, c’est tout ce dont j’ai besoin. Rapide, pertinent, tourne parfaitement sur mon 4090. »

Source Reddit

Qwen 3 32B dense : pour la créativité et les tâches variées

Contrairement à la version MoE, ce modèle active tous ses paramètres, ce qui le rend plus coûteux en ressources, mais parfois plus cohérent pour les tâches demandant un enchaînement créatif ou une compréhension contextuelle approfondie. Il nécessite au moins 48 à 64 Go de VRAM pour une exécution fluide non quantifiée.

Usage recommandé :

- Génération de texte complexe

- Dialogue structuré

- Assistants personnels polyvalents

- Simulation de scénarios narratifs ou jeux de rôle

Qwen 3 235B-A22B : la version extrême

Réservée aux utilisateurs disposant d’un accès à du matériel professionnel ou cloud, cette version massive offre des performances maximales sur des benchmarks comme AIME’24/25, mais reste difficilement exploitable pour un usage local classique. Elle utilise une architecture MoE de 235B paramètres avec 22B activés par token.

Usage recommandé :

- Recherche avancée

- Benchmarks LLM

- Entraînements comparatifs

- Scénarios cloud multi-utilisateurs

Le bon modèle dépend donc de vos contraintes techniques et de vos objectifs. Si vous êtes un développeur solo avec un GPU puissant, le 30B-A3B MoE est sans doute le meilleur choix. Si vous cherchez une alternative plus légère pour tester ou apprendre, le 14B suffit largement. Nous allons maintenant aborder les questions fréquentes des utilisateurs, issues de la section « Autres questions posées » de Google.

FAQ – Questions fréquentes sur Qwen 3

Oui, Qwen 3 est un modèle open source disponible gratuitement. Il peut être téléchargé et utilisé sans frais depuis des plateformes comme Hugging Face ou via des dépôts GitHub associés. Sa licence Apache 2.0 permet également un usage commercial.

Oui, il est possible de faire tourner Qwen 3 sur un CPU uniquement, notamment avec des outils comme llama.cpp et des versions quantifiées en Q4 ou Q3. Cependant, les performances seront limitées, ce qui peut ralentir considérablement les interactions. Une carte graphique reste fortement recommandée pour un usage confortable.

Qwen 3 apporte des améliorations majeures en vitesse, architecture (MoE) et en raisonnement, par rapport à Qwen 2.5. Toutefois, certains utilisateurs notent que dans certaines tâches sans activation du mode « thinking » (raisonnement explicite), Qwen 2.5 peut parfois donner de meilleurs résultats. Qwen 2.5-Turbo est également plus adapté aux contextes très longs (jusqu’à 1M de tokens).

Cela dépend du cas d’usage. Pour des tâches spécifiques comme le raisonnement mathématique, l’exécution en local, ou la vitesse, Qwen 3 peut être plus rapide et plus flexible qu’un modèle comme ChatGPT-3.5. En revanche, ChatGPT-4 reste supérieur en créativité, cohérence conversationnelle et accessibilité via le cloud.

Qwen 3 est distribué sous licence Apache 2.0, ce qui permet un usage commercial, la modification, l’intégration dans des applications privées ou publiques, sans contrainte majeure. Cela le distingue de nombreux autres modèles plus restrictifs (Gemma 3, Mistral…).

Oui, et c’est l’un de ses grands avantages. Grâce à sa licence permissive, une entreprise peut utiliser Qwen 3 dans un produit, une application ou un service client, sans frais de licence. Il est toutefois conseillé d’intégrer des filtres de sécurité ou de validation si le modèle est utilisé en production.

Non, à ce jour, Qwen 3 ne prend pas en charge le multimodal (texte + image). Pour des tâches de génération ou d’analyse d’image, il faudra se tourner vers des modèles comme Gemma 3 ou des alternatives multimodales (ex. : LLaVA, GPT-4V).

Oui, l’ensemble des modèles Qwen 3 est accessible sur Hugging Face. Vous y trouverez les versions quantifiées, les fichiers de configuration, ainsi que les informations de licence et d’intégration via les bibliothèques Transformers ou GGUF (llama.cpp).

Conclusion : Qwen 3, un modèle local puissant, flexible et prometteur

Avec l’arrivée de Qwen 3, Alibaba Cloud a marqué un tournant dans le monde des modèles open source. Ce modèle, rapide, puissant et optimisé pour une exécution locale, offre une alternative crédible aux solutions propriétaires comme GPT-4 ou aux modèles lourds comme LLaMA 3 70B. Son architecture MoE permet de concilier performance et légèreté, ce qui le rend particulièrement attractif pour les utilisateurs disposant de cartes graphiques performantes, sans pour autant nécessiter des infrastructures de datacenter.

Les points forts à retenir

- Rapidité d’inférence exceptionnelle : Qwen 3-30B-A3B dépasse souvent les 100 tokens/seconde sur une RTX 4090.

- Performance en mathématiques et raisonnement : scores de référence sur GSM8K et AIME, supérieurs à ceux de certains concurrents comme DeepSeek.

- Fonction-calling fiable pour l’automatisation, les bots ou agents locaux.

- Licence Apache 2.0, qui permet un usage commercial sans restriction.

- Support efficace du long contexte, en particulier dans les versions Turbo de Qwen 2.5.

Les limites à prendre en compte

- Précision factuelle encore perfectible, notamment dans les grandes versions MoE.

- Faibles performances en multilingue, avec des résultats moyens en français ou autres langues non anglaises.

- Rigidité dans certaines tâches de génération de code, avec des sorties parfois répétitives ou peu créatives.

- Pas de prise en charge multimodale (vision), contrairement à certains concurrents comme Gemma 3.

À qui s’adresse Qwen 3 ?

- Développeurs et ingénieurs : pour la génération de code, l’analyse de logs, ou la création d’agents intelligents.

- Chercheurs : pour tester des scénarios complexes de raisonnement, de synthèse de documents ou de calcul scientifique.

- Entreprises : qui souhaitent intégrer un modèle open source dans leur produit sans dépendre du cloud.

- Utilisateurs avancés : disposant d’un GPU haut de gamme et souhaitant une IA locale rapide, contrôlable et performante.

En somme, Qwen 3 s’impose comme une alternative sérieuse, rapide et maîtrisable, dans un univers LLM encore dominé par les solutions cloud fermées. Son potentiel réel dépendra de l’évolution de son support multilingue, de sa capacité à rester à jour, et de l’adoption croissante d’outils de déploiement local performants.

Les retours utilisateurs sur Reddit, bien que subjectifs, confirment la maturité croissante du projet Qwen. Si vous souhaitez tester le modèle ou partager votre retour, plusieurs fils de discussion sont disponibles sur le subreddit r/LocalLLaMA. Pour un test rapide en local, je vous recommande d’utiliser LM Studio, pour aller plus loin préférez Ollama ou Hugging Face. Plus classique et facile, l’interface Cloud avec chat.qwen.ai.

Liens recommandés

- Découvrez les modèles Qwen 3 sur Hugging Face ou page Github sur Qwen 3

- Analyse comparative des performances de Qwen 3

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !