Test GPT-OSS 120B en local : résultats surprenants sur une RTX 5090

Depuis quelques mois, les modèles d’intelligence artificielle à grande échelle se multiplient, et avec eux une question revient souvent : peut-on réellement exécuter un « grand » LLM comme GPT-OSS 120B en local sur un PC personnel ? Officiellement, ce modèle est conçu pour tourner sur des GPU professionnels de 80 Go de VRAM, comme l’NVIDIA H100 ou l’AMD MI300X, capables d’absorber ses 117 milliards de paramètres. Autrement dit, sur le papier, impossible de le lancer sur une simple carte graphique grand public.

Et pourtant, la pratique réserve parfois des surprises. Avec un peu d’optimisation et les bons outils, j’ai tenté l’expérience en local, directement sur ma configuration équipée d’une RTX 5090 (32 Go de VRAM), d’un Ryzen 5900X et de 64 Go de RAM. Un test qui semblait voué à l’échec, mais qui a finalement donné des résultats… inattendus.

GPT-OSS 120B en local : entre rêve et réalité

GPT-OSS 120B est présenté comme un modèle pour un raisonnement avancé, des tâches agentiques et des cas d’usage polyvalents pour les développeurs. Il est pensé pour la recherche, les applications professionnelles ou encore les scénarios exigeants en raisonnement avancé.

En théorie, lancer ce mastodonte sur une carte graphique grand public est une hérésie : manque de mémoire, risque d’instabilité et vitesse d’inférence trop faible. Mais grâce à l’écosystème open source, notamment Ollama et Open WebUI, il est aujourd’hui possible de tester ce type de modèle sur une machine bien équipée, même si elle n’atteint pas les standards des centres de données.

Mon expérience avec Ollama et Open WebUI

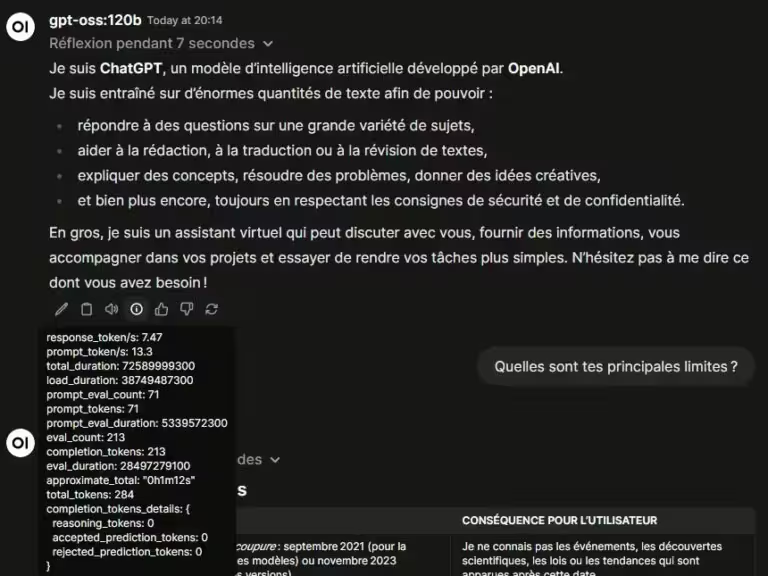

L’intégration dans Ollama simplifie grandement le processus. Une fois le modèle téléchargé, il est possible de l’interroger via la nouvelle interface d’inférence d’Ollama ou encore via Open WebUI, une interface intuitive qui facilite les tests. L’expérience est fluide, mais on sent rapidement que la machine est poussée dans ses retranchements : la génération de texte est régulière, mais le temps de réflexion reste perceptible avant que le modèle ne réponde.

C’est ici que se joue la principale différence avec une exécution sur GPU professionnel. Là où une H100 offrirait une latence minimale, la RTX 5090 doit compenser ses 32 Go de VRAM. Cela reste impressionnant de voir un tel modèle tourner sur une configuration de bureau, mais il faut accepter des compromis en termes de vitesse. Lors de l’inférence, le CPU et la RAM sont pleinement sollicité, vu que le modèle ne tient pas sur les 32 Go de la 5090.

Les résultats obtenus en chiffres

Concrètement, voici les résultats de mes tests avec deux prompts simples :

- Temps de réflexion : 7 et 12 secondes

- Vitesse d’inférence : 7,47 et 7,21 tokens par seconde

Ces chiffres montrent qu’un tel modèle est utilisable en local, mais loin d’être optimal pour un usage régulier. C’est plus une preuve de concept qu’une solution de production. Pour des tâches lourdes et un usage professionnel, le cloud ou les GPU haut de gamme restent incontournables. Le modèle plus petit, GPT-OSS 20B reste à privilégier pour un usage en local, la latence et l’inférence sont nettement supérieures au prix d’une connaissance globale plus limitée et un raisonnement moins poussé.

Conclusion

Tester GPT-OSS 120B en local sur une RTX 5090 relève autant de l’exploit technique que de la curiosité. Oui, c’est possible. Oui, cela fonctionne. Mais non, ce n’est pas idéal pour une utilisation quotidienne. L’expérience montre surtout à quel point la frontière entre GPU grand public et infrastructure professionnelle commence à s’estomper et les années à venir devraient rendre l’IA locale encore plus pertinente. La principale limitation aujourd’hui est la quantité de VRAM disponible.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !