Top 10 des modèles tendances sur Hugging Face en septembre 2025

Le mois de septembre 2025 n’est qu’une nouvelle étape pour l’intelligence artificielle open source. Sur Hugging Face, la plateforme incontournable des chercheurs, développeurs et passionnés d’IA, certains modèles se démarquent nettement par leur popularité, mesurée à travers les téléchargements, les mises à jour fréquentes et le nombre de likes.

Cet article propose un tour d’horizon des 10 des modèles tendances sur Hugging Face en septembre 2025, un classement qui reflète à la fois les besoins actuels en Large Language Models (LLM), en modèles multimodaux (texte, image, audio, vidéo) et en outils spécialisés comme les modèles de traduction, de génération d’images ou de recherche sémantique.

Pourquoi suivre les modèles tendances sur Hugging Face ?

Hugging Face est devenu bien plus qu’un simple dépôt de modèles IA. C’est un véritable baromètre de l’innovation et des usages dans le domaine de l’intelligence artificielle. Les modèles IA populaires permettent de comprendre quelles architectures, techniques et cas d’usage dominent le marché. Suivre les modèles les plus téléchargés et « liké », c’est aussi anticiper les futures tendances : que ce soit un modèle d’embedding pour la recherche sémantique, un modèle de diffusion text-to-image haute résolution ou encore un LLM optimisé pour le code et le raisonnement long contexte.

Pour les entreprises comme pour les développeurs indépendants, choisir un modèle en vogue sur Hugging Face, c’est accéder à une technologie déjà validée par une large communauté, ce qui garantit une meilleure documentation, plus de retours d’expérience et des performances testées à grande échelle.

Méthodologie et critères de sélection des modèles tendances IA

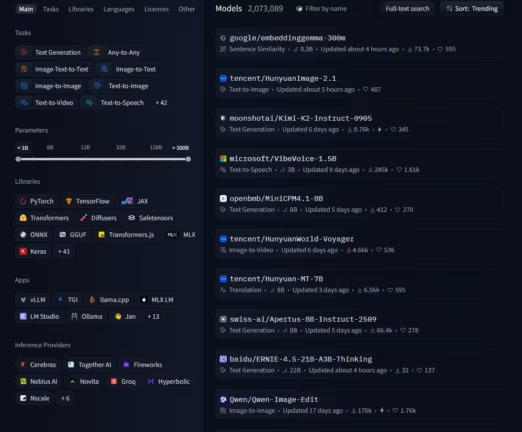

Ce classement des 10modèles tendances sur Hugging Face en septembre 2025 s’appuie sur plusieurs critères objectifs :

- Nombre de téléchargements : un indicateur direct de l’adoption par la communauté.

- Nombre de likes : une mesure de la satisfaction et de la confiance des utilisateurs.

- Date de mise à jour : les modèles récents sont souvent plus performants et mieux adaptés aux besoins actuels.

La sélection couvre plusieurs catégories : LLM open source, modèles de traduction multilingues, modèles de génération et d’édition d’images, modèles audio pour la synthèse vocale, ainsi que des modèles spécialisés dans la recherche et la similarité sémantique. En combinant ces critères, l’article propose une vision globale des tendances IA sur Hugging Face en 2025, utile aussi bien pour les chercheurs que pour les professionnels cherchant à intégrer l’IA dans leurs produits.

| Modèle | Paramètres | Téléchargements | Likes |

|---|---|---|---|

| google/embeddinggemma-300m | 0.3B | 73.7k | 595 |

| tencent/HunyuanImage-2.1 | – | 487 | – |

| moonshotai/Kimi-K2-Instruct-0905 | – | 8.76k | 345 |

| microsoft/VibeVoice-1.5B | 3B | 245k | 1.61k |

| openbmb/MiniCPM4.1-8B | 8B | 412 | 270 |

| tencent/HunyuanWorld-Voyager | – | 4.66k | 536 |

| tencent/Hunyuan-MT-7B | 8B | 6.56k | 595 |

| swiss-ai/Apertus-8B-Instruct-2509 | 8B | 66.4k | 278 |

| baidu/ERNIE-4.5-21B-A3B-Thinking | 22B | 32 | 137 |

| Qwen/Qwen-Image-Edit | – | 176k | 1.76k |

1. google/embeddinggemma-300m : un modèle d’embedding multilingue de nouvelle génération

Parmi les AI models les plus populaires sur Hugging Face en septembre 2025, google/embeddinggemma-300m occupe une place de choix. Développé par Google DeepMind, ce modèle léger de 300 millions de paramètres s’impose comme une solution idéale pour toutes les tâches liées à la similarité sémantique, à la classification de texte ou encore au clustering de documents.

L’atout majeur d’EmbeddingGemma réside dans son entraînement multilingue, couvrant plus de 100 langues, ce qui en fait un outil puissant pour la recherche et la récupération d’information dans des environnements multilingues. Comme le souligne la documentation officielle de Google, ce modèle est pensé pour fonctionner aussi bien sur des infrastructures cloud que sur des machines locales à ressources limitées (PC, ordinateurs portables, voire smartphones).

Techniquement, il produit des vecteurs embeddings de dimension 768 (avec possibilité de réduction à 512, 256 ou 128 grâce à la technique Matryoshka Representation Learning). Cela le rend particulièrement adapté aux cas d’usage modernes :

- Moteurs de recherche internes pour entreprises et institutions.

- Recommandation de contenus sur des plateformes numériques.

- Analyse de similarité textuelle pour détection de doublons ou d’anomalies.

- Retrieval-Augmented Generation (RAG) en association avec des LLM.

En septembre 2025, le succès de ce modèle sur Hugging Face s’explique par sa légèreté, sa performance multilingue et son intégration directe avec Sentence Transformers, qui facilite son adoption par la communauté.

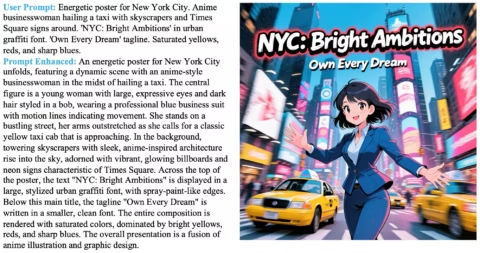

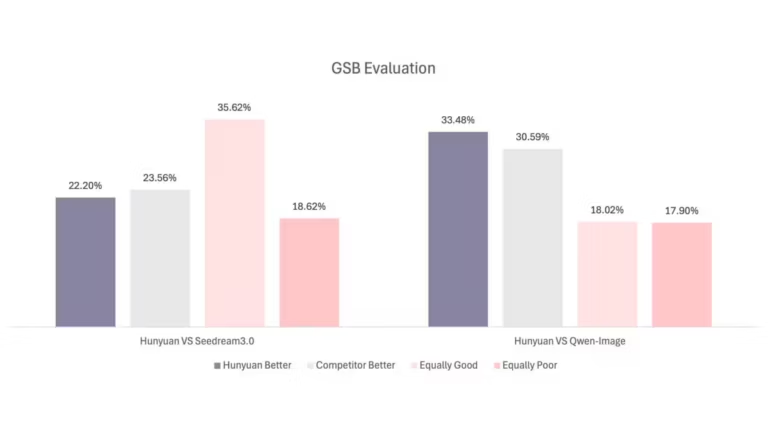

2. tencent/HunyuanImage-2.1 : le text-to-image en 2K résolution

Le second modèle marquant de ce classement est tencent/HunyuanImage-2.1, un modèle diffusion text-to-image qui se distingue par sa capacité à générer des images en ultra haute résolution (2048×2048) tout en assurant une grande cohérence entre le texte et l’image.

Publié début septembre 2025, ce modèle combine plusieurs innovations techniques :

- Prompt Enhancer qui enrichit automatiquement les instructions textuelles.

- Refiner Model pour améliorer netteté et détails visuels.

- Reinforcement Learning from Human Feedback (RLHF) appliqué pour optimiser l’esthétique et la précision.

Les benchmarks, comme le Structured Semantic Alignment Evaluation (SSAE), montrent que HunyuanImage-2.1 rivalise avec les meilleurs modèles fermés tels que GPT-Image et surpasse plusieurs modèles open source comme Qwen-Image.

Ses applications sont multiples :

- Création artistique et design graphique.

- Génération d’illustrations marketing et publicitaires.

- Production de contenus créatifs pour les réseaux sociaux.

- Prototypage rapide pour le cinéma, l’animation et le jeu vidéo.

Avec ce modèle, Tencent confirme sa place d’acteur incontournable dans la course aux modèles multimodaux, et son adoption massive sur Hugging Face en septembre 2025 reflète la demande croissante en IA générative pour l’image.

3. moonshotai/Kimi-K2-Instruct-0905 : un géant du raisonnement et du code

Le modèle moonshotai/Kimi-K2-Instruct-0905 fait partie des LLM tendance sur Hugging Face en septembre 2025. Développé par Moonshot AI, il incarne une nouvelle génération de Mixture-of-Experts (MoE), avec un total impressionnant d’1 trillion de paramètres dont 32 milliards activés par token.

Sa force réside dans trois aspects majeurs :

- Un contexte étendu à 256k tokens, ce qui en fait l’un des meilleurs modèles pour traiter des projets complexes et de longs documents.

- Des performances remarquables sur les benchmarks de code, comme SWE-Bench, où il rivalise avec des géants tels que Claude Opus 4 ou DeepSeek V3.1.

- Des capacités avancées de tool calling, qui le rendent particulièrement utile dans des environnements d’agent IA.

Dans la pratique, cela signifie que Kimi-K2-Instruct-0905 est parfaitement adapté aux développeurs travaillant sur :

- La génération et correction de code.

- La création d’agents conversationnels intelligents.

- Des projets nécessitant de la raison longue et structurée comme la recherche scientifique.

En septembre 2025, ce modèle est plébiscité par les communautés de développeurs pour sa puissance, mais aussi pour sa compatibilité avec vLLM, SGLang et TensorRT-LLM, ce qui facilite son déploiement en production.

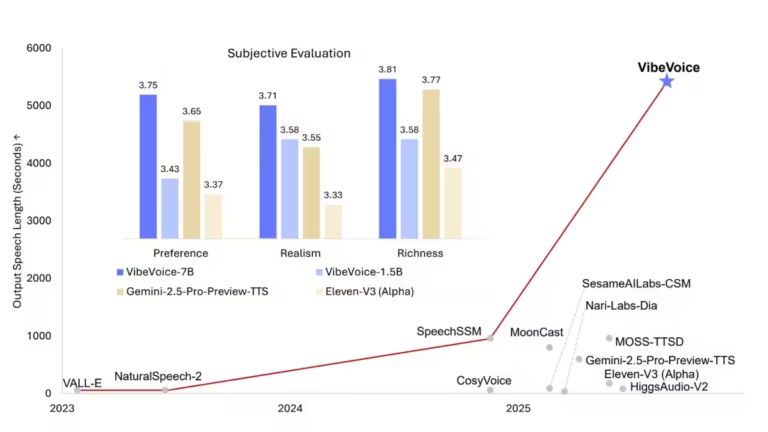

4. microsoft/VibeVoice-1.5B : l’avenir du text-to-speech expressif

Microsoft, déjà présent avec Copilot et Azure AI, franchit une étape avec VibeVoice-1.5B, un modèle Text-to-Speech (TTS) qui se distingue des systèmes classiques par sa capacité à générer des conversations audio naturelles et expressives, proches de l’expérience humaine. A noter une version VibeVoice-7B est également disponible.

Ce modèle repose sur une architecture innovante combinant :

- Des tokenizers acoustiques et sémantiques qui préservent la qualité audio tout en réduisant le coût de calcul.

- Un framework de diffusion de type next-token, qui améliore la fluidité et le naturel de la voix.

- La gestion multi-speakers, capable de produire jusqu’à 90 minutes d’audio avec 4 voix distinctes.

Cependant, Microsoft met en garde sur les usages à risque, notamment les deepfakes vocaux. Pour y répondre, VibeVoice-1.5B intègre deux garde-fous :

- Un watermark invisible dans l’audio généré.

- Un message audible inséré automatiquement dans chaque fichier : “This segment was generated by AI”.

Avec ce modèle, Hugging Face enregistre une adoption rapide, particulièrement par les créateurs de podcasts, de livres audio et les chercheurs en human-computer interaction. C’est un pas décisif pour l’avenir des conversations artificielles immersives. A ce jour ce modèle ce limite à l’anglais et chinois, pour un choix plus large vous pouvez consulter le guide des meilleurs modèles TTS.

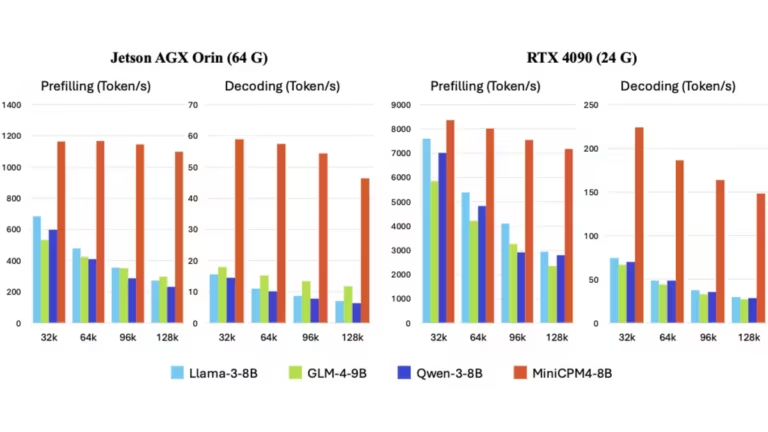

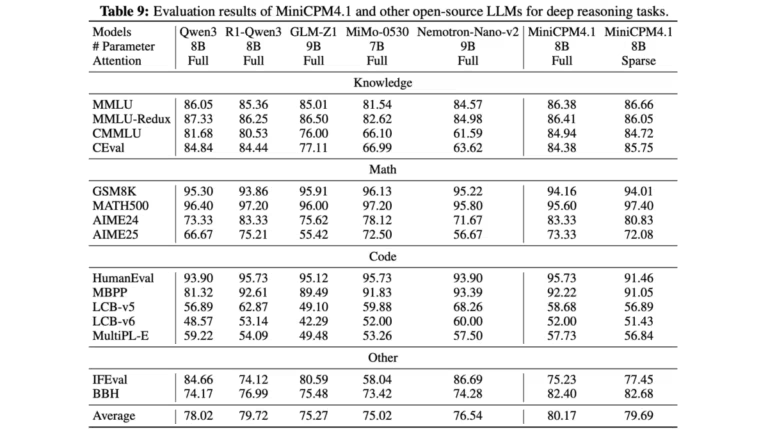

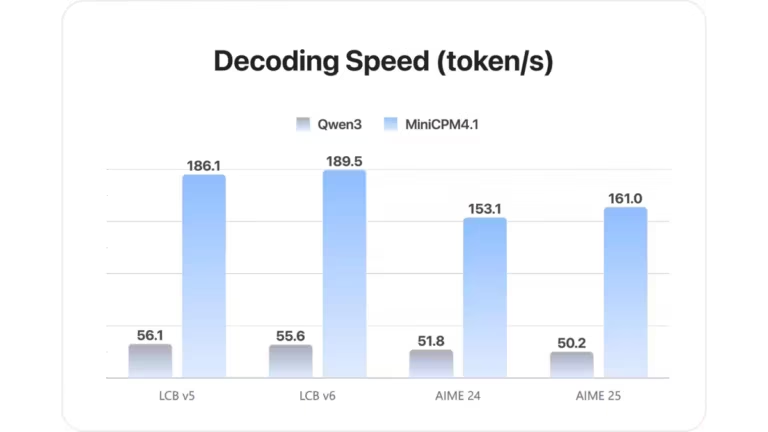

5. openbmb/MiniCPM4.1-8B : un LLM optimisé pour les appareils edge

Le modèle openbmb/MiniCPM4.1-8B illustre une autre tendance forte sur Hugging Face : la recherche d’efficacité pour les appareils edge et les environnements à ressources limitées. Contrairement aux mastodontes comme Kimi-K2 ou ERNIE, ce modèle se concentre sur la performance coût/efficacité.

Ses principales innovations sont :

- InfLLM v2, une attention clairsemée entraînable qui réduit drastiquement le coût des séquences longues.

- BitCPM, une quantification ternaire qui réduit de 90 % la taille des paramètres.

- Hybrid reasoning mode, permettant de basculer entre raisonnement profond et génération rapide en fonction des besoins.

- Support de contextes longs jusqu’à 65k tokens, extensible à 128k avec RoPE scaling.

Concrètement, MiniCPM4.1-8B est utilisé dans :

- Des applications mobiles d’IA.

- Des projets embarqués (robots, assistants vocaux).

- Des environnements cloud-edge hybrides.

Avec un support natif pour CUDA, SGLang et vLLM, il séduit les développeurs cherchant un compromis entre puissance et légèreté. Sa montée en popularité en septembre 2025 montre bien que la course à l’IA ne se limite pas aux supercalculateurs, mais aussi à l’IA accessible et embarquée.

6. tencent/HunyuanWorld-Voyager : la vidéo 3D à partir d’une seule image

Avec tencent/HunyuanWorld-Voyager, nous entrons dans un autre domaine : la génération vidéo 3D-consistante. Ce modèle repose sur un cadre de diffusion vidéo innovant capable de transformer une simple image en une séquence vidéo 3D en respectant un chemin de caméra défini par l’utilisateur.

Ses caractéristiques clés incluent :

- La génération conjointe de vidéos RGB et profondeur, facilitant la reconstruction 3D.

- La cohérence de scène à long terme, ce qui garantit que l’univers généré reste réaliste malgré les changements d’angles.

- Des applications concrètes pour la réalité virtuelle (VR), le jeu vidéo et le cinéma immersif.

Comme le montre la publication scientifique associée (Huang et al., 2025), Voyager ouvre la voie à une nouvelle génération de contenus interactifs explorables, une tendance forte sur Hugging Face où les modèles multimodaux gagnent en visibilité.

7. tencent/Hunyuan-MT-7B : la traduction multilingue de pointe

Le modèle tencent/Hunyuan-MT-7B fait figure de référence en matière de traduction automatique. Avec le support de 33 langues (dont des langues minoritaires chinoises), il s’adresse à la fois au grand public et aux projets académiques ou industriels nécessitant une traduction fiable et fluide.

Ses points distinctifs :

- Une architecture optimisée pour la cross-lingual pretraining (CPT) et le supervised fine-tuning (SFT).

- Un modèle compagnon, Hunyuan-MT-Chimera-7B, qui combine plusieurs sorties de traduction pour offrir un résultat enrichi.

- Une première place au concours WMT25 sur 30 des 31 catégories.

Ce succès s’explique par la combinaison de qualité linguistique, de robustesse multilingue et de performance sur des langues rarement couvertes par les grands LLM. Sur Hugging Face, Hunyuan-MT-7B séduit développeurs, chercheurs et traducteurs cherchant une alternative open source aux services fermés comme DeepL ou Google Translate.

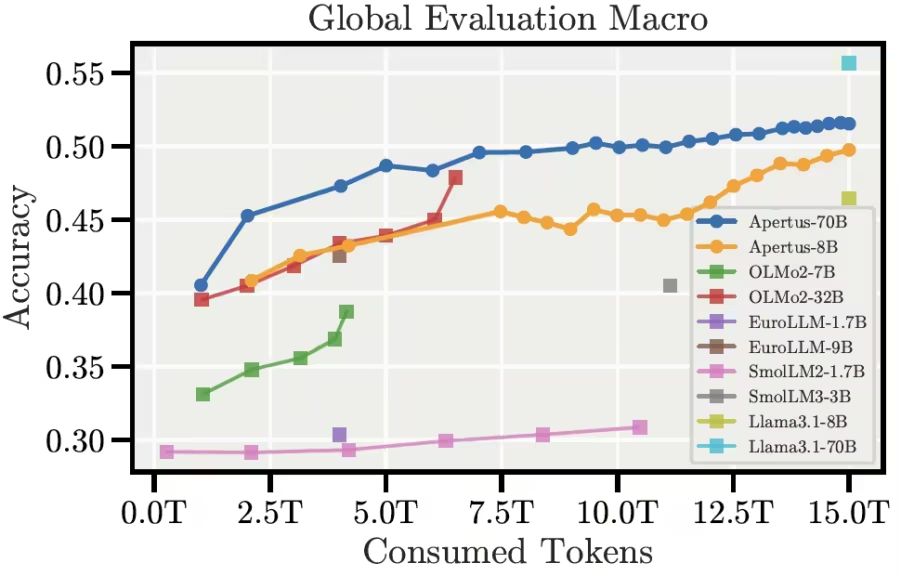

8. swiss-ai/Apertus-8B-Instruct-2509 : la transparence suisse au service de l’IA

Lancé par le Swiss National AI Institute (SNAI), Apertus-8B-Instruct-2509 symbolise une approche différente de l’IA : l’ouverture et la transparence totale. Contrairement à de nombreux modèles fermés, Apertus fournit :

- Les poids open source.

- Les recettes complètes d’entraînement.

- Un jeu de données construit dans le respect des opt-out et des réglementations européennes.

Avec 8 milliards de paramètres, ce modèle multilingue supporte plus de 1 800 langues, une première dans le domaine. Les benchmarks montrent qu’il rivalise avec LLaMA 3.1 et Qwen 2.5, tout en garantissant une approche éthique et responsable.

Les cas d’usage incluent :

- L’enseignement et la recherche académique.

- Les projets open source nécessitant une transparence totale.

- Les institutions cherchant à déployer l’IA dans le respect de l’AI Act européen.

Sa montée en popularité sur Hugging Face en septembre 2025 illustre un besoin croissant de confiance et de contrôle dans l’IA générative.

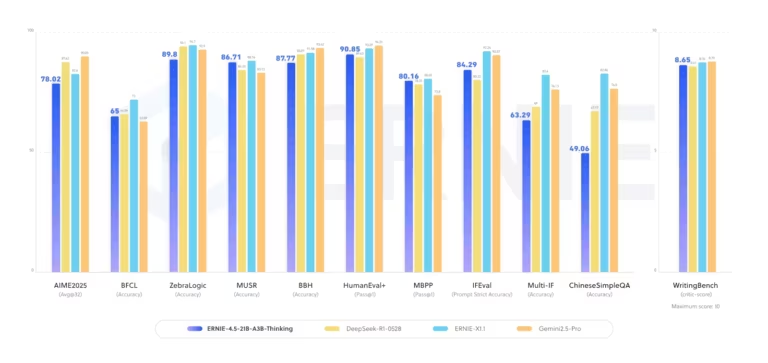

9. baidu/ERNIE-4.5-21B-A3B-Thinking : la puissance du raisonnement complexe

Baidu poursuit son avancée avec ERNIE-4.5-21B-A3B-Thinking, un modèle Mixture-of-Experts conçu pour le raisonnement intensif. Avec 21 milliards de paramètres (dont 3B activés) et une capacité de contexte étendue à 128k tokens, il se positionne comme un concurrent direct de DeepSeek et OpenAI.

Ses points forts :

- Excellentes performances sur les tâches de raisonnement logique, mathématique et scientifique.

- Fonction tool calling intégrée pour l’usage en agents IA.

- Support natif pour FastDeploy et vLLM, ce qui facilite son déploiement dans des environnements de production.

Comme l’indique Baidu dans sa documentation, ce modèle est pensé pour les cas où la qualité du raisonnement prime sur la rapidité brute. Cela explique son adoption dans des contextes variés : éducation, recherche avancée, conseil stratégique et même assistance scientifique.

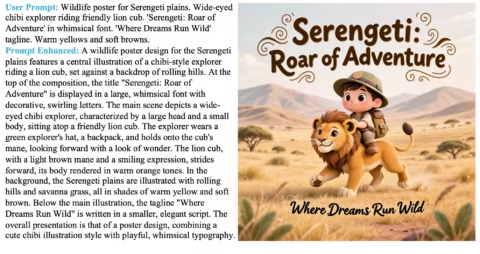

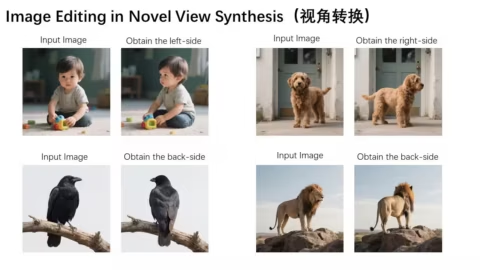

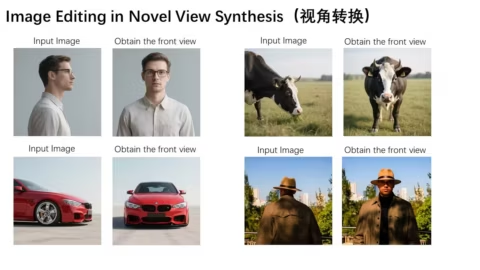

10. Qwen/Qwen-Image-Edit : l’édition d’images de nouvelle génération

Pour clôturer ce classement, impossible d’ignorer Qwen/Qwen-Image-Edit, un modèle spécialisé dans l’édition d’images. Issu de Qwen-Image (20B paramètres), il apporte des innovations uniques en matière d’édition d’image.

Parmi ses atouts :

- Précision dans l’édition de texte dans les images, y compris en chinois et en anglais.

- Modifications d’apparence (ajout ou suppression d’objets, retouche de détails visuels).

- Transformations sémantiques (rotation d’objets, style transfer, création IP).

Comme le montrent les démonstrations officielles de Qwen, il est possible de passer d’un simple poster à une version corrigée, traduite ou stylisée en quelques secondes. Ses applications sont immenses : publicité, design graphique, création de contenus multimédias.

Son succès sur Hugging Face en septembre 2025 reflète une tendance plus large : l’IA ne se contente plus de générer, elle édite et améliore l’existant, ouvrant la voie à des workflows créatifs entièrement assistés par IA. Pour ce type de modèle et un accessibilité simplifiée, je vous conseille de les utiliser via ComfyUI.

Ce que révèlent ces modèles sur l’avenir de l’IA

En observant ce classement des 10 modèles IA les plus populaires sur Hugging Face en septembre 2025, une tendance forte se dessine : l’intelligence artificielle devient de plus en plus multimodale et spécialisée. Là où les premiers LLM se concentraient uniquement sur le texte, les modèles actuels couvrent désormais un spectre élargi :

- Texte : LLM de nouvelle génération (Kimi-K2, MiniCPM4.1, ERNIE).

- Image : génération et édition d’images 2K (HunyuanImage-2.1, Qwen-Image-Edit).

- Vidéo : création de séquences 3D cohérentes (HunyuanWorld-Voyager).

- Audio : voix expressives et naturelles (VibeVoice-1.5B).

- Traduction : modèles multilingues performants (Hunyuan-MT-7B).

- Embedding : recherche sémantique et classification (EmbeddingGemma).

Autrement dit, l’IA ne se contente plus de produire du texte, elle sait aussi parler, voir, entendre et créer des mondes interactifs. Cela annonce un futur où les agents IA multimodaux pourront naviguer entre plusieurs types de modèles spécialisés et différents médias avec fluidité.

Cette diversité reflète aussi la compétition entre géants de la tech (Google, Microsoft, Tencent, Baidu, Alibaba) et initiatives open source (OpenBMB, Swiss AI). Les premiers misent sur la puissance brute, la polyvalence et la performance, les seconds sur l’ouverture, la spécialité, l’efficacité et la transparence.

Opportunités et limites pour chercheurs et entreprises

Ces modèles tendances offrent de nombreuses opportunités :

- Accessibilité accrue : certains modèles comme MiniCPM4.1 ou EmbeddingGemma sont conçus pour tourner sur des PC classiques, ouvrant l’IA avancée au plus grand nombre.

- Performances inédites : ERNIE-4.5 ou Kimi-K2 démontrent que le raisonnement complexe est désormais accessible via des modèles open source.

- Innovation créative : Qwen-Image-Edit et HunyuanImage-2.1 élargissent les possibilités de création graphique et artistique.

Mais il existe aussi des limites :

- Consommation en ressources : certains modèles (comme HunyuanImage-2.1 ou ERNIE-4.5) nécessitent des GPU haut de gamme (36 Go à 80 Go de VRAM).

- Risques d’abus : VibeVoice pose la question des deepfakes vocaux, Qwen-Image-Edit celle des manipulations visuelles.

- Encadrement réglementaire : avec l’entrée en vigueur progressive de l’AI Act européen, l’usage de ces modèles devra respecter de nouvelles obligations de transparence et de sécurité.

Ainsi, si ces modèles représentent le futur de l’IA open source, ils exigent également une approche responsable et réfléchie, aussi bien pour les chercheurs que pour les entreprises qui souhaitent les intégrer dans leurs solutions.

FAQ – Trending AI Models on Hugging Face in September 2025

Quels sont les modèles les plus téléchargés sur Hugging Face en 2025 ?

En septembre 2025, les modèles les plus téléchargés incluent EmbeddingGemma de Google, HunyuanImage-2.1 de Tencent et VibeVoice de Microsoft, chacun dans une catégorie différente (embedding, image, audio).

Quelle est la différence entre un LLM, un modèle TTS et un modèle de diffusion ?

Un LLM (Large Language Model) génère ou comprend du texte. Un modèle TTS (Text-to-Speech) transforme du texte en voix. Un modèle de diffusion génère des images ou vidéos à partir de bruit aléatoire guidé par un prompt textuel.

Comment utiliser gratuitement les modèles Hugging Face ?

La plupart sont accessibles via l’API Hugging Face ou téléchargeables en local. Certains nécessitent des GPU puissants, mais des versions quantifiées permettent une utilisation sur PC.

Quels modèles IA sont les mieux adaptés pour le code et le développement ?

Le modèle Kimi-K2-Instruct-0905 de Moonshot AI et MiniCPM4.1-8B d’OpenBMB sont actuellement les plus performants pour le développement logiciel et le reasoning long contexte.

Quels modèles d’image sont les plus performants actuellement ?

HunyuanImage-2.1 (génération 2K) et Qwen-Image-Edit (édition et transformation) dominent la catégorie image generation et image editing.

Peut-on déployer ces modèles en local sur un PC classique ?

Oui, mais uniquement les plus légers comme EmbeddingGemma (300M paramètres) ou MiniCPM4.1 (8B paramètres optimisés). Les modèles massifs comme ERNIE-4.5 (21B) nécessitent du matériel professionnel.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !