TPU Trillium v6e vs v5e et v5p, les gains de performances expliqués simplement

Le TPU Trillium, aussi appelé TPU v6e, représente l’une des avancées matérielles les plus marquantes de Google dans le domaine de l’IA. Cette nouvelle génération d’accélérateur divise par quatre le temps d’entraînement d’un modèle comme Llama 2 70B, multiplie presque par trois la vitesse d’inférence et accélère nettement les modèles de diffusion comme SDXL. Dans un contexte où chaque gain de performance compte, Trillium rebat les cartes face au v5e et au v5p..

Cet article vous présente les différences réelles entre ces trois générations, les innovations techniques qui expliquent ces écarts de performance et les cas d’usage où chaque TPU se montre le plus efficace. Et pour comprendre plus largement ce qu’est un TPU et en quoi il se distingue d’un GPU, vous pouvez consulter notre guide dédié : Google TPU Trillium : c’est quoi cette puce IA et en quoi diffère-t-elle d’un GPU ?

Résumé rapide, les gains concrets du TPU Trillium v6e

Le TPU v6e introduit des améliorations visibles dès les premières utilisations, que ce soit en entraînement, en inférence ou en génération d’images. Cette première section permet de comprendre rapidement les bénéfices essentiels de Trillium avant d’entrer dans les aspects techniques.

Les chiffres clés, compute, mémoire et bande passante

Trillium intègre une nouvelle génération d’unités matricielles MXU, passant d’un carrelage 128 × 128 à 256 × 256. Cette évolution permet d’augmenter la densité des multiplications matricielles, au cœur des modèles transformer. Comme l’indique Google Cloud dans son annonce officielle du TPU v6e, cette génération apporte également 32 Go de mémoire HBM3 par puce ainsi qu’une bande passante doublée (présentation Google Cloud).

Benchmarks rapides, LLM, inférence et modèles de diffusion

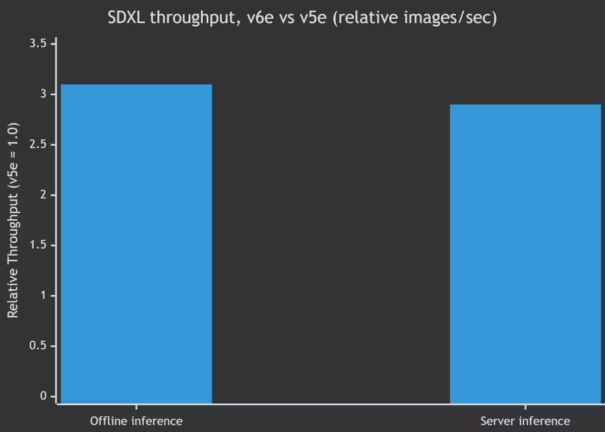

D’après les résultats publiés par Google Cloud dans ses benchmarks MLPerf, le v6e divise par quatre le step time de modèles comme Llama 2 70B, grâce à une meilleure utilisation du compute et à une mémoire plus rapide (analyse MLPerf Google Cloud). Les mises à jour AI Hypercomputer publiées par Google Cloud indiquent également que le v6e peut multiplier par près de trois la vitesse d’inférence sur Llama 2 70B grâce à JetStream et Pathways (mise à jour AI Hypercomputer). Les modèles de diffusion montrent les mêmes tendances : le throughput SDXL est triplé en mode offline et proche de ce facteur en mode serveur.

Tableau comparatif, TPU v5e vs v5p vs v6e

Ce tableau synthétise les différences principales entre compute, mémoire, bande passante et cas d’usage. Les informations proviennent de la documentation technique officielle des TPU v5e, v5p et v6e (documentation TPU v6e).

Synthèse des différences techniques essentielles

Le v5e offre un bon rapport coût performance pour des projets modestes. Le v5p cible les modèles massifs nécessitant une mémoire et une bande passante élevées. Le v6e combine les deux approches, avec un compute plus dense, une HBM3 plus rapide et un réseau interpuce optimisé pour les charges modernes.

| Spécification | TPU v5e | TPU v5p (Données estimées) | TPU v6e (Trillium) |

|---|---|---|---|

| Puissance de calcul par puce (BF16) | ~197 TFLOPS | ~459 TFLOPS* | ~918 TFLOPS |

| Capacité HBM par puce | 16 Go | ~95 Go* | 32 Go |

| Bande passante HBM | ~800 Go/s | ~2765 Go/s* | ~1600 Go/s |

| Bande passante interconnexion inter-puces | ~1600 Gbit/s | ~4800 Gbit/s* | ~3200 Gbit/s |

| Taille typique d’un pod (puces) | 256 | jusqu’à 8960 puces* | 256 |

| Puissance BF16 approximative par pod | ~50,6 PFLOPS | ~1,77 EFLOPS* (estimation extrapolée) | ~234,9 PFLOPS |

| Efficacité énergétique | référence | bande passante élevée, consommation supérieure* | perf/W amélioré (déclarations publiques GA) |

| Performance / coût (relatif) | économique | segment premium* | gain de 1,8× à 2,5× en perf/$ (workloads typiques) |

Quels workloads pour chaque génération

Le v5e est adapté aux prototypes et aux charges légères. Le v5p excelle sur les architectures bandwidth first ou les très grands modèles. Le v6e s’impose comme le choix le plus polyvalent pour l’entraînement LLM, l’inférence à grande capacité, les applications long context et les modèles de diffusion avancés.

Pourquoi le v6e est plus rapide, les innovations clés

Trillium ne se limite pas à une augmentation brute de FLOPs, il introduit des améliorations structurelles majeures qui optimisent l’exécution des modèles modernes.

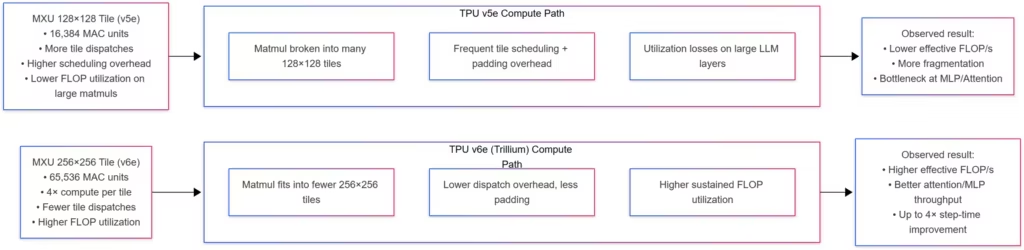

MXU 256×256, meilleure utilisation du compute

Avec un carrelage 256 × 256, les unités MXU de Trillium augmentent la densité des multiplications matricielles, réduisent la fragmentation et améliorent l’efficacité dans les couches feed forward et attention des architectures transformer.

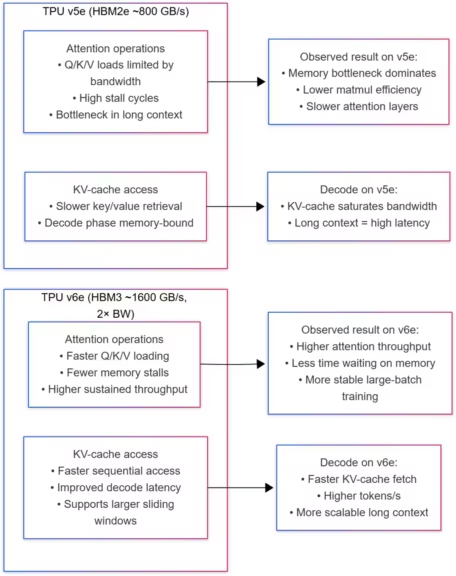

HBM3, moins de stalls dans l’attention et le KV cache

La bande passante HBM3 doublée réduit les stalls liés aux accès Q, K, V et au KV cache, particulièrement dans les modèles long context. La documentation TPU v6e détaille les gains obtenus grâce à cette amélioration mémoire.

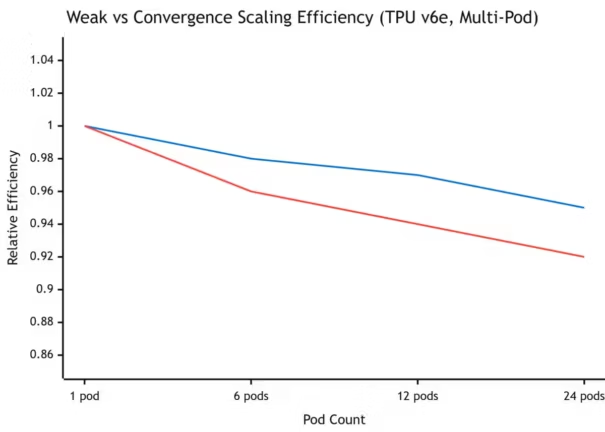

Interconnect et all reduce, stabilité multi pod

Les entraînements distribués reposent largement sur l’efficacité des opérations collectives. Selon les mises à jour AI Hypercomputer publiées par Google Cloud, Trillium améliore nettement la stabilité du scaling multi pod, avec une efficacité comprise entre 94 et 99 pour cent (AI Hypercomputer).

Entraînement LLM, ce que change vraiment le TPU v6e

Les grands modèles de langage nécessitent une capacité de calcul élevée, une mémoire rapide et une architecture stable. Le v6e améliore ces trois dimensions et se distingue particulièrement dans les LLM modernes.

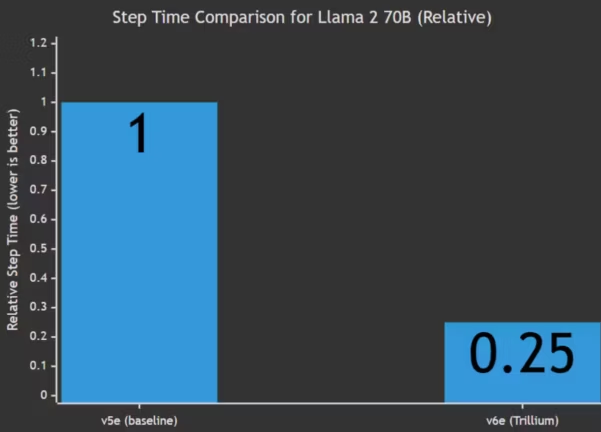

Step time divisé par quatre avec Llama 2 et Llama 3

Comme le montrent les benchmarks MLPerf publiés par Google Cloud, le v6e divise par quatre le step time d’un modèle comme Llama 2 70B grâce à son compute plus dense, à la HBM3 et à une interconnexion optimisée (analyse MLPerf Google Cloud).

MoE, moins de déséquilibres et scaling plus stable

Les architectures MoE souffrent souvent de déséquilibres dans la répartition des experts. Les optimisations matérielles du v6e et l’amélioration du routage expert stabilisent le scaling, notamment sur les configurations multi pod.

Impact sur le coût total d’entraînement

Grâce à la réduction du step time et à une meilleure efficacité de scaling, le v6e réduit le coût global d’entraînement et améliore la performance par dollar. Ces gains facilitent la planification budgétaire, comme le souligne Google Cloud dans ses analyses de coûts liées à Trillium.

Inférence LLM, JetStream et Pathways

L’inférence dépend d’un équilibre entre compute, scheduling, batching et gestion de contexte. Les améliorations du v6e, combinées à JetStream et Pathways, accélèrent sensiblement la génération de texte.

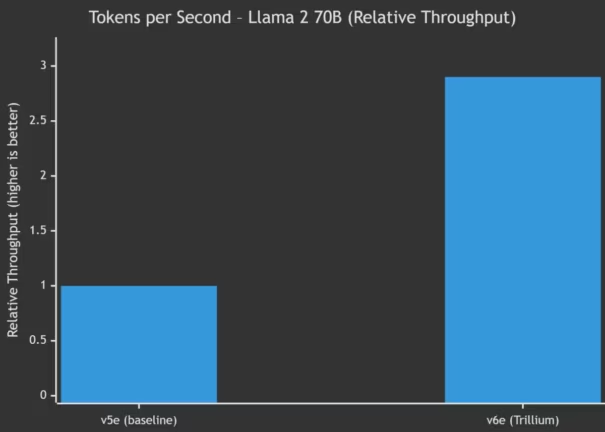

Tokens par seconde multipliés par 2,8 à 2,9

Comme le rapportent les mises à jour AI Hypercomputer, le v6e peut augmenter par près de trois la vitesse d’inférence sur Llama 2 70B grâce au batching continu de JetStream et aux optimisations de Pathways.

Latence, prefill plus rapide et decode accéléré

Pathways optimise la répartition des opérations entre prefill et decode. Selon les indications de Google Cloud, cette séparation permet d’accélérer le prefill jusqu’à un facteur sept et le decode jusqu’à un facteur trois, améliorant la réactivité dans les applications interactives.

Long context, KV cache et batching continu

La HBM3 accélère les accès au KV cache, un élément essentiel dans les modèles long context. JetStream optimise également le batching continu, stabilisant les performances même en cas de forte concurrence.

Modèles de diffusion, SDXL et Flux

Les modèles de diffusion reposent sur des pipelines lourds mêlant compute et mémoire. Trillium améliore sensiblemenrt leur débit.

Throughput SDXL multiplié par trois en mode offline

Les benchmarks MLPerf relayés par Google Cloud montrent que Trillium peut tripler le throughput SDXL en mode offline et offrir des gains comparables en mode serveur. Ces performances reflètent l’équilibre entre compute, mémoire et interconnexion de la génération v6e.

MaxDiffusion, un pipeline optimisé pour le v6e

MaxDiffusion exploite les caractéristiques propres aux TPU, notamment en matière de gestion des dépendances et de scheduling. Les charges SDXL ou Flux exécutées via MaxDiffusion bénéficient pleinement des améliorations matérielles du v6e.

Quel TPU choisir, v5e, v5p ou v6e ?

Le choix d’un TPU dépend du type de modèle, de la taille des charges et du budget disponible. Les trois générations présentent chacune des avantages spécifiques. Cette section aide à déterminer rapidement laquelle correspond le mieux à vos workloads IA.

Petits projets ou budgets serrés, v5e

Le v5e demeure une solution efficace pour les projets légers, les essais de modèles ou les charges modestes. Son coût plus faible en fait une option privilégiée pour les phases de prototypage ou les applications ne nécessitant pas de mémoire importante ni de très forte bande passante. Il reste largement suffisant pour de petites expérimentations LLM ou pour des microservices IA peu exigeants.

Modèles très larges ou pipelines bandwidth first, v5p

Le v5p se distingue par une bande passante et une mémoire supérieures. Il se prête mieux aux modèles extrêmement volumineux ou aux pipelines nécessitant des échanges interpuces intenses. Dans les environnements où la performance dépend principalement de la capacité mémoire ou du débit de communication entre puces, le v5p garantit une meilleure stabilité. Les descriptions de Google Cloud sur les TPU v5p montrent que ces configurations sont optimisées pour les très grands modèles distribués et les workloads fortement parallélisés.

Workloads modernes, LLM, diffusion et long context, v6e

Le v6e s’impose comme le choix le plus polyvalent. Il offre un excellent ratio performance par dollar, une exploitation plus dense du compute et une mémoire HBM3 nettement plus rapide. Comme le montrent les analyses de Google Cloud dans leurs publications sur Trillium, le v6e surpasse les générations précédentes dans les LLM récents, l’inférence haute capacité, les scénarios long context, et les pipelines de diffusion comme SDXL ou Flux.

Limites du v6e, quand le TPU Trillium n’est pas idéal

Le v6e représente une avancée significative, mais certaines contraintes peuvent influencer le choix selon vos besoins en IA. La connaissance de ces limites permet de décider en toute clarté entre v5e, v5p et v6e.

Mémoire par chip inférieure à certains GPU

Le v6e dispose de 32 Go de HBM3 par puce, ce qui reste inférieur à la mémoire de certains GPU haut de gamme récents. Pour les modèles nécessitant une très grande quantité de mémoire locale ou d’importants stockages intermédiaires, cette limite peut imposer de recourir à du sharding plus agressif ou à des stratégies d’optimisation. Dans ces situations, certains GPU peuvent offrir une plus grande flexibilité.

Disponibilité régionale et tuning nécessaire

Comme l’indique Google Cloud dans ses mises à jour d’infrastructure, la disponibilité du v6e dépend des régions et des capacités installées dans les datacenters. Certaines régions ne proposent que des ressources limitées ou un accès restreint aux clusters multi pod. Le v6e nécessite également un tuning spécifique, en particulier pour exploiter pleinement les optimisations des frameworks JAX et PyTorch XLA. La migration depuis des GPU peut demander des ajustements supplémentaires, notamment dans la gestion des batchs, du KV cache et des opérations collectives.

Perspective 2025, le futur des TPU et de l’écosystème IA

L’évolution de l’écosystème TPU reflète une stratégie plus large de Google, mêlant co conception matériel logiciel, optimisation progressive des frameworks et amélioration continue de la disponibilité des ressources. Les tendances observées en 2025 laissent entrevoir un environnement en pleine consolidation.

Optimisations XLA, Pathways et MaxDiffusion

Les outils logiciels jouent un rôle déterminant dans les performances des TPU. Les mises à jour récentes de XLA améliorent la stabilité et la capacité d’optimisation des graphes. Pathways optimise le scheduling et la gestion des ressources pour les workloads interactifs. MaxDiffusion continue de raffiner les pipelines dédiés aux modèles de diffusion. Google Cloud souligne régulièrement dans ses communications techniques que ces outils évoluent en parallèle du matériel afin d’exploiter pleinement les améliorations introduites par Trillium.

Positionnement face aux futurs GPU et TPU

Le v6e occupe une position solide dans l’écosystème IA actuel, offrant un équilibre entre compute, mémoire, interconnexion et efficacité logicielle. Les futures générations de GPU et TPU apporteront sans doute des gains supplémentaires, notamment en bande passante et en densité de calcul, mais Trillium reste à ce jour une plateforme centrale pour les workloads IA modernes. Les avancées conjointes en matériel et logiciel renforceront son rôle dans les projets nécessitant une forte capacité d’entraînement ou d’inférence.

À retenir

Le TPU Trillium v6e offre des gains tangibles dans l’entraînement LLM, l’inférence et la génération d’images, tout en proposant un ratio performance par dollar supérieur aux générations précédentes. Ses avancées matérielles, associées à des outils logiciels comme XLA, JetStream, Pathways et MaxDiffusion, en font une solution particulièrement adaptée aux workloads IA modernes.

Il existe toutefois des limites à considérer, notamment la mémoire par puce et la disponibilité régionale. Ces éléments doivent être pris en compte dans la planification d’infrastructures IA, en particulier lorsque les modèles sont très volumineux ou nécessitent une mémoire locale importante.

Avec l’arrivée continue de nouvelles optimisations logicielles et la montée en puissance des architectures spécialisées, le v6e devrait rester en 2025 une plateforme clé pour les modèles avancés, tout en préparant le terrain pour les futures générations d’accélérateurs IA. Pour une analyse plus technique et détaillée des différences entre le TPU v6e, le v5e et le v5p, vous pouvez consulter la version approfondie de cet article sur Cosmo Edge.

Pour approfondir ces questions d’efficacité mémoire, notre article sur la compression DFloat11 propose un éclairage complémentaire.

Sources et références

Entreprises

- Présentation officielle du TPU Trillium par Google Cloud, détaillant compute, mémoire et interconnexion https://cloud.google.com/blog/products/compute/introducing-trillium-6th-gen-tpus

- Analyse par Google Cloud des performances MLPerf du TPU v6e https://cloud.google.com/blog/products/compute/trillium-mlperf-41-training-benchmarks

- Mise à jour AI Hypercomputer de Google Cloud, incluant JetStream et Pathways https://cloud.google.com/blog/products/compute/ai-hypercomputer-inference-updates-for-google-cloud-tpu-and-gpu

Institutions

- Informations officielles sur MLPerf publiées par MLCommons https://mlcommons.org/en/

Sources officielles

- Documentation Google Cloud TPU v6e https://cloud.google.com/tpu/docs/v6e

- Documentation Google Cloud TPU v5e https://cloud.google.com/tpu/docs/v5e

- Documentation Google Cloud TPU v5p https://cloud.google.com/tpu/docs/v5p

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !