Comprendre les hallucinations en intelligence artificielle (IA)

L’intelligence artificielle est désormais omniprésente dans nos vies, que ce soit à travers les chatbots, les moteurs de recherche intelligents ou les assistants virtuels. Pourtant, ces technologies avancées ne sont pas infaillibles. Un phénomène de plus en plus préoccupant a émergé avec l’essor des modèles de langage et de l’IA générative : les hallucinations IA.

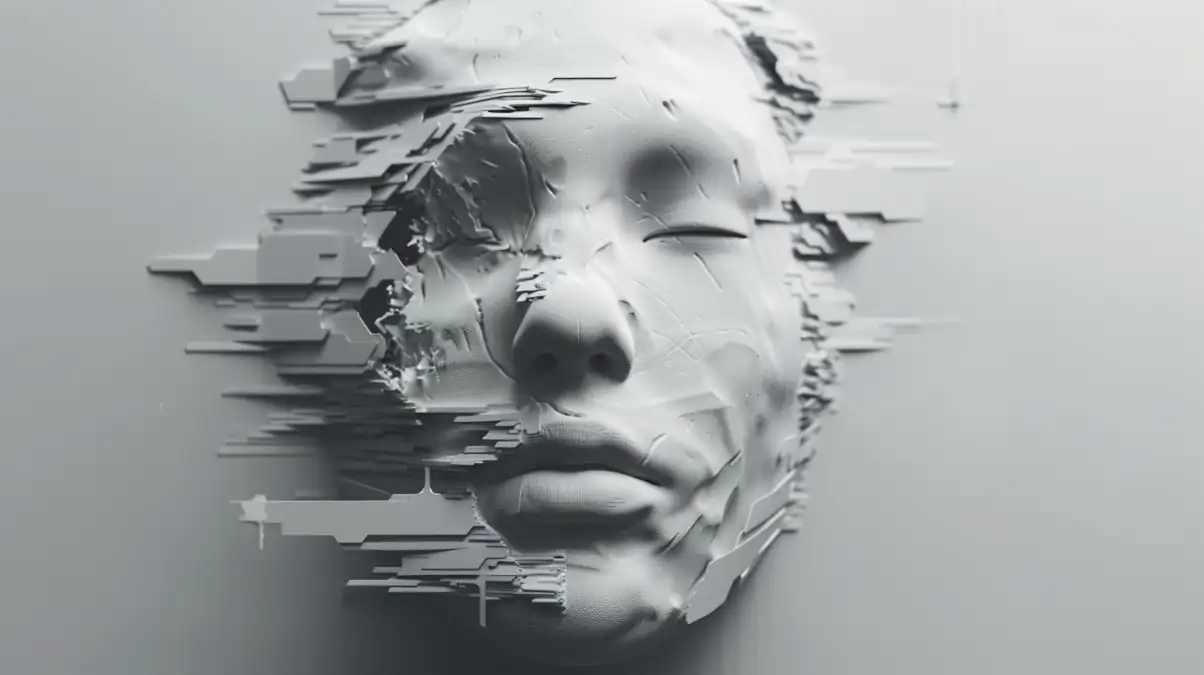

Une hallucination IA se produit lorsqu’un modèle d’intelligence artificielle génère une information incorrecte ou totalement fictive, tout en la présentant avec une grande assurance. Ce phénomène est particulièrement courant dans les LLM (Large Language Models) comme ChatGPT, Google Bard ou Gemini, qui utilisent des algorithmes de deep learning pour prédire les mots suivants dans une phrase, sans toujours vérifier leur exactitude.

Ce problème ne se limite pas au texte. Les modèles de vision par ordinateur peuvent également produire des hallucinations, en identifiant des objets qui n’existent pas dans une image. De même, les traductions automatiques peuvent parfois inventer des phrases qui ne figurent pas dans le texte original, créant ainsi une désinformation IA involontaire.

Pourquoi ces erreurs IA surviennent-elles ? Quels sont les dangers du faux contenu IA dans des domaines critiques comme la médecine, la finance ou la recherche scientifique ? Et surtout, comment limiter ces hallucinations pour rendre l’intelligence artificielle plus fiable ?

Dans cet article, nous explorerons en détail les causes, les types et les conséquences des hallucinations IA, ainsi que les stratégies mises en place par les chercheurs pour réduire ces erreurs et éviter la propagation de fausses informations générées par des modèles d’IA.

Introduction : Qu’est-ce qu’une hallucination en IA ?

L’intelligence artificielle (IA) évolue rapidement et s’intègre de plus en plus dans notre quotidien. Cependant, ces IA ne sont pas infaillibles et peuvent parfois générer des informations incorrectes ou trompeuses : c’est ce que l’on appelle une hallucination IA.

Contrairement à une simple erreur informatique, une hallucination IA ne résulte pas d’un bug ou d’un problème de programmation, mais plutôt du mode de fonctionnement des modèles d’apprentissage automatique. Ceux-ci se basent sur des probabilités linguistiques pour générer leurs réponses, sans toujours vérifier la véracité des informations produites.

L’impact des hallucinations IA peut être significatif. Cet article explore en détail les causes des hallucinations IA, leurs conséquences et les solutions envisagées pour réduire ce phénomène.

Histoire et évolution des hallucinations IA

Origine du terme et premières observations

Le terme « hallucination IA » a été popularisé avec l’essor des modèles de langage et des IA génératives. Cependant, les premières manifestations de ce phénomène remontent aux modèles de vision par ordinateur.

Dans les années 2010, des chercheurs ont observé que certains algorithmes de reconnaissance d’images attribuaient des interprétations erronées à des formes abstraites. Par exemple, un réseau neuronal pouvait identifier un chat dans une image totalement aléatoire simplement parce que certains motifs ressemblaient statistiquement à des caractéristiques félines. A l’époque, le terme « hallucination » était uniquement un problème visuel et le terme était donc plus compréhensible.

Avec l’arrivée des modèles de langage avancés (GPT, Gemini, Mistral, DeepSeek, LLaMa, BERT, T5, etc.), ces défauts de fonctionnement sont toujours présents. Aujourd’hui, ces problèmes ne se limitent plus à des erreurs d’identification visuelle, mais englobent également des affirmations textuelles incorrectes générées avec une apparente certitude. Le terme « hallucinations IA » a ainsi été adopté pour désigner ce phénomène, car il partage des similitudes avec les erreurs d’interprétation visuelle, bien qu’il concerne ici des erreurs d’interprétation textuelle.

Comment les hallucinations IA se produisent-elles ?

Les hallucinations IA sont inhérentes au fonctionnement des modèles génératifs. Contrairement aux moteurs de recherche traditionnels, qui se basent sur des bases de données validées, une IA générative produit du texte mot après mot en fonction de probabilités statistiques.

1. Rôle des données d’entraînement et des biais

Les modèles d’intelligence artificielle sont entraînés sur d’énormes corpus de données, souvent extraits du web. Ce processus introduit plusieurs facteurs de risque :

✅ Données incomplètes ou erronées : si le modèle est formé sur des informations incorrectes, il peut les reproduire.

✅ Biais dans les sources : un modèle peut privilégier certaines perspectives au détriment d’autres, amplifiant des erreurs systémiques.

✅ Obsolescence des informations : une IA ne dispose pas d’une mise à jour instantanée des connaissances, ce qui peut entraîner la diffusion d’informations dépassées.

2. Mécanisme probabiliste des modèles génératifs

Les modèles de langage comme ChatGPT, Claude ou Mistral ne comprennent pas réellement le sens des mots. Leur fonctionnement repose sur la prédiction probabiliste : à partir d’une question donnée, l’IA génère la réponse la plus probable en se basant sur son apprentissage.

Toutefois, sans vérification externe des faits, ces réponses peuvent être entièrement fausses mais formulées de manière crédible. C’est ainsi que naissent les hallucinations IA.

3. Absence de vérification des faits

Contrairement aux humains, qui croisent des sources et appliquent une réflexion critique, une IA générative ne peut pas vérifier l’authenticité des informations qu’elle produit.

Certains modèles utilisent des liens externes pour justifier leurs réponses. Cependant, ces mécanismes restent limités et ne garantissent pas une fiabilité absolue.

Différents types d’hallucinations IA

Les hallucinations IA peuvent prendre différentes formes, en fonction du type d’erreur générée.

1. Hallucination factuelle

➡ L’IA fournit une information fausse, mais sous une apparence crédible.

Exemple :

❌ Un modèle IA affirme que « Napoléon Bonaparte a dirigé la France en 1850 », alors qu’il est mort en 1821.

Ce type d’erreur est courant lorsque l’IA extrapole des faits historiques incorrects ou invente des sources inexistantes.

2. Hallucination linguistique

➡ L’IA produit une phrase grammaticalement correcte, mais incohérente en termes de sens.

Exemple :

❌ « Le soleil est un fruit qui pousse dans l’océan et produit des étoiles. »

Ce phénomène se produit lorsqu’un modèle combine des concepts sans établir un lien logique correct entre eux.

3. Hallucination interprétative

➡ L’IA comprend mal une question et répond de manière inappropriée.

Exemple :

❌ Un chatbot médical à qui l’on demande « Quels sont les symptômes d’un AVC ? » pourrait répondre en listant des symptômes d’une crise d’épilepsie, s’il a mal interprété la question.

Cette erreur provient de la mauvaise catégorisation des informations dans la base d’apprentissage.

4. Cas spécifiques : reconnaissance d’images et traduction automatique

Les hallucinations IA ne se limitent pas au texte. Elles existent aussi en vision par ordinateur et en traduction automatique.

📸 Vision par ordinateur :

Un modèle de reconnaissance d’images peut voir un visage humain dans une texture aléatoire ou identifier une voiture là où il n’y en a pas.

🌍 Traduction automatique :

Même si la traduction par IA a fait d’énorme progrès, elles peuvent parfois inventer des parties de texte inexistantes lorsqu’ils traduisent des langues rares.

Exemples concrets d’hallucinations en IA

Les hallucinations IA se manifestent dans de nombreux outils du quotidien. Voici quelques exemples notoires :

1️⃣ ChatGPT (OpenAI)

➡ En 2023, certains utilisateurs ont signalé que ChatGPT inventait des références scientifiques inexistantes, en générant des citations totalement fictives.

2️⃣ Google Bard

➡ Lors de sa première démonstration, Google Bard a fourni une fausse information sur le télescope spatial James Webb, ce qui a fait chuter l’action de Google en bourse.

3️⃣ IBM Watson

➡ IBM Watson, utilisé dans le domaine médical, a parfois généré des recommandations médicalement incorrectes, entraînant des inquiétudes sur son adoption en milieu hospitalier.

Pourquoi les hallucinations IA posent un problème majeur ?

L’impact des hallucinations IA dépasse la simple production d’erreurs anecdotiques. Lorsque ces erreurs sont générées dans des contextes critiques, elles peuvent avoir des conséquences importantes sur la désinformation, la confiance du public et même la sécurité des utilisateurs.

1. Risques pour l’information et la désinformation

L’un des plus grands dangers des hallucinations IA est leur rôle dans la désinformation numérique. Contrairement aux moteurs de recherche classiques qui renvoient des résultats vérifiables, une IA générative peut inventer des faits et les présenter comme des vérités absolues.

🚨 Exemples de désinformation générée par IA :

- Un chatbot juridique pourrait donner une mauvaise interprétation de la loi, poussant un utilisateur à prendre une décision erronée.

- Une IA d’information médicale pourrait recommander un traitement dangereux en se basant sur des données incorrectes.

- Dans le domaine académique, des étudiants ou chercheurs pourraient se baser sur des sources fictives générées par IA.

2. Impact sur la confiance et l’adoption de l’IA

Si les IA continuent à générer des hallucinations, le grand public et les entreprises risquent de perdre confiance en ces outils. Déjà, de nombreuses entreprises ont interdit l’usage des IA générative, en particulier le très populaire ChatGPT, pour éviter des erreurs dans des secteurs sensibles comme la finance et la médecine.

💡 Exemple : Certaines universités ont interdit l’utilisation des IA génératives pour la rédaction académique en raison des hallucinations factuelles fréquentes.

3. Dangers dans les secteurs sensibles

Dans des secteurs où la précision est essentielle, comme la médecine ou la justice, une hallucination IA peut avoir des conséquences graves.

⚠ Exemple critique : Un chatbot médical qui confond les effets secondaires bénins avec des symptômes d’une maladie grave pourrait induire un patient en erreur et provoquer un retard de diagnostic.

Peut-on empêcher les hallucinations IA ?

Même si les hallucinations IA sont un problème structurel des modèles actuels, des solutions existent pour réduire leur fréquence et leur impact.

1. Utilisation de données filtrées et vérifiées

L’une des causes majeures des hallucinations IA est la présence de données biaisées ou erronées dans les bases d’apprentissage. Certains chercheurs travaillent donc sur :

✅ Des datasets mieux filtrés : limiter l’apprentissage aux sources fiables.

✅ Un entraînement avec supervision humaine : identifier les erreurs dès le processus de formation.

✅ Un ajustement en continu des modèles pour éviter l’obsolescence des informations.

📌 Exemple : Gemini et ChatGPT ont été mis à jour pour donner plus souvent des réponses prudentes et signaler quand une information pourrait être incertaine.

2. Ajout de mécanismes de vérification externe des faits

Une IA générative ne possède pas généralement pas de connexion native à des bases de données validées et spécialisées. C’est pourquoi certains chercheurs développent des systèmes hybrides, où l’IA vérifie ses réponses avec des sources externes et fiables.

3. Rôle de l’apprentissage par renforcement avec feedback humain (RLHF)

L’une des stratégies les plus prometteuses est l’apprentissage par renforcement avec retour humain (RLHF). Ce processus permet d’entraîner une IA en lui faisant corriger ses propres erreurs grâce à des évaluations humaines.

🔍 Comment ça fonctionne ?

- L’IA génère une réponse.

- Un humain l’évalue et corrige si nécessaire.

- Le modèle ajuste son apprentissage en fonction des corrections apportées.

📌 Exemple : OpenAI utilise le RLHF pour améliorer la fiabilité de ses modèles comme GPT-4.

Stratégies et solutions pour limiter les hallucinations IA

Pour minimiser les risques d’hallucinations, plusieurs approches sont combinées :

1. Développement de modèles hybrides combinant IA et supervision humaine

Les entreprises développent de plus en plus des modèles d’IA intégrant une vérification par des experts humains afin d’améliorer la précision et la fiabilité. Cette approche garantit que les réponses générées par l’IA sont examinées par des professionnels qualifiés avant d’être présentées, en particulier dans des domaines critiques comme la santé.

IBM Watson en médecine

IBM Watson Health s’est associé à EBSCO Information Services pour créer des outils de support à la décision clinique intégrés. Ces outils combinent IBM Micromedex, une base de données complète sur les médicaments, avec DynaMed, une ressource clinique évaluée par des pairs. Cette intégration permet aux cliniciens d’accéder à des recommandations diagnostiques et thérapeutiques basées sur les dernières preuves scientifiques, afin de réduire les erreurs et d’améliorer les soins aux patients.

🔗 newsroom.ibm.com

StarGPT par Starmind

Starmind a lancé StarGPT, une plateforme d’IA générative conçue pour les entreprises, intégrant une vérification instantanée par des experts humains. Ce système permet aux entreprises d’utiliser un modèle de langage privé avec un suivi humain immédiat, facilitant une prise de décision plus rapide et plus éclairée tout en optimisant les processus critiques.

🔗 starmind.ai

Les systèmes « Human-in-the-Loop »

L’intégration de l’expertise humaine dans les systèmes d’IA, appelée « Human-in-the-Loop », associe le jugement humain aux capacités de l’IA pour améliorer la précision, l’efficacité et la sécurité de l’apprentissage automatique. Cette approche collaborative garantit que les résultats de l’IA sont continuellement surveillés et ajustés par des experts, rendant les applications d’IA plus fiables et robustes.

🔗 basic.ai

L’intégration d’une vérification humaine dans les modèles d’IA devient une tendance majeure, en particulier dans les secteurs où la précision est cruciale. En combinant l’efficacité de l’IA avec une supervision humaine, les organisations cherchent à minimiser les erreurs et à améliorer la fiabilité des réponses générées.

2. Amélioration des architectures neuronales

Les chercheurs travaillent sur de nouvelles architectures pour rendre l’IA plus fiable. Certaines pistes explorées incluent :

✔ L’intégration d’une mémoire à long terme pour éviter que l’IA ne génère des réponses incohérentes dans une même conversation.

✔ Des modèles combinant IA générative et IA symbolique, qui utilisent des règles logiques pour vérifier la validité des réponses.

📌 Exemple : Meta AI explore des modèles IA hybrides pour améliorer la cohérence des réponses.

L’avenir des hallucinations en IA : vers une intelligence artificielle plus fiable ?

L’élimination totale des hallucinations IA est très difficile, car elles sont une conséquence directe du mode de fonctionnement des modèles génératifs. Cependant, avec des améliorations en cours, nous pouvons espérer :

🚀 Des modèles plus fiables grâce à des techniques de vérification des faits avancées.

🚀 Une meilleure compréhension des limites des IA par le grand public et les entreprises.

🚀 Une IA plus transparente, capable d’indiquer lorsqu’une réponse est incertaine.

Les chercheurs et grandes entreprises comme OpenAI, Google, Microsoft et IBM travaillent activement sur ces défis pour rendre l’IA plus fiable et plus sûre.

Conclusion

Les hallucinations IA représentent un défi majeur pour le développement des modèles d’intelligence artificielle. Bien que les progrès en matière de vérification et d’apprentissage supervisé permettent de réduire ces erreurs, elles restent encore inévitables dans les modèles actuels.

L’avenir des IA passera par une meilleure transparence, des outils de vérification intégrés et une compréhension plus approfondie des limites des modèles génératifs.

📢 N’oubliez pas : Toujours vérifier les faits lorsqu’on utilise une IA générative, surtout dans un contexte professionnel ou académique.

FAQ : Réponses aux questions courantes sur les hallucinations IA

Les IA génératives utilisent des modèles statistiques pour prédire les mots suivants dans une phrase, mais elles ne comprennent pas réellement ce qu’elles disent. C’est pourquoi elles peuvent générer des informations incorrectes.

Une erreur IA peut être due à un bug informatique ou à un mauvais paramétrage, tandis qu’une hallucination IA est une réponse fausse générée naturellement par le modèle, sans qu’il en ait conscience.

Oui, surtout dans des domaines critiques comme la médecine, la finance et la justice. Une information incorrecte donnée avec certitude peut induire des erreurs graves.

Il est conseillé de toujours vérifier les sources citées par l’IA et de croiser les informations avec des ressources fiables comme Wikipedia, Google Scholar ou des articles validés.

Pas encore. Toutefois, des techniques comme le filtrage des données, la supervision humaine et les modèles hybrides permettent de réduire leur fréquence.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !