Quels modèles LLM installés en local avec 8 ou 16 Go de VRAM ?

Les modèles de langage installés en local (LLM) gagnent en popularité, notamment chez les développeurs, chercheurs ou passionnés d’intelligence artificielle souhaitant garder le contrôle de leurs données et minimiser leur dépendance au cloud. Mais pour fonctionner efficacement, ces modèles ont besoin de ressources matérielles adaptées, notamment en VRAM GPU.

Dans cet article, nous vous présentons les modèles LLM optimisés pour une exécution locale sur PC avec une carte graphique Nvidia ou AMD disposant de 8 ou 16 Go de VRAM, tout en intégrant les dernières techniques de quantification et d’optimisation mémoire. Que vous ayez une RTX 4060, une RX 6800, ou une carte plus modeste, il existe des solutions adaptées à vos besoins. Si vous n’êtes pas familier avec les termes liés aux modèles de langage LLM, je vous conseille la lecture rapide de notre lexique simplifié.

LLM local avec 8 Go de VRAM : les modèles à privilégier

Installer un LLM local avec 8 Go de VRAM nécessite des modèles compacts, mais performants. Voici ceux qui offrent le meilleur compromis entre qualité et légèreté.

Mistral 7B

Le modèle Mistral 7B, réputé pour ses performances remarquables en génération de texte et en code, fonctionne de manière fluide sur des cartes graphiques avec 8 Go de mémoire vidéo. Il surpasse parfois des modèles plus lourds comme LLaMA 2 13B, tout en étant plus facile à faire tourner localement.

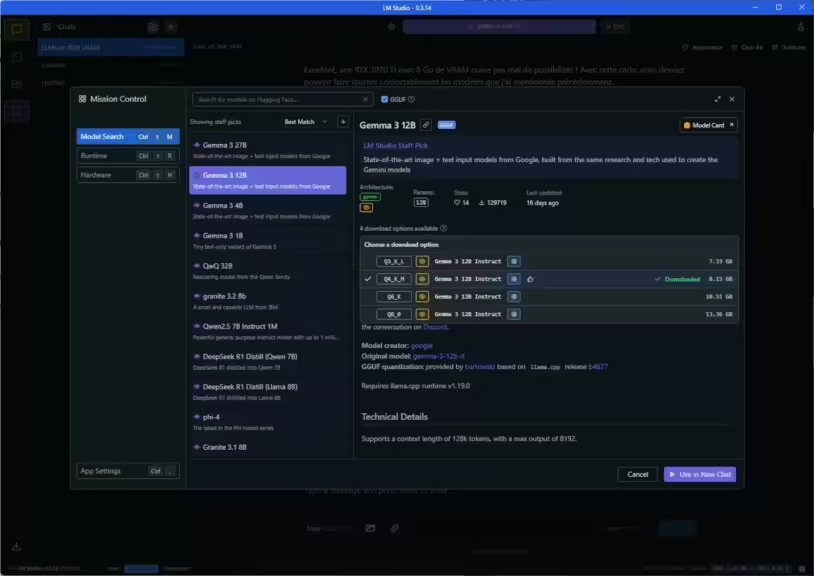

Gemma 3 12B

Le modèle Gemma 3 12B est conçu pour des tâches de génération de texte et de compréhension d’images, telles que le question-réponse, la synthèse et le raisonnement. Sa taille relativement modeste le rend adapté à une utilisation sur des machines avec des ressources limitées, y compris des ordinateurs portables et des postes de travail. Ce modèle est disponible sur des plateformes telles que Hugging Face et LM Studio , facilitant son intégration dans divers environnements de développement.

Llama 3 8B

Récemment sorti, Llama 3 8B offre une très bonne polyvalence pour les tâches de traitement du langage, y compris la génération de texte, la traduction ou les résumés automatiques. Il constitue une base solide pour un assistant IA personnel installé sur PC.

Mistral Small 3

Encore plus léger, Mistral Small 3 est taillé pour une exécution efficace sur des machines modestes. Son entraînement multilingue et ses performances en français en font un excellent choix pour les utilisateurs francophones disposant d’une carte graphique de 8 Go de VRAM.

Autres modèles compatibles 8 Go

- Phi-4 (Microsoft) : spécialisé dans la programmation et le raisonnement logique.

LLM local avec 16 Go de VRAM : plus de puissance, plus de possibilités

Avec 16 Go de VRAM, vous pouvez faire tourner des modèles plus complexes et plus performants, notamment grâce à la quantification en 4 ou 8 bits, réduisant considérablement la consommation de mémoire sans perte significative de performance.

Gemma 3 27B

Le modèle Gemma 3 27B offre des performances supérieures, rivalisant avec des modèles fermés de pointe. Il est capable de traiter des fenêtres de contexte allant jusqu’à 128 000 tokens, permettant une compréhension approfondie des informations complexes. Ce modèle est également disponible sur Hugging Face et LM Studio

DeepSeek Coder

Développé pour le développement logiciel, DeepSeek Coder est un excellent modèle si vous cherchez un assistant pour le codage, les revues de code ou la génération de scripts. Il est parfaitement adapté aux environnements avec 16 Go de mémoire graphique.

Mistral Medium

Évolution de Mistral 7B, le modèle Mistral Medium est pensé pour le raisonnement avancé, la compréhension du contexte, et les échanges complexes. Il fonctionne très bien en local sur une configuration disposant de 16 Go de VRAM, et offre une expérience quasi-équivalente à des modèles beaucoup plus lourds.

Qwen 2.5

Les modèles Qwen 2.5 sont disponibles en plusieurs tailles, notamment 0,5B, 1,5B, 3B, 7B, 14B, 32B et 72B de paramètres. Les versions plus petites, telles que le modèle 0,5B, sont idéales pour une utilisation sur des appareils mobiles, tandis que les modèles intermédiaires, comme le 7B, conviennent aux ordinateurs portables. Les modèles plus grands, tels que le 14B et le 32B, nécessitent des GPU plus puissants, comme les NVIDIA RTX 4090 ou RTX 5090, pour une exécution optimale.

LLaMA 3 8B Instruct

Ce modèle, sorti en avril 2024, propose des réponses structurées, multilingues et très pertinentes. En plus de maîtriser 6 langues, il s’adapte à des tâches variées, de la simple question-réponse à des cas plus spécialisés.

Llama 3 70B (quantifié)

Normalement destiné à des machines très puissantes, Llama 3 70B peut aujourd’hui être exécuté localement grâce à la quantification (ex. : 4 bits). Il nécessite environ 32 Go de VRAM, mais peut fonctionner partiellement ou en mode « offloading » avec 16 Go et suffisamment de RAM système.

Optimisations à connaître pour un LLM local performant

Même avec une carte de 8 ou 16 Go de VRAM, il est possible d’améliorer les performances des modèles locaux grâce à plusieurs techniques :

- Quantification : passer un modèle de FP16 à INT4 permet de diviser la consommation mémoire par 4.

- Offloading CPU/GPU : certaines parties du modèle sont exécutées sur la RAM système ou le processeur pour économiser la VRAM.

- Utilisation de llama.cpp, LM Studio ou Ollama : ces outils facilitent l’exécution locale en réduisant l’empreinte mémoire.

🔍 Astuce : pour faire tourner un modèle de 13B ou plus, 32 Go de RAM système sont fortement recommandés, même si le GPU n’a que 16 Go de VRAM.

Peut-on exécuter des modèles lourds comme Gemma 3 avec moins de 8 Go de VRAM ?

À première vue, faire tourner un LLM local comme Gemma 3 12B ou 27B semble hors de portée avec une carte graphique dotée de seulement 8 Go (ou moins) de VRAM. Pourtant, grâce aux dernières avancées logicielles, il est désormais possible d’exécuter ces modèles sur des machines bien configurées, même avec 6 Go de VRAM.

Exemple concret : RTX 3070 Ti (8 Go VRAM) + 64 Go de RAM

Sur un poste équipé d’une RTX 3070 Ti avec 8 Go de VRAM et 64 Go de mémoire système, il est possible d’exécuter Gemma 3 12B et même Gemma 3 27B en quantification 4 bits (Q4) à l’aide de LM Studio. Cette prouesse est rendue possible grâce à :

- La quantification (Q4), qui réduit drastiquement l’encombrement mémoire des modèles.

- L’offloading dynamique vers la RAM : seule une partie du modèle est traitée en VRAM, le reste étant pris en charge par la RAM système.

- Des outils comme LM Studio et llama.cpp, conçus pour tirer le meilleur parti d’un système avec peu de VRAM mais beaucoup de mémoire système.

⚠️ Cela ne veut pas dire que les performances seront équivalentes à une exécution 100 % GPU. Les temps de réponse sont plus lents, mais le modèle reste pleinement fonctionnel pour des tâches complexes.

Avec une telle configuration, Gemma 3 12B tourne de manière fluide, la vitesse de réponse (inférence) est comparable à ChatGPT via l’interface Web. En revanche, Gemma 3 27B est beaucoup plus lent, ce qui rend son utilisation plus difficile et moins pertinente.

Ce que cela change

Même avec une configuration modeste en VRAM, il est aujourd’hui possible de profiter localement de modèles très puissants comme Gemma 3. Ce constat remet en question l’idée selon laquelle 12B ou 27B seraient réservés à des GPU professionnels. L’important devient alors d’avoir beaucoup de RAM, un outil adapté comme LM Studio, et une quantification bien choisie.

Paramètres recommandés pour faire tourner un LLM lourd comme Gemma 3 avec peu de VRAM

L’exécution locale d’un modèle comme Gemma 3 12B ou 27B avec une VRAM limitée (6 ou 8 Go) repose sur une combinaison de quantification, optimisation mémoire et offloading. Voici les réglages recommandés dans LM Studio ou d’autres interfaces basées sur llama.cpp.

Configuration système conseillée

- Carte graphique : Nvidia (ex : RTX 3060, 3070 Ti, etc.) ou AMD RX équivalente

- VRAM minimale : 6 à 8 Go

- RAM système : 32 Go minimum, idéalement 64 Go ou plus

- Stockage : SSD (évite les ralentissements lors de l’offloading)

Paramètres à activer dans LM Studio

- Quantification du modèle :

→ Q4_K_M ou Q4_0 (équilibre entre qualité et performance)

→ Pour les configurations très légères : Q5 peut être envisagé si la VRAM le permet - Offloading GPU/RAM :

- Activer « GPU + RAM » (ou « Mixed » selon l’interface)

- Ne pas forcer le tout en RAM si GPU disponible

- Context length :

- Réduire si nécessaire (ex : 4096 ou 8192 tokens) pour économiser la mémoire

- GPU Layers :

- Commencer avec 20-40 layers en GPU selon le modèle, ajuster si erreur CUDA ou ralentissement

- Max memory usage :

- Sur certains outils, possibilité de spécifier un pourcentage de la RAM allouée (ex : 75 % si 64 Go disponibles)

Astuce supplémentaire

Sur Windows, pour éviter que des processus consomment de la VRAM inutilement (navigateur, Discord…), il peut être utile de :

- Fermer les applications non essentielles.

- Réserver un environnement de travail dédié à l’exécution des modèles IA.

Conclusion

Choisir un LLM local compatible avec 8 ou 16 Go de VRAM dépend de votre cas d’usage (texte, codage, assistant vocal) et de votre matériel. Les modèles comme Gemma 3 12B, Mistral 7B, Llama 3 8B, ou encore DeepSeek Coder démontrent qu’il est possible d’exécuter des IA puissantes entièrement en local, tout en gardant la main sur vos données et vos usages.

Pour vos premiers dans l’installation local de LLM, je vous conseille d’utiliser LM Studio, il a l’avantage de proposer les versions des modèles en fonction de votre configuration. Prenez le temps de vous familiariser avec l’installation et l’utilisation des LLM et montez en compétence. Ensuite, vous pourrez passer à des outils plus personnalisable, comme Ollama ou les transformers de Hugging Face. Je vous conseille de monter en compétence progressivement, ne vous lancez pas dès le début dans les outils les plus complexes.

Avant de vous lancer, pensez à vérifier les exigences en RAM, la disponibilité du modèle sous forme quantifiée, et la compatibilité avec les outils comme Ollama, LM Studio ou Text Generation WebUI.

Pour plus de détails, jetez un oeil sur notre page pour bien choisir votre LLM en fonction de vos besoins.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !