Unsloth Dynamic 4-bit vs FP16/BF16 : la quantification dynamique des LLM, une solution viable ?

Depuis l’arrivée de modèles open source comme LLaMA, Mistral, Qwen ou encore DeepSeek, la taille et la complexité des grands modèles de langage (LLMs) n’ont cessé de croître. Leur taille croissante pose un défi majeur : l’efficacité mémoire et les coûts computationnels. Exécuter un modèle compressé de plusieurs milliards de paramètres en precision (FP16 ou BF16) nécessite des GPU haut de gamme avec 48 à 80 Go de VRAM, limitant l’accès pour la plupart des développeurs.

La quantification dynamique répond à cette problématique. Alors que les premières méthodes de quantification LLM entraînaient des pertes significatives, les nouvelles approches comme GPTQ, AWQ et Unsloth Dynamic 4-bit permettent une réduction taille LLM drastique tout en préservant la précision.

Unsloth propose une quantification dynamique sur 4-bit (Unsloth Dynamic v1) innovante qui combine une optimisation de l’inference et une perte de précision minimal. Selon la documentation officielle Unsloth, cette approche sélective divise par quatre la taille des modèles tout en conservant 98-99% de la performance originale.

La question n’est plus de savoir si la compression d’un modèle IA est utile, mais quelle méthode choisir entre FP16/BF16 pour la fidélité ou la quantification pour l’accessibilité. Cet article propose une comparaison approfondie de la quantification Unsloth pa rapport au format FP16 BF16 pour identifier le meilleur choix selon vos besoins.

A lire également : Unsloth Dynamic v2.0 GGUFs : la nouvelle référence de la quantization LLM en 2025

Qu’est-ce que la quantification dans les modèles LLM ?

Pour comprendre l’intérêt de la quantification dynamique d’Unsloth face à FP16/BF16, il faut d’abord revenir sur la notion de quantification. Dans le domaine des LLMs (Large Language Models), la quantification désigne le processus qui consiste à réduire la précision numérique des poids d’un modèle. Concrètement, au lieu de stocker chaque paramètre en 16 ou 32 bits, on peut les compresser en 8 bits, 4 bits, voire 2 bits. C’est ce qui donne des noms de modèles avec l’information : K2, K4, K6, K8. Un modèle K2 aura une perte de précision plus marquée, alors que que la version K8 offrira un meilleur compromis.

L’objectif principal est double : réduire la mémoire GPU requise et accélérer la vitesse d’inférence sans sacrifier significativement la précision. Cela rend les modèles open source quantifiés accessibles sur du matériel grand public, notamment les Nvidia RTX ou même des ordinateurs portables.

La quantification agit directement sur la représentation numérique des poids et activations, optimisant les performances lors de l’inference et également lors du fine-tuning de LLM.

Exemple concret : un modèle 13B non quantifié peut nécessiter plus de 24 Go de VRAM GPU en FP16, imposant une RTX 4090/5090 ou Nvidia A100. Avec la quantification dynamique 4-bit d’Unsloth, il fonctionne sur une carte 8 Go VRAM tout en conservant des performances proches du modèle original.

Formats FP16 et BF16 : précision de référence

FP16 : standard precision réduite

Le FP16 (float16) encode chaque poids en 16 bits avec une mantisse réduite mais suffisante pour la plupart des tâches d’inference. Son avantage principal : diviser par deux la consommation de mémoire GPU comparée au FP32 classique, tout en maintenant une précision stable pour l’entraînement.

Selon Nvidia, FP16 a permis la première démocratisation des large language models (LLM) massifs. Cependant, FP16 reste coûteux en VRAM GPU pour les modèles dépassant 10 milliards de paramètres.

BF16 : stabilité numérique optimisée

Le BF16 (bfloat16) est une variante du FP16 qui modifie l’allocation des bits entre mantisse et exposant. L’idée est de garder un exposant similaire au FP32, ce qui permet une meilleure stabilité numérique, en particulier dans les phases de calcul intensif (entraînement profond, tâches de recherche scientifique, contextes très sensibles).

Comme le souligne Google Research, BF16 a été largement adopté dans l’écosystème TPU et est désormais disponible sur de nombreux GPU modernes. Dans la pratique, cela signifie moins d’erreurs d’arrondi et une plus grande robustesse sur des calculs complexes.

Limites FP16/BF16

Si ces formats garantissent une qualité maximale, leur coût en ressources reste prohibitif :

- Un DeepSeek-R1 32B en BF16 dépasse 64 Go de VRAM GPU

- L’inference optimisation locale sur RTX 5060/5070 devient impraticable

- L’edge deployment AI nécessite des serveurs équipés de cartes professionnelles

| Méthode | Sélectivité | Accuracy | VRAM utilisée |

|---|---|---|---|

| BitsAndBytes | Non | Moyenne | Faible |

| AWQ | Bloc/couche | Bonne | Moyenne |

| GPTQ | Bloc/couche | Très bonne | Moyenne |

| Unsloth Dynamic | Par couche | Excellente | Faible |

Tableau comparatif (méthodes principales)

Unsloth Dynamic 4-bit : optimisation de la quantification

C’est ici qu’intervient la quantification dynamique sur 4-bit d’Unsloth, qui propose une alternative beaucoup plus légère, tout en restant proche de la précision de FP16/BF16. Comme le montre la comparaison de LearnOpenCV, cette méthode permet de réduire de plus de moitié la taille et la mémoire utilisée, sans sacrifier de manière significative la performance des modèles sur des benchmarks comme MMLU.

La grande innovation d’Unsloth réside dans sa quantification dynamique sur 4-bit, une approche qui diffère fondamentalement des méthodes classiques. Les méthodes classiques appliquent une quantification uniforme (toutes les couches subissent la même réduction de précision), Unsloth adopte une stratégie sélective et adaptative.

| Méthode | Sélectivité | MMLU benchmark | VRAM GPU |

|---|---|---|---|

| BitsandBytes 4-bit | Non | Moyenne | Faible |

| GPTQ vs AWQ vs Unsloth – AWQ | Bloc/couche | Bonne | Moyenne |

| GPTQ vs AWQ vs Unsloth – GPTQ | Bloc/couche | Très bonne | Moyenne |

| Unsloth Dynamic 4-bit | Par couche | Excellente | Très faible |

Calibrage dynamique et sélectif

Unsloth ne réduit pas uniformément tous les poids : il analyse la sensibilité de chaque couche via des dataset de calibration puis décide lesquelles conserver en FP16 pour éviter toute perte critique. Cette approche préserve les couches essentielles au raisonnement contextuel.

Gains massifs efficacité mémoire AI

Cette méthode de quantification réduit drastiquement la taille des modèles quantifiés. Un DeepSeek-R1 14B passe d’environ 28 Go en BF16 à 14 Go en Unsloth, soit 50% d’économie (source Unsloth).

Impact direct sur la VRAM GPU requise :

- 8B → 8-10 Go VRAM

- 14B → 14-16 Go VRAM

- 32B → 32-36 Go VRAM

Cette réduction de la taille des LLM permet de faire de l’inférence sur une simple RTX 5060/5070. Avec l’augmentation en taille des LLM open source, c’est aussi une solution pour exécuter des modèles de 32B ou plus sur des postes de travail ou serveurs avec des ressources lmitées.

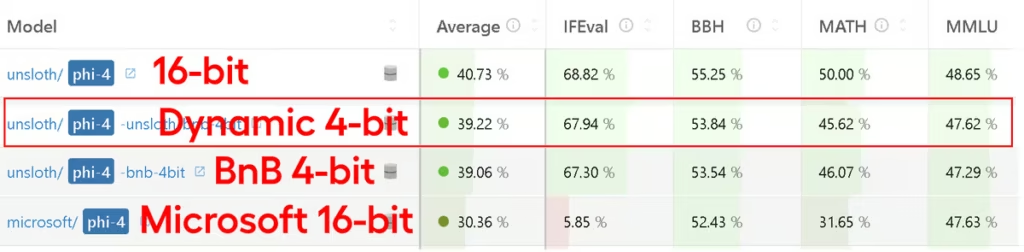

Benchmarks MMLU et performance comparative

L’évaluation sur MMLU benchmark (Massive Multitask Language Understanding) révèle la pertinence de la quantification dynamique face aux formats classiques. Ce test évalue les large language models (LLM) sur un éventail de tâches académiques et professionnelles.

Analyse par tâche

Si les moyennes globales sur MMLU montrent déjà que la quantization dynamique 4-bit d’Unsloth rivalise avec le FP16/BF16, une analyse plus fine, tâche par tâche, révèle à quel point cette approche conserve la qualité d’origine. Comme le montre les résultats issus de l’Open LLM Leaderboard, la précision se situe généralement entre 98 % et 99 % de la baseline BF16, un résultat exceptionnel pour un modèle compressé quatre fois.

Exemples concrets de scores par tâche

- MMLU 5-shot : Unsloth 4-bit atteint ~99 % de la performance FP16/BF16.

- ARC-C (0-shot) : les scores se maintiennent à environ 98–99 % de la baseline.

- GSM8k (8-shot reasoning mathématique) : Unsloth récupère même parfois légèrement plus que BF16, ce qui s’explique par une meilleure robustesse numérique lors de certaines opérations (source Reddit LocalLLaMA).

- HellaSwag et Winogrande : Unsloth 4-bit reste au-dessus de 98 % de la référence FP16.

- TruthfulQA : c’est l’un des rares cas où la différence peut atteindre 2 à 3 points, mais le modèle reste utilisable et largement supérieur à une quantization naïve en 4-bit.

Pourquoi les pertes sont-elles si faibles ?

La raison est simple : Unsloth n’applique pas une quantization uniforme. Comme expliqué dans son billet technique, certaines couches critiques, notamment les projections d’attention ou les couches de normalisation, sont conservées en FP16, ce qui évite les pertes de fidélité que l’on observe avec des méthodes comme GPTQ ou BitsandBytes appliquées sans distinction.

Résultats DeepSeek-R1 : précision vs performance

| Modèle | Précision BF16 | Unsloth Dynamic 4-bit |

|---|---|---|

| DeepSeek-R1 8B | 65,20% | 64,85% |

| DeepSeek-R1 14B | 68,40% | 67,95% |

| DeepSeek-R1 32B | 72,80% | 72,15% |

La perte reste généralement inférieure à 1%, un résultat remarquable pour un modèle d’IA quantifié, divisant la taille par deux à quatre, comme l’indique la documentation Unsloth.

Précision et gains mémoire GPU

En parallèle de cette précision quasi-inchangée, les gains en efficacité mémoire AI sont massifs :

| Modèle | Mémoire BF16 | Unsloth quantification |

|---|---|---|

| DeepSeek-R1 8B | ~16 Go | ~8 Go |

| DeepSeek-R1 14B | ~28 Go | ~14 Go |

| DeepSeek-R1 32B | ~64 Go | ~32 Go |

Un modèle qui nécessitait une Nvidia A100 devient exécutable sur RTX 5090, confirmé par LearnOpenCV qui souligne l’accessibilité pour les utilisateurs avec des cartes graphiques grand public.

Performance et compatibilité pratique

Inference optimisation et vitesse

La réduction de la précision numérique entraîne une baisse du volume de données manipulées et une simplification de calculs, ce qui permet à l’inférence d’être 2 à 5 fois plus rapide qu’en FP16/BF16. Comme le souligne Hyperbolic.ai, Unsloth combine sa quantification dynamique avec d’autres optimisations :

- FlashAttention 2 pour accélérer le traitement des séquences longues

- Paged optimizers pour une gestion mémoire GPU efficace

- Fusion des kernels CUDA limitant les appels redondants

Fine-tuning LLMs accessible

Alors que le fine-tuning complet en FP16/BF16 exige une Nvidia A100 80 Go VRAM, l’approche Unsloth permet d’entraîner un modèle 13B sur un simple GPU avec 8 Go VRAM via la combinaison quantification dynamique + LoRA.

Compatibilité Ollama quantification et outils

Les modèles open source quantifiés Unsloth exportés en format llama.cpp GGUF fonctionnent avec les outils populaires :

- llama.cpp pour l’exécution locale optimisée C++

- Hugging Face Transformer pour les développeurs

- Ollama simplifiant l’installation sur Mac/Linux

- vLLM

- LM Studio et ComfyUI pour les interfaces utilisateur

Cette compatibilité permet une large adoption, comme l’indique la documentation Unsloth.

Perte de précision – quand Unsloth n’est pas suffisant

Malgré ses performances remarquables, la quantization dynamique 4-bit d’Unsloth n’est pas une solution magique. Même si elle permet de récupérer 98 à 99 % de la précision d’un modèle FP16/BF16 sur la plupart des benchmarks, il existe encore des cas où le recours au FP16 ou au BF16 reste préférable. Comme l’explique Arxiv, certaines limites apparaissent surtout dans les scénarios de raisonnement complexe, de multimodalité ou lorsque l’on manipule des contextes extrêmement longs.

Raisonnement profond et tâches sensibles

Pour des applications où chaque décimale compte, comme la modélisation scientifique, les calculs financiers complexes ou certaines tâches en médecine et pharmacie, une petite dégradation de précision peut avoir des conséquences significatives. Dans ces cas, BF16 ou FP16 restent la norme car ils garantissent une fidélité des calculs et une stabilité numérique optimale, comme le rappelle Google Research pour le BF16.

Multimodalité et modèles spécialisés

La quantization 4-bit montre aussi ses limites pour les modèles multimodaux (texte + image, audio, ou vidéo). Les couches de traitement des signaux (visuels ou audio) sont particulièrement sensibles aux pertes de précision. Si certaines couches sont quantifiées trop agressivement, cela peut entraîner des erreurs perceptibles : mauvaise description d’image, erreurs dans la transcription audio, ou perte de nuances dans les vidéos générées.

Contextes longs et mémoire étendue

Un autre cas où Unsloth peut souffrir est l’inférence avec des contextes très longs (plusieurs centaines de milliers de tokens). Même si la quantization sélective réduit ce risque, la précision 16-bit offre une meilleure robustesse pour gérer des fenêtres contextuelles étendues sans perte de cohérence.

Une balance entre accessibilité et fiabilité

En pratique, le compromis est simple :

- Unsloth Dynamic 4-bit est idéal pour la majorité des usages (chatbots, agents, RAG, génération de contenu, recherche académique non critique).

- FP16/BF16 s’imposent encore pour des cas ultra-sensibles où la tolérance à l’erreur est quasi nulle.

La bonne question n’est pas de savoir si la quantization est meilleure ou moins bonne, mais de choisir la méthode adaptée au besoin réel : vitesse et accessibilité avec Unsloth, précision absolue avec FP16/BF16.

Cas d’usage et recommandations

Quand choisir Unsloth Dynamic 4-bit

Adoption actuelle et cas d’usage

L’adoption d’Unsloth Dynamic 4-bit se concentre principalement sur les communautés open-source, développeurs indépendants et projets de recherche plutôt que sur des déploiements commerciaux d’entreprises établies :

Développement et collaborations :

- Unsloth maintient activement sa méthode et publie des modèles de référence (Llama, Gemma, DeepSeek, Qwen) sur Hugging Face

- Microsoft a collaboré pour les quantifications dynamiques du modèle Phi-4, atteignant une précision comparable aux modèles pleine précision sur les benchmarks Open LLM

- La communauté IA utilise largement cette quantification dynamique pour DeepSeek-R1, Llama, Gemma, Qwen et Mistral comme le montre les différentes publications sur Reddit, LinkedIn et tutoriels.

Scénarios de déploiement typiques :

- Edge Computing AI et environnements contraints (IoT, systèmes embarqués)

- GPU grand public sur RTX 4060/5060/5070/5080

- Développement, prototypage rapide avec une vitesse d’inférence optimisée. grâce à la vitesse d’inférence 2 à 5 fois supérieure à FP16, il est possible d’itérer rapidement sans infrastructure lourde.

- Fine-tuning LLMs accessible via LoRA sur cartes 8-12 Go VRAM

- Applications grand public : chatbots, génération de contenu, assistants personnels

- Benchmarking, inférence low-cost et expérimentation avec contraintes de ressources

| Organisation | Usage Unsloth Dynamic 4-bit | Source |

|---|---|---|

| Unsloth | Développement principal, versions officielles | Documentation officielle |

| Microsoft | Modèles Phi-4 quantifiés en collaboration | Benchmarks Open LLM |

| Communauté IA | Large adoption, benchmarks modèles | LearnOpenCV, Reddit |

Note : Aucun client commercial établi n’a publiquement divulgué l’utilisation d’Unsloth Dynamic 4-bit en production en septembre 2025 ; l’adoption reste principalement open-source et expérimentale.

Quand privilégier FP16/BF16

- Recherche scientifique et médicale nécessitant une précision absolue

- Large language models (LLM) multimodaux sensibles (texte + image + audio)

- Entraînement complet de grands modèles sur GPU A100/H100

- Contextes ultra-longs (100k+ tokens) nécessitant une stabilité numérique

- Applications multimodales sensibles

Comparatif synthétique

| Critère | FP16 | BF16 | Unsloth Dynamic 4-bit |

|---|---|---|---|

| Précision | Excellente | Excellente + stabilité | ~98-99% selon MMLU benchmark |

| VRAM GPU | Élevée (16-32 Go) | Élevée | Très faible (7,5 Go pour 12B) |

| AI inference speed | Standard | Standard | 2-5x plus rapide |

| Taille modèle | 16-32 Go | 16-32 Go | 4-5x plus léger |

| Fine-tuning LLMs | GPU haut de gamme | GPU haut de gamme | Accessible 8-12 Go VRAM |

| Compatibilité | Large | Large (TPU/GPU récents) | Ollama quantification, llama.cpp GGUF |

Conclusion et conseils pratiques

La comparaison Unsloth vs FP16 BF16 révèle que la quantification dynamique n’est plus un simple compromis, mais une alternative viable pour exécuter des large language models (LLM) dans des environnements contraints.

Points clés à retenir

- La quantification dynamique sur 4-bit d’Unsloth réduit la taille par 4-5x tout en conservant 98-99% de la précision sur MMLU benchmark

- Les gains en VRAM GPU et vitesse d’inférence IA (2-5x) démocratisent l’accès aux modèles 27B sur des GPUs grand public

- L’export llama.cpp GGUF assure la compatibilité avec Ollama quantification et outils populaires

- Le fine-tuning LLMs devient plus accessible, même sur GPU 8-12 Go VRAM

Logique de choix

La quantification Unsloth convient aux développeurs recherchant l’efficacité mémoire AI avec du matériel abordable, tandis que FP16/BF16 s’adressent aux environnements où la fiabilité absolue prime.

L’avenir des méthode de quantification passe par des approches hybrides : la majorité des usages peut bénéficier du quantification dynamique 4-bit, mais certaines applications critiques nécessiteront toujours la précision et la performance du 16-bit ou encore du 32-bit.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !