Unsloth Dynamic 2.0 GGUFs : la nouvelle référence de la quantization LLM en 2025

Depuis avril 2025, l’annonce d’Unsloth Dynamic 2.0 GGUFs est une nouvelle évolution dans le domaine de la quantization des modèles de langage (LLM). Cette approche, présentée comme une évolution majeure des quants classiques, promet de concilier deux objectifs jusqu’ici difficiles à atteindre en même temps : réduire la taille des modèles tout en préservant un maximum de précision.

Aujourd’hui, en septembre 2025, le constat est clair : Dynamic 2.0 est devenu un standard de fait dans l’écosystème open source de l’intelligence artificielle. Il s’impose aussi bien auprès des développeurs indépendants que des grandes communautés comme celles de Llama.cpp, Ollama et Open WebUI. La collaboration d’Unsloth avec des entreprises comme Meta, Microsoft, Mistral, Google ou Qwen confirme l’intérêt pour cette technologie.

Une évolution majeure par rapport aux quants classiques

Selon la documentation officielle Unsloth, le passage à Dynamic 2.0 repose sur une refonte complète de la sélection des couches à quantifier. Contrairement aux méthodes classiques comme imatrix, qui appliquent une logique plus uniforme, Dynamic 2.0 ajuste la stratégie couche par couche, avec un schéma propre à chaque modèle.

Cette flexibilité se traduit par :

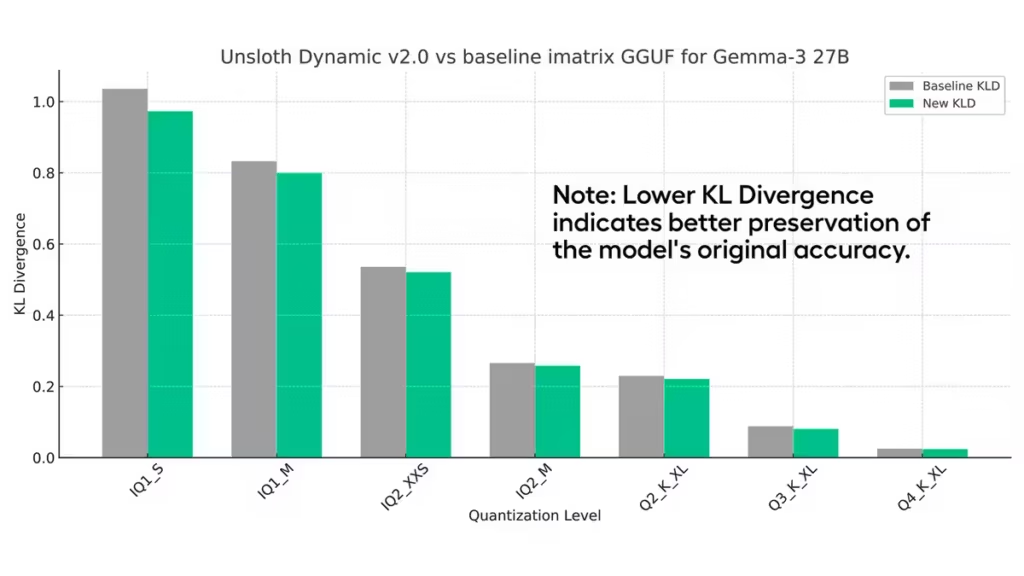

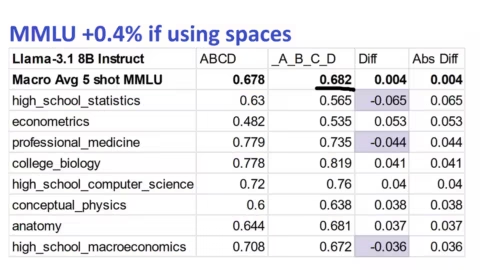

- une réduction notable du KL Divergence (KLD), indicateur fiable pour mesurer la fidélité d’un modèle par rapport à sa version en pleine précision, comme l’explique la publication scientifique Accuracy is Not All You Need ;

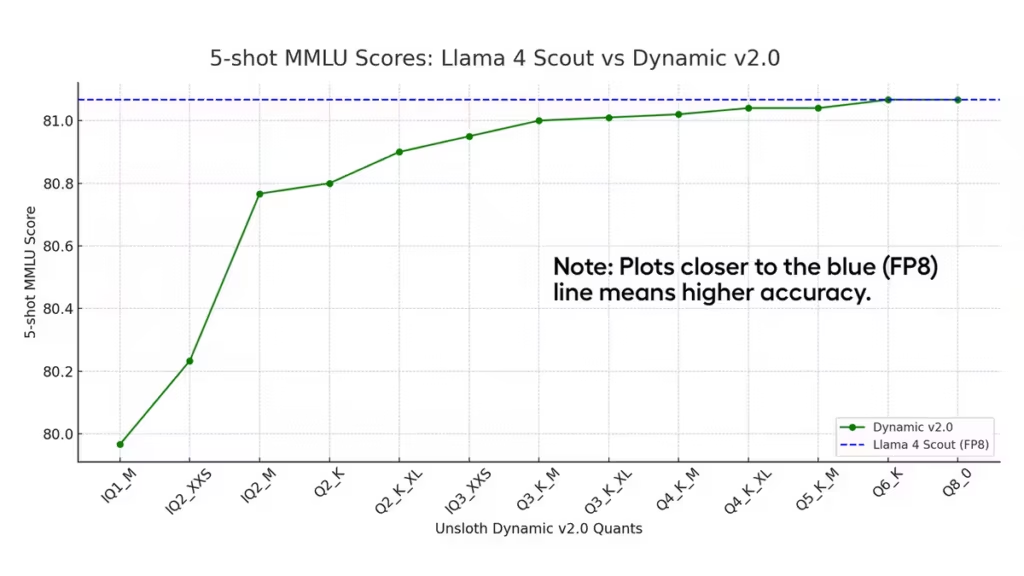

- des performances MMLU (5-shot) proches, voire supérieures à certaines versions QAT (Quantization Aware Training), tout en gagnant plusieurs gigaoctets sur l’espace disque ;

- une meilleure adaptabilité aux modèles hétérogènes, qu’il s’agisse de MoEs (Mixture of Experts) comme DeepSeek, ou de modèles denses comme Gemma 3 et Llama 4.

Des benchmarks qui confirment les gains

Les chiffres publiés en avril 2025 montrent que sur Gemma 3 (27B), la quantization Dynamic 2.0 en Q4_K_XL atteint 71,47% sur MMLU, contre 70,64% pour la version QAT officielle de Google, tout en étant 2 Go plus légère (Unsloth, avril 2025).

| Métrique | 1B | 4B | 12B | 27B |

|---|---|---|---|---|

| MMLU 5 shot | 26,12% | 55,13% | 67,07% (67,15% BF16) | 70,64% (71,5% BF16) |

| Espace disque | 0,93 Go | 2,94 Go | 7,52 Go | 16,05 Go |

| Efficacité | 1,20 | 10,26 | 5,59 | 2,84 |

Autre exemple frappant : le 10 septembre 2025, l’équipe Unsloth a annoncé que son Dynamic 3-bit DeepSeek V3.1 GGUF atteint 75,6% sur Aider Polyglot, surpassant plusieurs modèles en pleine précision considérés comme SOTA (State of the Art). Ces résultats confirment que l’approche n’est pas qu’un compromis entre taille et précision, mais peut réellement dépasser des solutions plus coûteuses en calcul.

Une adoption rapide dans l’écosystème open source

Un autre facteur qui a favorisé l’adoption de Dynamic 2.0 est l’engagement d’Unsloth à corriger les bugs critiques des modèles majeurs. Comme rappelé dans l’update du 10 septembre, l’équipe a collaboré directement avec Meta (Llama 4), Google (Gemma 1–3), Microsoft (Phi-3/4), Mistral (DevStral) et Qwen3 pour améliorer la stabilité et la précision.

Cette approche proactive a séduit la communauté. Sur Reddit (r/LocalLLaMA), les retours utilisateurs soulignent autant les gains de performance que la réactivité de l’équipe. Certains relèvent encore des problèmes pratiques (CPU overloading avec llama.cpp, compatibilité avec certains formats ARM), mais dans l’ensemble, le consensus est positif.

Des modèles déjà disponibles en Dynamic 2.0

À la date du 16 septembre 2025, de nombreux modèles sont disponibles en Dynamic 2.0 Quants :

- Qwen 3 Coder, Qwen 3 30B, Qwen 3 235B

- Kimi K2

- Llama 4

- Gemma 3 (12B et 27B)

- DevStral

- Phi 4

- DeepSeek

- Plus de modèles disponible avec ce lien

Cette disponibilité large démontre une volonté de couvrir les usages les plus variés : du codage (Qwen 3 Coder), aux assistants conversationnels grand public (Llama 4, Gemma 3), jusqu’aux architectures expérimentales (DeepSeek).

L’évolution des téléchargements sur Hugging Face montre clairement que les Unsloth Dynamic 2.0 Quants connaissent une adoption massive, parfois supérieure aux versions QAT (Quantization Aware Training) ou full precision. Des modèles comme Qwen3-30B-A3B-GGUF dépassent les 399 000 téléchargements, tandis que les déclinaisons spécialisées comme Qwen3-Coder-30B culminent à 167 000 téléchargements. En comparaison, les versions QAT de Gemma 3 (12B et 27B) restent sous les 32 000 téléchargements. Ce décalage suggère que la communauté préfère largement les quants Dynamic 2.0, jugés plus légers et accessibles sans sacrifier la précision.

L’usage confirme cette tendance : les quants Dynamic 2.0 dominent non seulement en volume de téléchargements mais aussi en diversité de publics. Les modèles “Coder” séduisent particulièrement les développeurs, tandis que les variantes généralistes comme GPT-OSS ou Gemma 3 attirent les utilisateurs cherchant des alternatives open source aux modèles propriétaires. Les versions full precision, plus lourdes et coûteuses en ressources, sont moins téléchargées et se cantonnent surtout à des environnements de recherche ou à des benchmarks officiels. Cette dynamique met en évidence une adoption réelle des quants Unsloth Dynamic 2.0 comme standard de facto pour l’inférence locale et le prototypage rapide.

Les défis encore ouverts

Malgré ces avancées, plusieurs questions restent ouvertes :

- Compatibilité ARM et Apple Silicon : bien que des formats comme Q4_NL et Q5.1 soient progressivement intégrés, les optimisations sur CPU ARM restent limitées.

- Évaluation multi-benchmarks : la MMLU reste la métrique principale, mais il faudrait davantage de comparaisons sur d’autres jeux de tests (traduction, raisonnement, code) pour confirmer la robustesse.

Conclusion : un standard qui pourrait redéfinir la quantization

En moins de six mois, Unsloth Dynamic 2.0 GGUFs s’est imposé comme la référence de la quantization LLM en 2025. Ses performances, combinées à une adoption rapide dans l’écosystème open source, en font une solution incontournable pour quiconque cherche à faire tourner des modèles puissants sur des machines grand public ou dans des environnements à ressources limitées.

Pour mesurer l’importance de Dynamic 2.0, il faut replacer cette approche dans la continuité des travaux d’Unsloth.

- Première génération : Unsloth Dynamic (v1)

En novembre 2024, Unsloth avait introduit ses premiers Dynamic Quants, dont des versions 4-bit (Q4_K, Q4_XL, etc.). Ces quants apportaient déjà un gain notable de performance par rapport aux méthodes classiques (imatrix, GPTQ), mais leur usage restait ciblé. Ils étaient surtout efficaces pour les architectures MoE (Mixture of Experts), comme les premiers modèles DeepSeek. Cette génération s’est démocratisé avec la dénomination « 4-bit Dynamic Quants« , ce qui induit une certaine confusion puisqu’il s’agit de la première génération. - Avril 2025 : Unsloth Dynamic 2.0

Avec la sortie officielle de Dynamic 2.0, la méthode change d’échelle. La sélection des couches à quantifier devient intelligente et spécifique à chaque modèle, permettant de couvrir aussi bien les MoE que les modèles denses (Llama 4, Gemma 3, Qwen 3). C’est cette génération qui établit de nouveaux benchmarks en MMLU et réduit fortement la KL Divergence, devenant la référence pour la communauté open source.

En résumé, les 4-bit Dynamic Quants appartiennent à la première génération et servaient surtout de preuve de concept. Dynamic 2.0 pose les bases solides d’une méthode universelle et fiable. Une nouvelle version Dynamic 3.0 pourrait suivre, mais aucune annonce officielle n’a été faite pour le moment.

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !