L’IA de Nvidia compresse la vidéo et divise par 10 les volumes !

L’IA de Nvidia compresse maintenant la vidéo de manière très efficace avec un gain x10 sur la taille des fichiers ! Nous en parlions déjà dans notre article sur la technologie DLSS de Nvidia, l’Upscaling par IA a encore beaucoup de potentiel notamment sur la compression vidéo.

Le fabricant de GPU NVIDIA a annoncé sa plate-forme Maxine pour les services de vidéoconférence améliorés par l’IA. Cet ensemble d’outils comprend une technologie permettant de réduire les besoins en bande passante. En déplaçant une grande partie du traitement des données vers le cloud, les utilisateurs finaux peuvent profiter de la compression sans avoir besoin de matériel spécialisé. Quel que soit votre appareil, PC, Andoir, Chromebook, Mac ou autres, avec ou sans carte Nvidia, vous pourrez profiter de la compression par IA de Nvidia.

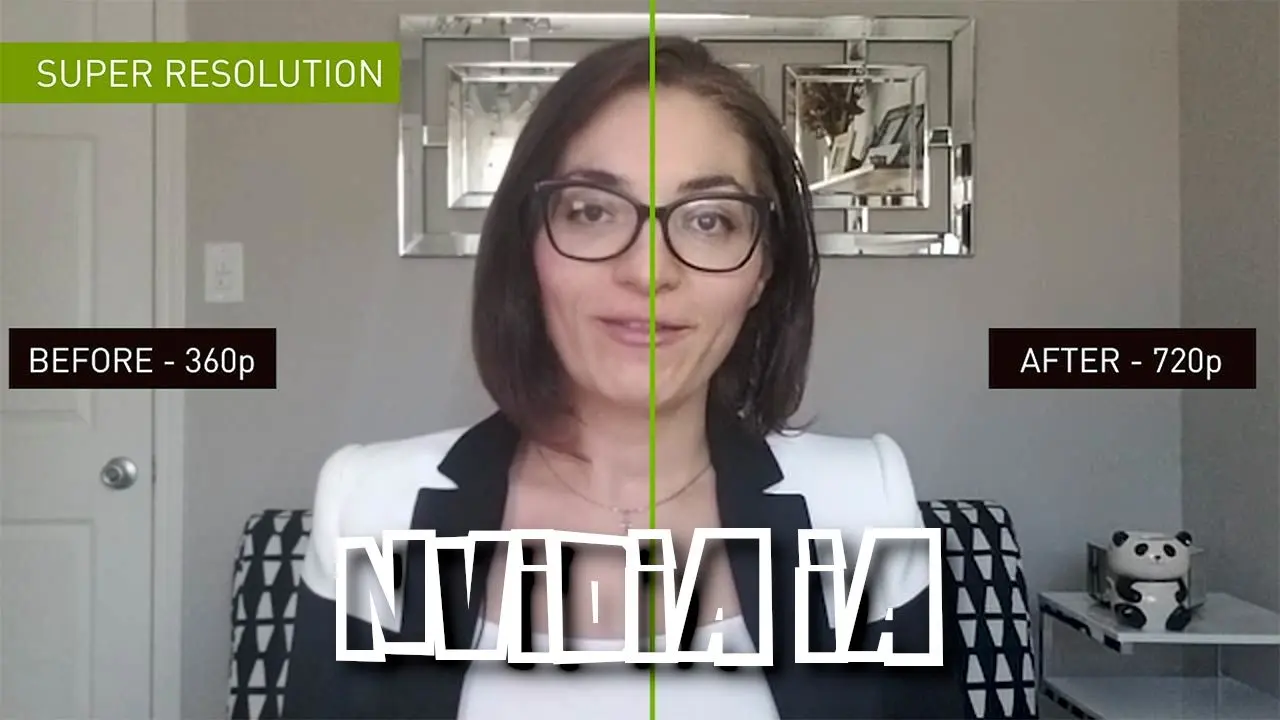

Lors de la conférence sur les technologies GPU (GTC), Jensen Huang, le CEO de NVIDIA, a décrit la plate-forme Maxime. La compression vidéo de Maxine utilise un Réseau Génératif Antagoniste (Generative Adversarial Network, GAN) du côté du récepteur, cette IA permet de reconstruire des images de visages humains. Concrètement avant l’émission de la vidéo, l’IA apprend à améliorer l’image (Upscaling) et n’envoi que la vidéo dans une faible résolution et l’information pour améliorer la résolution. L’information pour améliorer l’image, ou le savoir, a un volume de données nettement moins importants que l’équivalent en Pixels. En n’envoyant que ces informations, les besoins en bande passante sont considérablement réduits par rapport à la norme de compression H.264, jusqu’à 10 fois selon Nvidia. Maxine offre également plusieurs autres fonctionnalités, notamment l’alignement des visages et les avatars animés.

L’IA de Nvidia compresse la vidéo jusqu’à 10 fois plus que le H.264

Nous avons l’occasion de révolutionner la vidéoconférence d’aujourd’hui et d’inventer la présence virtuelle de demain.

L’algorithme central de l’IA dans Maxine est basé sur les recherches de NVIDIA sur les GAN. Les GANs utilisent deux modèles d’apprentissage profond. D’un côté, un générateur qui apprend à créer des données « réalistes ». Et de l’autre, un discriminateur qui apprend à distinguer les données réelles de la sortie du générateur. Une fois formé, le générateur peut produire une sortie très convaincante.

Dans un article présenté à la conférence de 2019 sur la vision par ordinateur et la reconnaissance des formes (CVPR), une équipe de recherche de NVIDIA a décrit un modèle qui peut transformer de simples dessins en images photoréalistes grâce au « transfert de style ». L’équipe a également créé une application de démonstration de la technologie appelée GauGAN, qui permet aux utilisateurs de faire leur propre dessin et d’appliquer l’une des nombreuses images de référence disponibles comme style.

Récemment, le co-développeur de GauGAN, Ming-Yu Liu, et d’autres collègues de NVIDIA ont réalisé qu’ils pouvaient appliquer cette technique à la vidéoconférence. La plupart des algorithmes de compression vidéo classique tirent parti du fait que toutes les données d’image ne changent pas entre les trames, transmettant parfois des images clés complètes, puis n’envoyant que les changements entre cette trame et les trames suivantes. Minerva nécessite également une image clé, ou image de référence, du visage de l’utilisateur qui transmet. Les images suivantes de la vidéo source sont analysées pour localiser les « points clés » du visage de l’émetteur dans l’image. Au lieu de différences entre les images, Minerva calcule les différences par rapport au visage de référence. En fait, à partir d’une image 2D du visage, l’IA de NVidia est capable de prédire un rendu 3D avec des positionnements différents de l’image de référence.

Nvidia valorise son IA au-delà de la visioconférence

Outre la réduction de la bande passante pour la vidéoconférence, Maxine offre plusieurs autres fonctionnalités. Comme par exemple l’amélioration des images prises en basse lumière et la suppression du bruit de fond. La plateforme peut « réorienter » le visage. De nombreux participants à la vidéoconférence ont tendance à regarder leur propre écran plutôt que de regarder directement la caméra. Repositionner le regard permet d’améliorer le contact visuel.

Maxine supporte également les « avatars » virtuels animés. En utilisant une image de référence différente, par exemple le visage d’un personnage de dessin animé. Maxine « reconstruira » alors l’expéditeur comme une version animée du personnage fictif. En utilisant les services d’IA Jarvis de NVIDIA, les vidéoconférences peuvent également inclure le sous-titrage en temps réel ainsi que la traduction.

De nombreux utilisateurs ont souligné la similitude entre l’algorithme de Minerva et les « deepfakes », ce qui a suscité des inquiétudes quant à l’utilisation abusive de cette technologie. Alors que d’autres ont soulignés les aspects positifs.

La plate-forme Maxine de NVIDIA est actuellement en bêta fermée et les développeurs peuvent demander un accès anticipé. Le code du modèle GauGAN est disponible sur GitHub.

A lire aussi

- Nvidia DLSS : c’est quoi ? Améliorer l’image des jeux avec une RTX

- Image Sharpening Nvidia : améliorer les détails de l’image

- Test Nvidia Shield TV : pour le streaming et les jeux ?

- Upscaling Nvidia : gagner des fps avec l’Upscaling – Guide performance

- Meilleur TV PS5 : quel TV choisir pour la PS5 ? 4K HDMI 2.1 120 Hz

Pour ne rien rater, abonnez-vous à Cosmo Games sur Google News et suivez-nous sur X (ex Twitter) en particulier pour les bons plans en direct. Vos commentaires enrichissent nos articles, alors n'hésitez pas à réagir ! Un partage sur les réseaux nous aide énormément. Merci pour votre soutien !